摘要

推广到分布外的数据一直是VQA的问题,为解决对新问题的推广,我们建议将它们分为“技巧”和"概念","技巧"是视觉任务,如计数和属性识别,被应用到"概念"(如物体和人)中。VQA方法应该能够以新的方式组合"技能"和"概念",无论在训练中如何,但我们证明现有模型在处理新组合方面有很多需要改进。我们提出了一种学习组合"技能"和"概念"的新方法,通过学习基础概念表示并从概念编码中区分出技巧编码,在模型中隐式地分离这两个因素。我们用一种新的对比学习过程来执行这些属性,它不依赖于外部注释,并且可以从未标记的图像-问题对中学习。实验证明了该方法对提高组合性能和接地性能的有效性。

代码

一、介绍

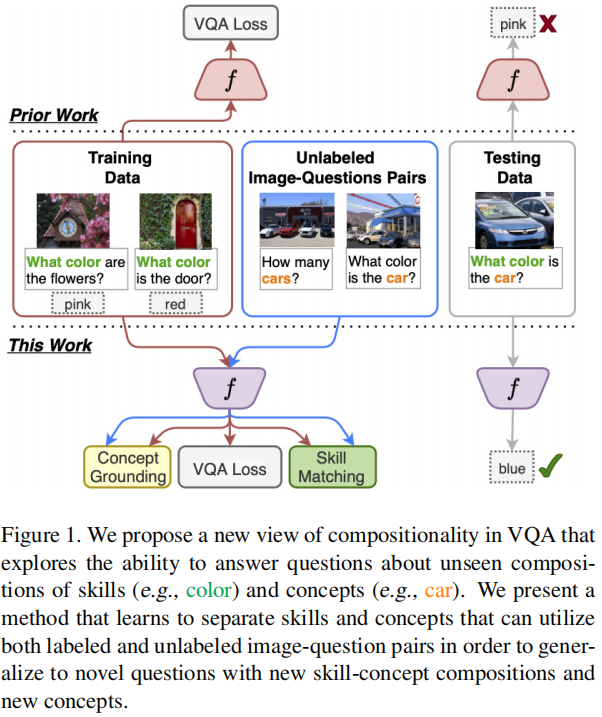

当人类回答问题时,首先解释问题,将问题拆分成部分(如概念,关系,行为,问题种类),然后选择并执行技巧来得出答案。这个技巧应用到很多特定问题内容的种类中。例如,你可以回答关于物体颜色的问题,以及识别和回答关于汽车的问题,那对于汽车是什么颜色的问题应该能直接回答,即使具体的组成还没有被看到。这种使用技巧来采用和组成概念表示的能力对于VQA的真正理解和从较少标签数据中泛化至关重要。

组合性被认为是人类认知的基本特性之一,仍需更多研究将组合性纳入模型和开发数据高效、可推广的系统。大多数先进模型没有任何内置组合的概念,并倾向于将技巧和概念用在学习表示中。以前的工作研究泛化能力的缺乏,使用与训练数据分布不同的测试数据,但是这并不能直接解决中心问题(缺乏组合性),它表现为糟糕的泛化和过度依赖语言先验。

为解决此问题,我们第一个贡献是对VQA组合性的新观点:技巧-概念组合,以及一个新的评估设置,直接针对VQA如何推广到技巧和概念的新组合。这一观点的动机是我们的观察,即回答一个关于真实图像的自然问题需要理解两个不同的元素:1)问题所提到的视觉概念;2)我们需要从所提到的概念中提取哪些信息。

我们提出一种新方法来改进泛化,利用对比学习来分离模型内部表示中的技巧和概念,同时共同学习回答问题。我们使用接地作为代理来分离概念,以便模型学习在问题和图像中识别一个概念,而不管特定的上下文如何。与弱监督接地[3,17]类似,我们通过对比掩蔽的概念词的多模态表示与其他问题中单词的多模态表示来训练模型以恢复给定图像问题对中提到的概念。我们利用一种新的方法来策划对比损失的正的和负的例子,以便模型学会基于相关的视觉信息来预测概念,而不是使用表面的上下文线索。此外,我们的方法通过对比具有相同或不同技巧的问题表示来学习将技巧从概念中分离出来。这些特性与VQA目标共同学习,基于最先进的模型,并可推广到新的架构。

我们方法的优点:1)我们只使用VQA数据,不需要外部注释,以一种自监督的方式学习接地。这与以前类似的目标的方法(注释要求而产生大量费用)相反。2)我们的方法不依赖于答案标签来学习技能-概念分离,因此我们能够使用未标记的图像-问题对来学习这些属性。因此,我们能够获得新的概念,并学习回答关于这些概念的无标记的问题,这对于推广到新领域或新实例至关重要。此外,我们关注数据高效的方法,不使用VQA外部的大量数据(如预训练方法[39,8],获得方法昂贵,并且需要对该领域和/或概念的先验知识表现良好)。

本论文的主要贡献:1)提出一种新的VQA组合性的视野和评估设置,称为技巧-概念组合,它能对真实图像问答有一个更直接和可解释的评估。2)提出一种新的对比学习方法,它结合了有着自监督学习的VQA方法,以在没有额外注释花费的情况下实现技巧概念区分。3)我们的方法显示了比现有的新技巧-概念组成模型的显著改进,以及泛化到包含没有见过的概念的未标记图像问题对。

二、相关工作

VQA和评估

另一个数据集[30]评估来自VQAv1[6]的数据和由问题模板和图像注释生成的合成数据,它们通过视觉任务分解。按任务考虑问题的基本前提类似于我们的“技巧”,但我们的设置检查技能和概念的合成的泛化性,我们在没见过的技巧和概念组成上评估。现有的评估泛化的工作[2,30]并没有探索对这种新组合的泛化。

组合性和VQA

CLEVR和GQA都提供了组合性的问题,问题中包含各种关系链。GQA并不关注新的组成,但CLEVR研究了属性和对象的新组成,例如,模型在训练期间看到某种颜色的立方体和其他颜色的圆柱体,然后立方体和圆柱体在测试中交换它们的颜色。类似于我们的设置,尽管我们建议研究技巧概念组成,我们实验是关于真实图像的自然问题。其他创建组合模型的努力来处理关系推理链[22,46]。我们的方法隐式地在最先进的多模态transformer架构中隐式地学习组合能力,不像这些显式的方法。我们还提供了当前组合模型(即神经模块网络)如何推广到新问题的结果。

接地视觉概念

以前关于视觉接地的工作通常以弱监督方式,有时利用对比学习来学习接地。然而,出现在VQA问题中的接地概念在以前的工作中很少被研究,我们在我们的论文中探讨。与VQA中的视觉接地有些相关的一个方向是学习具有可解释的视觉注意力的VQA模型[44,55]。然而,这些方法通常依赖于人类对最有影响力的区域的注释来进行VQA答案预测[9,28],这些区域获得成本昂贵,并且没有直接将概念提及与视觉区域联系起来。我们的工作学习问题中提到的接地概念,促进组合VQA建模,并且不使用任何额外的注释。

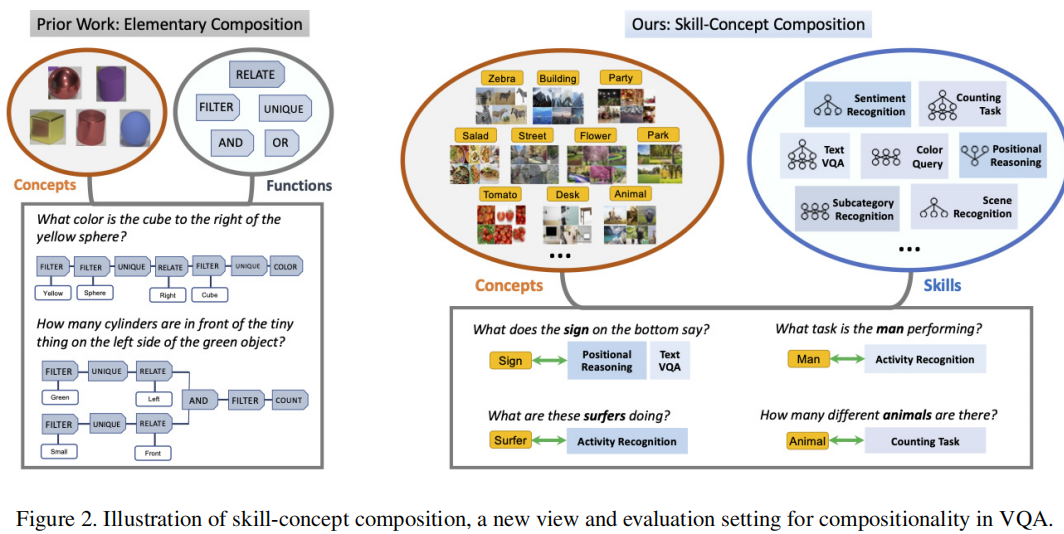

三、VQA的技巧-概念组合

概念是对象和其他视觉接地的词或短语,技巧是在回答现实世界图像的常见问题时涉及的高水平视觉理解。这些技巧基于概念,并在输入/输出表示的复杂性和必要的推理过程方面有所不同。我们对这些技巧的分类是从注释VQAv2问题的一个子集以及从之前VQA的工作中启发提取的。技巧通常彼此独立,并在VQA文献中被独立研究(如TextVQA[48]、位置推理[26]或计数[1])。

对于这些技巧有一个重要且直观的观察:为回答一个问题,经常只需要将少量技巧(最经常的一个)应用于图像中的一个或多个概念中。这一观察提供了一个模型对分布外数据的泛化能力的可解释图:模型应该了解到技巧是一个可分离的过程,可以应用于不同的概念,并且预测过程不应与该技巧同时发生的特定概念挂钩。这种技巧概念分离的明确概念是本文贡献的基础,包括一种新的新-VQA评估方法,以及一个新的可以回答新问题的弱学习VQA模型。

新VQA评估

虽然在概念上很直观,但这种技巧概念视图提供了自然的方法来指导根据分布外数据对VQA模型的评估。在我们的实验中,评估了两种新的VQA设置:1)回答关于技巧和概念的新组成的问题;2)回答关于模型以前没有看到任何答案的概念的问题。

对现有评估结果的比较

我们的评估也旨在衡量模型的泛化能力,VQA-CP并不能捕捉技巧概念组合,因为问题类型对于技巧并不是一定必要的,同样的技巧概念组成可以出现在训练和测试中,违背了新VQA设置。TDIUC评估不同类别的任务类型的VQA准确性。[52]创建测试分割,一个问题中至少有一个词在训练中没有见过,这不考虑技巧。这些基准都没有像我们的评估方案那样直接解决和评估技能概念的组合性。

技巧概念vs. 基本组成

现有的组合评估主要将组合定义为与问题相关的关系推理链(图2),它适合学习基本操作的程序来回答问题。将这个现有的组合视图应用于真实图像的问题回答有两个主要问题。首先,这些概念及其属性过于简化,并不能代表现实世界中不同的视觉呈现。其次,这些合成数据集中的组合问题很少出现在关于真实图像的自然问题中。我们提出的技巧概念组成视图更适用于现实世界的VQA,因此,可以更好地代表人们在真实图像的问题回答中所关心的能力。

四、方法

初步工作

假设给定一个部分标记的数据集,有图像I、问题Q和答案标签A,其中(Ia,Qa,Aa)∈Da有标签,而(Iu,Qu)∈Du没有。使用标记数据集用一个VQA损失训练模型。给出一个示例(I,Q),图像区域特征gv(I)={v1,...,vM}和问题表示嵌入gw(Q)={x1,...,xN)被提取并输入到一个多模态编码器以产生多模态表示f(gv(I),gw(Q))=({zm}=1,{hi}Ni=1),其中zm和hi分别是图像和文本多模态表示。通过将编码的表示池化为一个简单表示(或使用一个CLS表示作为输入),然后输入到一个softmax输出层预测答案。我们在这个基本的VQA设置基础上学习技巧概念分离,并独特地利用标记和未标记数据。

概述

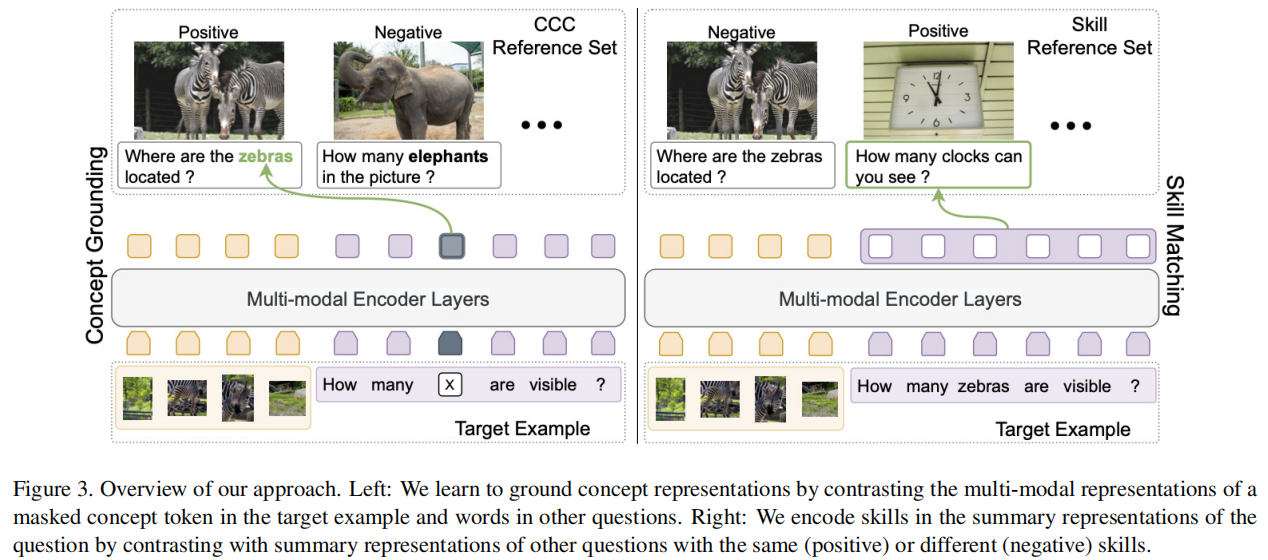

我们的目标是学习分离技巧和概念,就可以组合它们来回答新的问题。为了做到这一点,模型应该认识到,问题中提到的概念表现为它们在图像中的表现(即接地),无论问题或图像中的概念如何,技巧都应该是可识别的。收集监督来识别问题中的概念,将它们接地在图像中,和用技巧标记问题将是非常昂贵的。因此,我们建议使用对比学习,以自监督方式学习技巧-概念分离。如图3所示,我们结合了另外两个对比方法到VQA方法上来训练模型:概念接地(学习接地的概念表示),技巧匹配(编码技巧的概念不可知表示)。对于每个方法,该模型都提供了一个目标例子和一组从候选参考中采样的正和负例子的参考集。每个方法都训练模型,以使目标例子的表示与正例相似。

4.1 概念接地

为学习概念的接地表示,我们从目标问题中掩盖概念,然后训练模型恢复这个概念,使用多模态上下文信息,通过指向参考集中的示例中的相同概念。(图3)

概念发现

我们首先确定了可以接地图像的概念词,虽然这可以用不同的方法来完成,但我们只是简单地使用启发式方法。使用POS标记和引理化[21]识别出VQAv2中400个最频繁的词,然后过滤掉不能接地的概念(如时间)。如果关于图像的问题提到一个概念,那么该概念可能出现在图像中。因此,我们确定了一组提到相同概念的问题,c,称之为˜R+g(I,Q,c),我们认为它是Q的候选正参考,不提及任何相同概念的问题被视为候选负参考,称之为˜R−g(I,Q,c)。为了增加该概念出现在图像中的可能性,我们使用了一组基于NLP的启发式方法来删除其图像可能不包含该概念的问题,例如计算答案为“0”的问题。

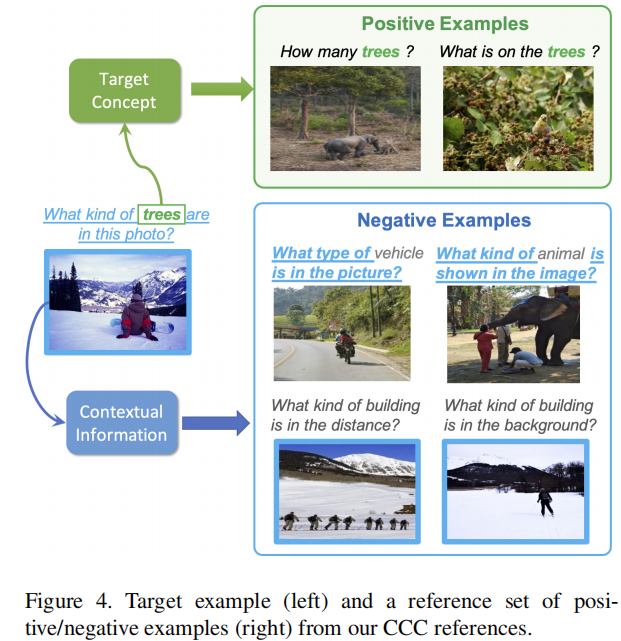

概念-上下文对比(CCC)参考

给定一个目标问题Q和一个目标概念在Q中提到的c,我们可以通过从˜R+g(I、Q、c)和˜R−g(I、Q、c)中仅基于问题是否包含c随机采样正和负示例。然而,我们提出了一种新的参考示例过滤策略来鼓励概念接地。我们的动力是,训练期间,一个概念经常与确定的视觉场景类型或语言先验同时出现,所以正负样例应迫使模型不依赖表面线索,看向正确的视觉区域。我们的解决方法是为每个(I、Q、c)元组构建改进的参考候选集R+g(I、Q、c)和R−g(I、Q、c),以确保可以减少数据集中存在的并发因子。如图4,想要找出包含tree概念的正例子,但有着来自目标的视觉场景和问题。对于负例子,我们寻找在问题或视觉场景中与目标相似的干扰(如图4中滑雪者的山脉),但不参考tree。为实现这一点,首先通过屏蔽问题中的c来表示c的上下文,并将屏蔽的问题和图像输入到现成的特征提取器中,以获得问题上下文表示q和图像表示v。我们通过以下方法来度量上下文相似度:

![]()

其中β是标量,(v、q)和(v'、q')分别是来自目标和候选例子的表示。

为了从˜R+g(I,Q,c)中选择正例,我们使用β=0.6,并采样一组R+g(I,Q,c),将最小化ξ作为(I,Q,c)的候选正例。对于负例,我们应用两个最大化ξ的β设置:β=0.7,它支持具有更多文本相似性的示例,和β=0.3,它对具有相似视觉上下文的图像进行优先。我们从每个设置中选择N−个例子作为候选的负例,R−g(I,Q,c)。如图4所示。当从这两组候选参考集中采样时,这些例子鼓励模型学习问题中提到的概念与它在图像中的外观之间的具体对应关系。直观地说,模型必须学会在干扰器存在的情况下建立概念的基础。

概念接地损失

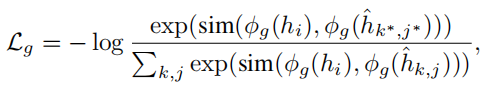

让(I、Q)和c分别作为目标示例和目标概念提及,并让X={(Ik、Qk)}Kk=1作为一个参考集,设k*是从R+g(I,Q,c)采样的X中的正例的索引,而其他K−1例子是来自R−g(I,Q,c)的负例。让wi作为Q中提到概念c的标记。我们掩蔽wi并将这个问题的掩模版本和相应的图像输入到模型f中,模型输出多模态表示,从中提取掩模概念标记的表示hi。接下来,我们单独将X的例子提供给模型,以获得每个标记的表示ˆhk,j,其中j是Qk中令牌的索引。让ˆhk∗,j∗作为正例问题中提到的概念的表示。我们的接地损失是一个NCE目标,要求模型将掩蔽概念的多模态表示与在参考集中提到的相同概念的表示相匹配:

其中φg是一个学习的投影函数,sim(·,·)是一个相似度函数(如点积或余弦相似度)。为正确匹配hi和ˆhk∗,j∗,模型必须编码两个令牌表示中这些示例图像之间匹配的视觉特征。我们的CCC参考鼓励这些在正例中提到的概念表示,和接地到正确视觉区域的掩盖的概念表示,因为模型不能依赖于表面的文本或视觉共同出现。

4.2 技巧匹配

与视觉概念相反,回答问题需要的基本技巧在很大程度上与图像外观和问题中对概念的提及无关。如计数问题应该共享一个类似的过程来产生答案:与计数对象相关的图像区域被总结,以进行计数预测。此过程应独立于所询问的对象的类型。换句话说,我们试图学习问题的总结表示,这些问题具有推断答案的基本步骤,并且对概念是不变的。

技巧推理

学习技巧的一种直接方法是注释明确需要相同推理步骤的问题,该注释在合成数据集[26,29]上随处可见,但在涉及真实图像和问题的数据集上却没有。相反,我们建议挖掘一组对比的例子来学习哪些问题需要相同/不同的巧,用相同的技巧匹配问题。由于问题所需的技巧通常由问题的词来表示,因此我们可以识别在语义上相似的问题。本质上,需要相同技巧的问题(如,“什么颜色……”)应该相互关联,而不管问题中提到的具体概念如何。因此对于每个问题,我们屏蔽了概念词,并计算它们的BERT[11]表示。对于给定的(I,Q),使用BERT表示从前200个最相似的问题中对R+(I,Q)进行采样,负例集R−(I,Q)是从其余的数据集中随机选择的。

技巧匹配损失

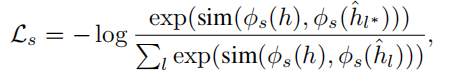

对于给定的目标示例(I,Q),让h作为目标问题的摘要表示。这可以使用像BERT的特殊输入令牌,或通过对从编码器输出的所有问题令牌表示的池化操作来计算。我们采样了一组图像问题对的参考集,{(Il,Ql)}LL=1,其中正例,来自R+(I,Q)的Ql∗,与目标问题具有相同的技巧,其余的参考集是来自R−(I,Q)的负例。设ˆhl作为参考集中一个问题的摘要表示。如图3所示,我们的技巧匹配损失被定义为:

其中ˆhl∗是正例表示,φs是另一个学习的投影函数。

4.3 训练过程

对于我们的损失,我们使用一个多任务学习程序[13,40],在每一步使用概率psep或非概率1−psep表示我们的目标。在训练过程中,我们总是首先从标记数据中采样一个实例,并通过最小化VQA目标来更新模型。如果在当前的迭代中,我们不使用我们的技巧和概念目标,那么我们只使用VQA目标。否则,我们首先使用VQA目标,然后应用其他目标。这两个目标都以相同的方式计算:对于Lg(或Ls),我们采样Da∪Du的目标示例,以及Rg+(或Rs+)的Nr+正例以及Rg−(或Rs−)的Nr−负例,结合采样的参考形成当前参考集,并计算损失项。然后对Lg和Ls加和,并更新模型以最小化负和。

五、实验

数据和设置

在VQAv2上进行实验,包含真实图像、人工写的问题和回答问题所需的技巧。因为要测试在不同类型的新问题上的性能,所以需要为测试数据提供答案注释。将验证集中的问题进行测试,不使用验证集来训练或调参。

模型比较

第一种是组合模型[5,22,23,46],使用StackNMN[22]和XNM[46],它们被设计用于处理合成问题,就像CLEVR[29]中的问题一样,并且在这些数据集上具有最先进的性能,同时也适用于真实图像,而不受功能程序或图像场景图的监督。

第二种是基于transformer[8,11,35,38,39,50,53,56],使用两种最好性能的transformer架构:1)双流交叉注意模型(X-Att),前面的层有特定模态的分支和交叉注意力,然后是网络后期的多模态层。2)视觉和语言transformer模型(X-BERT)作为整个网络的多模态编码器。为公平比较,我们不使用预训练,与我们的模型一样,因为我们特别关心数据效率模型的泛化能力,在不需要大规模的(例如,9M+图像-文本对),VQA外部的域内数据[19,47]。

最后,对于我们的基本模型,使用了标准多模态transformer的一个变体,其中图像特征可以由CLS令牌和语言特征同时参与。当基础模型在没有提出的技能概念对比损失的情况下被训练时,它作为一个基线模型(由基础表示)。

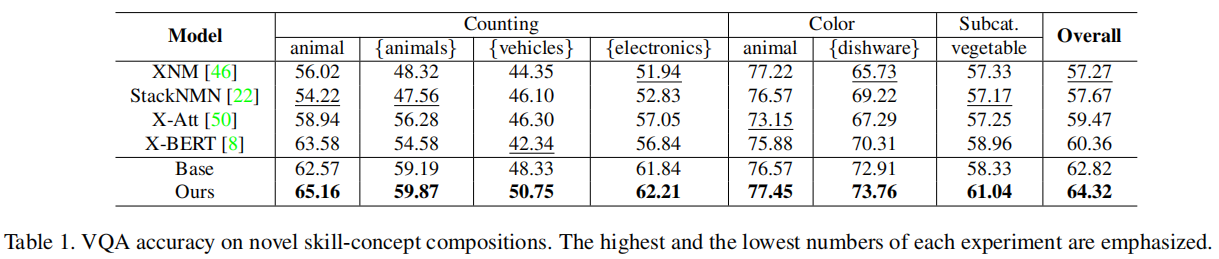

5.1 新技巧-概念组合的VQA

选择VQA v2中三种普遍和常见的技巧:计数‘、颜色查询和子类别识别。对于每个技巧,我们删除一个概念或一组概念的数据标签,这些概念可以从训练中形成一个不同的类别,然后对这些组成进行测试。概念(或概念组)随机采样,有两个标准:每个技巧概念组成包含可靠数量的测试数据以测量准确性,并且数据集覆盖范围不同。

表1显示了在每个新组合子集上的VQA精度。尽管神经模块网络被设计为明确地将问答过程分解为子任务,这原则上应该有助于使这些子任务适应新的问题以更好的泛化,但它们相比transformer模型有更低的性能,可能是由于自注意力机制的有效的特征学习能力。在所有的transformer模型中,我们的基础编码器实现了与现有网络竞争性的性能,证明它在多模态transformer间的一个强基线。最后,我们的对比学习框架在每个新的组合集合中都优于基线和所有其他方法,这支持了我们的框架推广到新组合的有效性。

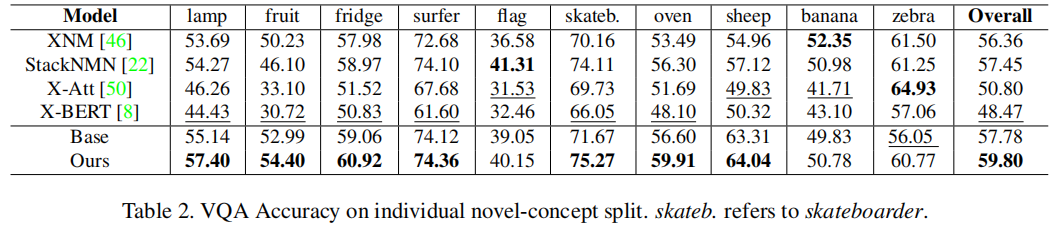

5.2 新概念VQA

对于这个实验,我们感兴趣的是模型从来没有被训练来回答关于一个概念的问题,但可以使用未标记的图像问题对,然后在提到这个给定概念的问题上进行测试。与之前的实验类似,对这些概念进行了采样,以最大化覆盖范围以及保持合理的测试规模。这种设置比之前的实验更具有挑战性,因为该模型错过了对任何具有给定概念的问题的VQA训练监督,而不是对任何同时具有给定概念和特定技巧的问题的VQA训练监督。

对于这种更具挑战性的新问答设置,平均而言,两种现有的transformer结构的性能明显低于其他模型。这可能表明,在大规模视觉和语言预训练中表现良好的transformer架构可能很难专门完成VQA任务。基础模型的性能略优于神经模块网络。最后,我们的框架平均优于所有模型,证明了它在新概念上提高VQA泛化能力方面的价值。

5.3 分析

概念接地

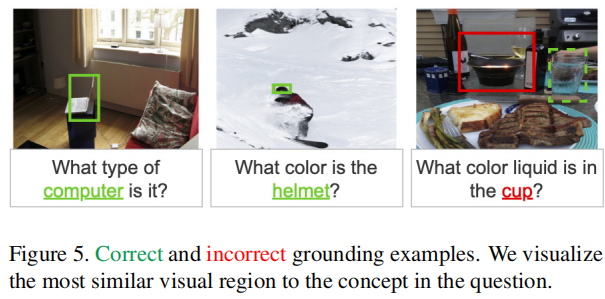

由于我们的方法在没有强监督的情况下学习接地概念,我们希望直接测试它的接地能力。为获得一个评估集,我们手动用图像中与每个元组中的概念对应的视觉区域注释320个图像-问题-概念元组。使用Faster RCNN得到候选视觉区域,使用召回@5作为接地度量,如果正确的视觉区域位于与目标概念令牌最相似的前5个视觉区域内,则考虑正确的接地。用我们的框架训练的模型实现了59.12的接地召回,而基地为43.71。请注意,我们的框架在没有额外的接地训练数据的情况下获得了这一改进。如图5所示,我们的模型通常可以正确地接地各种物体,但可以被模糊的概念所愚弄,比如错误的例子中的蜡烛。此外,学习区分几乎总是同时出现的概念(例如,“衬衫”和“人”)是具有挑战性的。

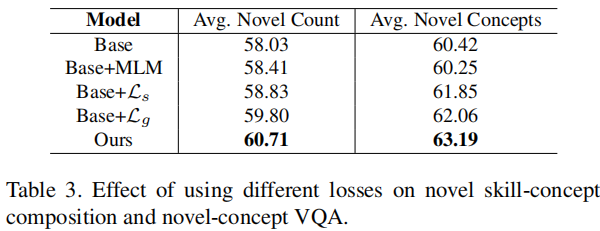

损失消融

我们通过采样三种新组成和三个新概念来减少损失,并报告它们的平均性能。增加我们的损失将导致一致的收益,并在我们的完整框架中达到最佳性能。当单独使用时,我们的接地损失似乎比技巧损耗有更大的好处。尽管如此,通过将这两个组成部分结合起来,仍然可以实现最佳的性能,这进一步支持了技能和概念分离的价值。我们还实验了一个掩蔽语言建模(MLM)目标[11]来代替我们的损失。我们的目标比MLM目标表现得更好,这意味着我们的目标提供的改进不仅仅是由于额外的数据。

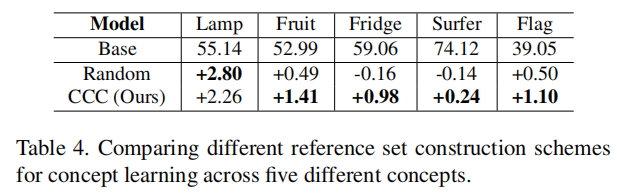

CCC参考集

为研究我们的CCC参考集选择策略的影响,我们将其与常用的随机抽样方法[3,41]进行了比较,并报告了新概念的VQA结果。我们用我们完整的框架来训练这两个模型,唯一的区别是概念损失的参考集构造方法。这两种模型都对基础模型进行了改进,我们的参考集构造方法提供了更一致的增益。

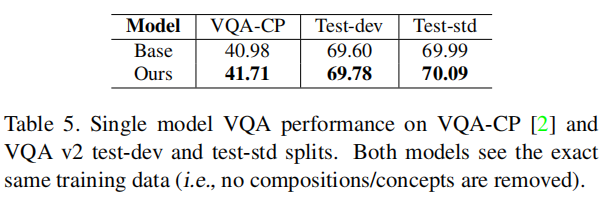

现有的基准测试

我们也在VQA-CP和VQA v2的test-dev/test-std集上进行评估,虽然我们看到了一般的增益,值得注意的是,我们的方法能够在VQA-CP上进行改进,而不需要额外的注释、集成/调优或在VQAv2上的性能下降。

六、结论

我们在VQA中提出了一个新的泛化设置:衡量组成回答问题所需的技巧和应该对图像接地的视觉概念的能力。我们表明,现有的方法很难推广到这两个因素的看不见的组成。我们提出了一种新的方法,隐式地分离技巧和概念,同时视觉上接地概念,使用对比学习程序。我们的方法能够从未标记的VQA数据中学习,以回答关于以前未见过的概念的问题。在VQAv2上的结果表明,所提出的框架可以在新的技巧概念组成上实现最先进的性能,并推广到未标记的数据中。

最后

以上就是眯眯眼小馒头最近收集整理的关于CVPR2021:Separating Skills and Concepts for Novel Visual Question Answering将技巧与概念分开的新视觉问答摘要一、介绍二、相关工作三、VQA的技巧-概念组合四、方法五、实验 六、结论的全部内容,更多相关CVPR2021:Separating内容请搜索靠谱客的其他文章。

发表评论 取消回复