Deep Reinforcement Learning for Dialogue Generation

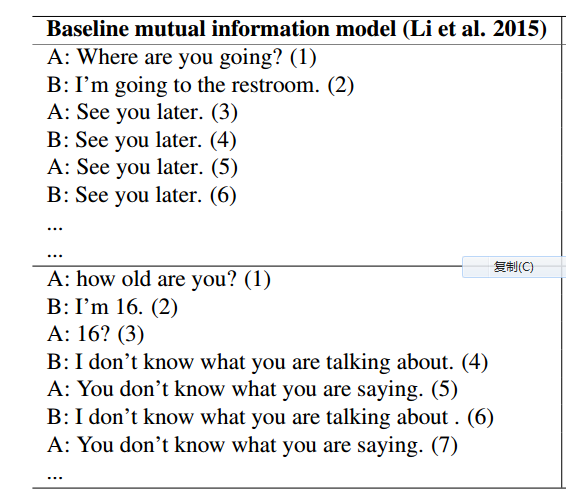

任务好理解,就是生成对话,之前采用最大似然来优化这个问题,会存在以下问题:

生成的最后开始变得毫无意义,作者想利用增强学习来缓解这一点。

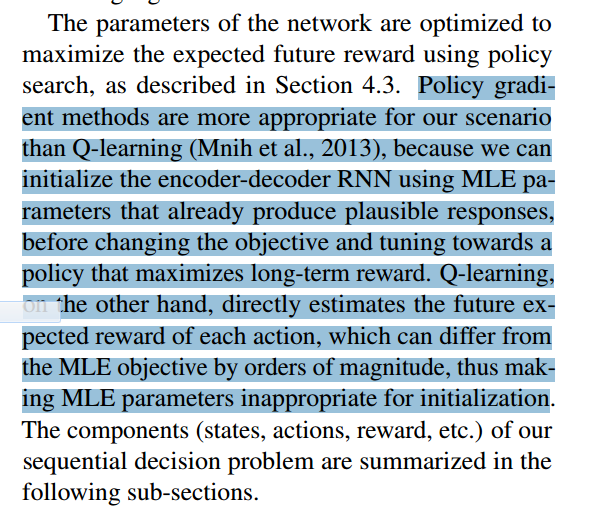

有关为什么用Policy Gradient不用Q-Learning,作者是这样解释的:

按照我对两种强化学习的理解,q-learning是最大化q值,action未必是最优的。policy是直接最优化action。有关初始化的差距也可能的确是一方面,这一点不是很确定。

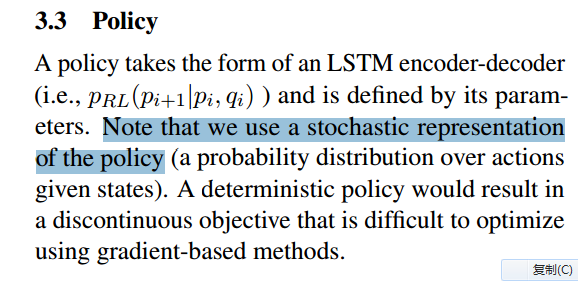

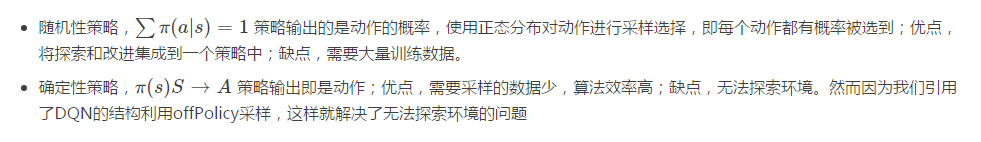

更进一步详细,这里的Policy,使用的是stochastic.

相关内容可以参看:

【强化学习】DDPG(Deep Deterministic Policy Gradient)算法详解

重点截图:

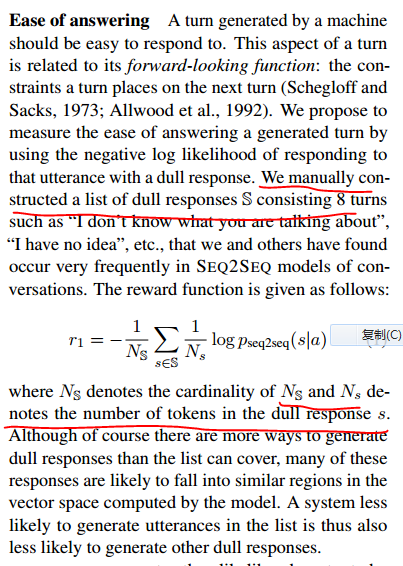

开头的问题怎么解决呢?就是在计算reward的时候把这种重复考虑进来:

首先作者统计了可能重复的句子,如果生成的句子偏向这种重复的,就给一个负的reward.(我其实好奇,如果不用增强学习,用最大估计是不是也能把这个损失加进去?可能不是特别好加,没有强化学习来的直观。)

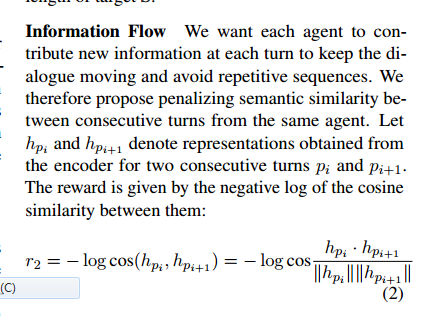

除了不能说“废话”的约束之外,还有一个不能说“重复的话”的约束,简单来说就不能一直说:我不知道,我不知道,我不知道。。。。(虽然在现实中会出现这种情况,不过毕竟是少数),这个“不能重复”的约束是怎么加的?是这样:

直接计算cos相似度,如果太相似,就给一个更负的reward.

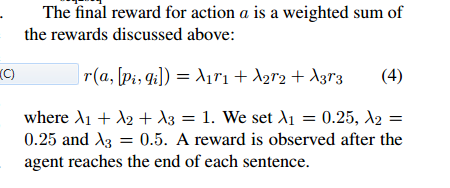

除了这两个reward,作者还提出一个,不能说“没有意义的话”,这里是不合逻辑的意思,就是给了上句,下句和这句应该是有关系的。有逻辑的,能够相互推理出来。如下:

也就是反向训练了一个生成器,讲道理,大部分情况下,应该是能互推的。

最后

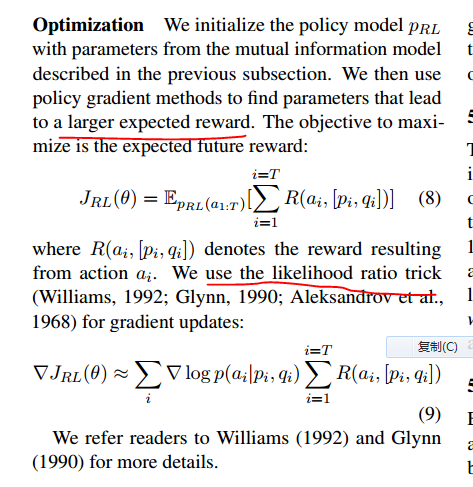

最后就optimization

最后

以上就是精明丝袜最近收集整理的关于Deep Reinforcement Learning for Dialogue Generation的全部内容,更多相关Deep内容请搜索靠谱客的其他文章。

发表评论 取消回复