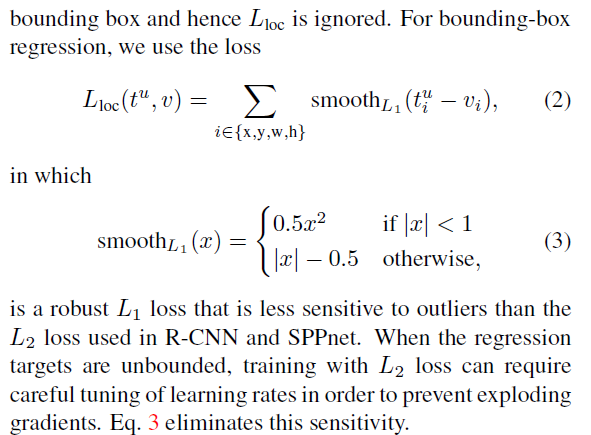

先把论文中这部分描述摘抄过来,如下图所示:

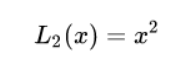

假设我们不适用smooth_L1,考虑L2函数

其梯度为

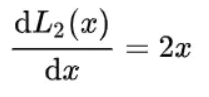

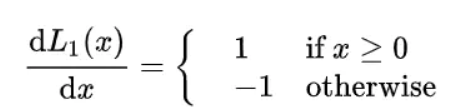

那么会出现一个原文描述的问题,when the regression targets are unbounded,既x很大的时候,会发生梯度爆炸,再考虑L1函数

此时会出现另外一个问题,当x变化很小的时候,梯度依旧很大,此时函数很有可能无法收敛(除非你控制学习率降低的更多,但是这样手工智能显然有点蠢。)

既然L2和L1都有缺点,那么我们各取其优点,结合起来会怎么样呢?

看smooth_L1表达式

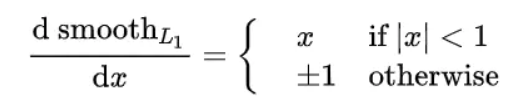

其梯度

刚好回避了之前的缺点,既当x过大的时候,梯度不会爆炸,x很小的时候,也可以拥有很小的梯度(不用担心梯度过小,那时候函数已经收敛了)

最后

以上就是谦让战斗机最近收集整理的关于fast-r-cnn论文中个为什么使用smooth_L1 (x),smooth_l1是什么?的全部内容,更多相关fast-r-cnn论文中个为什么使用smooth_L1内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复