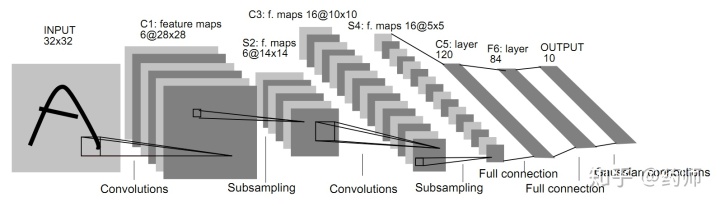

LeNet-5

相关文献: Gradient-based learning applied to document recognition

共有 7 层,2个(卷积层+降采样层)+2个全连接层+1个高斯连接层。

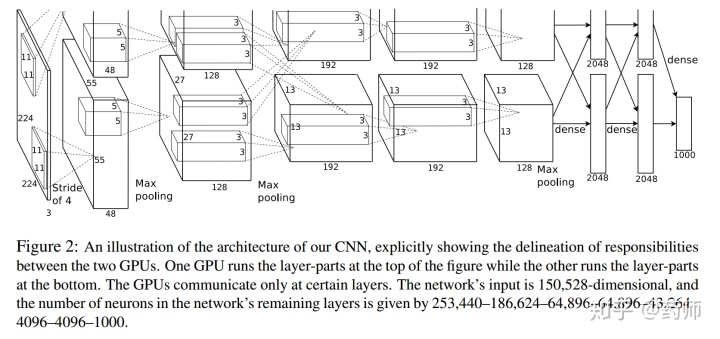

AlexNet

相关文献: ImageNet Classification with Deep Convolutional Neural Networks

AlexNet是ILSVRC竞赛 2012 年第一名,5个(卷积层+池化层)+3个全连接层。

The first convolutional layer filters the 224×224×3 input image with 96 kernels of size 11×11×3 with a stride of 4 pixels (this is the distance between the receptive field centers of neighboring neurons in a kernel map). The second convolutional layer takes as input the (response-normalized and pooled) output of the first convolutional layer and filters it with 256 kernels of size 5 × 5 × 48.

The third, fourth, and fifth convolutional layers are connected to one another without any intervening pooling or normalization layers. The third convolutional layer has 384 kernels of size 3 × 3 × 256 connected to the (normalized, pooled) outputs of the second convolutional layer. The fourth convolutional layer has 384 kernels of size 3 × 3 × 192 , and the fifth convolutional layer has 256 kernels of size 3 × 3 × 192.

The fully-connected layers have 4096 neurons each.

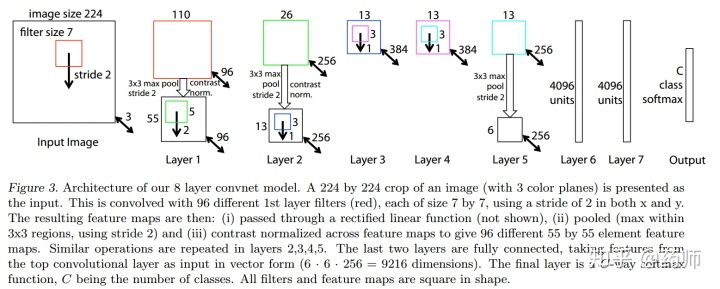

ZFNet

相关文献: Visualizing and Understanding Convolutional Networks

ZFNet是ILSVRC竞赛 2013 年第一名。

GoogLeNet 与 VGGNet

GoogLeNet是ILSVRC竞赛 2014 年第一名,VGG是ILSVRC竞赛 2014 年第二名。

GoogLeNet给出了Inception结构,Inception历经了V1、V2、V3、V4等多个版本的发展,不断趋于完善。

[1] - VGGNet

相关文献: Very Deep Convolutional Networks for Large-Scale Image Recognition

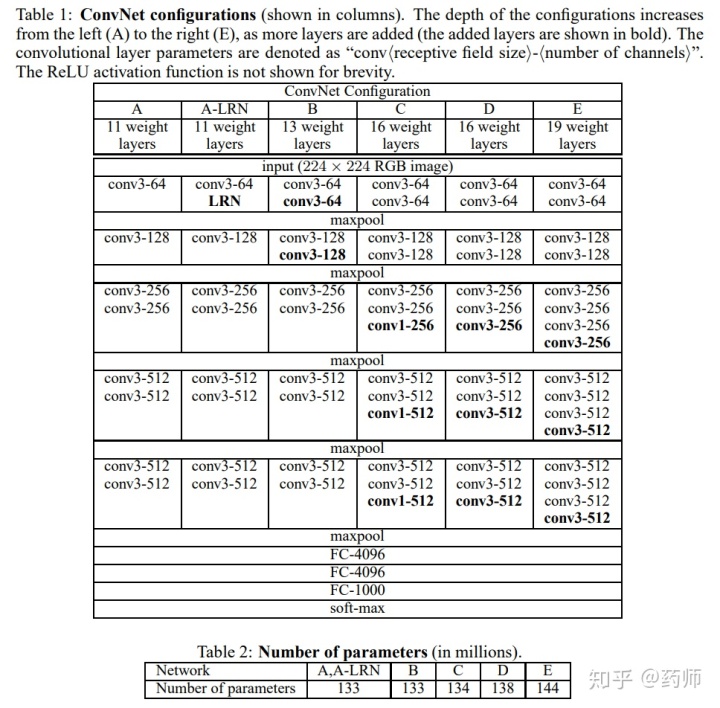

如下表所示,网络结构 D 就是著名的VGG-16,网络结构 E 就是著名的VGG-19。

[2] - GoogLeNet

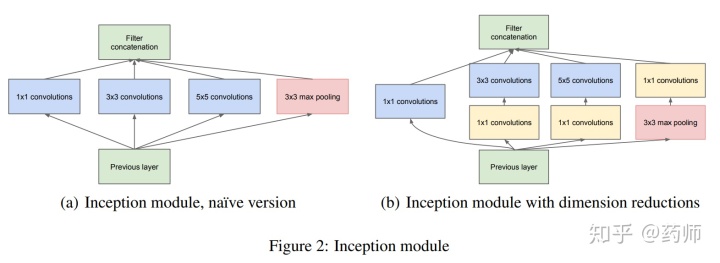

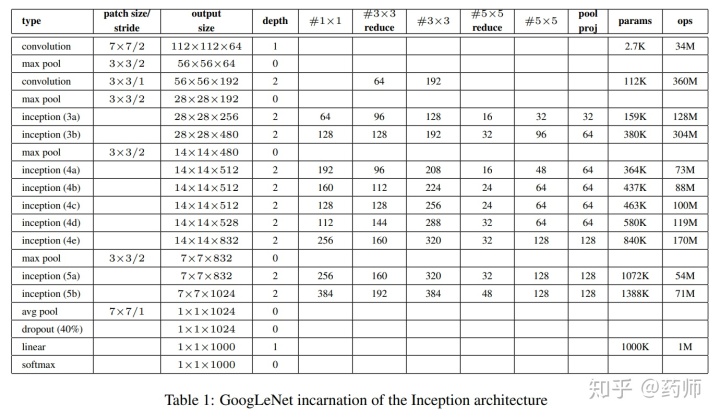

2014年9月的《Going deeper with convolutions》提出的Inception V1,将全连接,甚至卷积中的局部连接,全部替换为稀疏连接。相比之前的网络结构,GoogLeNet非常大胆地尝试了更小的卷积核,如下所示。GoogLeNet的完整网络架构图详见论文。

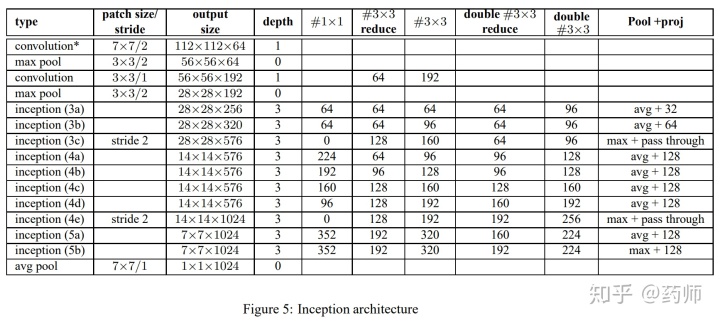

2015年2月的《Batch Normalization: Accelerating Deep Network Training by Reducing Internal Covariate Shift》提出的Inception V2,加入了BN(Batch Normalization)层,并且使用 2 个 3*3 替代 1 个 5*5 卷积。

2015年12月的《Rethinking the Inception Architecture for Computer Vision》提出的Inception V3,提出了卷积分解,将7*7分解成两个一维的卷积(1*7, 7*1),3*3也是一样(1*3, 3*1),这样的好处,既可以加速计算(多余的计算能力可以用来加深网络),又可以将 1 个 conv 拆成 2 个 conv ,使得网络深度进一步增加,增加了网络的非线性。

2016年2月的《Inception-v4, Inception-ResNet and the Impact of Residual Connections on Learning》提出的Inception V4,利用残差连接(Residual Connection)来改进v3结构,将 Inception模块 和 ResidualConnection 结合,使得训练加速收敛更快,精度更高。

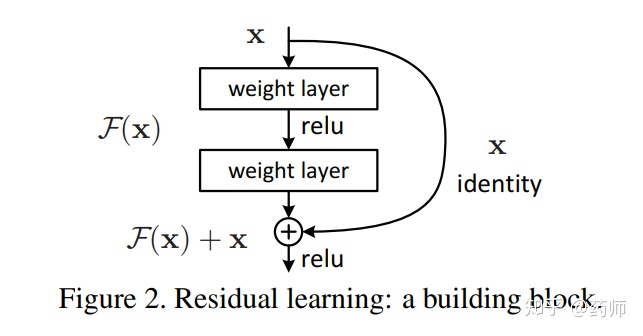

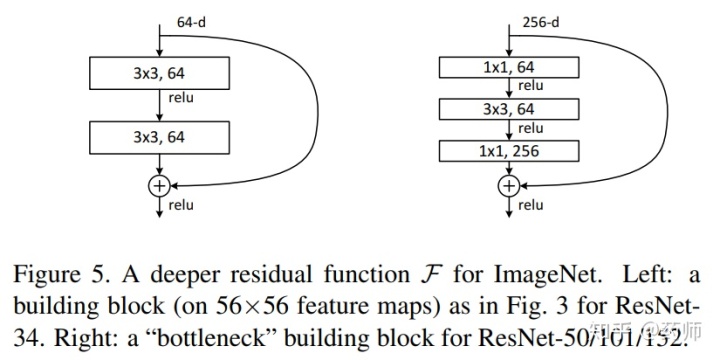

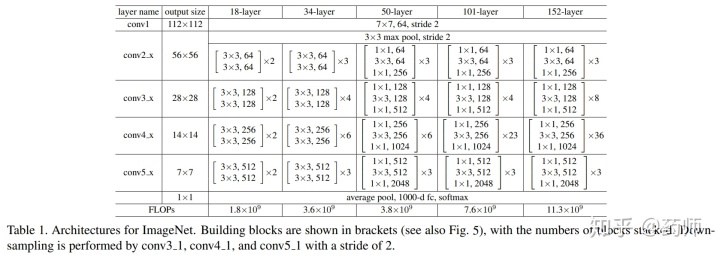

ResNet

ResNet是ILSVRC竞赛 2015 年第一名。ResNet结构看起来就感觉有很多冗余

相关文献: Deep Residual Learning for Image Recognition

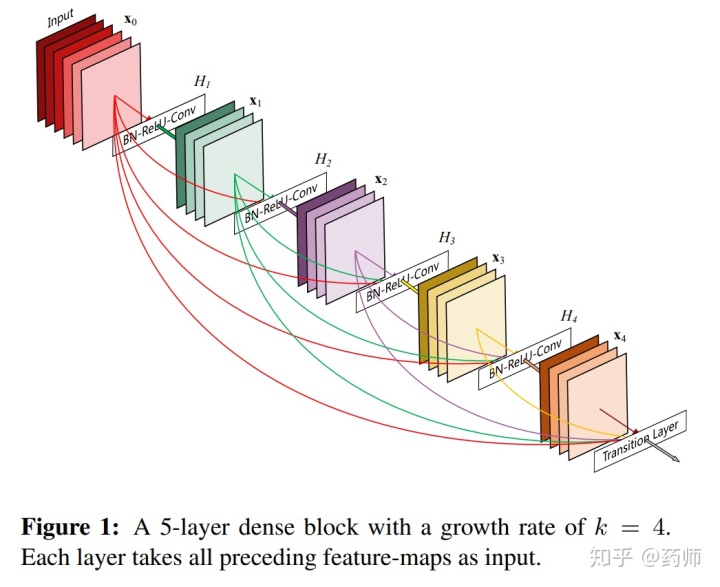

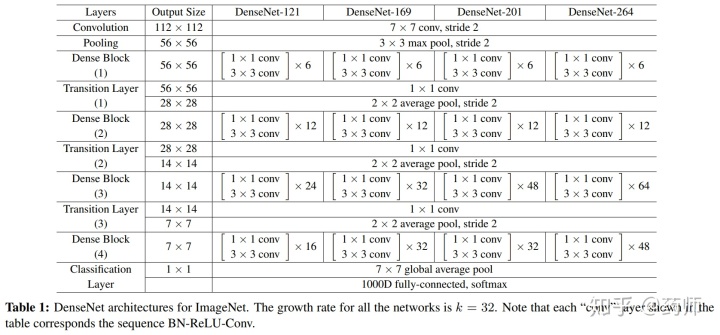

DenseNet

相关文献: Densely Connected Convolutional Networks

如下图所示,DenseNet的每一层的输出都会作为后面所有层的输入,提升了网络层级间信息流与梯度流的效率。

GBD-Net

GBD-Net是ILSVRC竞赛 2016 年第一名。

相关文献: Crafting GBD-Net for Object Detection

The effectiveness of GBD-Net is shown through experiments on three object detection datasets, ImageNet, Pascal VOC2007 and Microsoft COCO. This paper also shows the details of our approach in wining the ImageNet object detection challenge of 2016, with source code provided on craftGBD.

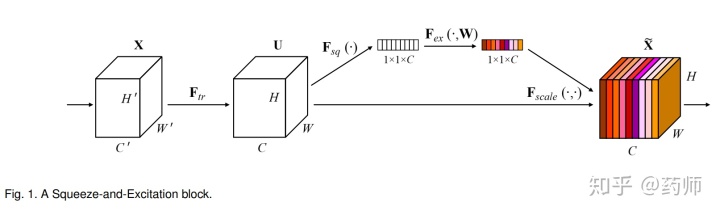

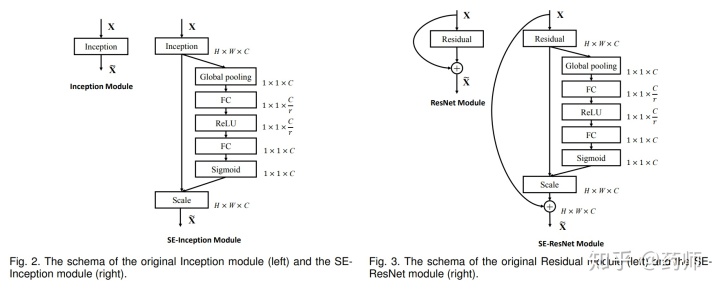

SENet

SENet是ILSVRC竞赛 2017 年第一名。

相关文献: Squeeze-and-Excitation Networks

Squeeze-and-Excitation Networks formed the foundation of our ILSVRC 2017 classification submission which won first place and reduced the top-5 error to 2.251%, surpassing the winning entry of 2016 by a relative improvement of ∼25%.

Models and code are available at https:// github.com/hujie-frank/ SENet .

SENet 的 Squeeze-Excitation 模块在普通的卷积(单层卷积或复合卷积)由输入 X 得到输出 U 以后,对 U 的每个通道进行全局平均池化得到通道描述子(Squeeze),再利用两层 FC 得到每个通道的权重值,对 U 按通道进行重新加权得到最终输出(Excitation),这个过程称之为 feature recalibration,通过引入 attention 重新加权,可以得到抑制无效特征,提升有效特征的权重,并很容易地和现有网络结合,提升现有网络性能,而计算量不会增加太多。

————————————————

也有其他人总结过类似的文章,可供参考

https://blog.csdn.net/shinef/article/details/100587245

https://zhuanlan.zhihu.com/p/58776542

https://blog.csdn.net/weixin_41770169/article/details/84985254

https://blog.csdn.net/ft_sunshine/article/details/90950048

https://my.oschina.net/u/876354/blog/1637819

最后

以上就是标致樱桃最近收集整理的关于inception网络_【DL】一些经典的神经网络架构总结的全部内容,更多相关inception网络_【DL】一些经典内容请搜索靠谱客的其他文章。

发表评论 取消回复