使用requests模块

使用requests.session()创建一个会话。然后使用会话进行链接请求。如果把cookies或headers放进请求参数中,在session进行第一次请求后,这些参数不会自动添加到后续的请求中。

因此,为了是参数在session中共用,应该将其添加到session上。

session = requests.session()

session.cookies = get_cookiejar()

session.headers = {}cookies需要是 requests.cookies.RequestsCookieJar。

获取一个已经登录网站的cookie

import requests

import browser_cookie3

def get_cookiejar_from_browser(domain):

cj = browser_cookie3.chrome(domain_name=domain)

cookiejar = requests.cookies.RequestsCookieJar()

for c in cj:

cookiejar.set(c.name, c.value, domain=c.domain, path=c.path)

return cookiejar

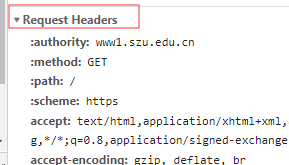

有一种方法,直接copy请求头,然后将其附着到session上,这样只能访问你copy的那个网页,cookies并不会真正的被设置。

requests设置代理:

import requests

proxies = {

"http": "http://10.10.1.10:3128",

"https": "http://10.10.1.10:1080",

}

requests.get("https://www.baidu.com/", proxies=proxies)https 证书验证:

import requests

url = 'https://kyfw.12306.cn/otn/leftTicket/init'

# 关闭证书验证

r = requests.get(url, verify=False)

print(r.status_code)

# 开启证书验证

# r = requests.get(url, verify=True)

# 设置证书所在路径

# r = requests.get(url, verify= '/path/to/certfile')使用cookie:

import requests

url = 'https://movie.douban.com/'

r = requests.get(url)

# r.cookies是RequestsCookieJar对象

print(r.cookies)

mycookies = r.cookies

# RequestsCookieJar转换字典

cookies_dict = requests.utils.dict_from_cookiejar(mycookies)

print(cookies_dict)

# 字典转换RequestsCookieJar

cookies_jar = requests.utils.cookiejar_from_dict(cookies_dict, cookiejar=None, overwrite=True)

print(cookies_jar)

# 在RequestsCookieJar对象中添加Cookies字典

print(requests.utils.add_dict_to_cookiejar(mycookies, cookies_dict))

最后

以上就是感性春天最近收集整理的关于python爬虫,自动登录的全部内容,更多相关python爬虫内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复