文章目录

- 1、ABSTRACT AND INTRODUCTION

- 2、ARCHITECTURE AND OPERATION

- 2.1 FL operation in Block FL

- 2.2 Blockchain operation in Block FL

- 2.3 One-epoch Block FL operation

- 3、END-TO-END LATENCY ANALYSIS

- 3.1 One-epoch Block FL latency model

- 3.2 Latency optimal block generation rate

- 4、NUMERICAL RESULTS AND DISCUSSION

- 5、REFERENCES

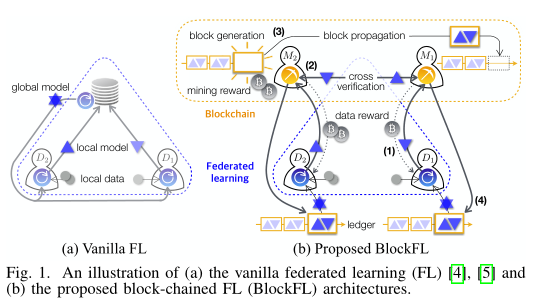

基于区块链的联邦学习体系架构

1、ABSTRACT AND INTRODUCTION

Google’FL Vanilla FL

每个设备可以交换其本地模型更新,即学习模型的权重和梯度参数

比原始数据模型更加注重隐私

global model:通过中央服务器聚集所有局部模型更新并取总体平均值,产生全局模型更新

local model:每个设备下载全局模型更新,并计算其下一个局部更新直到全局模型训练完成

eg:通过分布式随机梯度下降(SGD)

缺点:

1、 需要中央协调

易受集中服务器故障影响

由此产生不准确的全局模型更新扭曲了局部模型更新,可能导致整个训练崩溃

????????????????????????

这就需要分布式FL体系结构

2、 需要大量的数据样本,并且需要与其他设备进行数据样本交换

在没有提供与样本数量成比例的适当补偿的情况下,这种设备不太愿意与拥有少量数据样本的其他设备联合

补偿机制带来的副作用, 一些不诚实的设备伪造具有比实际样本大小更多的数据样本,从而在FL产生不准确的全局模型更新

????????????????????????

为了解决私有交换和奖励机制的问题,利用区块链而不是中央实体

作者提出:block-chained federated learning(BLOCK FL)

移动设备的本地学习模型更新通过利用区块链来交换和验证

无中央协调通过交换本地数据来训练每个设备的本地模型

challenges

※ 本地数据样本归每个设备所有

交换时对其他设备保密原始数据样本

※本地设备的奖励系统

具有大量数据样本的设备对全局模型训练更大,同时消耗更多的计算能力和时间

Block FL架构

Block FL的逻辑结构由移动设备和矿工组成,矿工可以是随机选择的设备,也可以是独立的节点。

区块链网络允许交换设备的本地模型更新,同时能够验证和提供他们相应的奖励。

Block FL具体操作如下:

1、Block FL中每个设备计算本地模型更新并将其上传到区块链网络中与其关联的矿工

同时作为回报,从矿工接受与其数据样本数量成比例的数据奖励

2、矿工交叉验证所有本地模型更新,然后运行工作证明算法(pow)

3、一旦矿工完成pow,它生成一个块,在该块中记录已验证的本地更新,并从区块链网络中接收采矿奖励

4、最终,存储聚合本地模型更新的生成块被添加到区块链,也称为分布式账本,并由设备下载。每个设备从最新的块计算全局模型更新,这是下一个本地模型更新的输入。

※Block FL全局模型更新是在每个设备本地计算的

因此,矿工/设备在全局模型更新中的故障不会影响其他设备的局部全局模型更新,从而确保整体训练的健壮性。

但与普通FL相比,Block FL需要支付区块链网络产生的额外延迟

为了解决这个问题,Block FL的端到端的延迟模型是通过考虑FL模型和区块链操作期间的通信,计算和POW延迟来制定。通过调整区块生成速率(即POW难度),最大限度减少延迟

2、ARCHITECTURE AND OPERATION

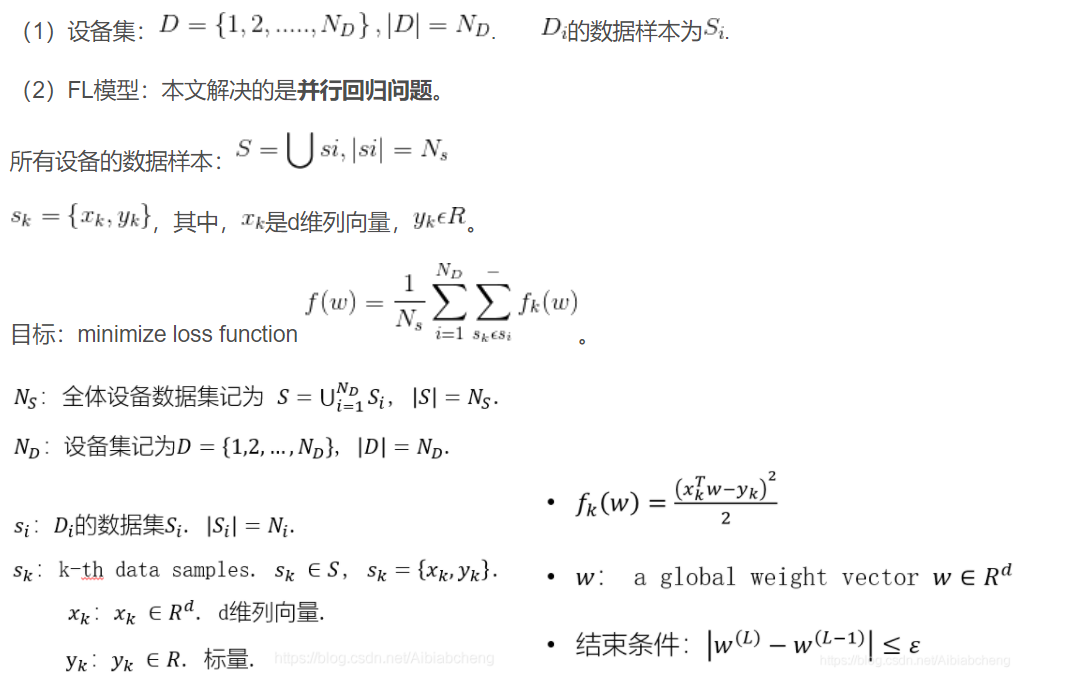

2.1 FL operation in Block FL

Di的本地模型更新被上传到其相关联的矿工Mi

If 矿工在物理上与设备相同 M=D,否则M!=S

Then 通过矿工验证和交换本地模型更新的总数ND

Finally 聚集的本地模型更新从每个矿工下载到其相关联的设备

方便起见,分布式模型训练集以并行方式解决线性回归问题

为了解决上述回归问题,与[4]中谷歌的普通FL一样

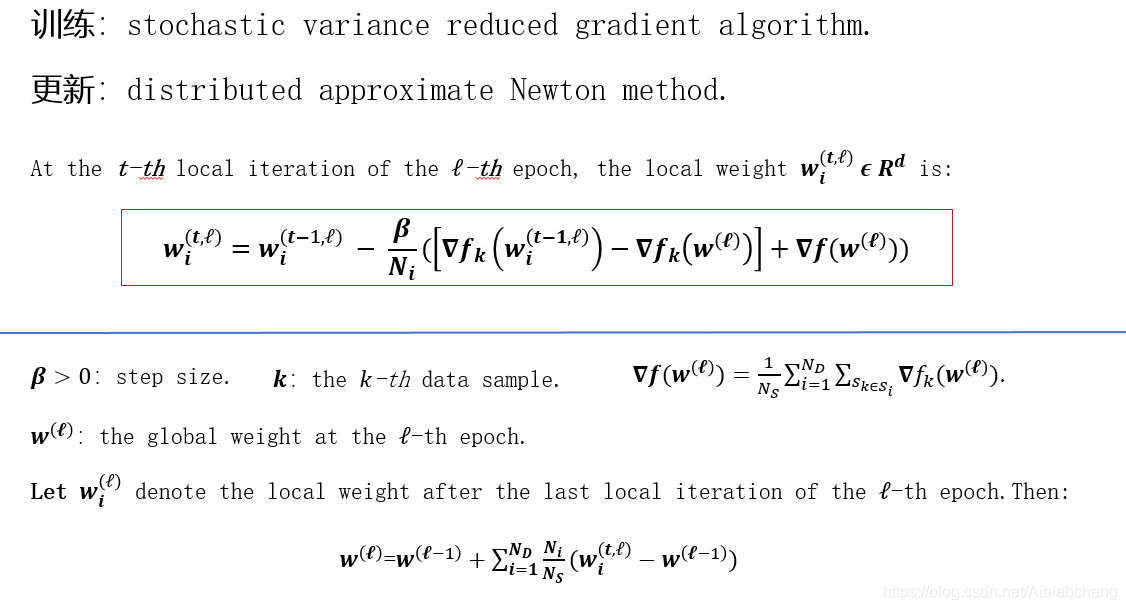

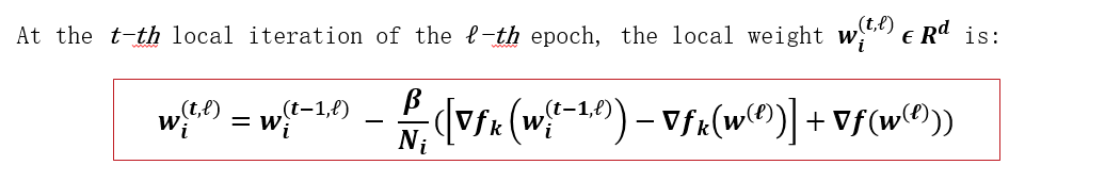

(1)设备Di学习模型通过随机方差消减梯度算法(SVRE) 用其数据样本所设置的Si进行局本训练

(2)使用分布式拟牛顿法(DANE)方法聚合所有设备的局部模型更新,产生全局模型更新

2.2 Blockchain operation in Block FL

在BlockFL的区块链网络中,区块及其M中矿工的验证旨在通过分布式帐本真实是的交换本地模型更新。

账本中的每个块都分为它的区块头和区块体部分。

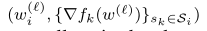

在传统的区块链结构中[9],区块体部分包含一个经过验证的交易列表。在BlockFL中,区块体存储了D中设备的本地模型更新,即为

按照[7]的结构,区块头部分包含前一个块的指针信息,块生成率λ和POW算法的输出值(nonce)。

为了存储所有设备的本地模型更新,每个块大小设为

↓ ↓

头部和模型更新大小

每一个矿工都有一个候选块,该块按照到达的顺序提供了来自其关联设备或者其他矿工的本地模型更新。

填充过程一直持续到它到达块的大小或者每个周期开始测量的最大等待时间。简单起见,假设最大等待时间足够长,以便每块总是被所有设备的本地模型更新填满。

之后,按照PoW算法 [7],矿工继续生成随机数,直到该随机数nonce变得小于目标值。一旦矿工M1成功地找到这个随机数,它的候选块就被允许生成为新块

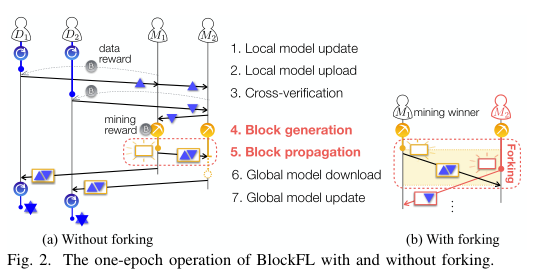

如图2所示。这里,可以通过调整pow难度来控制块生成速率λ。

eg:pow目标值越低,λ越小。

接下来,将生成的块传播给所有其他矿工,以便同步他们所有的分布式帐本。为此,正如在[7]中所做的那样,所有接收生成块的矿工都被迫停止他们的PoW操作,并将生成块添加到他们的本地账本中。

如果另一个矿工M2在第一个生成的块的传播延迟内成功地生成了它的区块,那么一些矿工可能会错误地将第二个生成的块添加到它们的本地账本中,这被称为forking(分叉)。在BlockFL中,forking使一些设备将不正确的全局模型更新应用到它们的下一个局部模型更新。forking频率随着λ和块传播延迟的增加而增加,其减缓会产生额外的延迟。

除了本地模型更新交换操作外,区块链网络还对设备的数据样本提供奖励,对矿工的验证过程提供奖励,分别称为数据奖励和采矿奖励。设备Di的数据奖励从其关联的矿工接收,其数量与数据样本大小Ni成正比。当矿工Mj生成一个块时,它的采矿奖励由区块链网络获得,就像传统的区块链结构[7]一样。

采矿奖励的数量与其所有关联设备的数据样本总量成正比,即

其中NMj表示与矿工 Mj关联的设备数量。这促使矿工收集更多的本地模型更新,同时补偿他们的数据奖励支出。

作为奖励系统的一个副作用,一些不诚实的设备可能通过夸大用于本地模型数据的实际样本大小或者在不进行本地学习计算的情况下生成任意的本地模型更新来欺骗矿工。矿工在将本地模型更新存储在其候选块中之前,会验证真实的本地更新。

验证是通过将样本大小Ni 与其相应的本地计算时间Tloacl进行比较来执行的,这被认为是真实的,在例如Intel的SGX技术[14]下,经过时间的证明[13]。

2.3 One-epoch Block FL operation

设备Di在每一轮周期Block FL的7个步骤

0.初始化:初始参数从预定义的范围均匀随机选择,对于一个常数,局部模型和全局模型权重

以及全局梯度

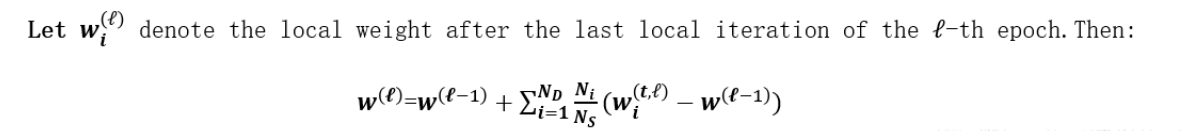

1.本地模型更新:设备Di用Ni的迭代次数计算(2)

2.本地模型上传:设备Di 与矿工Mi 均匀随机关联

If M=D, 则从 MDi 中挑选Mi

设备上传本地模型更新 及相应的本地计算时间Tlocal,i 到其相关联的矿工

3. 交叉验证:矿工广播从其相联设备获得的本地模型更新。同时,矿工按照到达的顺序验证从他们相关联的设备或其他矿工接收到的本地模型更新。

如果局部模型计算时间Tlocal,i与数据样本大小Ni成正比, 局部模型更新的真实性得到验证。

已验证的本地模型更新记录在矿工的候选区块中,直到其达到区块大小 或最大等待时间Twait。

4. 块生成:每个矿工运行POW,直到找到随机数nonce或从另一个矿工收到生成块。

5. 块传播:首次找到nonce的矿工的候选块被作为新块并传播给其他矿工,矿工从区链网络上获得挖矿奖励(mining reward)。为了避免链分叉,一旦每个矿工接收到新的块或当每个矿工没有检测到分叉事件时,就发送一个ACK确认信号,包括是否发生forking。

每个矿工等待,直到收到所有矿工的确认信号;否则,操作从步骤1重新开始。

6. 全局模型下载:设备Di从其相关联的矿工下载生成的区块

7. 全局模型更新:设备Di在(3)中通过使用存储在生成区块的聚合局部模型更新来计算全局模型更新。

当全局权重W 满足

周期过程停止。

集中式FL结构容易收到服务器故障的影响,以至于扭曲所有设备的全局模型更新。

与此相比,Block FL中每个设备都在本地计算它的全局模型更新,因此对于取代服务器实体的矿工的故障来说更加健壮。

3、END-TO-END LATENCY ANALYSIS

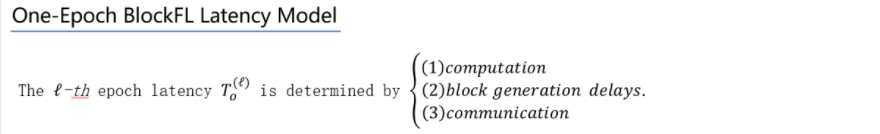

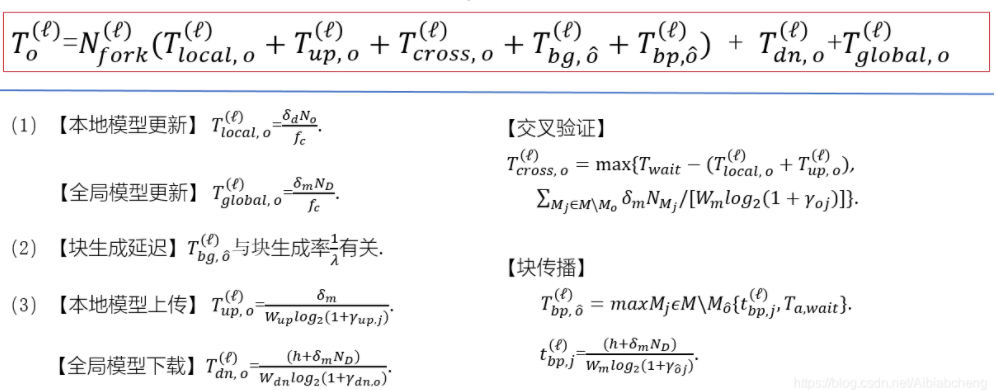

3.1 One-epoch Block FL latency model

3.2 Latency optimal block generation rate

单周期延迟表达式,目标是为了推导出最优块生成速率 λ *,使设备D0第l 个周期pow过程的平均延迟最小。

pow过程会影响块生成延迟,快传播延迟以及分叉forking发生的数量,这些因矿工中成功者M0相互依赖。

为了避免上述困难,所有矿工通过调整Twait同步启动他们pow进程

使得

在这种情况下,即使是较早完成交叉验证的矿工也会一直等待到Twait,从而提供了性能的下界,即延迟的上界。

4、NUMERICAL RESULTS AND DISCUSSION

用数值方法评估了所提出的Block FL的平均学习完成延迟

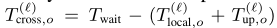

图3显示了块生成速率 λ 对Block FL 的平均学习完成延迟的影响

在图3-a中,我们观察到延迟图像在 λ 上呈凸形,并且随着信噪比(SNR)的增加而减少。

在图3-b中,对于最佳块生成速率 λ *,从 Proposition 1中获得的最小平均学习完成延迟时间总是比在没有近似情况下模拟的最小延迟时间长1.5%。

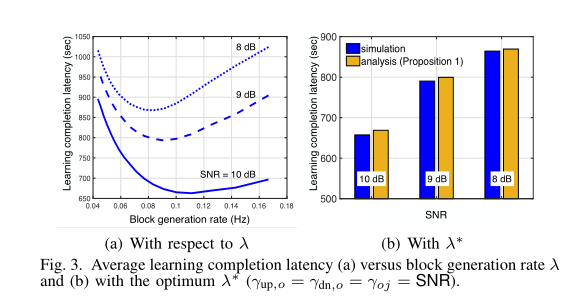

图4分别说明了BlockFL在矿工和设备的数量NM和ND方面的可扩展性。

- 在图4-a中,计算了在NM= 1和NM= 10条件下,无论矿工是否发生故障,平均学习完成延时。

- 故障时可以通过添加高斯噪声N(−0.1,0.01)到每个矿机的本地模型更新的聚合概率为0.5来捕捉。

- 在没有任何故障的情况下,矿工较多时会由于它们的交叉验证和块传播延迟的增加而增加延迟。

- 在矿工的故障情况下,这一点并不总是成立。

- 在BlockFL中,每个矿工的故障只会扭曲其关联设备的全局模型更新。这种扭曲可以通过与矿工正常工作的其他设备联合来恢复。由于这个原因,矿工数量较多时能实现更短的延迟,正如观察到的故障时NM=10。

更多的设备数量ND可能由于使用了更多的数据样本而降低了学习完成延迟。

与此同时,增加了每个区块的大小,即通信有效载荷,从而导致更高的块交换延迟,从而导致相对于ND的延迟模型呈凸形。

在这方面,适当的设备选择有可能减少延迟,如[5],[10]所研究的。

最后,从图4-b可以看出,随着每个设备的本地模型尺寸δm的增加,延迟增加。

5、REFERENCES

[1] P . Popovski, J. J. Nielsen, C. Stefanovic, E. de Carvalho, E. G. Ström,

K. F. Trillingsgaard, A. Bana, D. Kim, R. Kotaba, J. Park, and R. B.

Sørensen, “Wireless Access for Ultra-Reliable Low-Latency Communi-

cation (URLLC): Principles and Building Blocks,” IEEE Netw., vol. 32,

pp. 16–23, Mar. 2018.

[2] M. Bennis, M. Debbah, and V . Poor, “Ultra-Reliable and Low-Latency

Wireless Communication: Tail, Risk and Scale,” [Online]. Available:

https://arxiv.org/abs/1801.01270.

[3] J. Park, D. Kim, P . Popovski, and S.-L. Kim, “Revisiting Frequency

Reuse towards Supporting Ultra-Reliable Ubiquitous-Rate Communica-

tion,” in Proc. IEEE WiOpt Wksp. SpaSWiN, Paris, France, May 2017.

[4] J. Koneˇ cn´ y, H. B. McMagan, D. Ramage, “Federated Optimization:

Distributed Machine Learning for On-Device Intelligence,” [Online].

Available: https://arxiv.org/abs/1610.02527.

[5] H. B. McMahan, E. Moore, D. Ramage, S. Hampson, B. A.y Arcas,

“Communication-Efficient Learning of Deep Networks from Decentral-

ized Data,” in Proc. AISTATS, F ort Lauderdale, FL, USA, Apr. 2017.

[6] J. Chen, R. Monga, S. Bengio, and R. Jozefowicz, “Revisiting Dis-

tributed Synchronous SGD,” in Proc. ICLR, San Juan, Puerto Rico,

May 2016.

[7] S. Nakamoto, “Bitcoin: A Peer-to-Peer Electronic Cash System,” [On-

line]. Available: https://bitcoin.org/bitcoin.pdf.

[8] C. Decker, and R. Wattenhofer, “Information Propagation in the Bitcoin

Network,” in Proc. IEEE P2P , Trento, Italy, Sep. 2013.

[9] S. Samarakoon, M. Bennis, W. Saad, and M. Debbah, “Distributed

Federated Learning for Ultra-Reliable Low-Latency V ehicular Commu-

nications,” [Online]. Available: https://arxiv.org/abs/1807.08127.

[10] T. Nishio, R. Y onetani, “Client Selection for Federated Learning

with Heterogeneous Resources in Mobile Edge,” [Online]. Available:

https://arxiv.org/abs/1804.08333., 2018.

[11] R. Johnson and T. Zhang, “Accelerating Stochastic Gradient Descent

Using Predictive V ariance Reduction,” in Proc. NIPS, Lake Tahoe, NV ,

USA, Dec. 2013.

[12] O. Shamir, N. Srebro, and T. Zhang, “Communication-Efficient Dis-

tributed Optimization Using An Approximate Newton-Type Method,”

in Proc. ICML, Beijing, China, Jun. 2014.

[13] L. Chen, L. Xu, N. Shah, Z. Gao, Y . Lu, and W. Shi, “On Security

Analysis of Proof-of-Elapsed-Time,” in Proc. SSS, Boston, MA, USA,

Nov. 2017.

[14] V . Costanand, and S. Devadas, “Intel SGX Explained,” Cryptologye

Print Archive Report 2016/086, 2016.

[15] 3GPP TS 36.300 v13.4.0, “E-UTRA and E-UTRAN; Overall Descrip-

tion; Stage 2,” Tech. Rep., 2016.

最后

以上就是仁爱麦片最近收集整理的关于《On-device federated learning via blockchain and its latency analysis》论文笔记1、ABSTRACT AND INTRODUCTION2、ARCHITECTURE AND OPERATION3、END-TO-END LATENCY ANALYSIS4、NUMERICAL RESULTS AND DISCUSSION5、REFERENCES的全部内容,更多相关《On-device内容请搜索靠谱客的其他文章。

发表评论 取消回复