文章目录

- 2020

- A Cross Entropy Based Deep Neural Network Model for Road Extraction from Satellite Images(entropy)

- Render U-Net: A Unique Perspective on Render to Explore Accurate Medical Image Segmentation

- ContourRend: A Segmentation Method for Improving Contours by Rendering

- 2021

- Progressive Semantic Segmentation(CVPR)

- BoundarySqueeze: Image Segmentation as Boundary Squeezing

- RefineMask: Towards High-Quality Instance Segmentation with Fine-Grained Features(CVPR)

- PointFlow: Flowing Semantics Through Points for Aerial Image Segmentation(CVPR)

- Look Closer to Segment Better:Boundary Patch Refinement for Instance Segmentation

- Lightweight boundary refinement module based on point supervision for semantic segmentation

- Spatially Adaptive Feature Refinement for Efficient Inference

- Pointnet: Learning Point Representation for High-Resolution Remote Sensing Imagery Land-Cover Classification

- 2022

- NPCNet: Jointly Segment Primary Nasopharyngeal Carcinoma Tumors and Metastatic Lymph Nodes in MR Images

2020

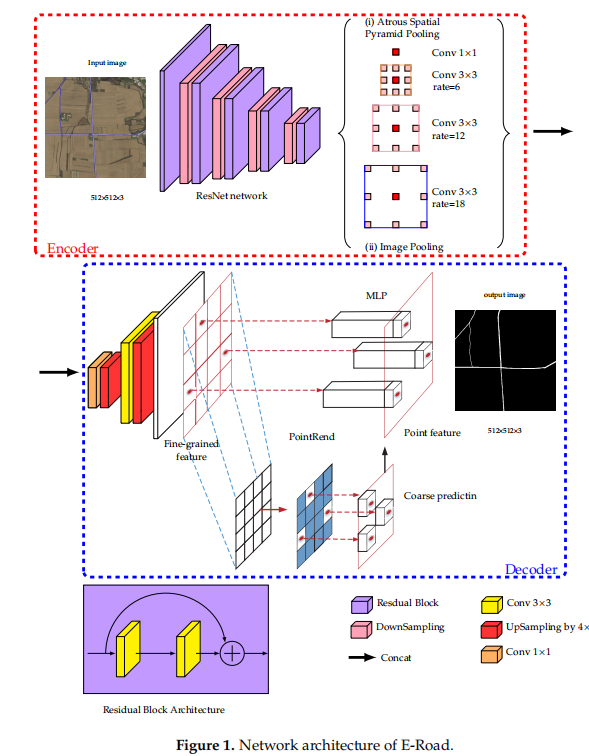

A Cross Entropy Based Deep Neural Network Model for Road Extraction from Satellite Images(entropy)

摘要

本文提出了一种具有编解码器结构的深度卷积神经网络模型,从卫星图像中提取道路网络。我们采用ResNet-18和空间空间金字塔池技术在提取精度和运行时间之间进行权衡。提出了一种改进的交叉熵损失函数来训练我们的深度模型。利用PointRend算法恢复光滑、清晰、清晰的道路边界。利用增强的深度球数据集对我们的深度模型进行训练,并采用异步训练方法来加速训练过程。以小木村的5幅盐砾石图像为输入,对模型进行评价。所提出的电子书路模型的参数数较少,训练时间较短。实验表明,E-Road以59.09%~5984%的深度模型,可以对复杂环境下的图像进行准确的预测。

论文的贡献

- 1)提出了一种新的编码器深度网络,采用ResNet作为编码器模偶,简单而有效的上采样层和解码器算法作为解码器模块。

- 2)我们使用空间空间金字塔池(ASPP)技术在精度和运行时间之间进行权衡。

- 3)我们应用一个改进的交叉熵损失函数来提高道路数据集训练过程的性能。

- 4)我们采用了一种异步训练的方法,以加快训练时间而不损失性能。

- 5)与其他深度网络相比,该模型在较低的情况下取得了良好的性能。

Render U-Net: A Unique Perspective on Render to Explore Accurate Medical Image Segmentation

摘要: 器官损伤的死亡率很高,对人们的生命构成严重威胁。准确地分割器官有助于医生的诊断。目前还需要一种先进的医学图像分割模型。然而,大多数分割模型都是直接从自然图像分割模型中迁移过来的。这些模型通常忽略了边界的重要性。为了解决这一困难,在本文中,我们提供了一个独特的渲染视角来探索精确的医学图像分割。我们采用了一种基于细分的点采样方法来获得高质量的边界。此外,我们将注意力机制和嵌套的U-Net架构集成到所提出的网络渲染U-Net中。渲染U-Net在三个公共数据集上进行了评估,包括LiTS、chasos和DSB。该模型在5个医学图像分割任务中表现最好。

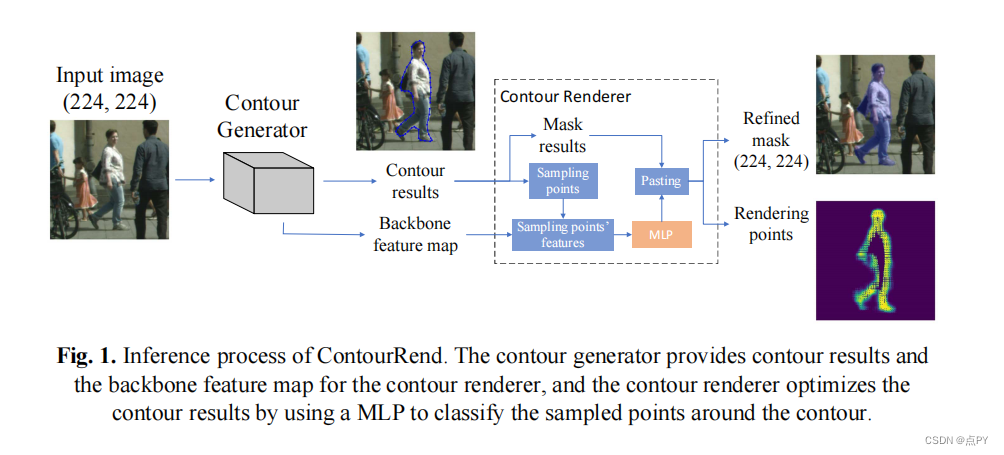

ContourRend: A Segmentation Method for Improving Contours by Rendering

code: https://github.com/CUQS/ContourRend

摘要: 一个好的目标分割应该包含清晰的轮廓和完整的区域。然而,基于掩模的分割不能在粗糙的预测网格上很好地处理轮廓特征,从而导致边缘模糊的问题。而基于轮廓的分割直接提供了轮廓,但忽略了轮廓的细节。为了获得精细的轮廓,我们提出了一种名为轮廓轮廓的分割方法,它采用轮廓渲染器来细化分割轮廓。并在一个基于图卷积网络(GCN)的分割模型上实现了我们的方法。对于城市景观数据集上的单个对象分割任务,使用基于GCN的分割轮廓生成单个对象的轮廓,然后我们的轮廓渲染器聚焦于轮廓周围的像素,并以高分辨率预测类别。通过绘制轮廓结果,我们的方法达到了并集(IoU)的均交72.41%,超过基线Polyon-GCN1.22%。

2021

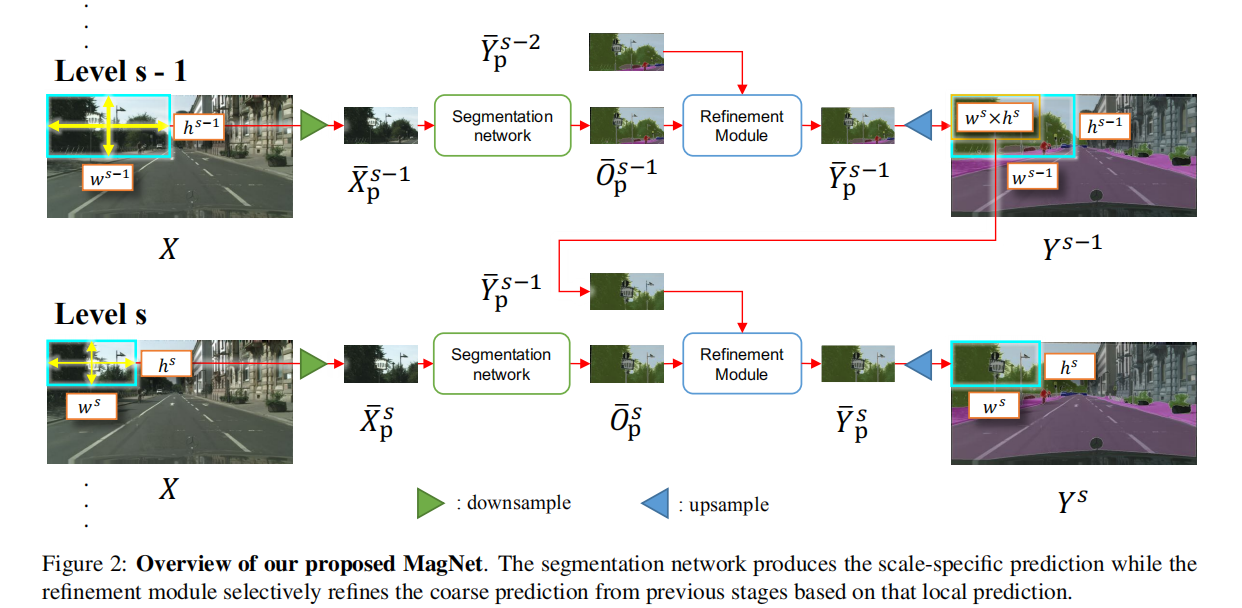

Progressive Semantic Segmentation(CVPR)

code : https://github.com/VinAIResearch/MagNet

摘要

这项工作的目的是分割高分辨率的图像,而不超载GPU内存的使用或丢失输出分割地图中的细节。内存约束意味着我们要么必须对大图像进行降采样,要么将图像分割成局部补丁以进行单独处理。然而,前一种方法将失去细节,而后者可能由于缺乏全球图景而模棱两可。在这项工作中,我们提出了磁铁,一个多尺度的框架,通过观察在多个放大水平上的图像来解决局部模糊性。磁铁有多个处理阶段,其中每个阶段对应一个放大级别,并将一个阶段的输出输入下一个阶段,进行粗到细的信息传播。每个阶段以比前阶段更高的分辨率分析图像,恢复之前由于有损降采样步骤而丢失的细节,并通过处理阶段逐步细化分割输出.在城市景观、空中场景和医学图像的三个高分辨率数据集上进行的实验表明,磁铁的性能始终显著优于最先进的方法。

论文的贡献

为了弥合尺度空间的两端之间的差距,我们建议考虑两者之间的多个尺度。我们引入了一种新的多尺度框架,其中输出分割图的分析时,将逐步细化。我们的框架的核心是一个细化模块,它可以使用一个分割映射来细化另一个分割映射。这个细化模块用于我们的多尺度处理管道的每个阶段,以在其最不确定的位置细化输出分割映射。我们的框架可以集成全局上下文线索,以产生更准确的分割,并可以在内存约束下输出高分辨率的详细分割图。无花果1显示了磁网的结果,并与其他分割方法进行了比较,包括最近提出的PointRend[14]方法,该方法寻求只在最不确定的像素上进行细化。

在本文中,我们提出了一个具有任意数量的尺度级别的模块化框架。它对于细化粗分割输出既简单又有效,能够保持粗分割输出的整体结构,同时在每个阶段后添加更多的细节,而不受支配问题。表1比较了不同方法的关键特征。

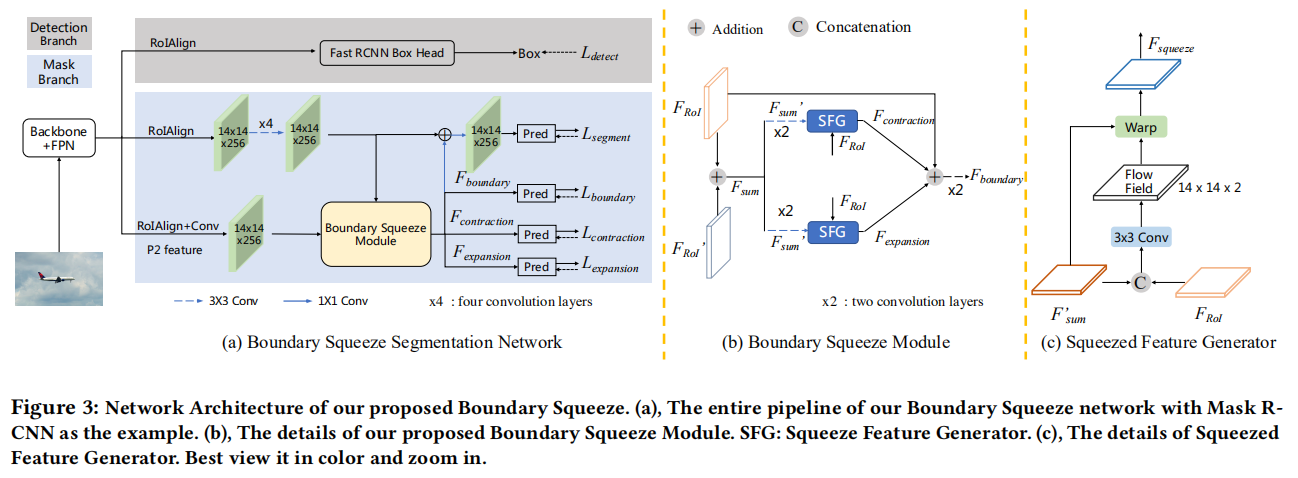

BoundarySqueeze: Image Segmentation as Boundary Squeezing

https://github.com/lxtGH/BSSeg

摘要

提出了一种新的细粒度高质量图像分割方法。受形态学图像处理技术的扩张和侵蚀的启发,我们将像素级分割问题视为压缩对象边界。从这个角度来看,我们提出了边界挤压模块:一种新颖而有效的模块,它可以从内外两个方向上挤压物体的边界,从而得到精确的掩模表示。为了生成这种压缩表示,我们提出了一种新的基于双向流的扭曲过程,并设计了特定的损失信号来监督学习过程。边界压缩模块通过构建在现有模型之上的即插即用模块,可以很容易地应用于实例和语义分割任务。我们表明,我们的简单而有效的设计可以在几个不同的数据集上导致高定性的结果,我们还提供了几个不同的边界度量来证明比以前的工作的有效性。此外,该模块的权重较轻,具有实际应用的潜力。我们的方法在COCO、城市景观等实例和语义分割方面获得了很大的收益,并且在相同设置下的准确性和速度上都优于之前的优点。

论文的贡献

- 通过将分割作为边界压缩过程,提出了边界压缩,一种新的有效的边界压缩模块。该模块通过不同的标签进行监督,这可以从掩码注释中免费获得。

- 边界挤压可以作为一个即插即用模块,轻松部署到当前最先进的分割方法中,包括MaskR-CNN[27]和DeeplabV3+[11]。大量的实验和分析验证了该方法的有效性。

- 我们的方法可以产生更精细的边界结果。它的结构输出比PointRend[38]有更多的结构输出。在COCO[44]和城市景观数据集上的不同指标上,我们获得了比PointRend和边界保护掩码RCNN[15]更好的结果。

- 该方法还对城市景观[16]和BDD[72]数据集上的语义分割任务进行了验证。它还显著改进了强大的DeeplabV3+模型[11]。

RefineMask: Towards High-Quality Instance Segmentation with Fine-Grained Features(CVPR)

code : https://github.com/zhanggang001/RefineMask

摘要

例如分割的两阶段方法,如MaskR-CNN,最近取得了良好的性能。然而,由于特征金字塔和实例级池化过程中的降采样操作,分割后的掩模仍然非常粗糙,特别是对于大型对象。在本工作中,我们提出了一种新的方法,用于对象和场景的高质量实例分割,该方法在实例分割过程中包含细粒度特征。通过逐步地融合更详细的信息,能够持续地改进高质量的掩模。改进成功地分割了硬情况,例如被以前大多数方法过度平滑的对象的弯曲部分,并输出精确的边界。在没有附加功能的情况下,在COCO、LVIS和城市景观基准测试上,RefineMask分别比MaskR-CNN显著提高了2.6、3.4、3.8AP,而需要少量额外的计算成本。

PointFlow: Flowing Semantics Through Points for Aerial Image Segmentation(CVPR)

code : https://github.com/lxtGH/PFSegNets

摘要

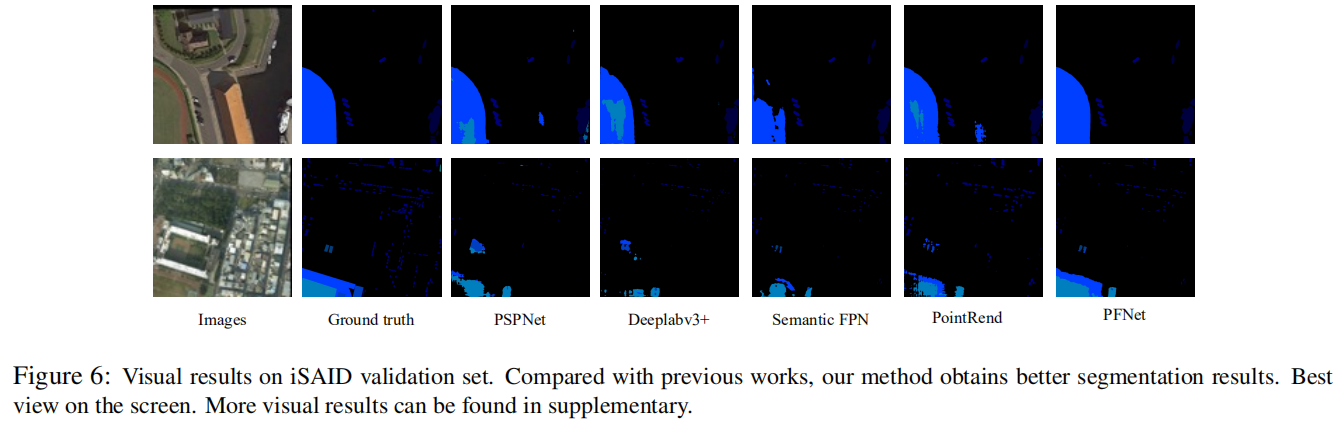

航空图像分割是一个特殊的语义分割问题,具有一般语义分割所没有的一些具有挑战性的特征。有两个关键问题:一个是极端的前景-背景不平衡分布,另一个是多个小物体和复杂的背景。由于过度引入背景上下文,这类问题使得最近的密集关联上下文建模与基线相比表现很差。为了解决这些问题,我们提出了一个基于特征金字塔网络(FPN)框架的点向亲和传播模块,称为点Flow。在相邻特征之间的选定点上生成稀疏亲和图,而不是稀疏亲和学习,在保持效率的同时降低了背景引入的噪声。特别地,我们设计了一个双点匹配器,分别从突出区域和对象边界中选择点。在三种不同的航空分割数据集上的实验结果表明,该方法比现有的通用语义分割方法更有效和高效。特别是,我们的方法在三个空中基准上达到了最佳的速度和精度的权衡。在三个通用语义分割数据集上的进一步实验证明了该方法的通用性。

论文贡献:

1)提出了点流模块(PFM),这是一种新颖的平衡亲和学习模块,并设计了一种双点匹配器,以互补的方式从突出区域和边界中选择匹配的稀疏点。2)我们将PFM附加到FPN架构中,并构建了一个名为PFNet的金字塔传播网络。3)大量的实验和分析表明了PFM的疗效。我们在三个空中基准测试上基准测试了15种最先进的一般分割方法。我们的PFNet在这些基准测试上取得了最先进的结果,同时也取得了最好的速度和准确性的权衡。我们进一步证明了该方法在三个一般语义分割数据集上的通用性。

Look Closer to Segment Better:Boundary Patch Refinement for Instance Segmentation

code: https://github.com/tinyalpha/BPR

摘要

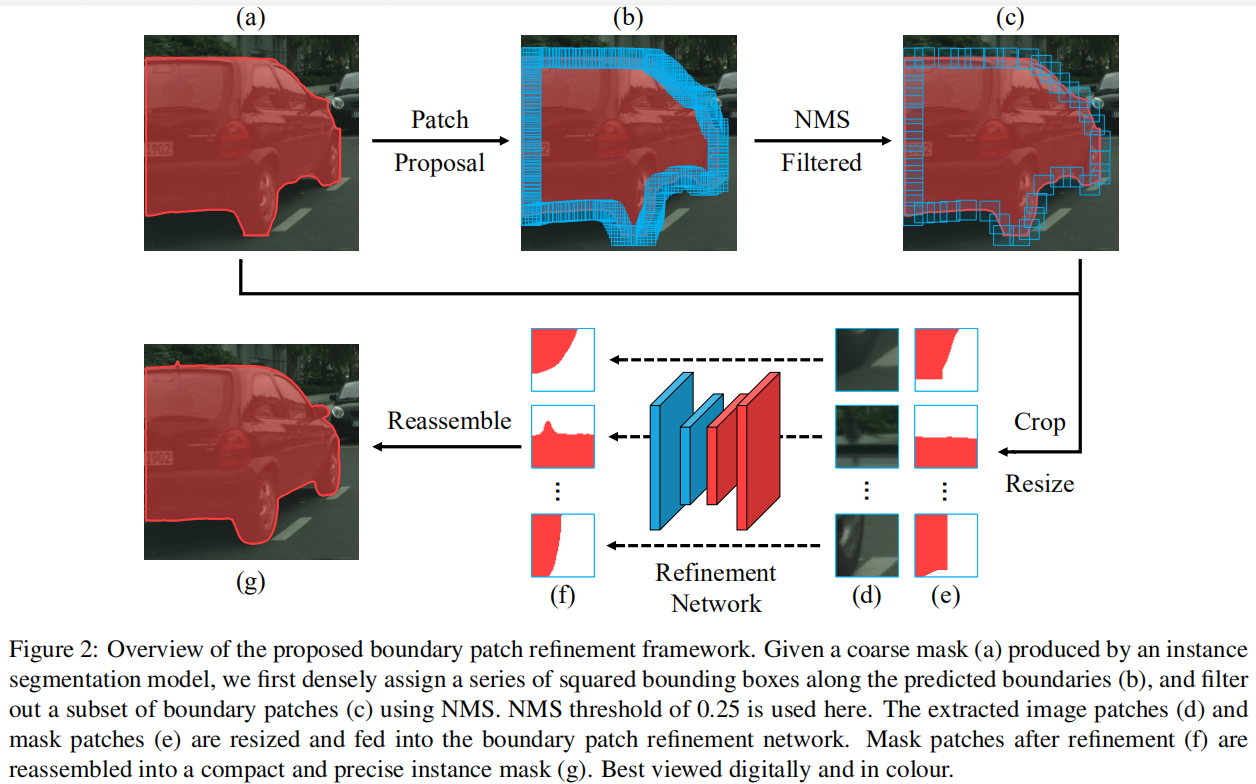

在实例分割方面已经做出了巨大的努力,但掩模的质量仍然不令人满意。由于特征映射的空间分辨率较低,以及边界像素比例极低而导致的不平衡问题,预测的实例掩模的边界通常不精确。为了解决这些问题,我们提出了一个概念上简单而有效的后处理细化框架,基于任何实例分割模型的结果来提高边界质量,称为BPR。根据更好地观察分段边界的思想,我们沿着预测的实例边界提取和细化了一系列小边界块。通过更高分辨率的边界补丁细化网络来完成细化。在城市景观基准测试上,所提出的BPR框架在基准上比MaskR-CNN基线产生了显著的改进,特别是在边界感知指标上。此外,通过将BPR框架应用于“多重变换+SegFix”基线,我们获得了城市景观排行榜的第一名。

论文的贡献

本文在人类分割行为的激励下,我们提出了一个概念上简单而有效的后处理框架,通过切割再细化策略来提高边界质量。具体来说,给定任何实例分割模型产生的粗糙实例掩码,我们首先沿着预测的实例边界提取一系列小的图像补丁。边界补丁与掩模补丁连接后,将其输入一个重新细化网络,该网络进行二值分割,对粗边界进行细化。然后,改进后的掩码补丁被重新组装成一个紧凑和高质量的实例掩码,如图1(右)所示。

由于我们只在对象边界周围进行裁剪,因此允许使用比以前的方法更高的分辨率来处理补丁,以便更好地保留低级别的细节。同时,小斑块中边界像素的比例自然增加,可以缓解优化偏差。

Lightweight boundary refinement module based on point supervision for semantic segmentation

摘要

一种有效的语义分割方法应该包含精细的对象边界和连续区域。 然而,目前基于掩码的分割方法在粗预测的情况下,不能很好地提取边界特征,导致边界模糊问题明显。 虽然许多分割方法都嵌入了边界检测分支来直接计算轮廓,但这种结构会导致计算复杂度的增加,并且会错过边缘的详细信息,如类间区分。 为了获得精细边界,我们提出了一种基于点监督的轻量级边界细化模块BRPS,以提高现有各种分割模型产生的分割结果的边界质量。 首先,学习方向场来完成初始特征校正,该方向场定义为从最近的物体边界指向每个像素,其中加权的欧几里得和余弦距离函数作为预测边界像素与Ground-truth标签之间的损失。 然后,基于新的点卷积运算,在不确定和特定的位置(包括随机分布和关键特征点)进行基于点的监督学习,输出最终清晰的对象边界。 最后,我们验证了我们的BRPS模块可以有效地降低在Pascal VOC2012、NYUD v2数据集、Cityscapes和BDD100K数据集上由DeepLabv3和HRNet等各种先进模型生成的分割结果的预测误差。

论文的贡献

-

我们提出的轻量级BRPS模块是一种通用的方案,它在不需要额外的先验信息的情况下,持续地提高跨越多个基线的各种分割模型的性能。

-

方向场作为一种新颖的特征形式,可以有效地完成前景边缘的全局校正,属于初始边界筛选过程。

-

采用不确定性估计、关键点检测和基于点监督学习的偏移松弛来学习全局和局部点特征,使该模块更加轻量级。

-

BRPS模块在Pascal VOC2012[17]、NYUDv2[18]、Cityscapes[2]和BDD100K[19]数据集上对语义分割任务的实验结果表明,在训练集和验证集上都有改进。

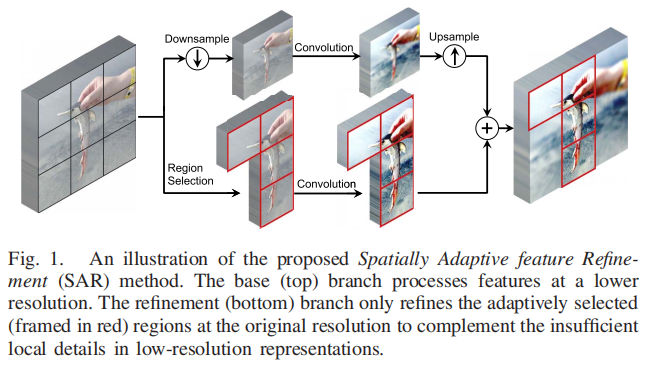

Spatially Adaptive Feature Refinement for Efficient Inference

空间冗余通常存在于卷积神经网络(CNNs)的学习表示中,导致对高分辨率特征进行不必要的计算。本文提出了一种新的空间自适应特征细化(Spatially Adaptive feature Refinement, SAR)方法来减少这种多余的计算。它通过自适应融合来自两个分支的信息来进行有效的推断:一个在较低的空间分辨率下对输入特征进行标准卷积,另一个在原始分辨率下选择性地细化一组区域。这两个分支在特征学习中相互补充,它们都比标准卷积引起的计算量少得多。SAR是一种灵活的方法,可以方便地插入现有的cnn,建立减少空间冗余的模型。对CIFAR和ImageNet分类、COCO目标检测和pascalVOC语义分割任务的实验表明,所提出的SAR能够持续提高网络性能和效率。值得注意的是,我们的结果表明,SAR只细化不到40%的区域的特征表示ResNet97%的样本验证AmageNet集实现精度与原始模型,揭示了高计算冗余的空间维度。

Pointnet: Learning Point Representation for High-Resolution Remote Sensing Imagery Land-Cover Classification

摘要: 随着遥感技术的发展,大量的高空间分辨率(HSR)图像可以获得,这使得精细的土地覆盖测绘成为可能。然而,HSR图像中的地面物体的细节是复杂的,特别是在边缘,因此给土地覆盖分类带来了新的挑战。现有的深度学习方法将其视为一种基于完全卷积网络(FCN)的语义分割任务,而不考虑复杂的细节识别。在本文中,我们通过提出一个用于HSR土地覆盖分类的点表示网络(PointNet)来解决这个问题,特别是设计不确定点选择是为了在ResNet编码器的末端寻找最不确定的细节。根据这些点,编码器中的粗特征和细特征被融合,然后是一个多层感知器(MLP)。与卷积采样不同,MLP侧重于不确定点的识别,这种识别改变了训练过程中的网络优化。在预测过程中,对粗特征进行点细化,依次上采样,提高了土地覆盖细节识别性能。在南京陆地覆盖数据集上的实验结果表明,该点网络优于最先进的方法。

2022

NPCNet: Jointly Segment Primary Nasopharyngeal Carcinoma Tumors and Metastatic Lymph Nodes in MR Images

摘要: 鼻咽癌(NPC)是一种恶性肿瘤,如果提供早期诊断和及时治疗,其生存率将大大提高。原发性鼻咽癌肿瘤和转移性淋巴结(MLNs)的准确分割对于患者的分期和放疗安排至关重要。然而,现有的研究主要集中在原发肿瘤的分割上,而忽略了mln的识别,因此未能为肿瘤的识别提供一个全面的景观。原发性鼻咽癌肿瘤和mln的分割主要面临三个挑战:位置可变、大小可变和边界不规则。为了解决这些挑战,我们提出了一个自动分割网络,命名为NPCNet,以实现原发性鼻咽癌肿瘤和mln的同时分割。具体来说,我们设计了三个模块,包括位置增强模块(PEM)、尺度增强模块(SEM)和边界增强模块(BEM),以解决上述挑战。首先,PEM增强了最可疑区域的特征表示。随后,SEM捕获多尺度上下文信息和目标上下文信息。最后,BEM对分割掩模中的不可靠预测进行了校正。为此,我们对从754名患者中收集的9124个样本的数据集进行了广泛的实验。实验结果表明,每个模块都实现了其设计的功能,并与其他模块互补。通过将三个提出的模块结合在一起,我们的模型与9个流行的模型相比,取得了最先进的性能。

论文的贡献:

- 我们的工作是首次尝试验证在如此大的数据集上同时分割原发性鼻咽癌肿瘤和mln的可行性,这为临床医生提供了足够的诊断参考,并具有可靠的性能。

- 设计了三个信息增强模块来解决这三个主要挑战。这些模块可以相互补充,每个模块都有其独特的优势。

- 通过结合9种常用模型的优点,该模型与提出的模型实现了最先进的性能。

最后

以上就是明亮早晨最近收集整理的关于PointRend相关论文集202020212022的全部内容,更多相关PointRend相关论文集202020212022内容请搜索靠谱客的其他文章。

发表评论 取消回复