Multilingual Molecular Representation Learning via Contrastive Pre-training

目录

1.Molecular property prediction

2.Zero-shot Data-lingual retrieval

总结

分子表征学习在生物信息学中起着至关重要的作用。由于给定的分子可以使用不同的语言来描述,如SMILES、IUPAC和InChI,作者提出了一种多语言分子嵌入生成方法,称为MM-Deacon。MM-Deacon在大规模分子上使用SMILES和IUPAC作为两种不同的语言进行预训练。作者在MoleculeNet的7个分子性质预测任务、zero-shot跨语言检索和一个药物-药物相互作用预测任务评估了模型的鲁棒性。

一、Introduction

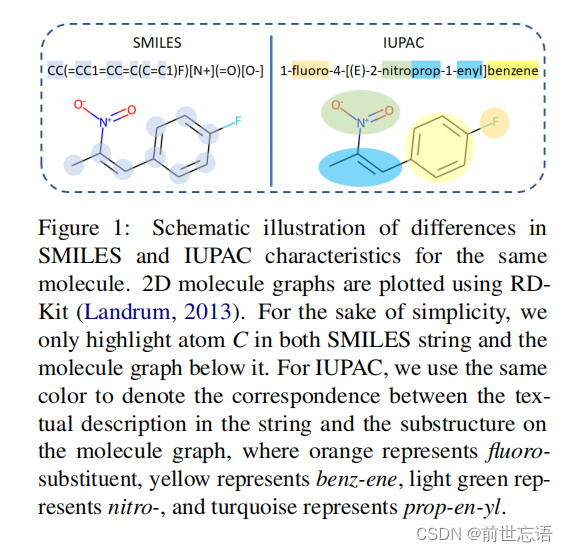

SMILES字符串是通过遍历分子图来创建的,其中SMILES字符串中的每个字母(如图1中的C, F, N, O)对应图上的一个原子,其他字符表示位置和连通性。然而,IUPAC名称类似于一种自然语言,IUPAC名称中的语素(如本例中的fluoro、prop、en、yl)通常代表分子图上特定类型的子结构,这些子结构也负责分子的特征化学反应。

基于对比学习、MLM,作者提出了基于SMILES和IUPAC联合训练的分子表示学习算法MM-Deacon。在MM-Deacon中,使用Transformer作为基线编码器对SMILES和IUPAC进行编码,并将编码器的embedding投影到联合embedding空间。然后,使用对比学习将正例(同一分子的SMILES和IUPAC)的嵌入距离拉近,负例(不同分子的SMILES和IUPAC)的嵌入距离拉远。

从公开的PubChem数据集中随机选择1000万个分子,对MM-Deacon进行预训练,然后将预训练的模型用于下游任务。作者主要贡献总结如下:

- 作者提出了MM-Deacon,一种利用多种分子语言通过对比学习生成分子嵌入的新方法。

- 作者是第一个利用SMILES和IUPAC之间共享的相互信息进行分子编码。

- 作者对各种任务进行了广泛的实验,包括分子性质预测、跨语言分子检索和药物-药物相互作用(DDI)预测,并证明作者的方法优于基线方法和现有的最先进的方法。

二、Molecule pre-training

现有的预训练方法根据使用的模型可分为三类:GNNs预训练、语言模型预训练和混合模型预训练。与其他分子预训练方法不同,MM-Deacon是使用成对SMILES和IUPAC语言模型进行多语言预训练的。与使用带有GNN的分子图相比,语言模型编码的IUPAC名称通过表示官能团的基本词带来了丰富的先验知识,而不需要复杂的图超参数设计。

- Pre-training with GNNs:Hu等人使用带有属性mask和结构预测目标的节点级和图级表示在200万个分子上预训练GNN。MolCLR使用子图级分子数据增强方案创建正负对,并通过对比学习区分正负。GraphMVP在2D和3D分子图(在2D图中添加原子空间位置形成的3D图)的一致性以及与GNN的对比目标上进行了预训练。

- Pre-training with language models:Xu等人使用具有seq2seq损失的编码器-解码器GRUs重构了SMILES,其中潜在空间中的嵌入用于下游分子性质的预测。Chemberta将SMILES输入到Transformer中,然后根据MLM损失进行优化。FragNet使用编码器-解码器Transformer重建SMILES,并通过增强SMILES和对比学习对潜在空间进行额外监督。X-Mol是通过将同一分子的一对SMILES变体作为输入,并在11亿个分子上使用Transformer生成两个输入SMILES中的一个作为输出来进行预训练的。

- Pre-training with hybrid models:不同的分子数据格式可以协同使用。例如,DMP建立在smile和2D分子图的一致性之上,SMILES由Transformer编码,2D分子图由GNN编码。

三、Method

1.Tokenizer

使用BPE将SMILES变成token,Chithrananda等人(2020)表明,在下游任务中,BPE比基于正则表达式的SMILES token表现更好。对于IUPAC名称标记化,使用了基于规则的正则表达式,它根据后缀、前缀、普通名称等拆分IUPAC字符串。

2.Model architecture

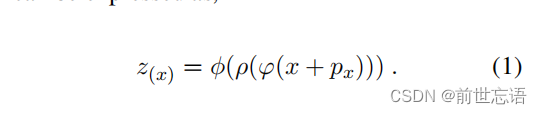

如图2所示,MM-Deacon以SMILES和IUPAC字符串作为输入。输入文本字符串s被token化并嵌入到每个分支中的矩阵x中,标记列表的顺序由位置嵌入 保留。然后x和

被一个编码器块φ摄取,该编码器块由6层Transformer编码器组成。使用全局平均池化层ρ对所有位置的特征进行集成,使用投影层φ将集成的特征向量投影到联合嵌入空间。因此最终嵌入z (x)可表示为

最大输入token序列长度设置为512。对于6个Transformer编码器层中的每一层,我们选择自注意头的数量为12,隐藏大小为768。投影层φ将长度从768投影到512的向量,使得表示更加紧凑。

Contrastive loss

以来自N个分子的N个SMILES-IUPAC对作为输入,在N个SMILES串和N个IUPAC串的相关矩阵中可生成N个正对和 个负对。更具体地说,第i个SMILES的唯一正对是第i个IUPAC,而其余的N−1个IUPAC字符串与第i个SMILES形成负对。使用AdamW优化器在80 V100 GPU上预训练MM-Deacon 10个epoch(共15小时),每个GPU上有16个batch,学习率为10−6。温度τ设置为0.07。

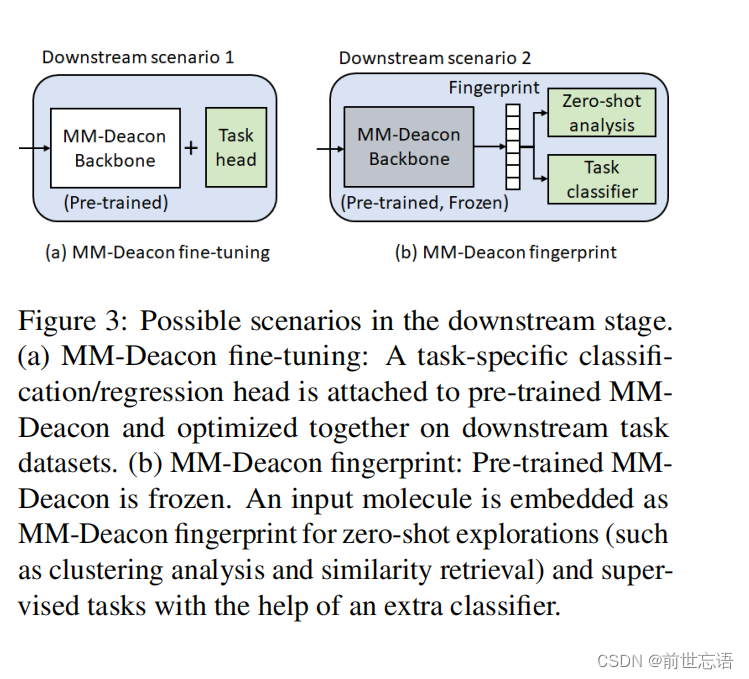

3.Downstream stage

在预训练获得的知识可以以不同的方式转移到下游任务。图3列出了在下游阶段使用预训练MM-Deacon的两种情况。

- MM-Deacon fine-tuning:一个任务特定的分类/回归层可以附加到预先训练的MM-Deacon上,系统作为一个整体可以在下游任务数据集上进行调优。

- MM-Deacon fingerprint:训练好的MM-Deacon被冻结。输入分子被嵌入为MM-Deacon指纹,用于 zero-shot 探索(如聚类分析和相似性检索)和在额外分类器的帮助下监督任务。

四、Experiments

1.Molecular property prediction

Data

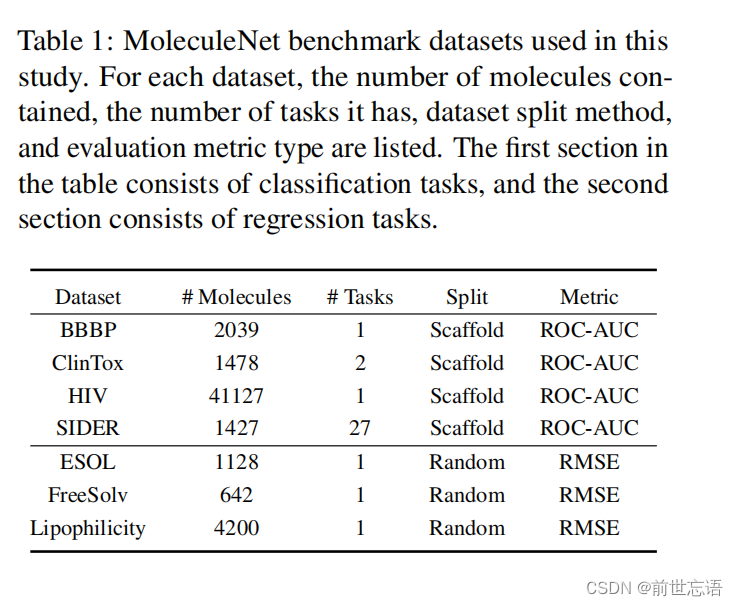

BBBP、ClinTox、HIV和SIDER数据集是分类任务,其中每个任务中都提供了分子SMILES及其二进制标签。使用ROC曲线面积AUC评估。对于具有SIDER等多个任务的数据集,报告同一数据集下所有任务的平均ROCAUC。每个分类任务的train/val/test的分数为0.8/0.1/0.1,使用Scaffold拆分。请注意,使用分子支架进行数据拆分会产生结构上更明显的train/val/test,这比随机拆分更具挑战性。ESOL、FreeSolv和Lipophilicity数据集的实验结果都是用于预测给定分子SMILES标签的回归任务。采用RMSE作为评价指标,其值越低表示性能越好。根据MoleculeNet的推荐,作者采用随机拆分,将每个数据集分为0.8/0.1/0.1,用于train/val/test。验证集上的结果用于选择最佳模型。为了保持与MoleculeNet的一致性,作者运行每个任务三次,每次使用不同的数据分割种子,以获得指标的平均值和标准偏差(std)。表1显示了每个数据集的详细信息,例如任务的数量和它所包含的分子。

Model

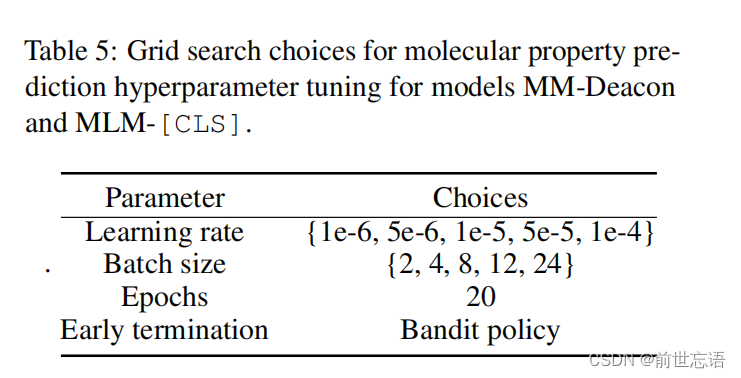

作者采用了如图3a所示的模型。在预训练的MM-Deacon SMILES分支中添加一个线性层作为任务特定的头部进行微调(IUPAC分支被删除)。分类任务采用交叉熵损失,回归任务采用均方误差损失。使用网格搜索进行超参数调优,可能的选择如表5所示。每个任务分别进行优化。

Results

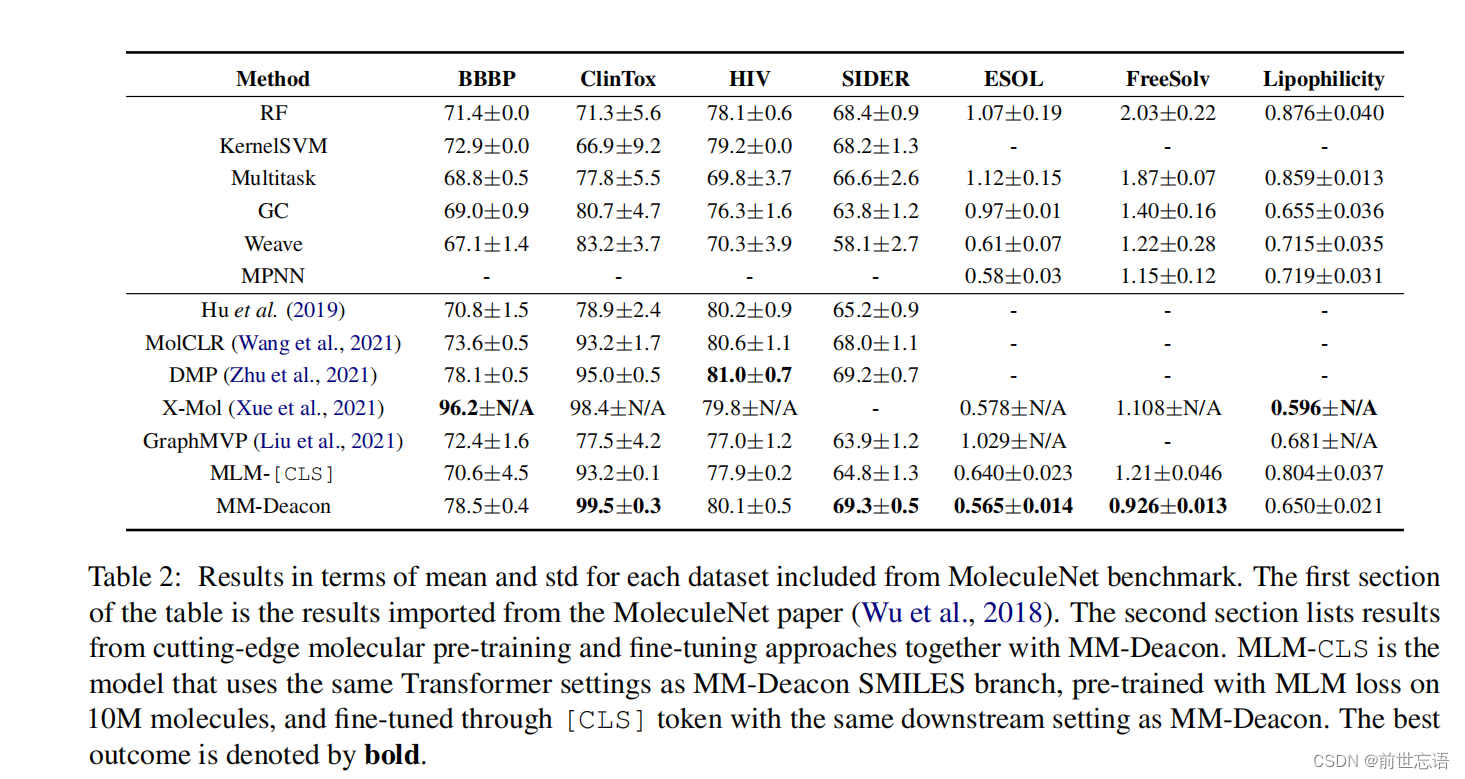

表2显示了每个数据集的平均值和标准差结果。表2的上半部分显示了从MoleculeNet导入的结果,而第二部分显示了MM-Deacon和其他最先进的分子预训练和微调方法的结果。MLM-[CLS]表示实现了Chemberta变体,该变体使用与MM-Deacon SMILES分支相同的Transformer设置,在10M分子上使用MLM损失进行预训练,并通过与MM-Deacon相同的下游设置通过[CLS]token进行微调。与其他基于训练前的方法相比,MM-Deacon在7个数据集中的4个中优于现有的最先进的方法,在其余3个数据集中具有可比性,在ClinTox和FreeSolv上有重大改进。

MM-Deacon和MLM-CLS都使用了6层Transformer块来处理SMILES。在每项任务中,MM Deacon都经过了SMILES和IUPAC的预训练,其性能超过了MLM-CLS(只进行了SMILES的预训练)。MM-Deacon和DMP在这四个分类任务上的表现相似,而DMP使用12层Transformer块进行SMILES和12层GNN编码分子2D图,这几乎是MM-Deacon模型大小的两倍。此外,作者发现BBBP测试集比验证集更具挑战性,这与MoleculeNet论文中公布的结果一致。在BBBP数据集上获得的高精度X-Mol可能是由于他们在预训练中使用了11亿个分子,或者他们使用了不同的数据集分割方法。

2.Zero-shot Data-lingual retrieval

Data

排除了用于MM-Deacon预训练的1000万个分子后,从PubChem数据集中随机选择了100K个分子。为每个分子提供SMILES和IUPAC字符串。使用标准召回率(R@1和R@5)。

Model

使用预训练好的MM-Deacon生成MM-Deacon指纹,如图3b所示。因此,每个SMILES和IUPAC字符串分别编码为MM-Deacon SMILES指纹和IUPAS指纹。查询和搜索的候选分子之间的余弦相似性用于确定排名。

Results

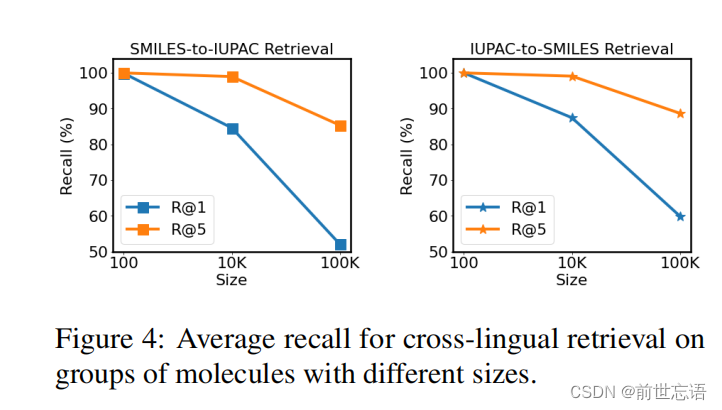

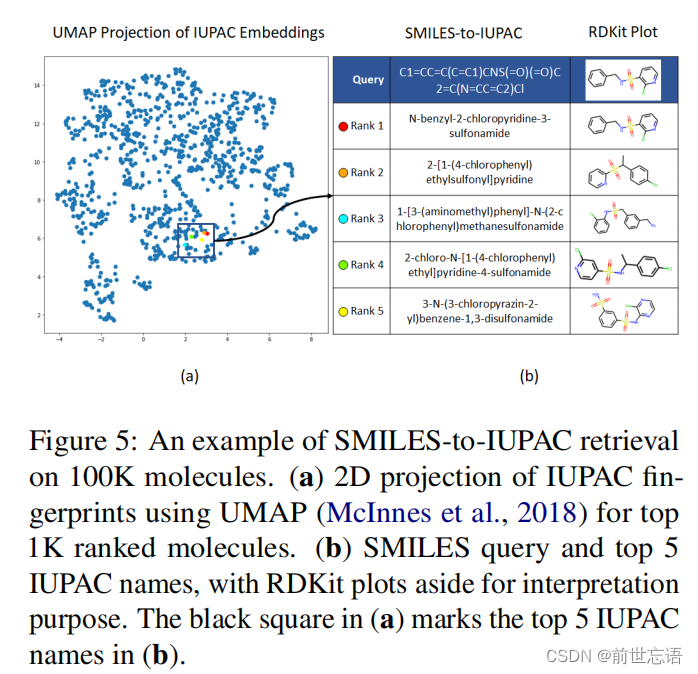

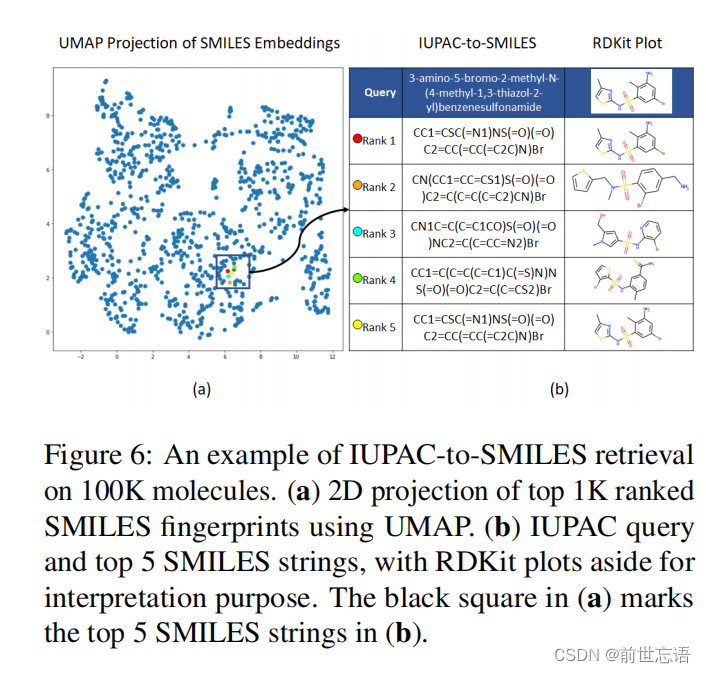

图4显示了SMILES-to-IUPAC和IUPAC-to-SMILES检索在召回率方面的结果。作者不仅直接对整个100K分子进行检索,还显示了对较小分子组(100,10K)的检索结果,以更全面地了解检索性能。MM-Deacon获得R@5两种类型的跨语言检索均超过85%,即使在对100K分子执行检索时也是如此。此外,图5和6分别显示了SMILES-to-IUPAC检索示例和IUPAC-to-SMILES检索示例。

3.DDI prediction

Data

DDI数据集包括548种药物,其中48584种已知相互作用,101294种非相互作用(可能包含创建数据集时未发现的相互作用)。从PubChem获得了每种药物的SMILES和IUPAC名称。采用分层5倍交叉验证和药物组合拆分。评估指标包括AUC、AUPR、Precision和Recall。

Model

配对药物的MM-Deacon指纹联合输入到MLP中进行二元分类。MM-Deacon使用了三种不同类型的指纹:SMILES、IUPAC以及串联的SMILES和IUPAC指纹。MLP有一个隐藏层,有200个神经元。ReLU激活,学习率为10−3。

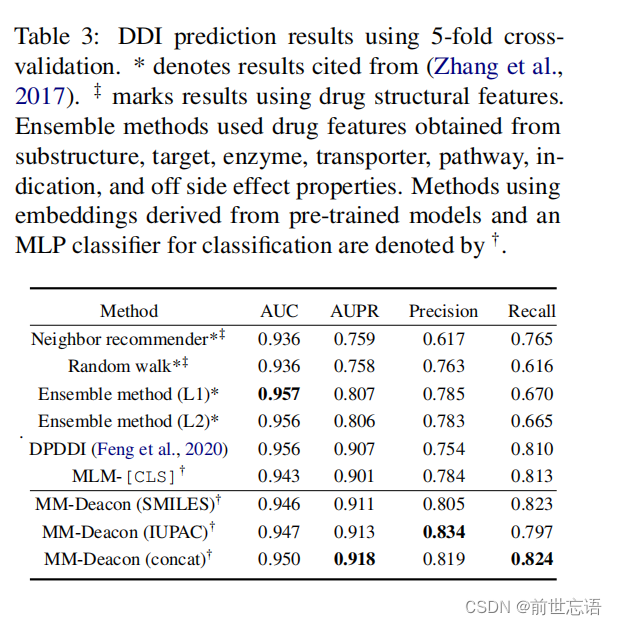

Results

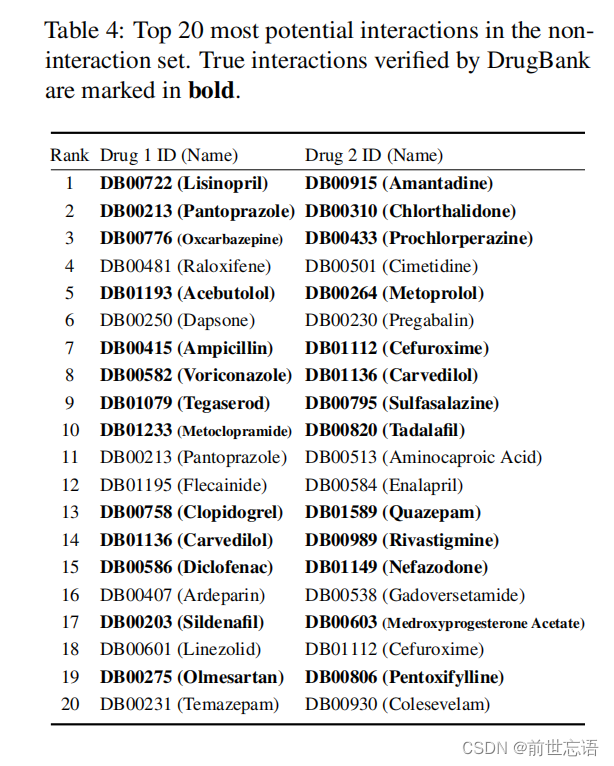

如表3所示,MM-Deacon在AUPR、Precision和Recall方面优于其他方法,当将SMILES和IUPAC指纹连接输入特征集时,可以获得最大AUPR。集成模型除了药物结构特性外,还包括额外的生物活性相关特征。表4显示了MM-Deacon(concat)预测的非交互集合(false positives)中的前20个最具潜力的交互作用,其中13个被DrugBank确认为true positives。而对于集成模型,这个值是7/20。

五、Discussions

MoleculeNet中七项分子性质预测任务的表现表明,当采用图3a所示的网络微调时,预训练MM-Deacon的有效性。zero-shot跨语言检索的评估结果进一步表明,MM-Deacon SMILES和IUPAC指纹共享了大量的相互信息,这意味着IUPAC名称可以直接使用,而无需像化学家过去那样首先翻译成SMILES格式。DDI预测任务表明,MM-Deacon还允许直接使用联合共享空间中的嵌入作为下游预测任务的分子指纹,这是化学信息学中广泛使用的策略。

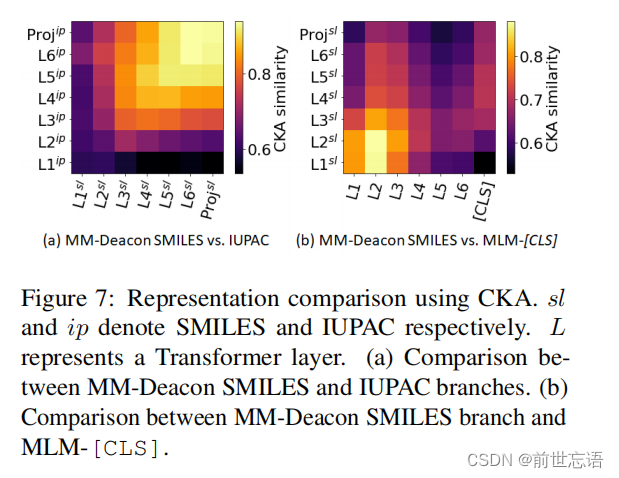

1.Molecule-level alignment

作者使用CKA和RBF核来比较不同层之间的表示。在图7a中,对MM-Deacon SMILES和IUPAC分支之间的6个Transformer层和最终投影层的表示进行了比较,其中浅层的表示有所不同,而深层的表示达到了较高的对齐水平。在图7b中,MM-Deacon SMILES分支和MLM-[CLS]模型都将SMILES作为输入,因此浅层具有较高的对齐分数,而表示随着网络的加深而变化。图7显示,MM-Deacon有效地对齐了SMILES和IUPAC表示,使用SMILES与IUPAC训练的分子表示不同于仅使用SMILE训练的表示。

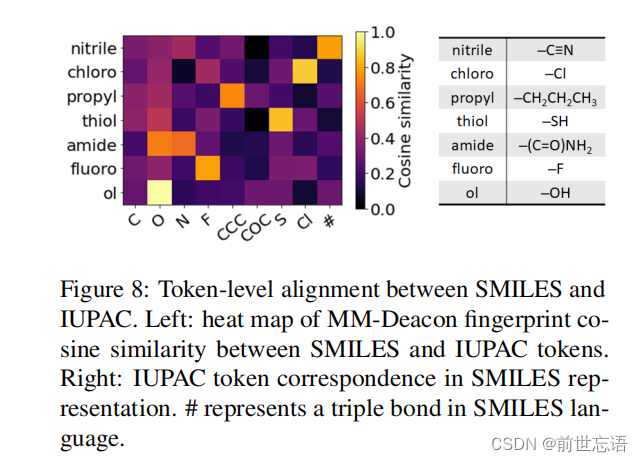

2.Token-level alignment

IUPAC语料库中的token和SMILES语料库的token之间的MM-Deacon指纹的余弦相似矩阵如图8所示。图8中的表格列出了用SMILES语言表示的IUPAC标记,热图表明SMILES和IUPAC之间存在良好的标记级对齐。

六、Conclusion

在本研究中,作者提出了一种新的多语言分子表示学习方法,该方法将来自SMILES-IUPAC联合训练的互信息与自监督的对比损失相结合。作者在分子性质预测、zero-shot跨语言检索和DDI预测等下游任务重评估了模型效果。结果表明,自监督的多语言对比学习框架为化学领域探索和药物发现提供了巨大的可能性。在未来的工作中,作者计划将MM-Deacon预训练扩展到更大的数据集大小,并研究MM-Deacon对其他类型分子语言的适用性。

参考(具体细节见原文)

原文链接:https://doi.org/10.48550/arXiv.2109.08830 https://doi.org/10.48550/arXiv.2109.08830

https://doi.org/10.48550/arXiv.2109.08830

最后

以上就是自信机器猫最近收集整理的关于MM-Deacon:基于对比预训练的多语言分子表征学习Multilingual Molecular Representation Learning via Contrastive Pre-training总结一、Introduction二、Molecule pre-training三、Method四、Experiments五、Discussions六、Conclusion参考(具体细节见原文)的全部内容,更多相关MM-Deacon:基于对比预训练的多语言分子表征学习Multilingual内容请搜索靠谱客的其他文章。

发表评论 取消回复