1.论文链接

NEURAL MACHINE TRANSLATION

BY JOINTLY LEARNING TO ALIGN AND TRANSLATE

2.本文主要为了解决什么问题?

在之前的seq2seq论文中,我们在encode的过程中要把输入数据的所有信息都映射到一个向量中,但是显然随着向量长度的提升,这么做会越来越困难。本文主要是为了解决这个问题

3.解决过程

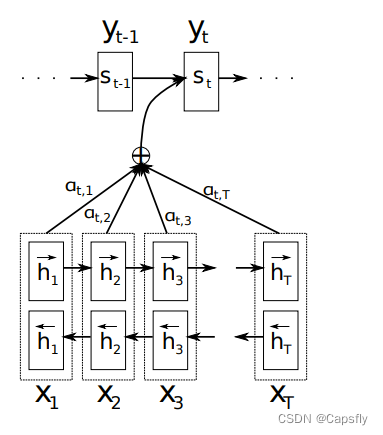

首先是收到了LSTM和seq2seq的启发(其中在seq2seq的论文中明确指出如果是反过来输入的话,效果会提升,算是一个trick),在encode的时候分别正向使用RNN encode一次,再反过来 RNN encode一次。然后在计算下一个单词的概率的时候,

P

(

y

i

∣

y

1

,

.

.

.

y

i

−

1

,

x

)

=

g

(

y

i

−

1

,

s

i

,

c

i

)

P(y_i|y_1,...y_{i-1},x)=g(y_{i-1},s_i,c_i)

P(yi∣y1,...yi−1,x)=g(yi−1,si,ci)

值得一提的是对于

c

i

c_i

ci的计算,作者提出了attention机制,就是

c

i

=

∑

j

=

0

T

x

α

i

j

h

j

c_i=sum_{j=0}^{T_x}alpha_{ij}h_j

ci=j=0∑Txαijhj

我们可以将

α

i

j

alpha_{ij}

αij理解为权重

4.本文的创新点

1.引入了attention机制

2. 分别用了正向RNN和反向RNN

最后

以上就是英勇音响最近收集整理的关于【论文阅读】NEURAL MACHINE TRANSLATION BY JOINTLY LEARNING TO ALIGN AND TRANSLATE1.论文链接2.本文主要为了解决什么问题?3.解决过程的全部内容,更多相关【论文阅读】NEURAL内容请搜索靠谱客的其他文章。

![[Data structure学习笔记][week1]Stacks and QueuesStacksQueues](https://www.shuijiaxian.com/files_image/reation/bcimg11.png)

发表评论 取消回复