在上一篇博客中,我简单复习了矩估计,这篇博客将对点估计中的另外两个常见估计方法进行总结,分别是极大似然估计与最小二乘法,首先会对各自知识点进行归纳,最后论证这两种参数估计方法在特定条件下的转换关系。

极大似然估计

基本概念

在总体分布类型已知的前提下所使用的一种参数估计方法,这不同于矩估计,矩估计是在总体分布类型未知的情况下进行的。

理论依据

概率大的事件在一次观测中更容易出现

通俗的解释

似然估计法是在已知结果的情况下去求未知参数θ的,对于已经发生的结果(一般指的是我们所抽取出来的样本),既然他能够发生,说明在未知参数θ的条件下,这个结果发生的可能性很大,极大似然估计就是求出使得当前结果发生的可能性最大的那个θ值。

极大似然估计法的求解步骤

- 构建似然函数L(θ)

- 对似然函数取对数:l(θ)=log L(θ)

- 对l(θ)中的参数θ求导数(如果有多个参数,则进行求偏导),并令求出的导数方程等于0,求解出对应的参数值即可。

似然函数的构建

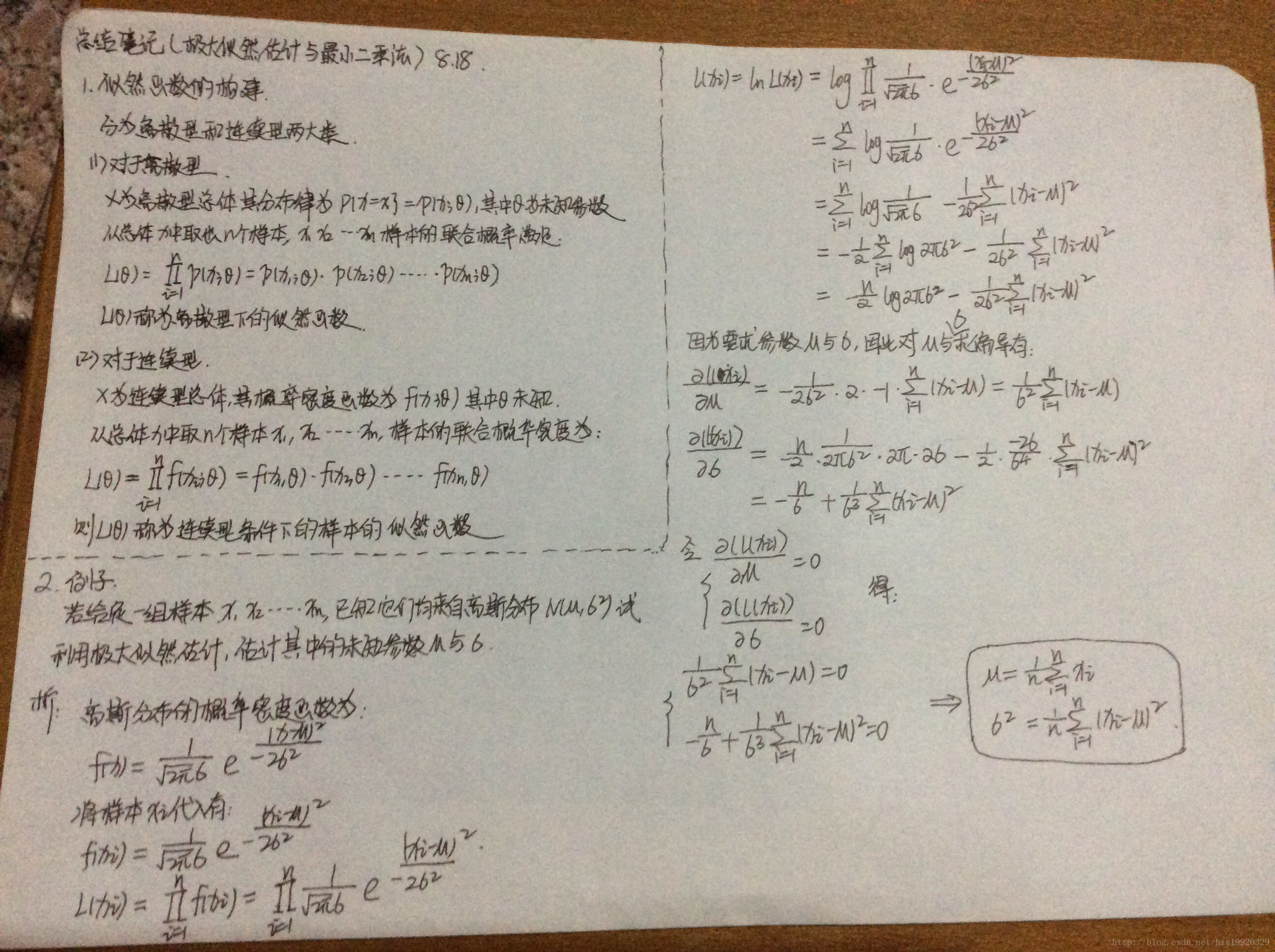

似然函数的构建分为离散型和连续型两大类,具体可见附加笔记第(1)点。

一点疑问

在求解似然函数的最值时,我们仅仅通过将对对数似然函数求导之后的结果等于零,求出对应条件下的θ值就认为已经求出了最大值,按道理讲,导数等于零的点应该是极值点呀,不一定是最值点咯?

解释:主要是因为,我们常见的概率分布函数一般都是属于指数分布族的,如正态分布、泊松分布、伯努利分布等,因而在多数情况下我们会认为导数为0的点其实也就是最值点了,但肯定也有不满足指数分布族的分布存在,只是不常见而已。

似然性与概率的区别

似然性与概率在意思上确实存在着相近关系,均指的是某个事件发生的概率,但两者又有区别:

概率:用于在已知参数的情况下来预测接下来出现的观测值出现的可能性。

似然性:在已知某些观测值的基础上,对原先分布中的未知参数进行估计。

一个简单的例子

具体可见附加笔记第(2)点。

最小二乘法(Least Square)

核心思想

通过最小化误差平方和的方式来使得拟合对象无限接近目标对象

深入理解最小二乘法

深入理解最小二乘法只需要了解清楚两个问题即可:

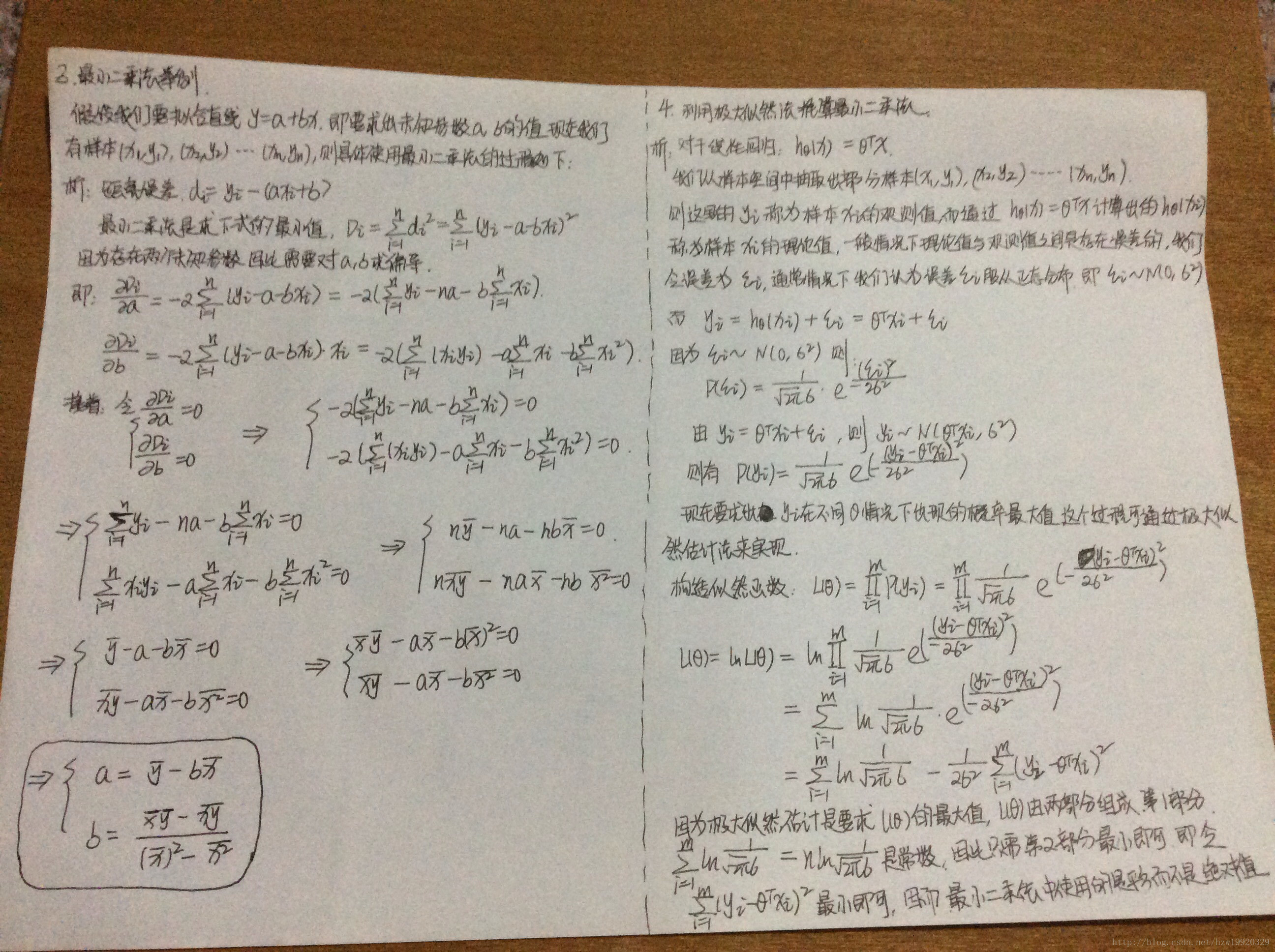

(1):误差方程的求解

(2):最小化误差方程误差方程的构建:用目标函数的值减去拟合函数的值,再取平方即可。

最小化误差方程:其实就是分别对误差方程中的未知参数求偏导,并令求导之后的式子等于0来计算对应的参数。

最小二乘法、极大似然估计以及梯度下降法的区别

首先应该了解清楚机器学习的三要素:模型、目标和算法。模型的话目前我已经深入了解的有线性回归以及逻辑回归;目标通常指的就是损失函数,损失函数的构建是需要用到最小二乘法和极大似然估计的,具体到模型上的话,线性回归使用的最小二乘法来构建损失函数的,逻辑回归使用的是极大似然估计来构建损失函数;最后就是算法部分,算法部分可以简单理解为优化部分,梯度下降就是这部分的算法,通过不更新参数值来使得损失函数最小,因此梯度下降法和前两种方法根本就不处于同一个机器学习的过程中。

一个简单例子

具体可见附加笔记第(3)点。

利用极大似然估计法推算最小二乘法

最小二乘法其实是可以通过Gaussian分布以及极大似然估计推算出来的,具体可见附加笔记第(4)点。

附加笔记

参考文献

- http://blog.csdn.net/liuyuemaicha/article/details/52497512

- http://bbs.pinggu.org/thread-3041002-1-1.html

- https://www.zhihu.com/question/37031188

- http://www.cnblogs.com/diegodu/p/5725139.html

- https://www.zhihu.com/question/20447622

- https://www.zhihu.com/question/24900876

- http://blog.csdn.net/zlbflying/article/details/47782657

最后

以上就是淡然牛排最近收集整理的关于机器学习总结(四):极大似然估计与最小二乘法的全部内容,更多相关机器学习总结(四)内容请搜索靠谱客的其他文章。

发表评论 取消回复