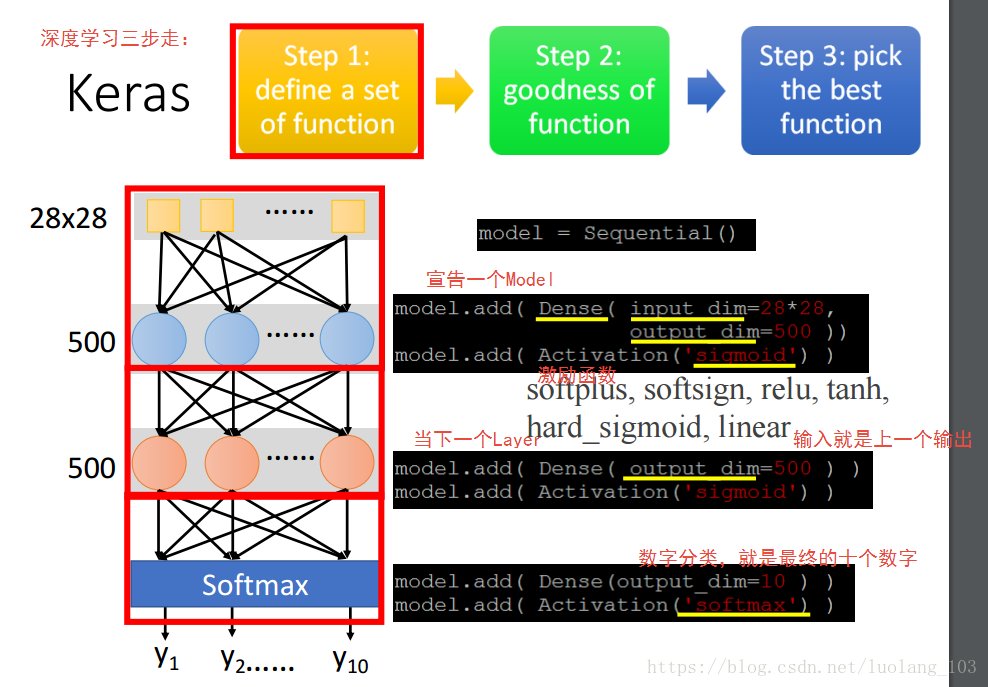

Keras:

有关的介绍:总的来说就是一个深度学习框架

keras - CSDN博客

https://blog.csdn.net/xiaomuworld/article/details/52076202

软件工程中的框架:一种可复用的设计构件(从宏观上大体结构的一种规定约束)

软件工程中的框架 扫个盲 嘿嘿 - CSDN博客

https://blog.csdn.net/molitiantang/article/details/7868102

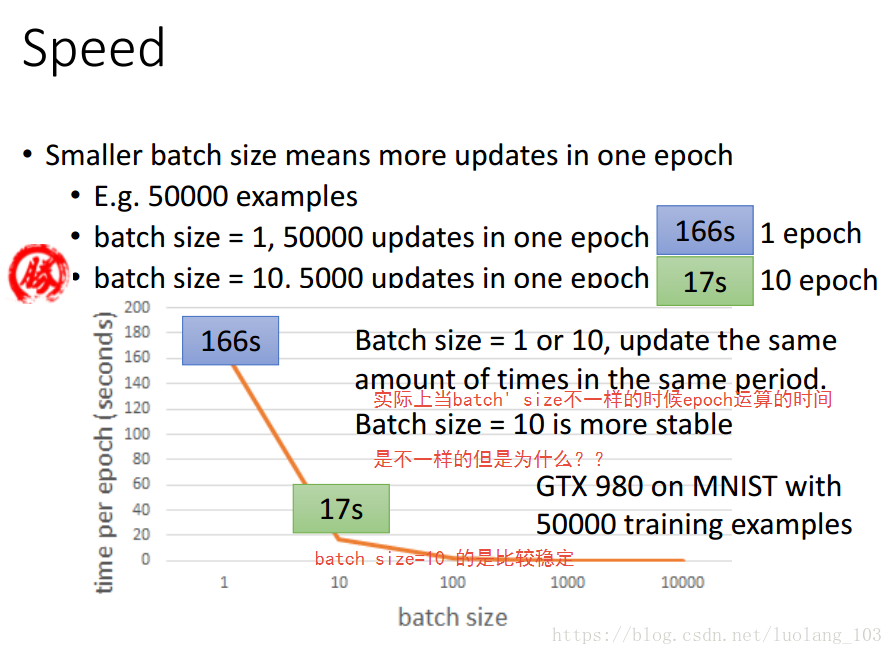

每一个epoch中会Update很多的参数,因为每一个batch被选择之后就会进行计算Loss Function然后进行参数的更新

SGD的速度比较会,上面的例子就是一个SGD,虽然SGD的方向是不稳定的。

使用Mini-batch的主要原因就是实用性

问题:

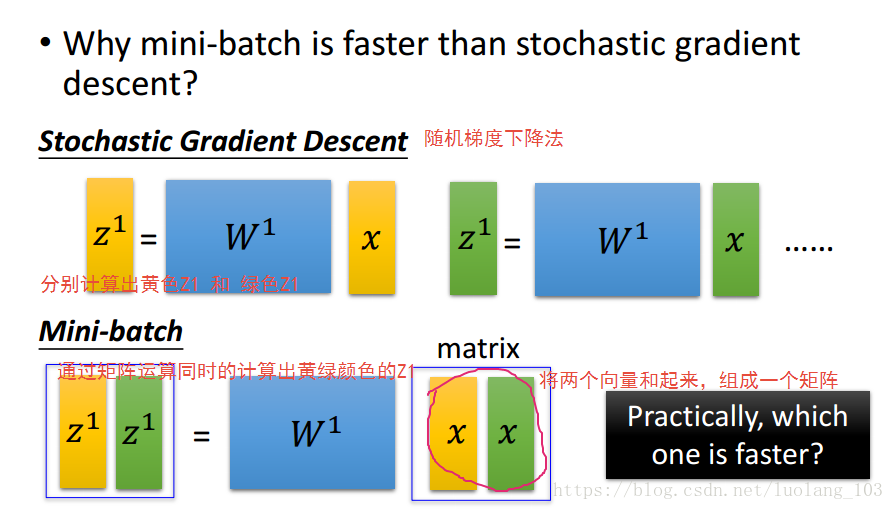

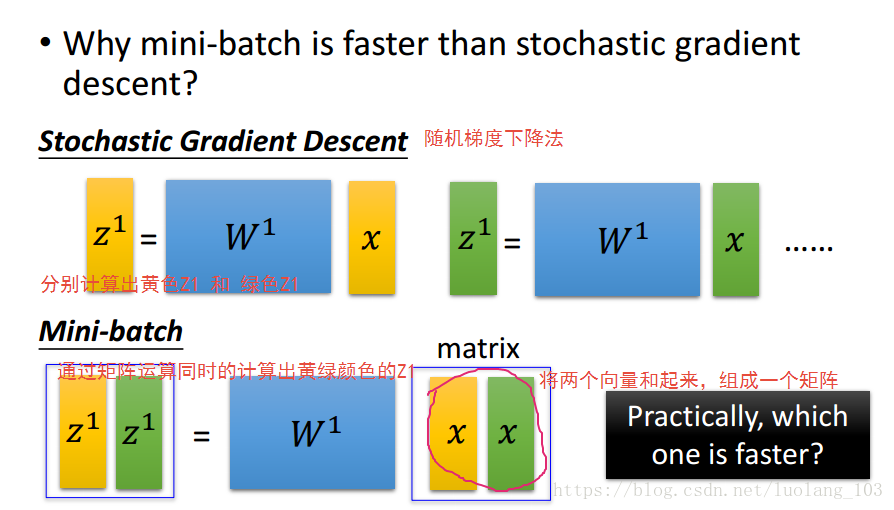

为什么使用batch size比较大的时候速度回比较快??

答:使用了平行运算,就是同时运算的。

为甚不让batch size 开到很大?、

答:cpu存储,当设置很大的时候实际是表现并不好

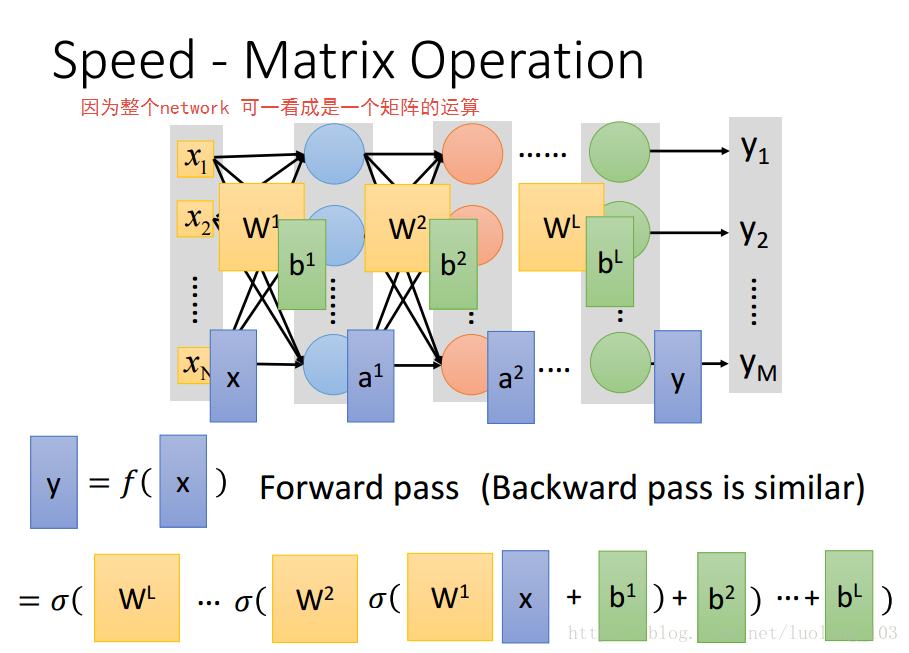

解释问题:当有batch的时候GPU是如何平行的加速??

理论上这两中方法运算时间是一样的,但是事实上的运算时间会是第一种的越是第二种的两倍

故而有了GPU,一定要知道使用mini-batch,不然也没有加速

最后

以上就是缓慢小笼包最近收集整理的关于2018-3-21李宏毅机器学习视频笔记(十三)--“Hello Wrold” of Deep learning的全部内容,更多相关2018-3-21李宏毅机器学习视频笔记(十三)--“Hello内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复