我是靠谱客的博主 温婉星星,这篇文章主要介绍线性回归 linear regression我们如果面对的是分类问题,单用linear regression其实效果没有linear classification好。由于linear regression 很快,所以我们一般先用linear regression, 求出一个大概的值,作为 PLA或者 packet 的初始值。,现在分享给大家,希望可以做个参考。

这节课好像吸收的东西有点少

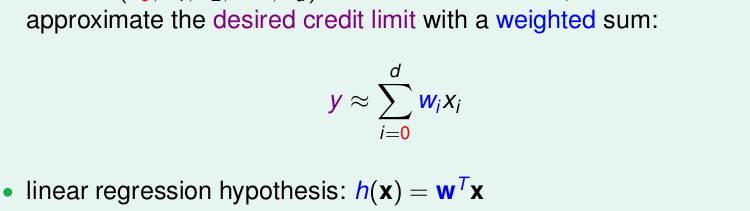

总体来说,线性回归就是形如

其实就是对我们的特征x进行加权w再求和罢了。

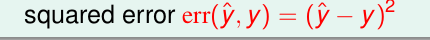

他的误差计算公式为

那么就是想最小化

err(y⏞,y)

.

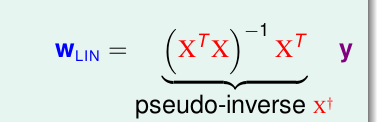

我们用矩阵的计算方法,其实可以直接求得

觉得这个推导,吴恩达老师的cs229讲的比林轩田老师讲的好,吴恩达来说用的是 矩阵迹的方法trace()。

linear regression 能否用在 linear classification 上

答案是可以的。

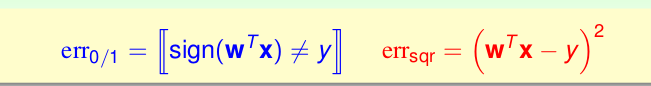

我们比较他们的误差函数

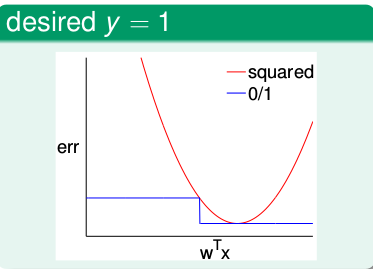

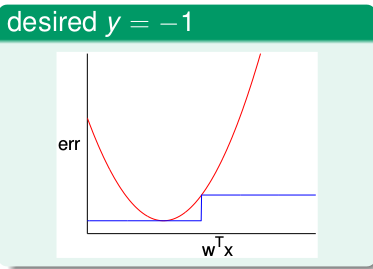

以

wTX

作为横坐标,误差err作为纵坐标.

当y=1时

当y=-1时

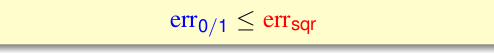

发现,不管怎样,始终有

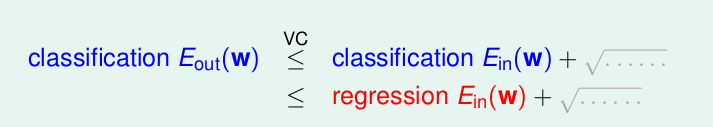

所以

regression的

Ein(w)

可以作为classification

Eout(w)

的上限

所以,只要我们让regression的

Ein(w)

尽可能的小,那么就可以让classification

Eout(w)

尽可能的小。

我们如果面对的是分类问题,单用linear regression其实效果没有linear classification好。由于linear regression 很快,所以我们一般先用linear regression, 求出一个大概的值,作为 PLA或者 packet 的初始值。

最后

以上就是温婉星星最近收集整理的关于线性回归 linear regression我们如果面对的是分类问题,单用linear regression其实效果没有linear classification好。由于linear regression 很快,所以我们一般先用linear regression, 求出一个大概的值,作为 PLA或者 packet 的初始值。的全部内容,更多相关线性回归内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复