困于心衡于虑而后作

今天的学习目标是,scrapy的基本使用

经过之前的学习,对爬虫有了基本的认识

写小型爬虫的常用的基本库有

- urllib

- requests

常用爬取网站的爬虫框架

- scrapy

当然还有信息提取

- re

- beautiful soup

- css selector

- lxml

- xpath selector

最后的就是数据库了,数据库暂时没有接触到,

暂时爬取的文件都是直接写入txt文件的中

一、首先还是安装

打开命令行输入

pip install scrapy

二、原理部分

完成之后,讲解原理

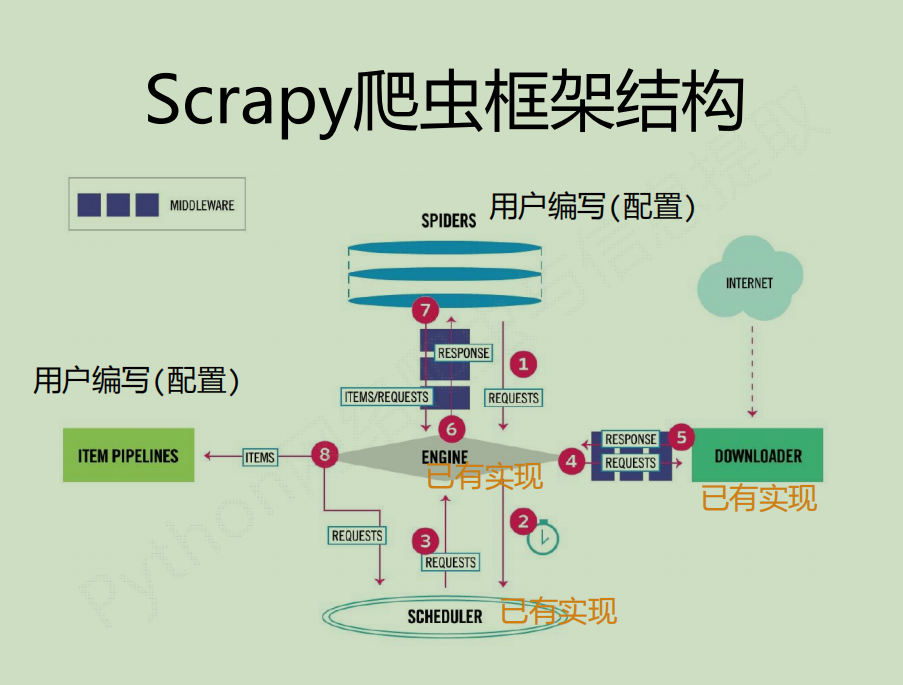

scrapy使用5+2结构,即spiders,engine,downloader,scheduler和item pipelines,还有两个中间键middleware

爬取的过程分3步走

1.首先是入口模块spiders发送request爬取请求——>engine处理——>发给scheduler调度

2.数据经过scheduler调度,调度发送request请求——>engine处理——>发送给downloader爬取网页——>返回给engine处理——>下载完毕后将数据返回给spiders

3.spiders得到数据之后——>请求engine处理——>发给出口模块item pipelines,或者开启下一轮的爬取,发送消息给scheduler调度模块

用户实现scrapy爬虫,一般只需要编辑spiders,item pipelines还有两个中间键,一共四个部分的代码

1.engine和downloader中间键

用户可以

最后

以上就是忧虑天空最近收集整理的关于python基础爬虫——Scrapy快速入门的全部内容,更多相关python基础爬虫——Scrapy快速入门内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复