在上一章的基础上,我们继续讨论这个问题。

1.导包

import warnings

warnings.filterwarnings('ignore')

import tensorflow as tf

from tensorflow.keras.optimizers import Adam

from tensorflow.keras.preprocessing.image import ImageDataGenerator2.构建网络

model=tf.keras.models.Sequential([

tf.keras.layers.Conv2D(32,(3,3),activation='relu',input_shape=(64,64,3)),

tf.keras.layers.MaxPooling2D(2,2),

tf.keras.layers.Conv2D(64,(3,3),activation='relu'),

tf.keras.layers.MaxPooling2D(2,2),

tf.keras.layers.Conv2D(128,(3,3),activation='relu'),

tf.keras.layers.MaxPooling2D(2,2),

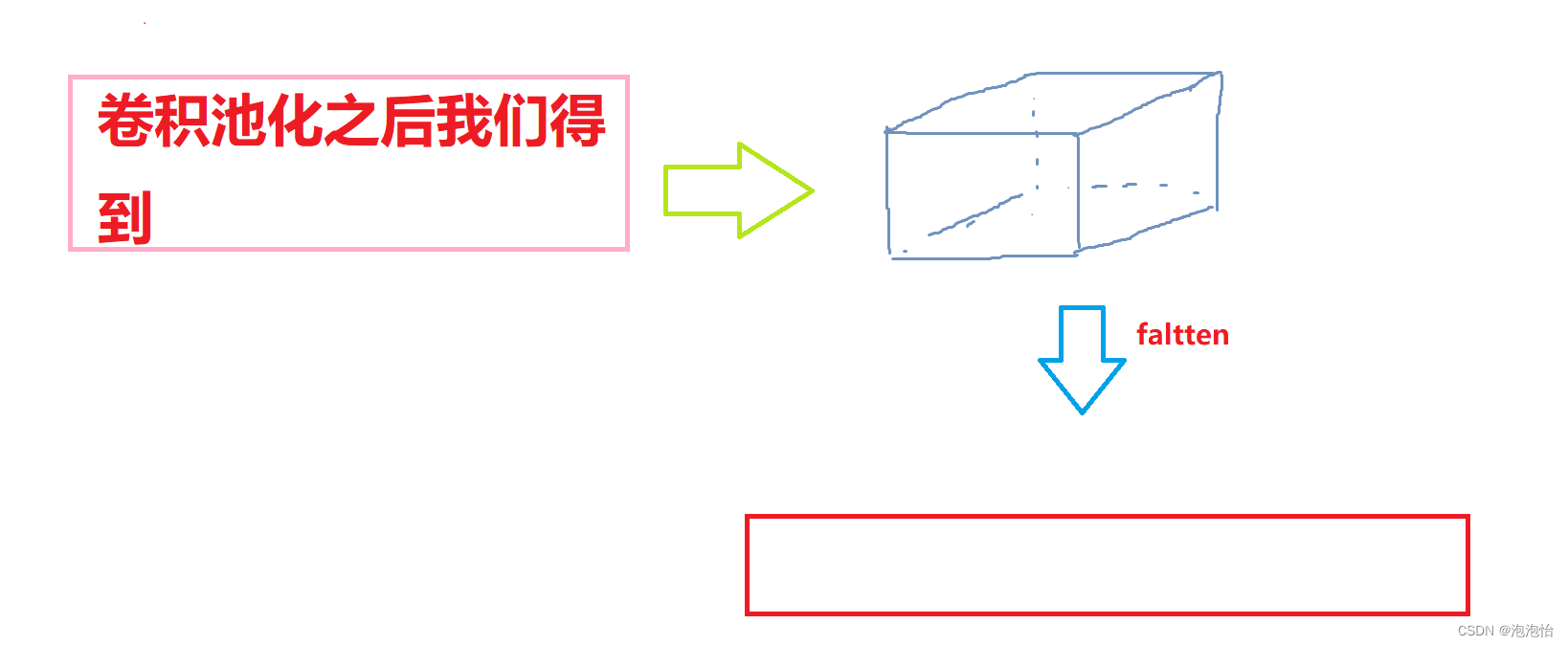

#由于卷积后我们得到的是立体特征图,所以我们需要将它拉长再输入全连接层

tf.keras.layers.Flatten(),

tf.keras.layers.Dense(512,activation='relu'),

#二分类用sigmoid

tf.keras.layers.Dense(1,activation='sigmoid')

]) 补充说明:

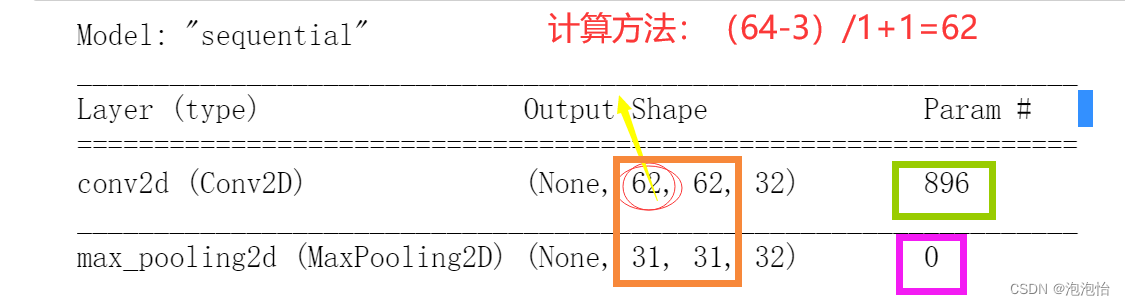

3.model.summary()

我们知道卷积网络的参数都是共享的。那我们算一下896 是怎么来的?

我们知道卷积网络的参数都是共享的。那我们算一下896 是怎么来的?

我们知道我们的卷积核是3×3的,但是捏卷积核第三个维度的大小跟输入的第三个维度一致。所以权重参数为3×3×3=27,然而每个卷积核都有27个权重参数,所以32个的32×27+32(偏置)=896.

另一个发现池化层:没有权重参数。

3.配置训练器

model.compile(loss='binary_crossentropy',

optimizer=Adam(lr=1e-4),

metrics=['acc'])4.数据预处理 图像数据归一化(0-1)区间

train_datagen=ImageDataGenerator(rescale=1./255)

test_datagen=ImageDataGenerator(rescale=1./255)5.使用ImageDataGenerator从目录中读取图像

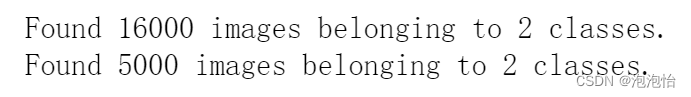

train_generator=train_datagen.flow_from_directory(

train_dir,

target_size=(64,64),#要和前面输入大小保持一致

batch_size=80,

class_mode='binary')

validation_generator=test_datagen.flow_from_directory(

validation_dir,

target_size=(64,64),

batch_size=50,

class_mode='binary'

)结果如下:

6.训练网络模型 :

1.直接fit也可以,但是通常我们不能把所有数据全部放入内存中,而fit_generator相当与一个生成器,动态产生所需的batch数据。

2.steps_per_epoch相当于给定一个停止条件,因为生成器会不断产生batch数据。

history=model.fit_generator(

train_generator,

epochs=100,

validation_data=validation_generator,

validation_steps=50,

verbose=2)7.绘制训练过程中损失曲线和精度曲线。

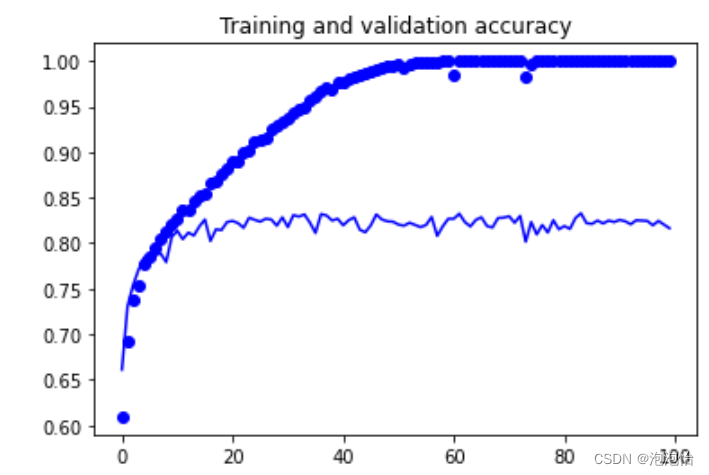

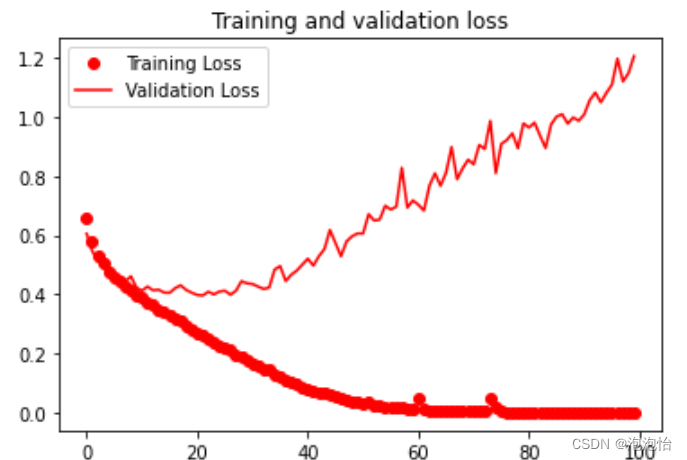

import matplotlib.pyplot as plt

acc=history.history['acc']

val_acc=history.history['val_acc']

loss=history.history['loss']

val_loss=history.history['val_loss']

epochs=range(len(acc))

plt.plot(epochs,acc,'bo',label='Training accuracy')

plt.plot(epochs,val_acc,'b',label='Validation accuracy')

plt.title('Training and validation accuracy')

plt.figure()

plt.plot(epochs,loss,'ro',label='Training Loss')

plt.plot(epochs,val_loos,'r',label='Validation Loss')

plt.title('Training and validation loss')

plt.legend()

plt.show()结果:过拟合。

最后

以上就是虚拟小蝴蝶最近收集整理的关于猫狗大战——卷积网络架构、训练模型的全部内容,更多相关猫狗大战——卷积网络架构、训练模型内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复