1. Confusion Matrix(混淆矩阵)

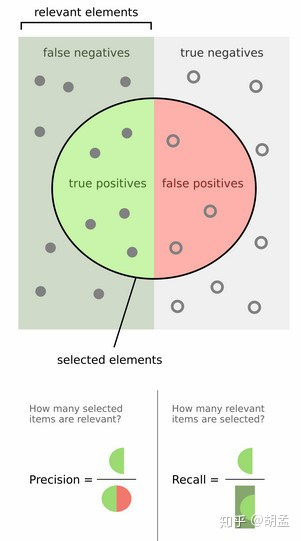

| Relevant | Nonrelevant | |

|---|---|---|

| Retrieved | True Positive | False Positive |

| Not Retrieved | False Negative | True Negative |

2. Precision and Recall

Precision = TP/(TP+FP),即被检索出的文档中真正相关的文档所占的比例。

Recall = TP/(TP+FN),即真正相关的文档中被成功召回(检索)的文档所占的比例。

下图解释较为形象:

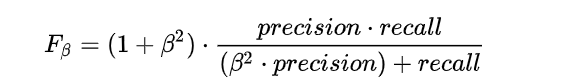

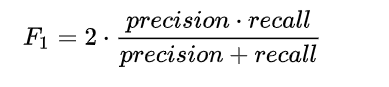

3. F measure

We normally use a balanced F1 measure with β=1.

4. Rank-Based Measures

Slides: Stanford CS276 Ranked-Based Measures

- Precision@K

- Mean Average Precision (MAP)

- Mean Reciprocal Rank (MRR)

- Normalized Discounted Cumulative Gain (NDCG)

最后

以上就是诚心棒棒糖最近收集整理的关于Evaluation Metrics in Information Retrieval(信息检索中的评价指标)的全部内容,更多相关Evaluation内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复