1.Ubuntu环境配置

本文使用Ubuntu 18.04.1 LTS,其他版本搭建过程基本一致。

创建hadoop用户(可略)

1.创建新用户

$ sudo useradd -m hadoop -s /bin/bash

2.设置密码

$ sudo passwd hadoop

3.为 hadoop 用户增加管理员权限

$ sudo adduser hadoop sudo

4.注销当前用户并切换到hadoop用户

更新apt

$ sudo apt-get update

安装Vim

$ sudo apt-get install vim

安装SSH、配置SSH无密码登陆

集群或单节点模式都需要用到 SSH 登陆。Ubuntu 默认安装了 SSH client,此外还需要安装 SSH server

$ sudo apt-get install openssh-server

使用ssh localhost登陆本机(需要输入密码)

为了避免每一次使用SSH都要输入密码,利用 ssh-keygen 生成密钥,并将密钥加入到授权中:

$ cd ~/.ssh/ # 如果不存在该文件夹,需要先登陆本机

$ ssh-keygen -t rsa # 会出现多个提示,全部回车

$ cat ./id_rsa.pub >> ./authorized_keys # 加入授权

登陆本机

$ ssh localhost

安装Java环境

安装前最好更改系统软件源为国内源(阿里云)

$ sudo apt-get install default-jre default-jdk

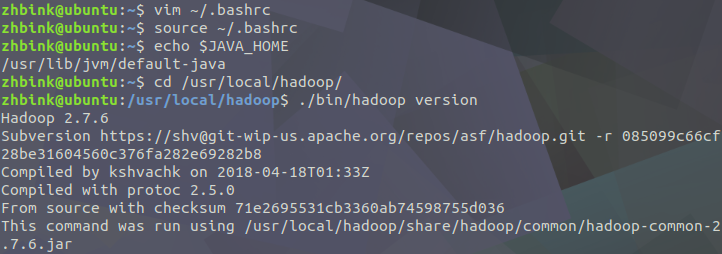

需要配置JAVA_HOME环境变量

$ vim ~/.bashrc

加入这一行

export JAVA_HOME=/usr/lib/jvm/default-java

退出,让环境变量生效

$ source ~/.bashrc

测试

$ echo $JAVA_HOME

$ java -version

$ $JAVA_HOME/bin/java -version #这句等同于上面

2.安装 Hadoop 2

需要下载编译好的hadoop-2.x.y.tar.gz 文件

我下载的是2.7.6

将 Hadoop 安装至 /usr/local/ 中:

$ sudo tar -zxf ~/Download/hadoop-2.7.6.tar.gz -C /usr/local

$ cd /usr/local/

$ sudo mv ./hadoop-2.7.6/ ./hadoop

$ sudo chown -R hadoop ./hadoop # 修改文件权限,第一个hadoop为用户名

Hadoop 解压后即可使用。检测:

$ cd /usr/local/hadoop

$ ./bin/hadoop version

Hadoop 默认模式为非分布式模式(本地模式),无需进行其他配置即可运行。

Hadoop伪分布式配置

因为只是简单地学习,仅使用伪分布式的方式。

修改配置文件 core-site.xml ( vim ./etc/hadoop/core-site.xml),将

<configuration></configuration>

修改为:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.

</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

修改配置文件 hdfs-site.xml:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

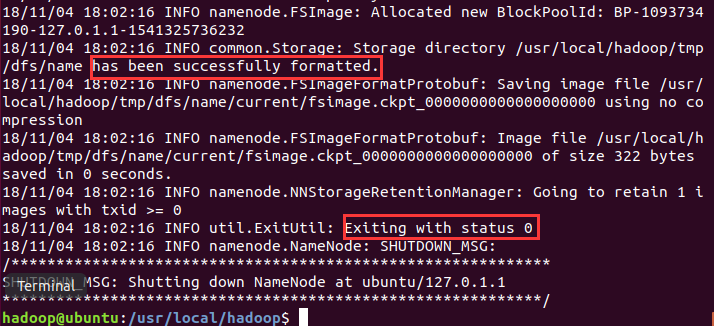

执行 NameNode 的格式化:

$ ./bin/hdfs namenode -format

出现 “successfully formatted” 和 “Exitting with status 0”则代表成功

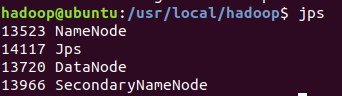

开启 NameNode 和 DataNode 守护进程。

./sbin/start-dfs.sh

通过 jps 可以判断是否成功启动

如果有NameNode 或 DataNode则配置成功

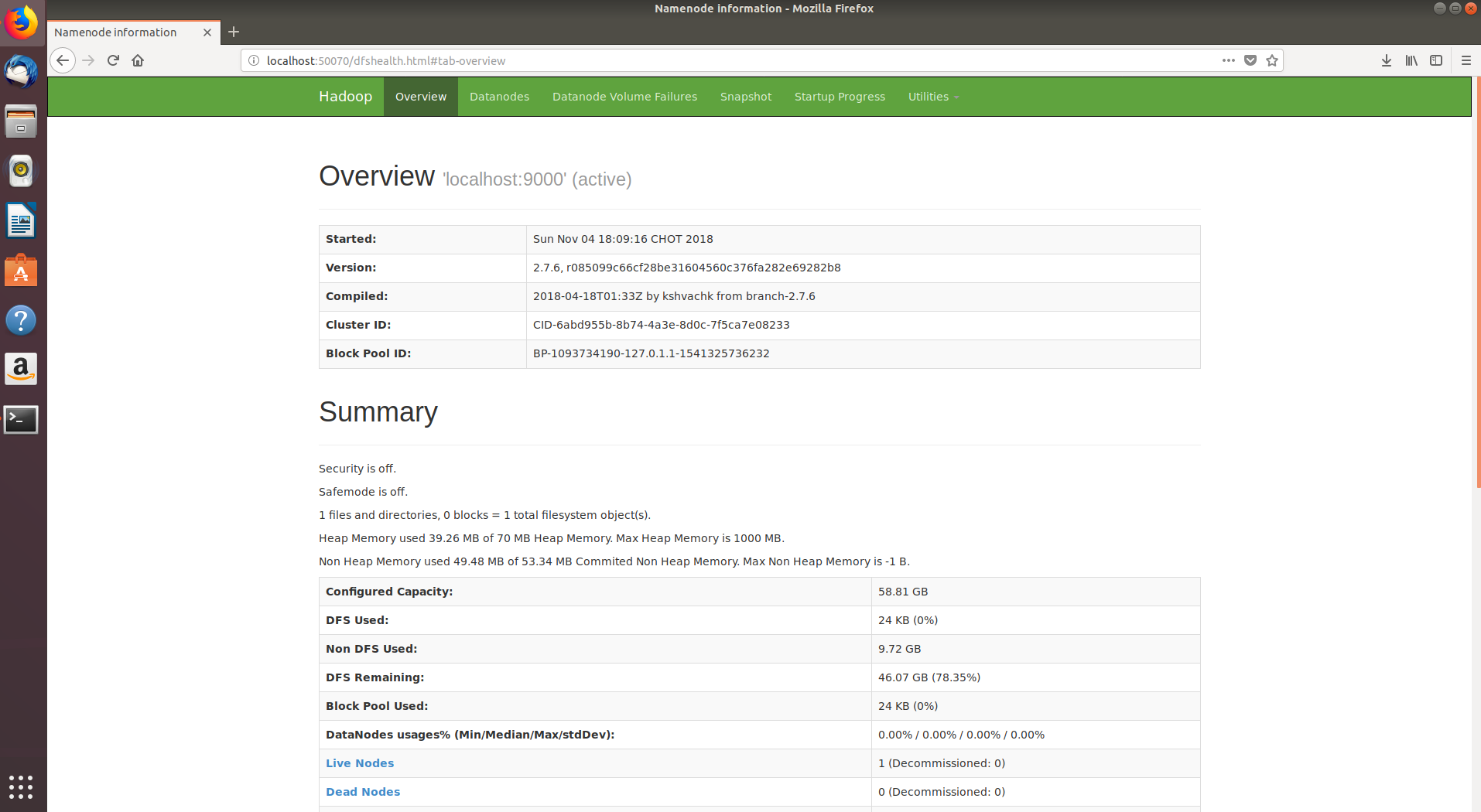

可以访问 http://localhost:50070 查看详细信息

使用HDFS

在 HDFS 中创建用户目录

$ ./bin/hdfs dfs -mkdir -p /user/hadoop

注:

- hadoop fs适用于任何不同的文件系统,比如本地文件系统和HDFS文件系统

- hadoop dfs只能适用于HDFS文件系统

- hdfs dfs跟hadoop dfs的命令作用一样,也只能适用于HDFS文件系统

开启hdfs

$ ./sbin/start-dfs.sh

关闭hdfs

$ ./sbin/stop-dfs.sh

YARN

YARN 负责资源管理与任务调度。YARN 运行于 MapReduce 之上,提供了高可用性、高扩展性。

修改配置文件 mapred-site.xml

重命名:

$ mv ./etc/hadoop/mapred-site.xml.template ./etc/hadoop/mapred-site.xml

编辑 vim ./etc/hadoop/mapred-site.xml :

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

修改配置文件 yarn-site.xml:

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name> <value>mapreduce_shuffle</value>

</property>

</configuration>

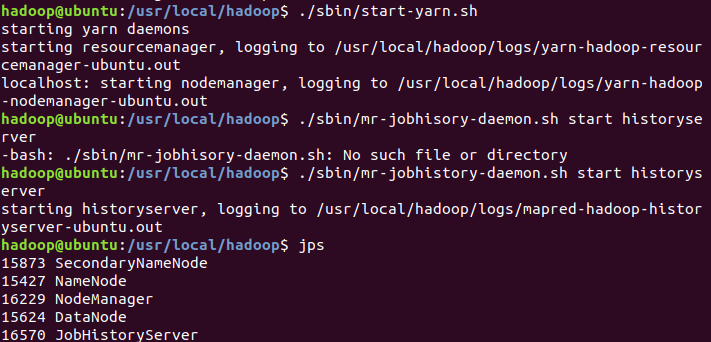

启动 YARN (需要先执行过 ./sbin/start-dfs.sh):

$ ./sbin/start-yarn.sh

$ ./sbin/mr-jobhistory-daemon.sh start historyserver

通过 jps ,多了 NodeManager 和 ResourceManager 两个后台进程

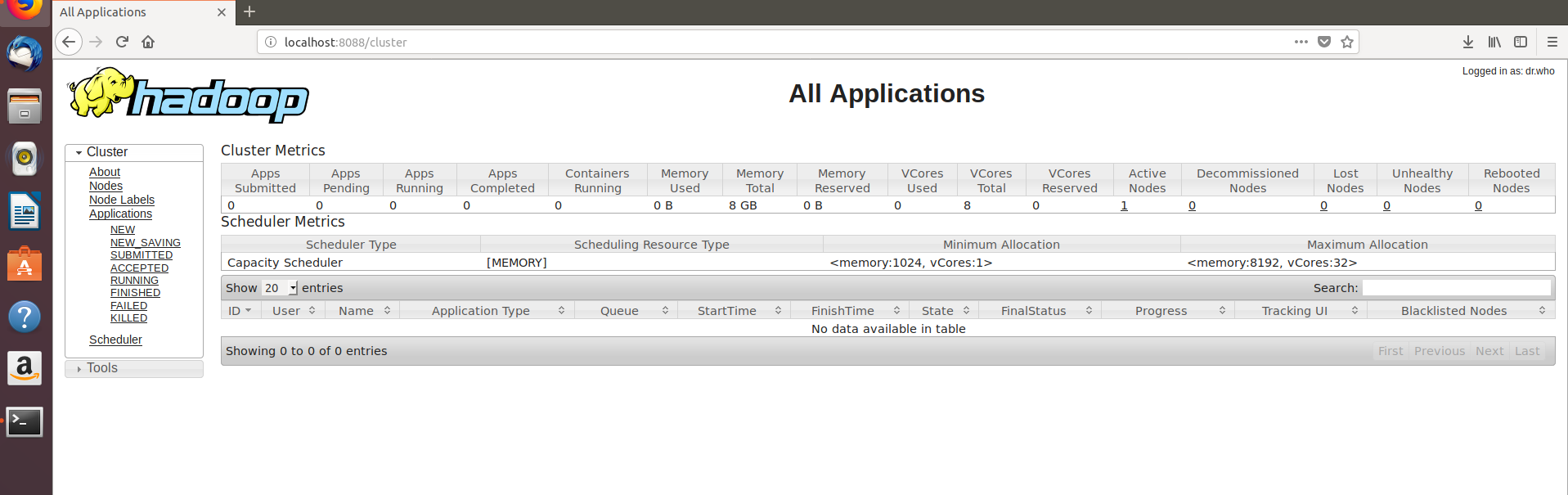

启动 YARN 后可以通过localhost:8088.cluster 查看任务的运行情况

关闭 YARN 的脚本:

$ ./sbin/stop-yarn.sh

$ ./sbin/mr-jobhistory-daemon.sh stop historyserver

Hadoop执行例子

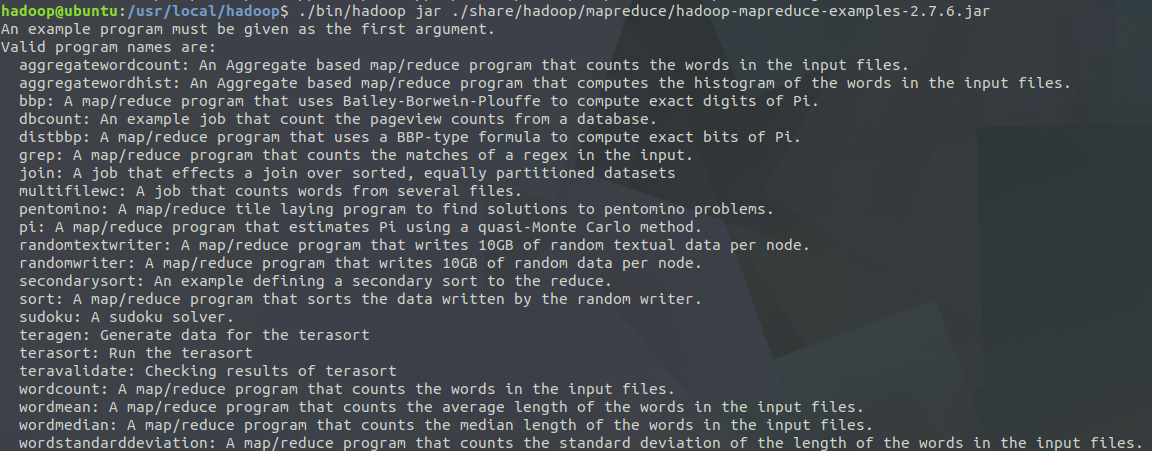

hadoop附带很多例子,包括wordcount、join、grep、terasort等。运行 ./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.6.jar 可以看到所有例子

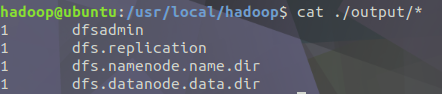

选择运行 grep 例子,将 input 文件夹中的所有文件作为输入,筛选当中符合正则表达式 dfs[a-z.]+ 的单词并统计出现的次数,最后输出结果到 output 文件夹中。

$ cd /usr/local/hadoop

$ mkdir ./input

$ cp ./etc/hadoop/*.xml ./input # 将配置文件作为输入文件

$ ./bin/hadoop jar ./share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.6.jar grep ./input ./output 'dfs[a-z.]+'

$ cat ./output/* # 查看运行结果

执行后输出了作业的相关信息,输出的结果是符合正则的单词各出现了1次

注意,Hadoop 默认不会覆盖结果文件,因此再次运行上面实例会提示出错,需要先将 ./output 删除。

rm -r ./output

为Hadoop添加至环境变量

每一次启动都要进入/usr/local/hadoop目录,再执行sbin/hadoop(等同于运行 /usr/local/hadoop/sbin/hadoop),受之前为jdk添加至环境变量过程的启发,在这里希望将Hadoop添加至环境变量。

在~/.bashrc中加入:

export PATH=$PATH:/usr/local/hadoop/sbin:/usr/local/hadoop/bin

执行source ~/.bashrc使设置生效。

在任意目录中都可以直接开启Hadoop:start-dfs.sh;直接启动YARN:start-yarn.sh;使用hdfs:如hdfs dfs -ls input查看HDFS文件。

最后

以上就是隐形小蜜蜂最近收集整理的关于Ubuntu 18.04.1 LTS 搭建Hadoop环境1.Ubuntu环境配置的全部内容,更多相关Ubuntu内容请搜索靠谱客的其他文章。

发表评论 取消回复