学习演练Hadoop 2.6有一段日子了。现在才大致搞清楚了系统里面各个log的位置和功能,在这里总结一下。网上的资料并不丰富,甚至Google出来的结果也不是很满意,或许这个是太简单了,牛人都不屑来写。也可能是各个公司藏着掖着的东西。

Hadoop 2.6包含两个大部分:DFS和Yarn,而Yarn里面又包含在Resource Manager的JVM中运行的部分和在Node Manager里面运行的JVM部分。所以整个系统(不考虑加装ZooKeeper的HA的情况)的log是分别放在3个log里面的。

1. 对于DFS的log,在Name Node和Data Node里面,默认可以在${HADOOP_INSTALL}/logs里面看到。这个是非DFS的文件,直接可以通过Linux文件系统看到。

2. 对于Yarn的log,在Resource Manager和Node Manager里面,默认可以在${HADOOP_INSTALL}/logs里面看到。这个也是非DFS的文件,直接可以通过Linux文件系统看到。

对于MapReduce任务的log,情况就比较的复杂了。在2.6里面,task是按照application->container的层次来管理的,所以在Name Node机器上运行mapreduce程序的时候,在console里面看到的log都可以通过在相应的data node/node manager里面的${HADOOP_INSTALL}/logs/userlogs下面找到。这个部分也是非DFS文件,直接可以通过Linux文件系统看到。

这些log也可以通过Hadoop Web管理页面看到,比较方便。

网络上搜来的信息基本都是关于上面这些部分的。可对于一个开发人员而言,上面这些log对于调试程序的帮助就不大了。Java程序员会经常要用System.out/err来输出中间内容到standard output,而且工业界早就用logger来记录系统状态和帮助调试了。那么我们在mapreduce程序体里面怎么来得到这些log哪。

首先讲讲System.out的输出,这个网络上的介绍还算详细。基本来说在main方法里面的部分都可以在console上输出。这一点不管是在Eclipse里面通过插件链接DFS运行on MapReduce的时候,还是直接在namenode上跑jar包,都可以看的到。直接编程读写DFS的程序也能够通过这个方法来看到中间结果和调试程序。而上面也说了,因为这个task的部分是运行在resource manager的启动的JVM里面(这个部分不是很确定,也许是单独启动的一个JVM),所以System.out的输出可以看到。而一旦程序进入Mapper和Reducer的部分,这个时候,任务是分发到datanode的机器里面跑,那里的JVM的输出就不会再返回到task的JVM了,所以在Mapper和Reducer里面的System.out输出是无法看到的。

那么这个时候怎么来写log哪?网络搜索的结果基本给了3个方法:1. 用log4j来生成logger;2. 用apache common里面的LogFactory生成logger;3. 用MultipleOutput来自己写log输出。

1和2本质是一样的,只是调用现成的Logger类。3是要自己管理log文件的生成和输出,灵活但是很累。

现在最关键的问题来了。我用Log4j或者LogFactory的Logger输出的log文件在哪里?搜了一天,基本讲的都语焉不详,特别是针对Hadoop 2.6的,没有找到。综合了几个帖子,终于发现了问题所在。为了能看到Logger输出的内容,需要做如下几件事:

1. 在启动Hadoop集群的时候,除了start-yarn.sh和start-dfs.sh,还要启动historyserver,命令是

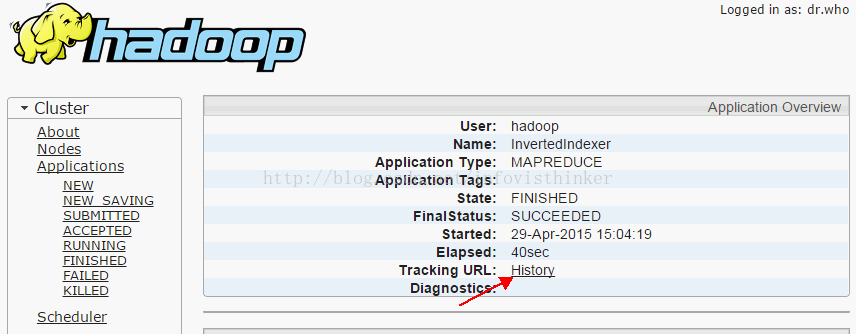

mr-jobhistory-daemon.sh start historyserver启动了HistoryServer后,就可以看到Tracking URL里面的History了。

还能在Hadoop Web管理界面里看到每个Job的历史Map和Reduce任务,以及每个任务所在的datanode。

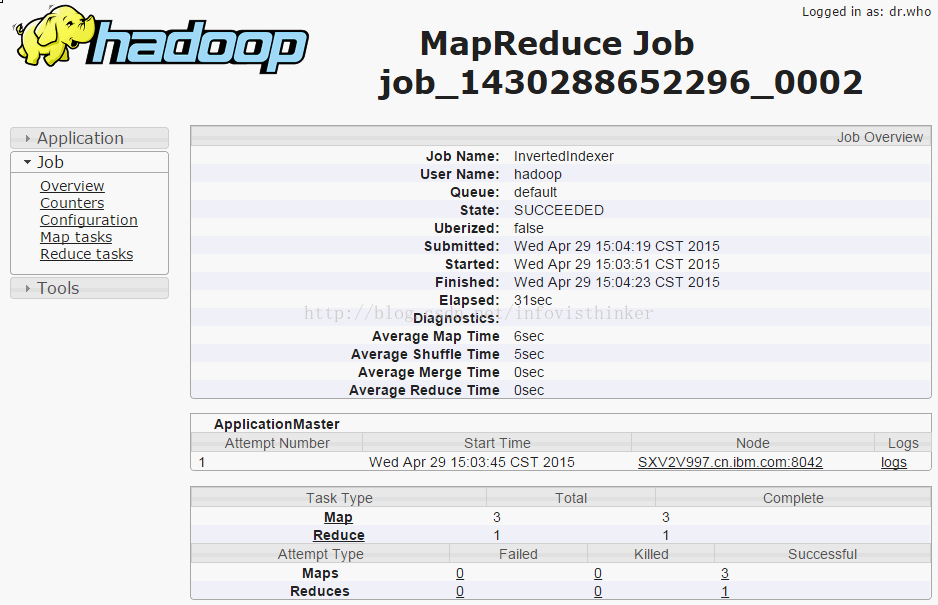

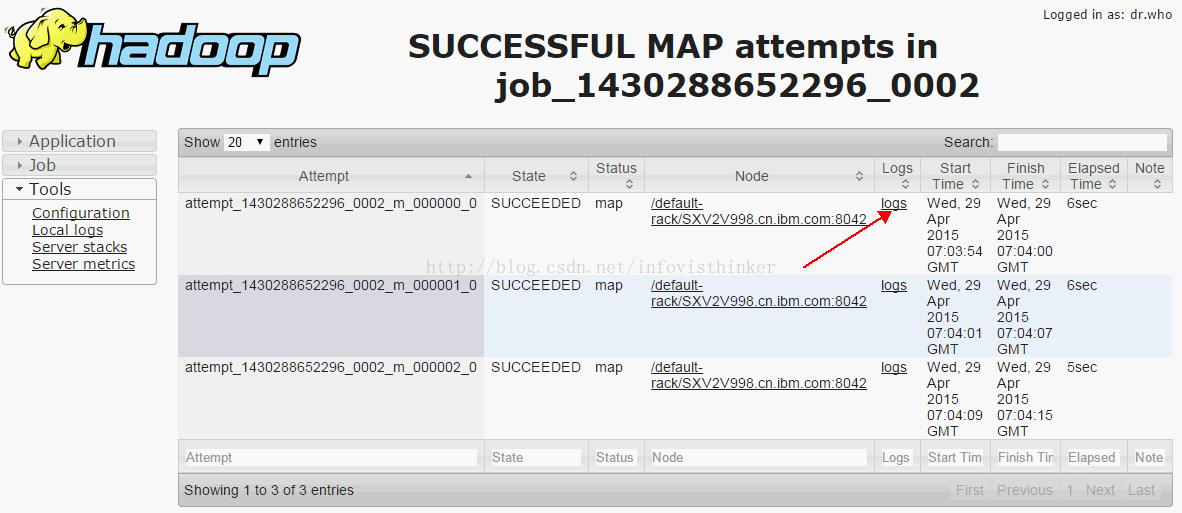

点击Maps和Reduces后面的数字link,就能看到每个任务运行的情况。

但是当去点击log的链接的时候,会碰到Aggregation function is not enabled错误。为了能看到每个Map和Reduce任务的Log,还必须在yarn-site.xml里面配置aggregation为true。

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

<description>Configuration to enable or disable log aggregation</description>

</property>

到了这里,就只剩下一个问题了。这个log文件在哪里?查看yarn-site.xml后终于发现了MapReduce任务的log的位置。

<name>yarn.nodemanager.remote-app-log-dir</name>

<value>/logs</value>

<description>HDFS directory where the application logs are moved on application completion. Need to set appropriate permissions. Only applicable if log-aggregation is enabled. The default value is "/logs" or "/tmp/logs" </description>

</property>[hadoop@SXV2V999 ~]$ hdfs dfs -ls hdfs://namenode/logs/hadoop/logs/application_1430285399789_0001

15/04/29 23:02:01 WARN util.NativeCodeLoader: Unable to load native-hadoop library for your platform... using builtin-java classes where applicable

Found 2 items

-rw-r----- 2 hadoop supergroup 58369 2015-04-29 13:32 hdfs://namenode/logs/hadoop/logs/application_1430285399789_0001/<strong><em>hostname</em></strong>_39575

-rw-r----- 2 hadoop supergroup 399834 2015-04-29 13:32 hdfs://namenode/logs/hadoop/logs/application_1430285399789_0001/<strong><em>hostname</em></strong>_54053在Web页面里显示的也就是从这两个文件里读取并排版的。自此每个log文件的具体位置终于水落石出。

个人心得,有错误和不全面的地方欢迎拍砖。

最后

以上就是热情日记本最近收集整理的关于Hadoop 2.6 日志文件和MapReduce的log文件研究心得的全部内容,更多相关Hadoop内容请搜索靠谱客的其他文章。

![[Hive]MapReduce将数据写入Hive分区表](https://www.shuijiaxian.com/files_image/reation/bcimg6.png)

![java web 经验笔记 (二)1.Failed to configure a DataSource: 'url' attribute is not specified and no embedded datasource could be configured. Reason: Failed to determine a suitable driver class有关datasource2. Circular view path [login]: would dispatch back to](https://www.shuijiaxian.com/files_image/reation/bcimg11.png)

发表评论 取消回复