一、Hadoop的部署模式:官网:hadoop.apache.org

1、单机部署

进程没有

2、伪分布式部署 开发用的比较多

进程存在 +1节点

3、集群部署 开发/生产

进程存在+ n节点

二、Hadoop伪分布式部署步骤:注意前提是基础部署完成后

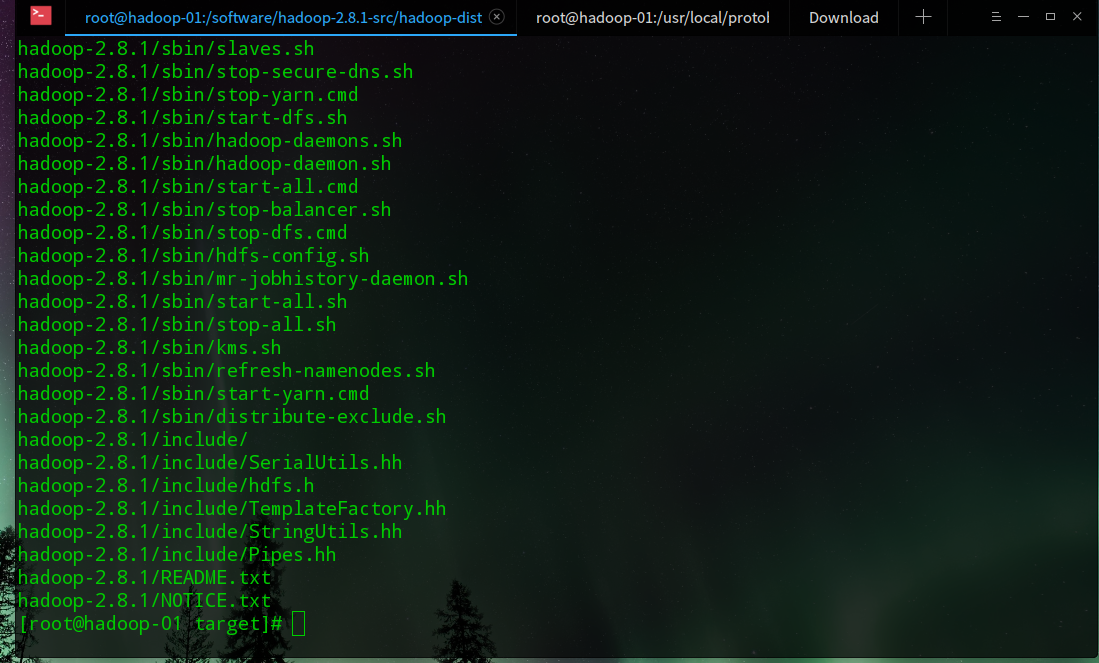

1、解压安装包

cd /sofware

tar -xzvf hadoop-2.8.1.tar.gz

2、解读解压文件:

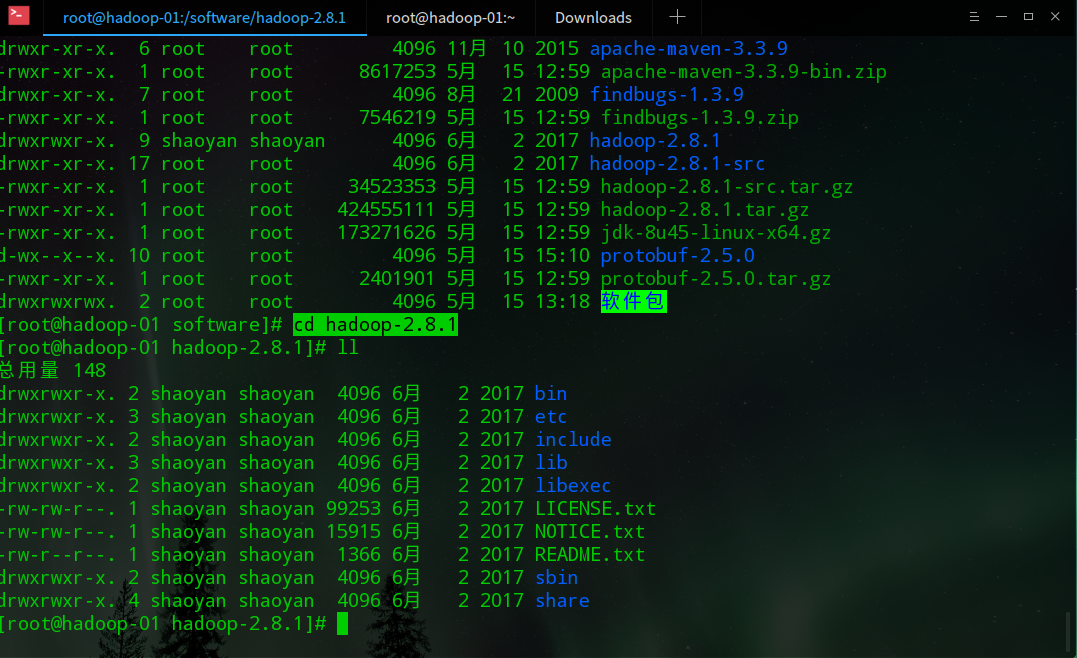

更改解压后的用户属性:

chown -R root:root hadoop-2.8.1

cd hadoop-2.8.1

ll

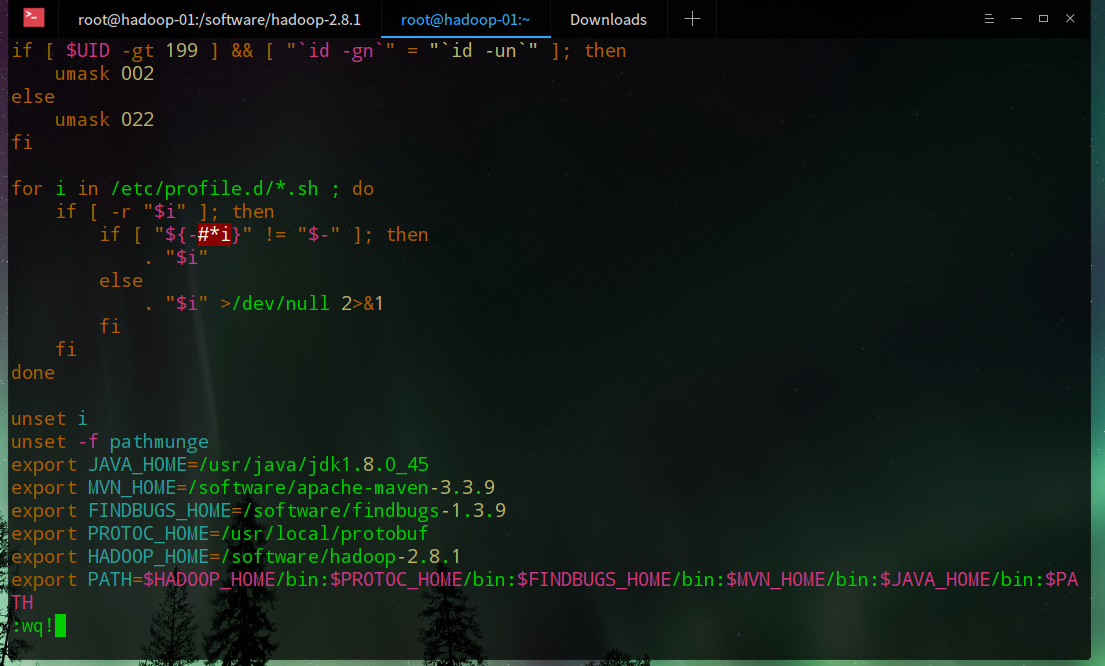

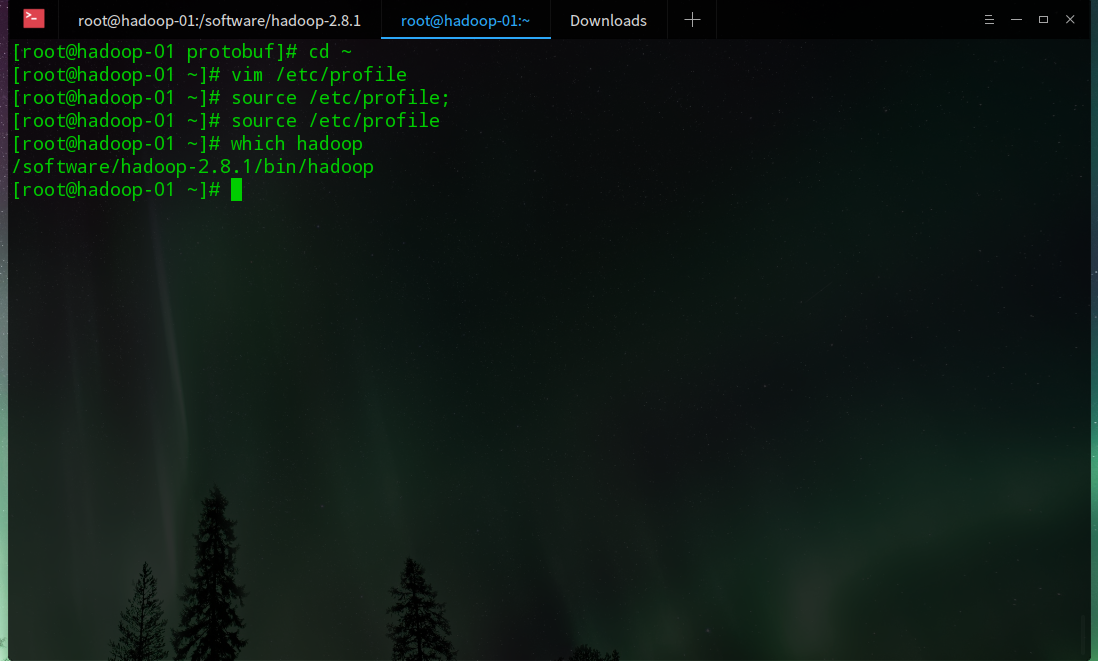

3、配置环境变量:

生效后查看:

4、删除无用的目录

rm -f bin/*.cmd

rm -f sbin/*.cmd

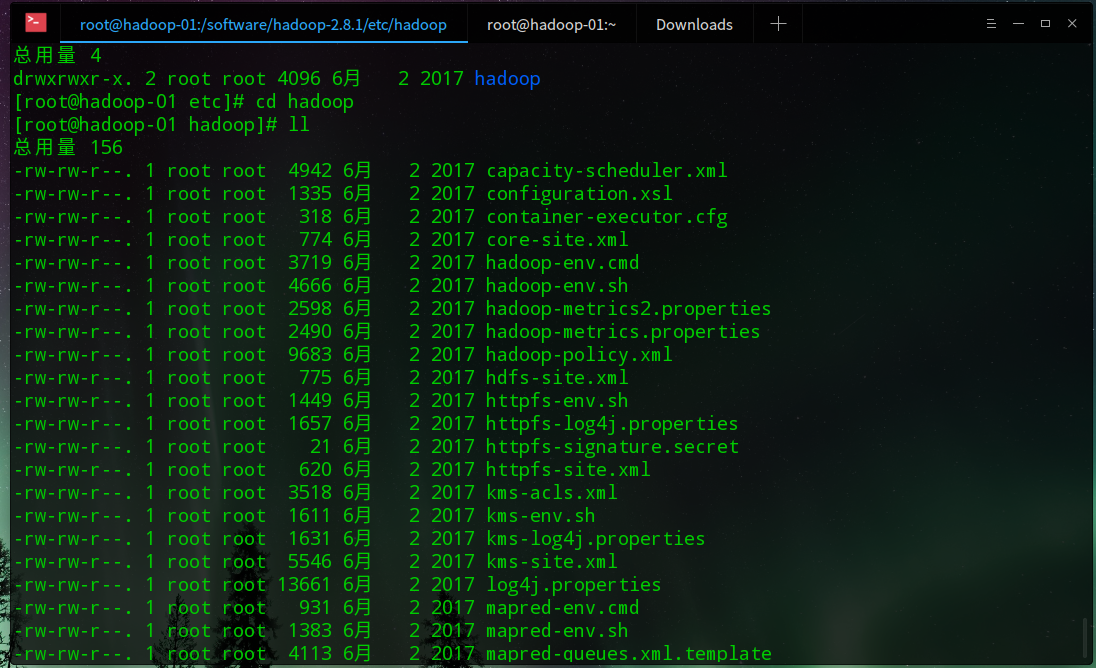

5、配置core-site文件

cd etc/hadoop

ll

修改配置文件

vim core-site.xml

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://192.168.137.130:9000</value>

</property>

</configuration>

vim hdfs-site.xml

etc/hadoop/hdfs-site.xml:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration>

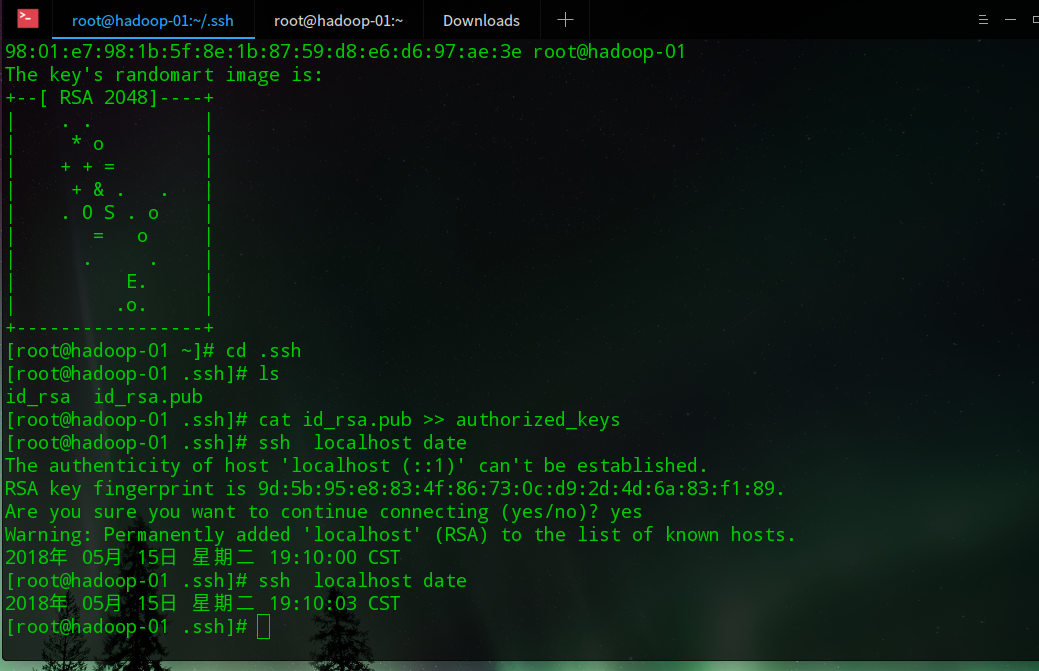

6、ssh

6.1、生成公钥文件

ssh-keygen

6.2、进入.ssh目录

cd .ssh

cat id_rsa.pub >> authorized_keys

6.3、第一次登录验证

ssh localhost date

6.4、测试登录:

ssh localhost date

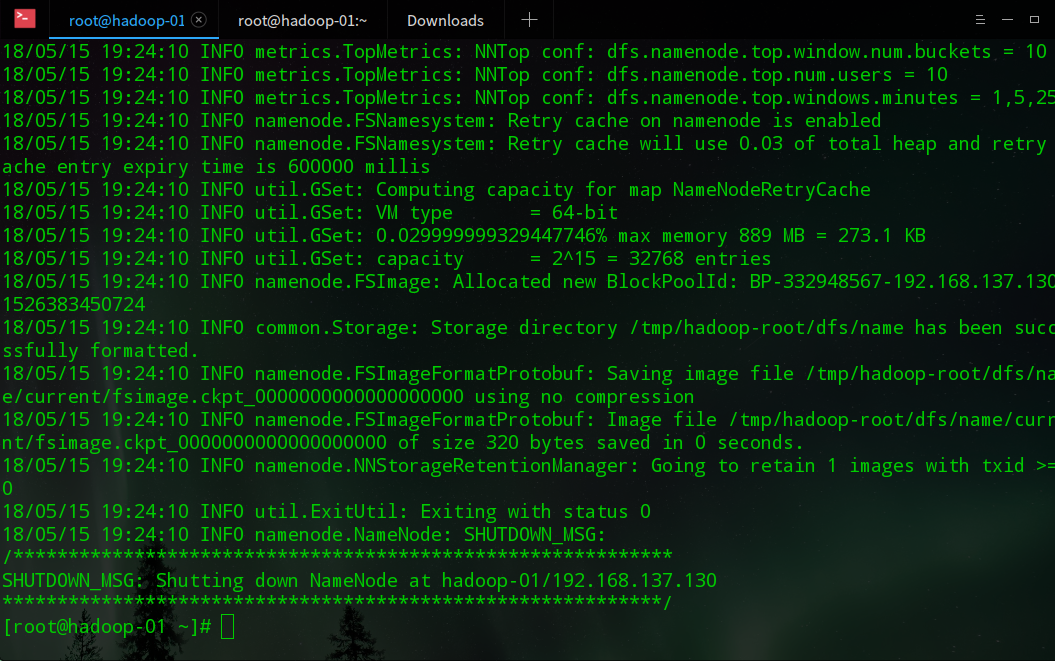

7、格式化文件系统

hdfs namenode -format

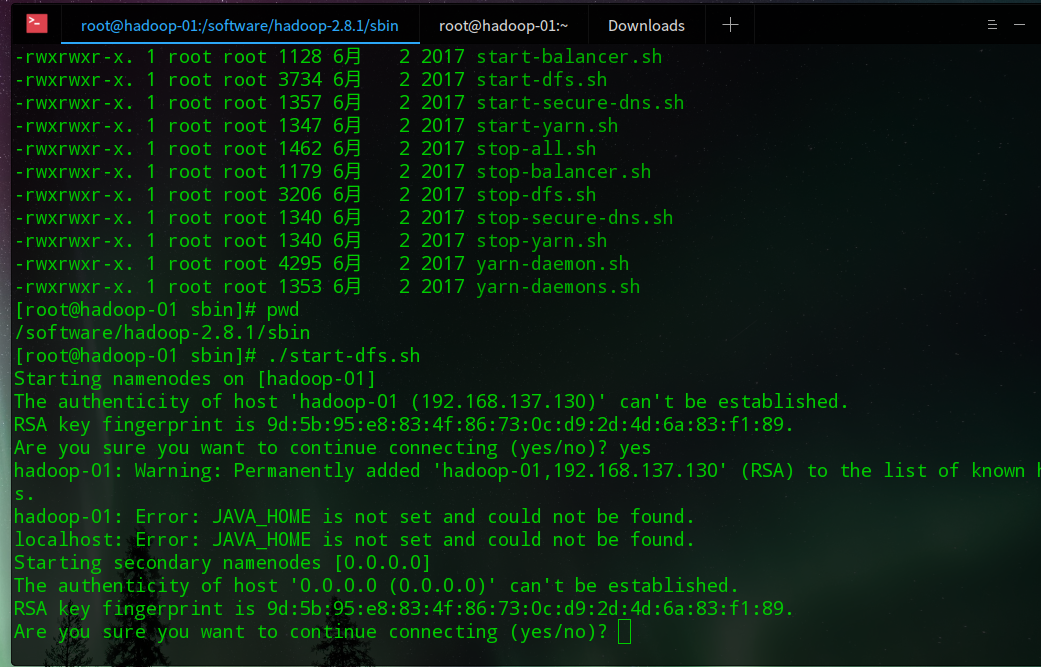

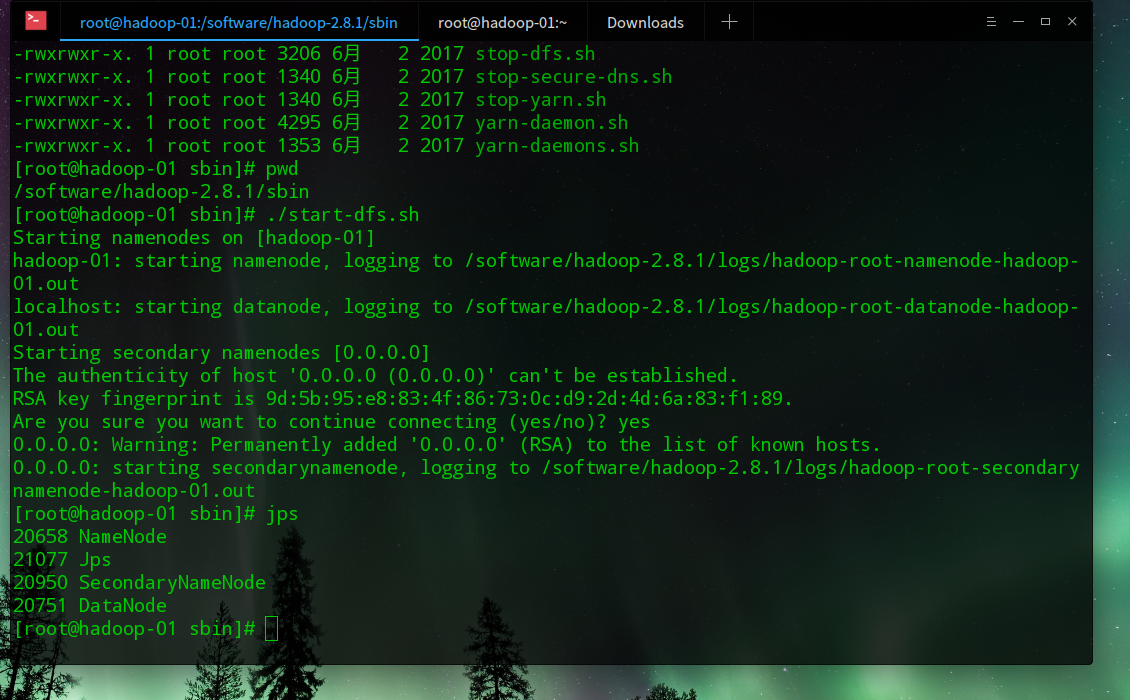

8、启动hdfs

cd /software/hadoop-2.8.1/sbin

./start-dfs.sh

提示java目录没有配置

9、java home配置

cd /software/hadoop-2.8.1/etc/hadoop

echo $JAVA_HOME

/usr/java/jdk1.8.0_45

vim hadoop-env.sh

# The java implementation to use.

export JAVA_HOME=/usr/java/jdk1.8.0_45

10、重新启动

cd /software/hadoop-2.8.1/sbin

./start-dfs.sh

11、检查是否成功:

jps

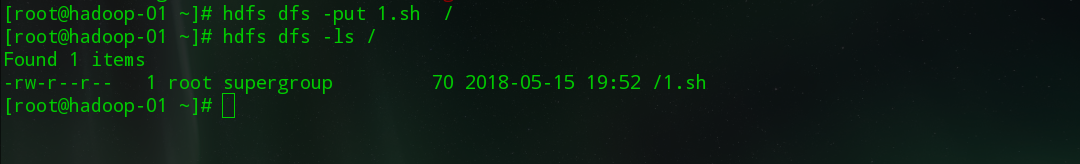

12、测试,向存储中放入文件并查看

hdfs dfs -put 1.sh /

hdfs dfs -ls /

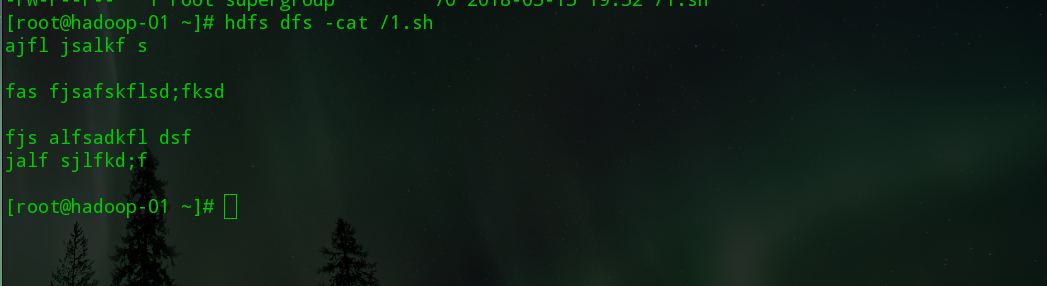

hdfs dfs -cat /1.sh

13、到此伪分布式系统部署成功。

最后

以上就是美满墨镜最近收集整理的关于大数据学习之Hodoop伪分布式部署的全部内容,更多相关大数据学习之Hodoop伪分布式部署内容请搜索靠谱客的其他文章。

发表评论 取消回复