1、走过的弯路

网上很多的博客介绍的是增量从某个数据库导入hive,其实就是使用类似于这种的sqoop语句,

sqoop import --driver com.microsoft.sqlserver.jdbc.SQLServerDriver --connect "jdbc:sqlserver://IP地址:1433;database=TS_Test" --username sa --password Test6530 --table data --target-dir '/user/hive/warehouse/data' --incremental append --check-column id --last-value 3 -m 1

我这里是sqlserver导入到hive中,我有一点被误导,说是增量,其中的参数last-value 是自动更新的,对last-vaalue怎么更新的?存储在哪里?.后来发现并不是。这里说的增量,就是给定一个范围抽取(不是全量的)。

2、真正的增量更新

我们可以使用sqoop提供的metastore,metastore它本质是一个hsql内存级数据库,用Metastore中保存-- last-value,通过这种方式进行增量的更新。

废话不说,直接上案例

1)首先需要配置metastore

首先需要选择一个节点放置metastore,我这里选择在主节点放置metastore,

打开master机器的sqoop-site.xml文件,(在SQOOP_HOME/conf/sqoop-site.xml )

<property>

<name>sqoop.metastore.server.location</name>

<!--数据存放的目录-->

<value>/usr/local/sqoop/tmp/sqoop-metastore/shared.db</value>

<description>Path to the shared metastore database files.

If this is not set, it will be placed in ~/.sqoop/.

</description>

</property>

<property>

<name>sqoop.metastore.server.port</name>

<!--client访问的端口-->

<value>16000</value>

<description>Port that this metastore should listen on.

</description>

</property>

然后再在其他机器的sqoop-site.xml文件加入下面的配置

<property>

<name>sqoop.metastore.client.autoconnect.url</name>

<value>jdbc:hsqldb:hsql://master:16000/sqoop</value>

</property>

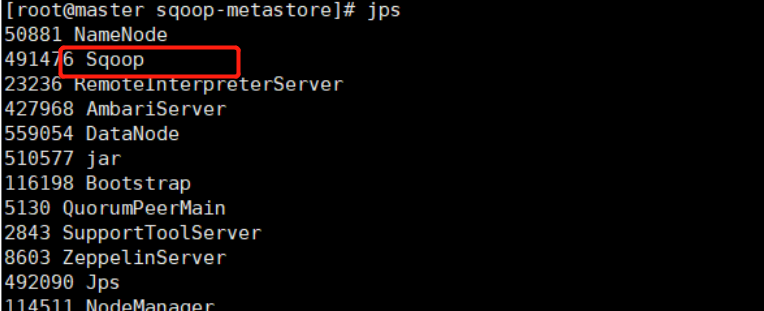

最后在启动master的metastore sqoop metastore &,启动成功后,我们能通过jps命令看到一个sqoop应用已经启动

2)创建一个sqoop job并将其保存进metastore

首先在sqlserver创建一个data表:

DROP TABLE IF EXISTS data;

CREATE TABLE data (

id int NOT NULL identity(1, 1),

name char(20) DEFAULT NULL,

last_mod datetime NOT NULL ,

PRIMARY KEY (id)

) ;

select * from data

INSERT INTO data VALUES ('1', '2019-08-28 17:31:56');

INSERT INTO data VALUES ('2', '2019-08-28 17:31:57');

INSERT INTO data VALUES ('3', '2019-08-28 17:31:58');

INSERT INTO data VALUES ('4', '2019-08-28 17:31:59');

先将mysql表数据全部导入hive

sqoop import --connect jdbc:mysql://IP:1433;database=TS_Test" --username sa --password Test6530 --table data --hive-import --hive-table test --fields-terminated-by ',' -m 1

注意:fields-terminated-by 要是不指定值的话,默认分隔符为’�01’,并且以后每次导入数据都要设置 --fields-terminated-by ‘�01’,不然导入的数据为NULL。建议手动设置 --fields-terminated-by的值。

这是查询一下hive表里的数据是不是三条,这是再次插入数据

INSERT INTO data VALUES ('4', '2019-08-28 17:31:58');

INSERT INTO data VALUES ('5', '2019-08-28 17:31:59');

INSERT INTO data VALUES ('6', '2019-08-28 17:32:00');

然后创建sqoop job

sqoop job --create test --meta-connect jdbc:hsqldb:hsql://master:16000/sqoop -- import --driver com.microsoft.sqlserver.jdbc.SQLServerDriver --connect "jdbc:sqlserver://IP:1433;database=TS_Test" --username sa --password Test6530 --table data --target-dir '/user/hive/warehouse/test' --hive-import --hive-table test --incremental append --check-column id --last-value 3 -m 1

可以查询一下创建的job

sqoop job -meta-connect jdbc:hsqldb:hsql://master:16000/sqoop -list

最后执行job

sqoop job --meta-connect jdbc:hsqldb:hsql://master:16000/sqoop --exec test

最后发现,hive表的hdfs上的存储目录里有两个文件,第二个文件里就是存放的id>3的数据。

如果我们再次插入一些新的数据

INSERT INTO data VALUES ('7', '2019-08-28 17:31:58');

INSERT INTO data VALUES ('8', '2019-08-28 17:31:59');

INSERT INTO data VALUES ('9', '2019-08-28 17:32:00');

再次执行job

同样在目录里生成第三个文件,里面会是从7到8的数据。

好了,有什么问题可以留言,我看到会回给大家解答。

最后

以上就是俊秀白羊最近收集整理的关于sqoop增量从sqlserver导入到hive表中的全部内容,更多相关sqoop增量从sqlserver导入到hive表中内容请搜索靠谱客的其他文章。

发表评论 取消回复