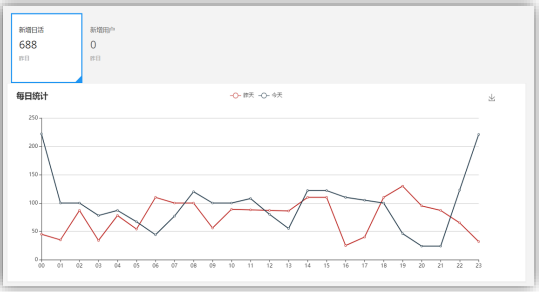

1.1 当日用户首次登录(日活)分时趋势图,昨日对比

从项目的日志中获取用户的启动日志,如果是当日第一次启动,纳入统计。将统计结果

保存到 ES 中,利用 Kibana 进行分析展示

1.2 实现思路

1.2.1 功能 1:SparkStreaming 消费 kafka 数据

Kafka 作为数据来源,从 kafka 中获取日志,kafka 中的日志类型有两种,启动和事件,

我们这里统计日活,只获取启动日志即可

1.2.2

功能 2:利用 redis 过滤当日已经计入的日活设备(对

一个用户的多次访问进行去重)

每个用户每天可能启动多次。要想计算日活,我们只需要把当前用户每天的第一次启动

日志获取即可,所以要对启动日志进行去重,相当于做了一次清洗。

实时计算中的去重是一个比较常见的需求,可以有许多方式实现,比如

◼

将状态存在 Redis 中

◼

存在关系型数据库中

◼

通过 Spark 自身的 updateStateByKey(checkPoint 小文件等问题比较麻烦)等

我们这里结合 Redis 实现对当前用户启动日志去重操作

1.2.3 功能 3:把每批次新增的当日日活信息保存到 ES 中

去重清洗后的数据如何处理

我们这里使用方案 1

1.2.4 功能 4:从 ES 中查询出数据,发布成数据接口,可视

化工程进行调用

最后

以上就是无辜高跟鞋最近收集整理的关于(28)实时日活思路的全部内容,更多相关(28)实时日活思路内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复