Pentaho Kettle 7.1 读取 Hive 数据到 MySql

目录

1、hive jar包的存放位置 1

2、下载对应的hive jar包 1

3、Hadoop所需要的jar包下载地址 2

4、下载Hadoop所需要的jar包 3

5、修改plugin.properties文件 5

6、重启kettle新建DB连接 6

7、新建转换 6

8、参考文档 9

1、hive jar包的存放位置

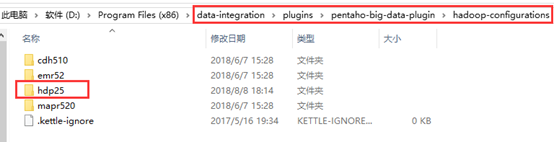

在kettle的安装目录中找到hadoop-configurations文件夹,如下:

注意:文件夹名称hadoop-configurations 和 hdp25 需要配置到配置文件中,稍后说明。

Hive的jar包存放在hdp25文件夹下面的lib文件夹。

2、下载对应的hive jar包

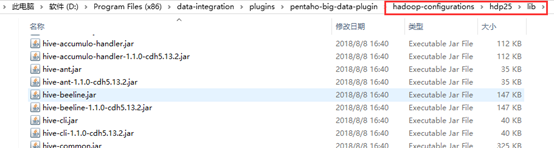

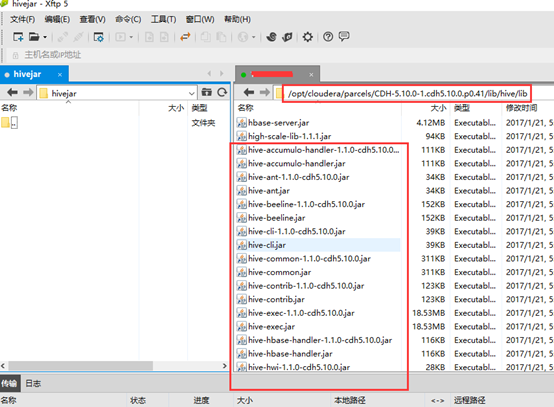

在服务器上找到所有hive的相关jar包,下载下来放入hadoop-configurations目录下的hdp25的lib文件夹中。

通过CDH安装的hive jar包一般保存在/opt/cloudera/parcels/CDH/lib/hive/lib中。

下载所有hive开头的jar包,放入到data-integrationpluginspentaho-big-data-pluginhadoop-configurationshdp25lib路径中。

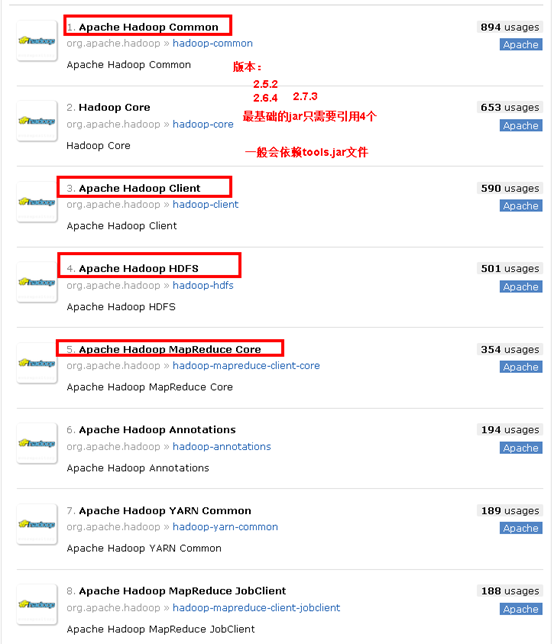

3、Hadoop所需要的jar包下载地址

JDK版本的要求:

Hadoop 2.7 以及之后的版本,需要JDK 7;

Hadoop 2.6 以及之前的版本,支持JDK 6;

对于Hadoop1.x.x版本,只需要引入1个jar:

hadoop-core

对于Hadoop2.x.x版本,需要引入4个jar:

hadoop-common

hadoop-hdfs

hadoop-mapreduce-client-core

hadoop-client

jdk.tools(视情况需要,我没有使用也能够连通)

需要的Jar包 (对应版本:2.x.x)

Maven仓库:https://mvnrepository.com/artifact/org.apache.hadoop

4、下载Hadoop所需要的jar包

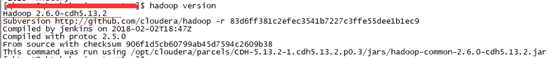

查看Hadoop安装版本 命令:hadoop version

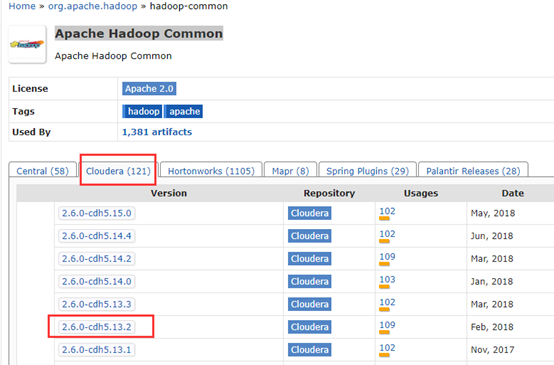

以Apache Hadoop Common包为例:

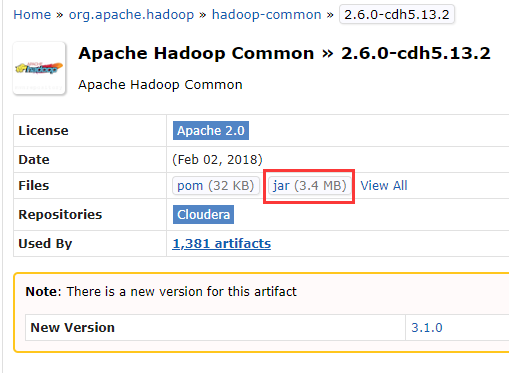

选择对应版本的jar包,点击下载。

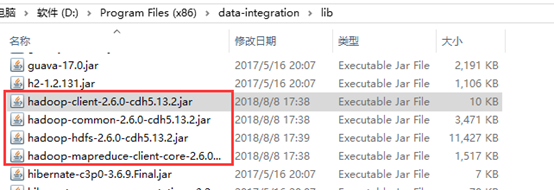

同样下载其他3个jar包,放到 data-integrationlib 目录中。

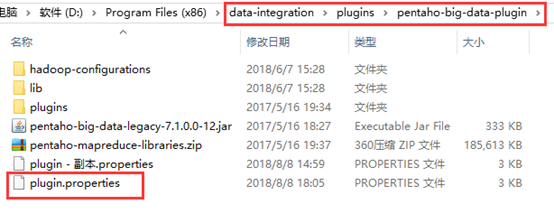

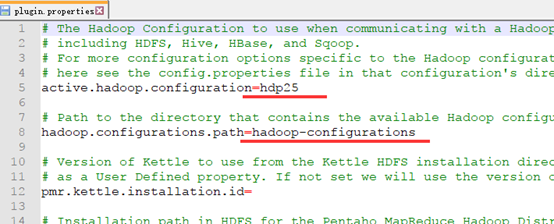

5、修改plugin.properties文件

找到 data-integrationpluginspentaho-big-data-plugin 目录中的 plugin.properties 文件。

修改配置为上面提到的安装目录对应的文件夹名称。

6、重启kettle新建DB连接

修改配置后以及新增jar包后需要重启kettle才生效。

重启后尝试建立DB连接如下:

主对象树–》DB连接右键新建—》填写相关参数(参数与自己的hivesever2的ip端口数据库名以及可登陆linux系统访问hiveserver2的用户名对应)

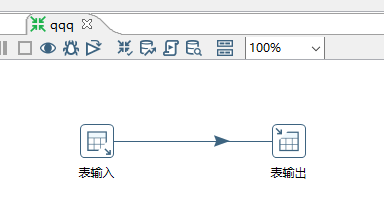

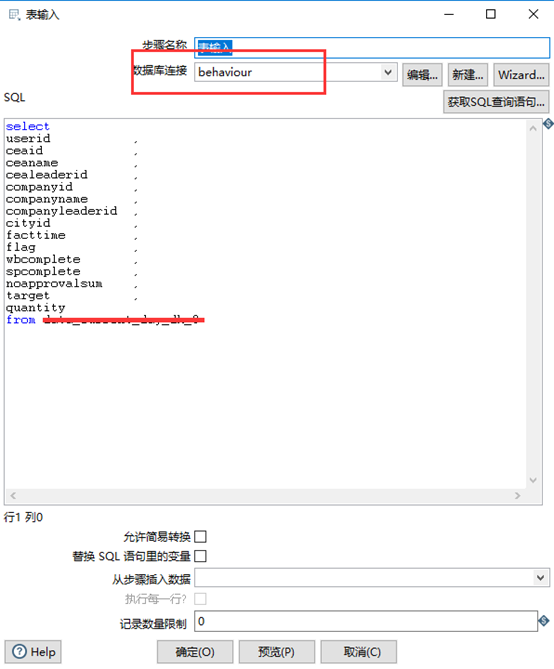

7、新建转换

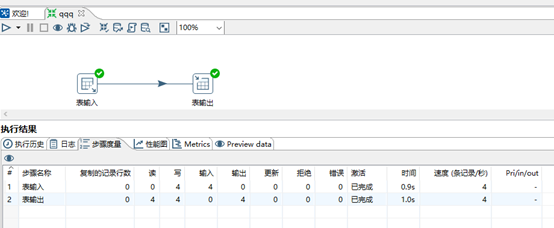

表输入 à 表输出

表输入:

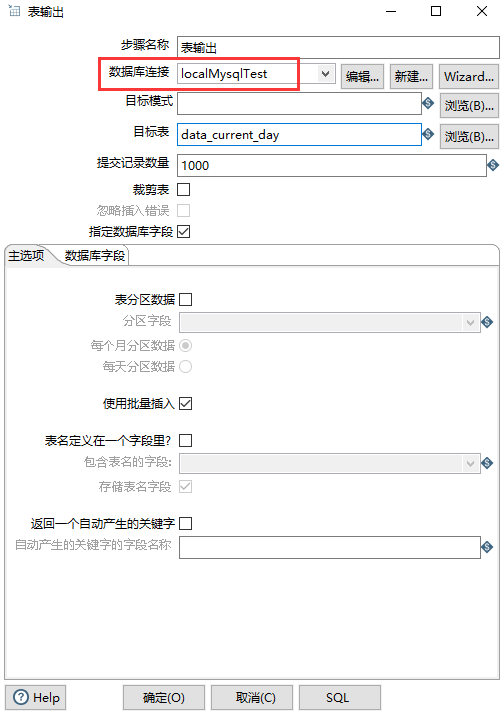

表输出:

执行:

8、参考文档

-

https://blog.csdn.net/w405722907/article/details/77962227

-

https://blog.csdn.net/zzq900503/article/details/79088912

转载于:https://www.cnblogs.com/sunnyjarry/p/9448259.html

最后

以上就是神勇眼睛最近收集整理的关于Pentaho Kettle 7.1 读取 Hive 数据到 MySql的全部内容,更多相关Pentaho内容请搜索靠谱客的其他文章。

发表评论 取消回复