从头开始来搭建一个maven的是spark与scala的项目

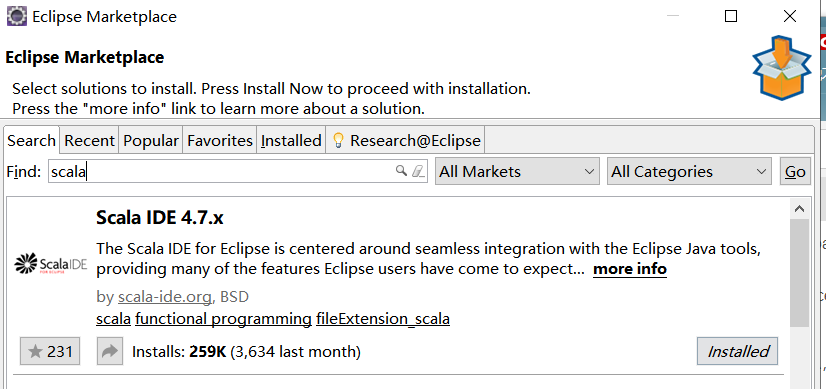

首先下载scala 的 IDE

eclipse的help 下有一个marketplace点进去

然后如下图

我可能会出现找不到,千万不要急,可能是eclipse版本低了,可以换一个高版本来,或者使用手动导入就好

installed 全部呀!

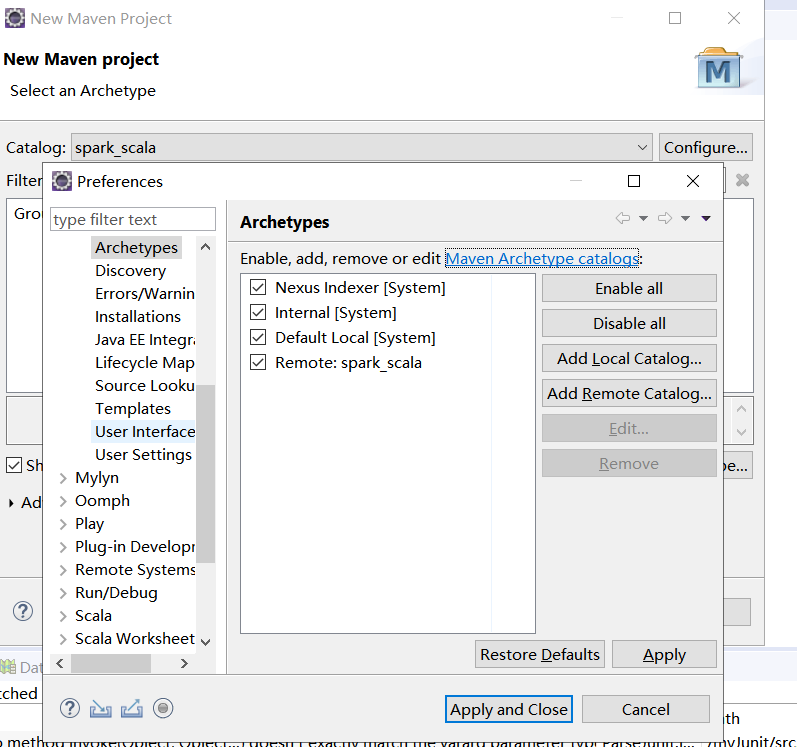

然后 嘿嘿重点来了

到这里maven的建造框架里面进来后点击 add Remote Catalog 这个

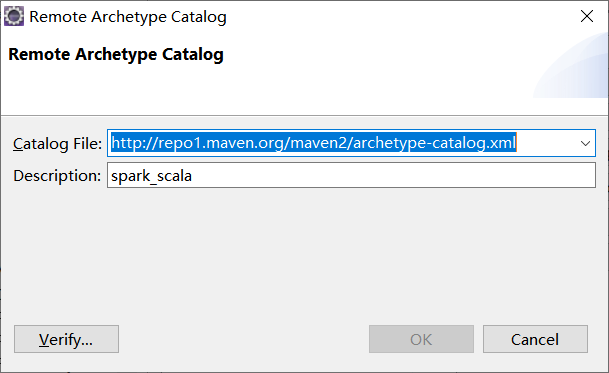

填进去 不慌!

http://repo1.maven.org/maven2/archetype-catalog.xml

spark_scala

要 apply!!!!!!!!

要 apply!!!!!!!!

要 apply!!!!!!!!

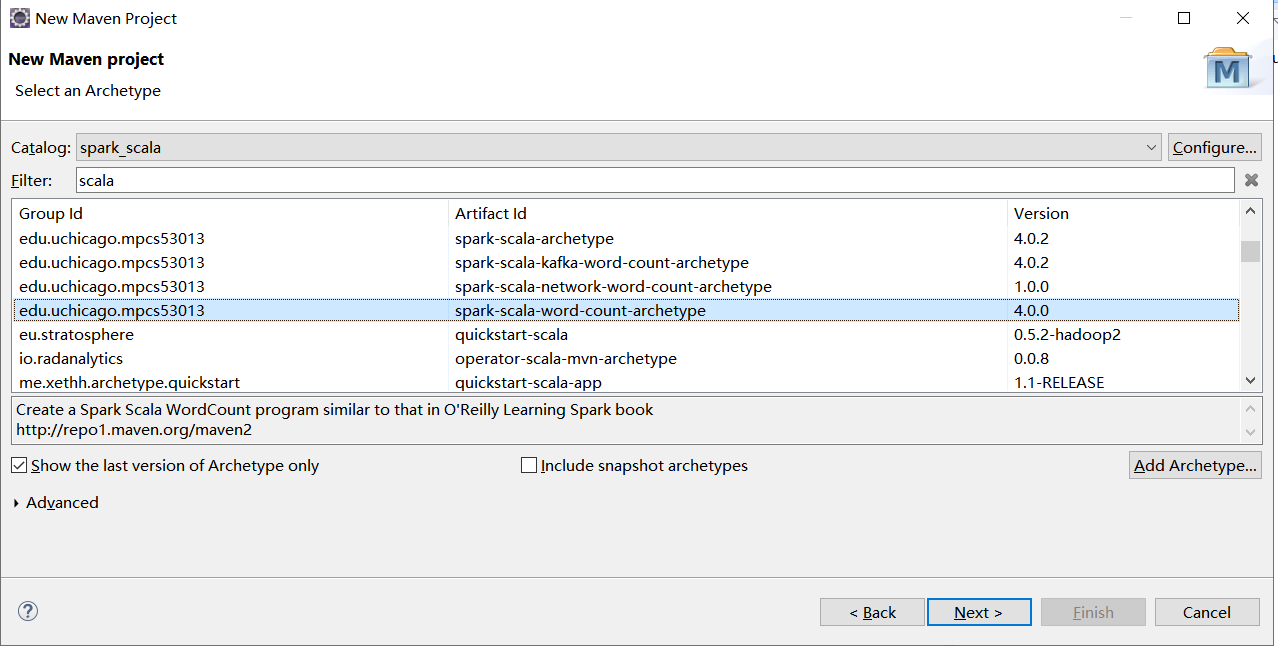

下一步 ps:这一步很慢没办法官网咯…

我下的这个版本的,你们随意,但推荐好吧哈哈

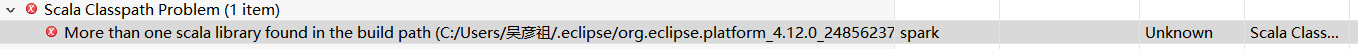

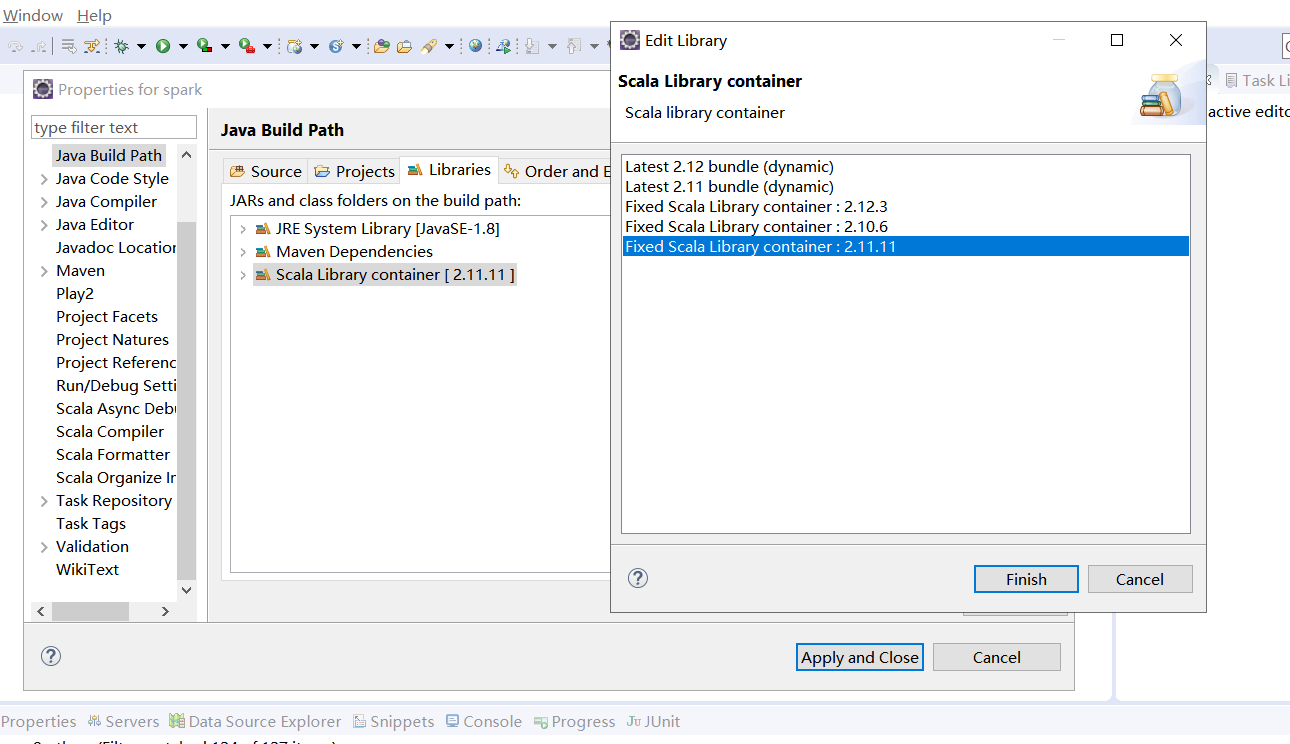

然后你满怀期待的下载完成,结果,第一个项目一建,出来问题

不要慌!

上图上图,直接解决。

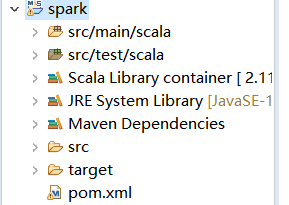

完美实现!

昨天又遇到几个同学一起出现的问题,他们上述操作ok后依然出现了问题,原来是pom.xml这里面下载的包会依赖xx包,然后本机存在xx包就会出现冲突了,所以删除 pom 红色标记错误的地方,update 你的maven项目就可以了

最后

以上就是糊涂哑铃最近收集整理的关于解决maven下Spark与scala的包不兼容问题的全部内容,更多相关解决maven下Spark与scala内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复