最近了解一些大数据知识,自己尝试着搭建hadoop集群,但是遇到了很多坑,总结一下。

hadoop-daemon.sh开启集群,设置了3台虚拟机来当作集群,在master节点通过jps命令查看,看到3台集群的DataNode,NameNode、SecondaryNameNode都已启动,在slave节点通过jps命令查看,每台服务器的东西都启动成功。

但是在图形化界面上看只有一个DataNode,网络上搜索了一下, 有如下原因,就是在以下目录下有一个文件VERSION,如果集群中的每个机器都有这个文件,并且里面datanodeUuid,storageID,clusterID参数都一样会引起DataNode显示不出来

/opt/module/hadoop-2.7.2/data/tmp/dfs/data/current

于是我思考了一下,发现自己在执行hdfs namenode -format命令后还进行了服务器文件同步,这样确实会导致每个服务器的VERSION都是一样的,于是乎,手动把其他虚拟机上的dfs目录删除掉,然后这个时将所有内容重启。

没想到还是不行,还是为空

在google上搜索了一个命令,hdfs dfsadmin -report 这个可以查看datanode节点的信息,没想到查出来的也是空。

然后开始了一步步的排查

1.首先排查几个虚拟机之间是否可以ping通,答案是可以的

2.排查防火墙iptables关闭执行命令chkconfig --list iptables发现防火墙已经关闭

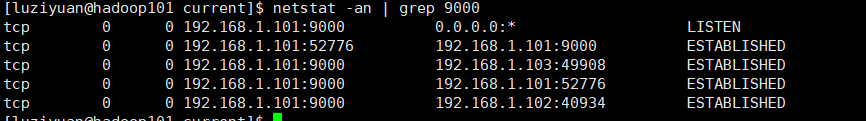

3.查看9000端口netstat -an | grep 9000

以上显示即为正常,如果要是都是127.0.0.1,那么就说明你没有修改ip这个就去修改hosts文件吧。

仔细检查了以上内容发现都没问题,于是有点奇怪

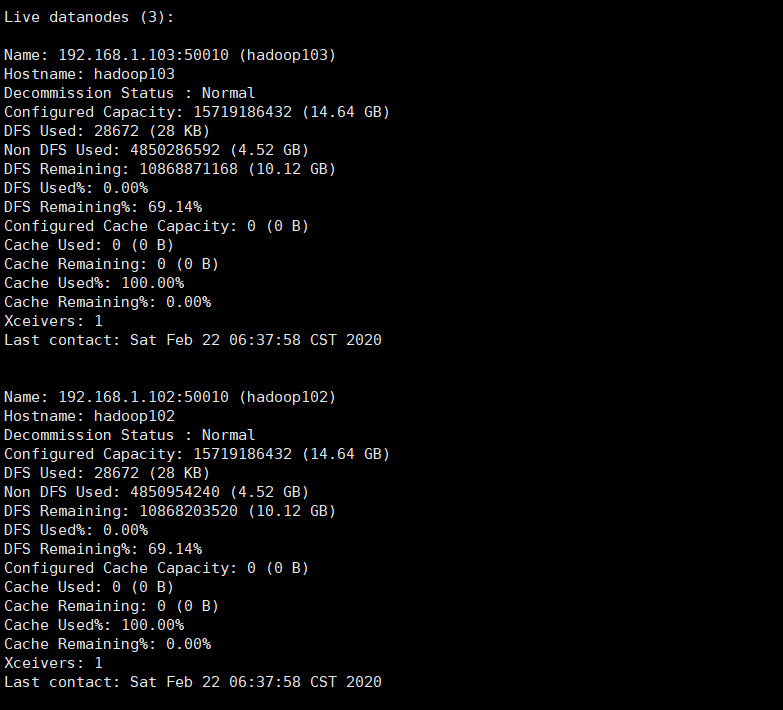

然后又看了一些文档说了ssl会影响集群的建立,突然想到主节点是普通用户启动的,而另外2个节点都是使用root用户启动的,赶紧将另外2个修改为普通用户保证集群中的用户都是同一用户,重新启动,这回执行 hdfs dfsadmin -report发现另外2个datanode也出现在了列表中。

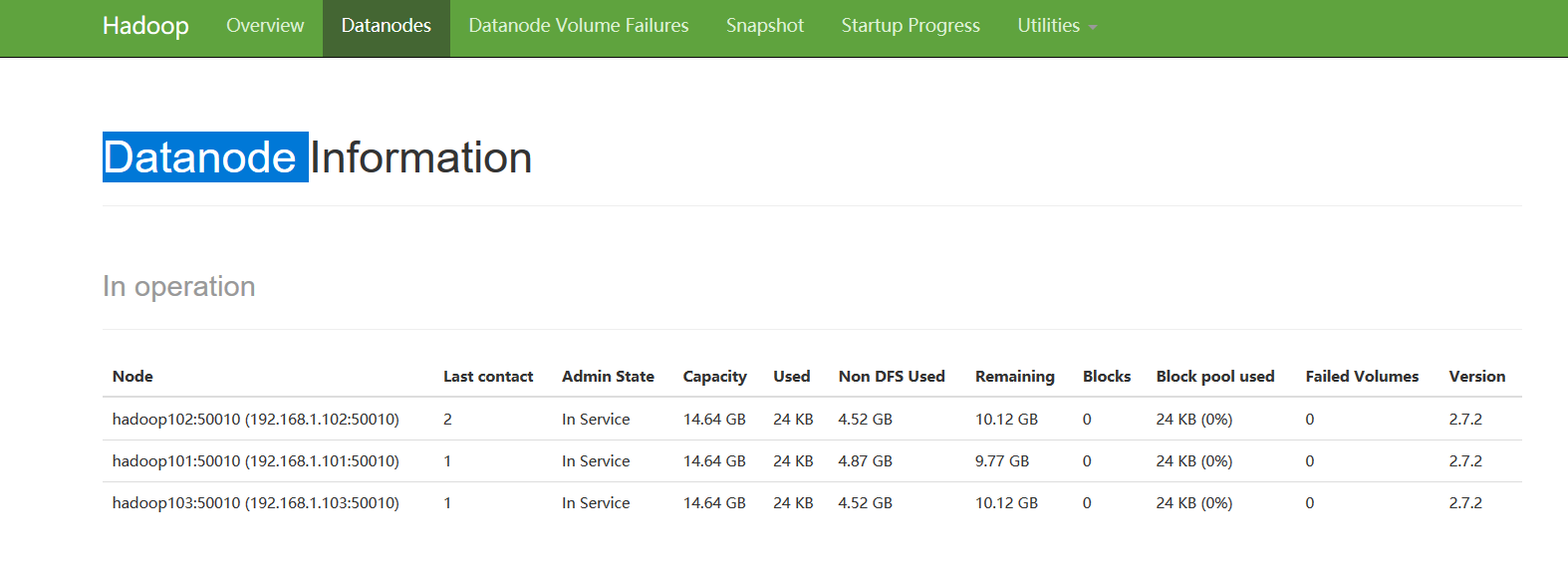

这个时候回到图形化界面发现所有节点都出现了

如果解决了你的问题点个赞吧

最后

以上就是文静棒棒糖最近收集整理的关于hadoop图形化界面上只有一个datanode,集群中其他节点没有显示出来的全部内容,更多相关hadoop图形化界面上只有一个datanode内容请搜索靠谱客的其他文章。

发表评论 取消回复