我是

靠谱客的博主

飘逸柜子,这篇文章主要介绍

BORT 阅读笔记,现在分享给大家,希望可以做个参考。

《Optimal Subarchitecture Extraction For BERT》

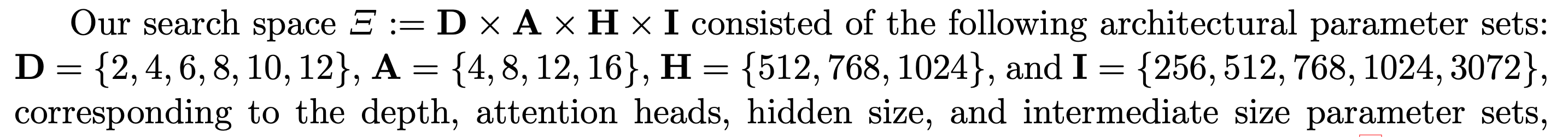

用神经网络搜索的方法寻找一个最优的BERT:

最终寻到的最优BERT:

其中

其中

D是transformer encoder层数

A是attention heads

H是hidden size

I是intermediate layer size

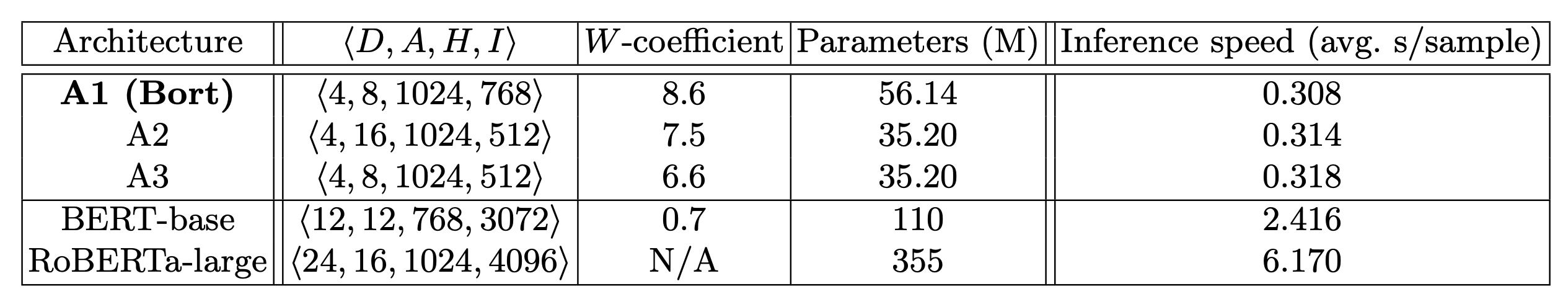

对比了 普通预训练 和 基于蒸馏的预训练(下面第二第三列):

最后

以上就是飘逸柜子最近收集整理的关于BORT 阅读笔记的全部内容,更多相关BORT内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复