我是靠谱客的博主 开放天空,这篇文章主要介绍【Keras】Keras构建LSTM网络时的输入维度问题——可参考博客梳理Keras构建LSTM网络时的输入维度问题——可参考博客梳理,现在分享给大家,希望可以做个参考。

Keras构建LSTM网络时的输入维度问题——可参考博客梳理

keras中的LSTM层:

keras.layers.LSTM(units, activation='tanh', recurrent_activation='sigmoid', use_bias=True, kernel_initializer='glorot_uniform', recurrent_initializer='orthogonal', bias_initializer='zeros', unit_forget_bias=True, kernel_regularizer=None, recurrent_regularizer=None, bias_regularizer=None, activity_regularizer=None, kernel_constraint=None, recurrent_constraint=None, bias_constraint=None, dropout=0.0, recurrent_dropout=0.0, implementation=2, return_sequences=False, return_state=False, go_backwards=False, stateful=False, unroll=False)

- units参数的理解

首先要对这个参数有一个正确的理解,总体而言它指的是一个LSTM Cell内部的神经元数目。不要与时间步数混淆。具体解释可参考下面两篇博文。

(1)keras中LSTM的units是什么意思

(2)Keras中的LSTM - 关于输入shape解释,强推下面第一篇博文,解释的相当简洁明白。

(1)keras:4)LSTM函数详解 - 如果你还是有些不太懂,可以看一下面三篇博文(可按从上至下的顺序查看),其中第二篇和第三篇比较长,有一些其他内容,但第二篇我觉得说的还挺好的。

(1)[LSTM学习笔记2]使用Keras开发LSTM

(2)Keras LSTM教程

(3)一文学会如何在Keras中开发LSTMs(附代码) - 关于LSTM网络后面使用TimeDistributed层封装器,可参考下面这篇博文。

(1)如何在长短期记忆(LSTM)网络中利用TimeDistributed层—python语言

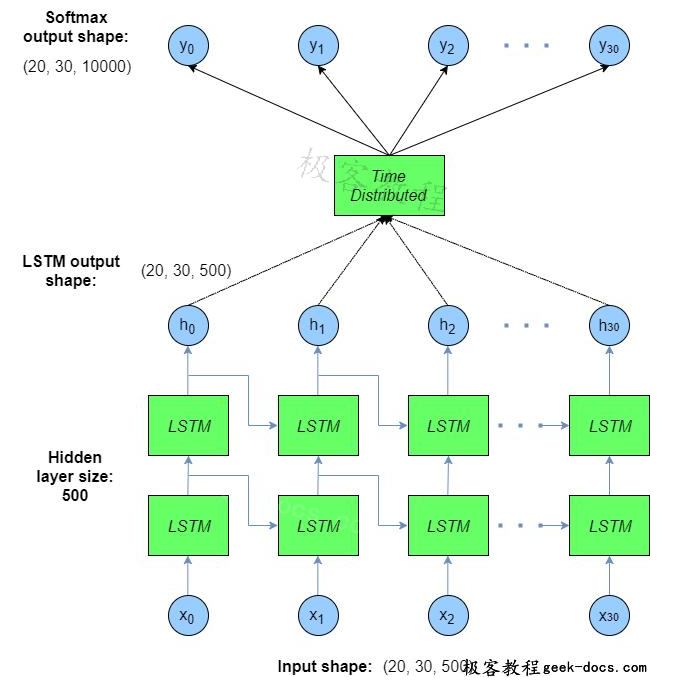

此外,理解的过程中,可以参看下面这张图帮助理解(出自上面第3点中的第二篇)。

- 关于双向RNN的理解,可以参看下面这篇博文。

(1)使用Keras进行深度学习:(五)RNN和双向RNN讲解及实践 - 对于Epoch、Iteration、Batchsize的正确理解,如果想再看一看,可以参考下面的这篇博客。

(1)神经网络中的Epoch、Iteration、Batchsize

最后

以上就是开放天空最近收集整理的关于【Keras】Keras构建LSTM网络时的输入维度问题——可参考博客梳理Keras构建LSTM网络时的输入维度问题——可参考博客梳理的全部内容,更多相关【Keras】Keras构建LSTM网络时内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复