RNN与LSTM原理及其结构应用

- 神经网络ANN(Artificial Neural Network)

- 神经网络定义

- 公式表达

- 逆向参数调整法

- 优缺点

- 解决方案:

- 卷积神经网络

- 循环神经网络

- 批量归一化

- DROPOUT

- 在线自定义神经网络模型链接

- RNN(Recurrent Neural Network)

- 运作原理

- LSTM

- 运作原理

神经网络ANN(Artificial Neural Network)

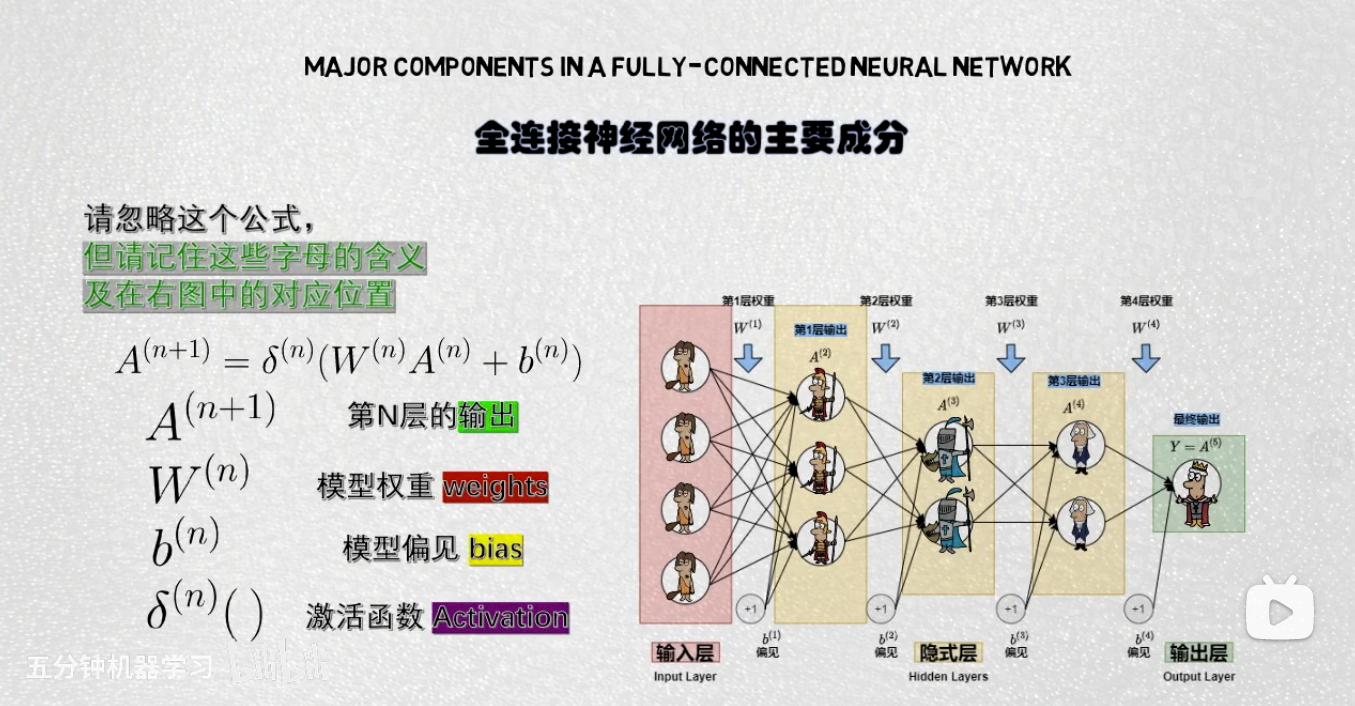

神经网络定义

偏置bias:告诉了加权和得有多大,才能让神经元的激发变得有意义。

偏置bias:告诉了加权和得有多大,才能让神经元的激发变得有意义。

神经元激活函数Activation Function:神经元的信号值是由传输的加权和所决定,激活函数会将该输入信号转化成该神经元的输出值。

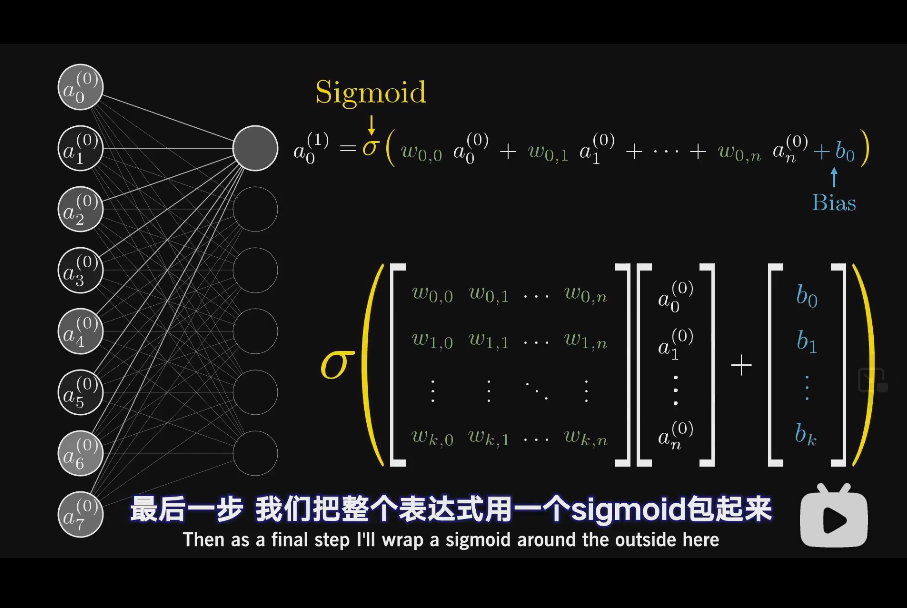

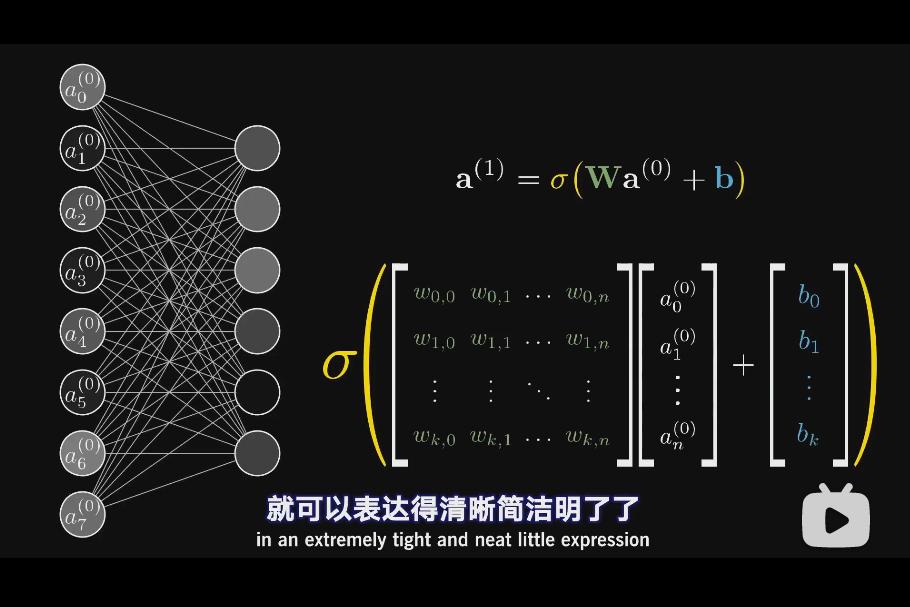

公式表达

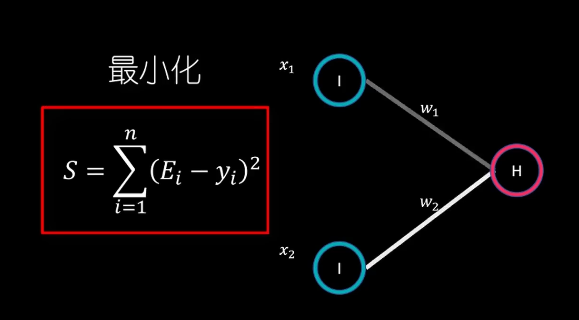

训练目标:利用反向传播,找到合适的模型权重和模型偏见,使得loss最低。

逆向参数调整法

神经网络模型通过训练提高其预测准确度的方法:逆向参数调整法(Back Propagation)

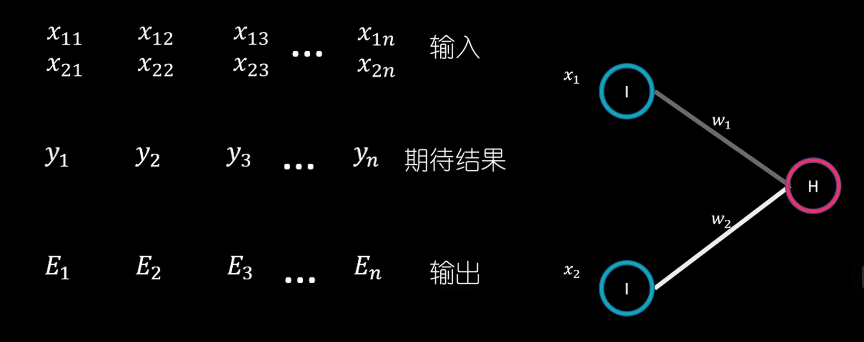

训练的目标就是通过不断调整W1、W2,让Y、E集合的误差平方和最小。

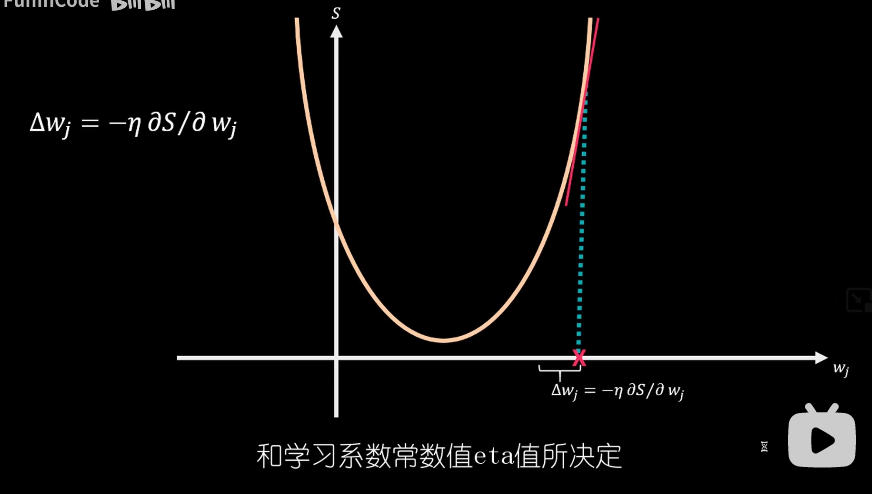

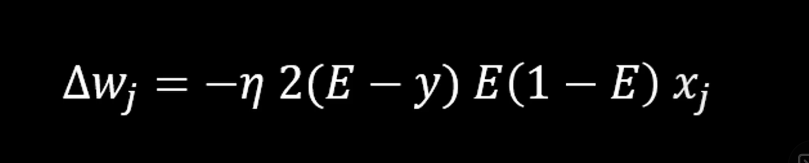

具体调整过程中需要借助连个数学方法:梯度下降法和链式法则。

梯度下降法的核心在于为了求得误差方差平和的极小值,我们要将W权重从初始值逐步移动到误差平方和函数S(W)的导数为0处,每次移动的幅度由S(W)的导数和学习系数常数值eta值所决定。当初始随机W值较大时,其最终输出误差也较大,根据其导数进行计算,初始调整步幅也会较大。

权重调整方法

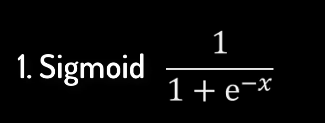

### 激活函数的选择

### 激活函数的选择

-

Sigmoid函数

特点:(1)输出值落于01连续区间 (2)在输入值从横坐标左侧移动到右侧的过程中,其输出值呈现从平缓到加速再到平缓的特点。(3)sigmoid函数的导数值落于0-0.25的连续区间。

特点:(1)输出值落于01连续区间 (2)在输入值从横坐标左侧移动到右侧的过程中,其输出值呈现从平缓到加速再到平缓的特点。(3)sigmoid函数的导数值落于0-0.25的连续区间。 -

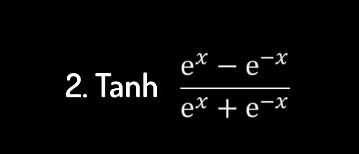

Tanh 函数

特点:(1)输出值落于-1~1连续区间 (2)导数值落于0-1区间,大于sigmoid函数的导数区间,因此相对于sigmoid,能相对缓解梯度消失的问题。

特点:(1)输出值落于-1~1连续区间 (2)导数值落于0-1区间,大于sigmoid函数的导数区间,因此相对于sigmoid,能相对缓解梯度消失的问题。 -

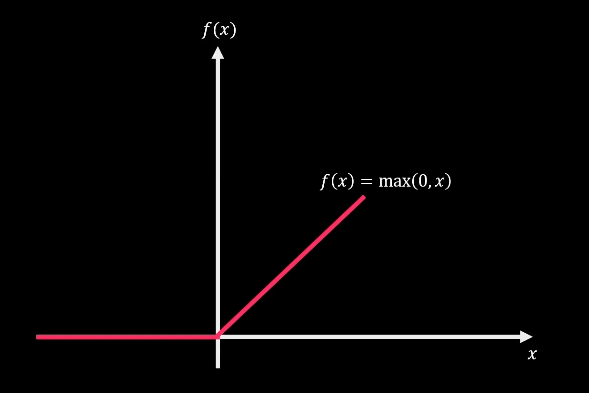

ReLU

特点:(1)通常为隐藏层的激活函数 (2)是非线性函数,在大于0时展现的是线性特征(2)当输入值为负数时,其输出值和导数均为0,神经元处于熄灭状态,且在逆向参数调整过程中不产生梯度调整值。

优缺点

优点:1.是监督类算法 2.层层连接过滤信息,模型内部可用参数多,模型性能出色 3.激活函数是非线性变化的,理论上可以拟合任意分布

缺点:1.参数多意味着训练慢、训练难 2.网络模型对超参数敏感

解决方案:

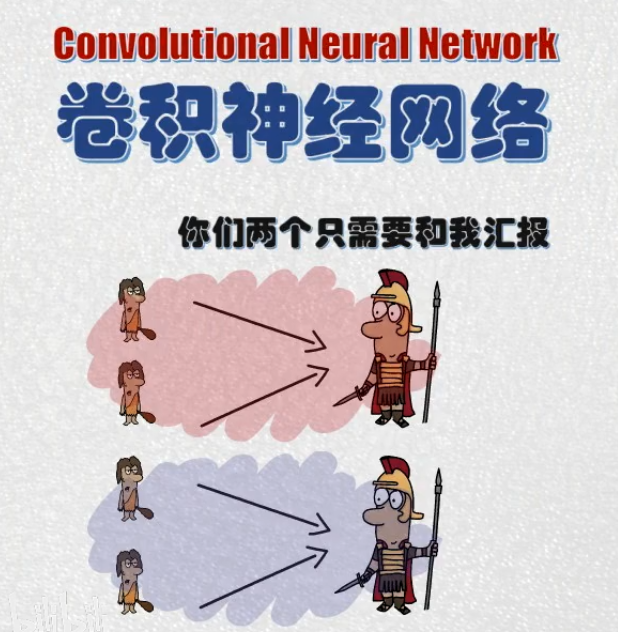

卷积神经网络

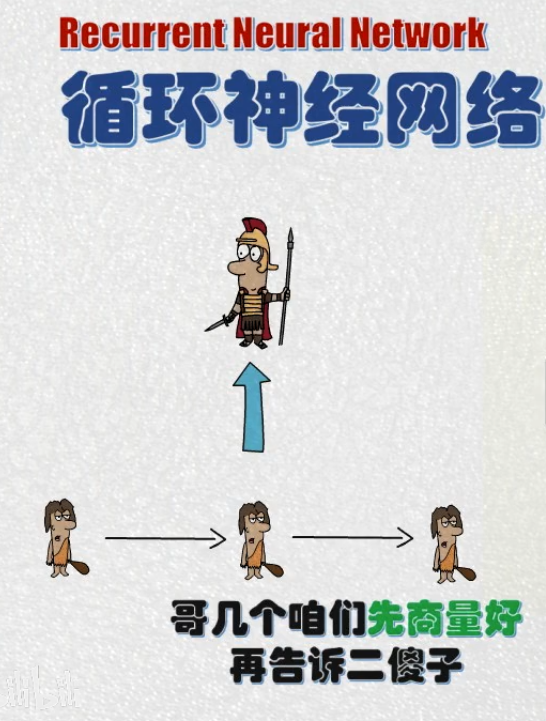

循环神经网络

批量归一化

DROPOUT

在线自定义神经网络模型链接

链接: 在线自定义神经网络模型连接https://playground.tensorflow.org/.

链接: 卷积神经网络-将图片发出声音www.imaginarysoundscape.net

RNN(Recurrent Neural Network)

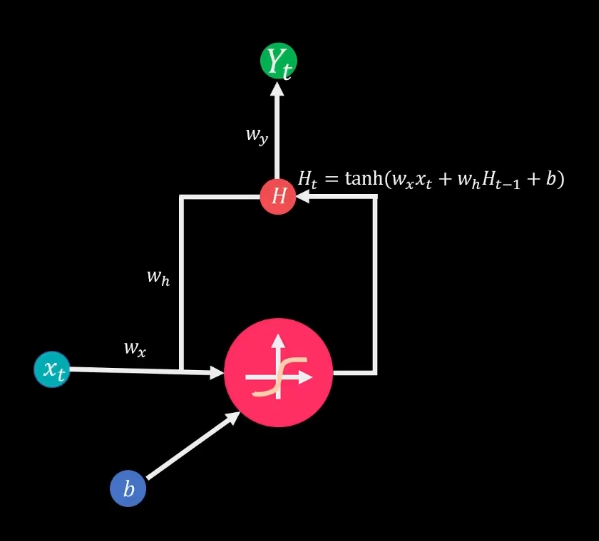

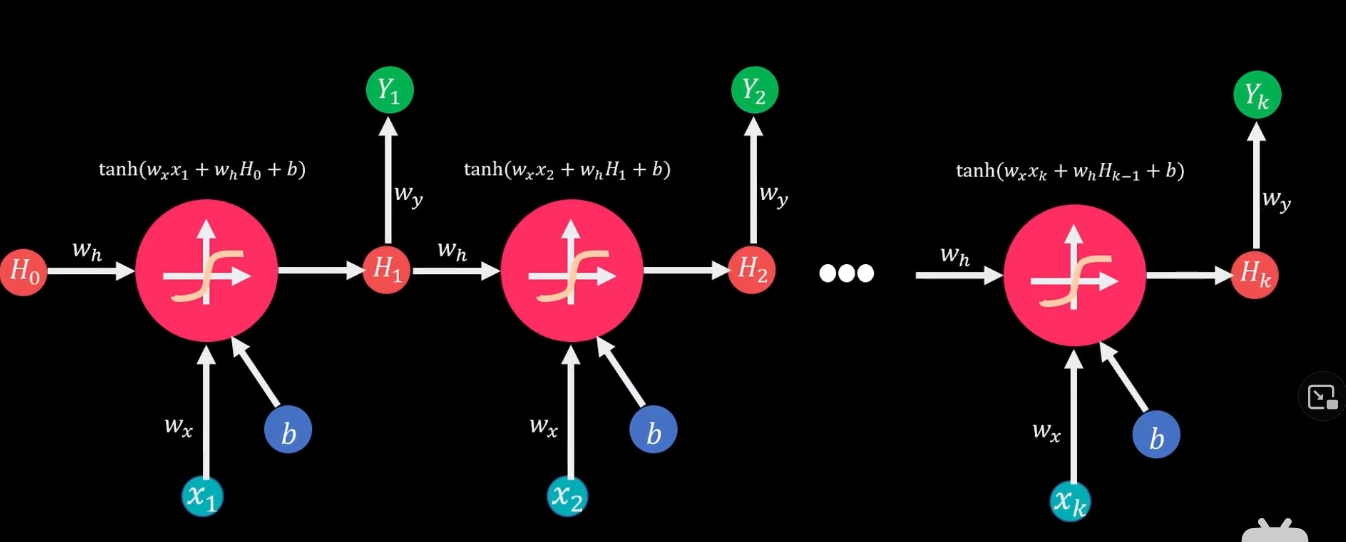

运作原理

RNN模型在每期计算中会同时考虑当期输入值和前期状态值,并利用相同的模型架构循环下去

展开之后:

展开之后:

在时间t,模型输出值Yt取决于两个参数:1.隐藏层要输入层的连接权重Wy 2.当期状态值Ht。

在时间t,模型输出值Yt取决于两个参数:1.隐藏层要输入层的连接权重Wy 2.当期状态值Ht。

输入值Xt和上期的状态值Ht-1通过相应的连接权重Wh和Wx加权相加,在ton过激活函数TanH生成当期的状态值Ht,而Ht在下期计算中又会作为状态输入值和Xt+1一起参与到Ht+1的计算。

RNN会陷入梯度消失和梯度爆炸的问题。

LSTM

运作原理

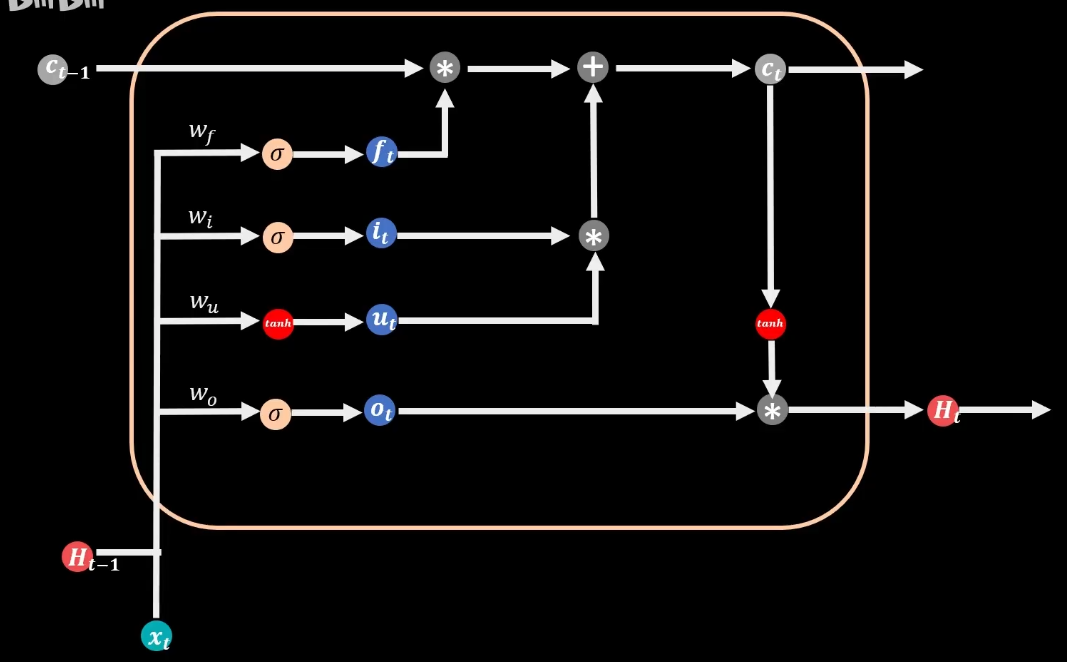

有三个sigmoid函数和2个tanH函数,sigmoid函数返回0到1区间的值,儿tanH返回-1到1之间的值,因此sigmoid函数可以作为闸门,用来控制信息流出的比例,而tanH可以控制信息的增减方向,并把值锁在-1到1的区间。在LSTM模型中,三个sigmoid函数分别管理着三扇闸门,分别是遗忘门、输入门、输出门。与简单CNN模型相比,LSTM增加了记忆状态C这一元素。本期记忆状态值Ct由上期状态值Ct-1通过遗忘门过滤到本期的部分,加上本期新增的部分所决定,上期过滤的部分要依靠sigmoid函数的遗忘门来把关。当遗忘门值为0时,意味着上期记忆完全遗忘,当遗忘门值为1时,意味着上期记忆完全保留。用来更新新增记忆的输入门,sigmoid把握着更新记忆的比例,tanH函数控制着大小和方向,两者相乘得到本期新增的记忆部分,它与前期记忆流入的部分相加,得到当前的记忆状态值,最后来到输出门,输出门的sigmoid函数和当期记忆值Ct的tanH值相乘,得到本期的输出值Ht,Ct和Ht会循环流入至T+1,参与到下期的计算。

有三个sigmoid函数和2个tanH函数,sigmoid函数返回0到1区间的值,儿tanH返回-1到1之间的值,因此sigmoid函数可以作为闸门,用来控制信息流出的比例,而tanH可以控制信息的增减方向,并把值锁在-1到1的区间。在LSTM模型中,三个sigmoid函数分别管理着三扇闸门,分别是遗忘门、输入门、输出门。与简单CNN模型相比,LSTM增加了记忆状态C这一元素。本期记忆状态值Ct由上期状态值Ct-1通过遗忘门过滤到本期的部分,加上本期新增的部分所决定,上期过滤的部分要依靠sigmoid函数的遗忘门来把关。当遗忘门值为0时,意味着上期记忆完全遗忘,当遗忘门值为1时,意味着上期记忆完全保留。用来更新新增记忆的输入门,sigmoid把握着更新记忆的比例,tanH函数控制着大小和方向,两者相乘得到本期新增的记忆部分,它与前期记忆流入的部分相加,得到当前的记忆状态值,最后来到输出门,输出门的sigmoid函数和当期记忆值Ct的tanH值相乘,得到本期的输出值Ht,Ct和Ht会循环流入至T+1,参与到下期的计算。

最后

以上就是糟糕玉米最近收集整理的关于RNN与LSTM原理及其结构应用神经网络ANN(Artificial Neural Network)RNN(Recurrent Neural Network)LSTM的全部内容,更多相关RNN与LSTM原理及其结构应用神经网络ANN(Artificial内容请搜索靠谱客的其他文章。

发表评论 取消回复