StarGAN Based Facial Expression Transfer for Anime Characters 论文阅读

(这篇论文没啥创新意义,主要学习一下数据收集、处理)

关键词:动画、面部表情

主要贡献:

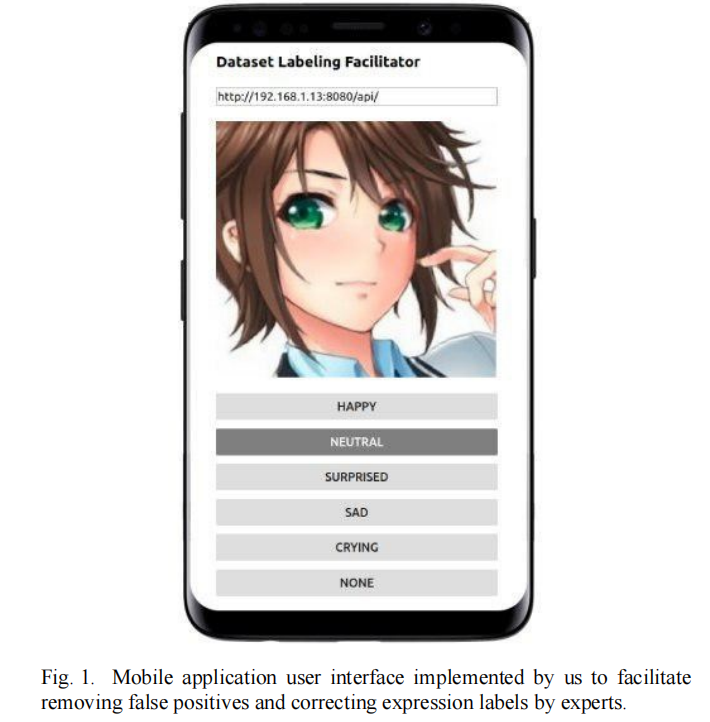

1)提供了一个有标签的数据集,它收集自Danbooru和GetChu,包含5个动画表情(happy、sad、crying、neutral、surprised),每个表情平均有一千张图片。我们还实现了一个开源的可移动应用来加快图片标记和检测假阳性的错误。

2)使用StarGAN作为我们的基本模型来进行面部表情迁移,使用CARN超像素模型对图片进行预处理,我们成功实现动画人物的表情变化。

方法

数据准备

Danbooru:一个免费的图片托管网站,用户可以使用他们自定义标签上传动画图片。

Getchu:提供游戏动画人物的标准图像。

- 我们首先根据使用爬虫工具gallery-dl4从Danbooru将图片和它的标签收集起来,我们在搜索关键词中使用了‘manga’关键词,来限制搜到的图片是彩色图片。

- 我们使用‘lbpcascade animeface’——一个预训练的卡通脸检测器,来检测脸。我们使用启发式图像来丢弃那些有超过6张脸的图片。

- 通过脸部检测器,我们可以知道眼睛、嘴、鼻子的位置。因此我们对图片进行旋转让眼睛的中心能够在同一个水平线。我们使用眼睛之间的距离的1.35倍来选择脸周围的边框。

- 最后,我们手动删除了false positives。

下图为我们专门开发的app:

数据预处理和数据增强

我们从网络中收集的数据大部分都是92px到112px的方形图片。我们使用了CARN超像素框架(放大比例为2)来预处理并提高图片的分辨率,且通过减少噪声来提高图片质量。最后,我们将其放大到224x224的大小,同时使用数据增强(先random crop 192x192的图片,再random flip)。

模型

StarGAN通过在Discriminator内增加一个辅助domain分类器,实现了使用一个GAN进行多个domain之间的映射。

generator:由两个卷积层来下采样、6个残差块,两个转置卷积来上采样。

Discriminator:使用了基于PatchGAN的结构。

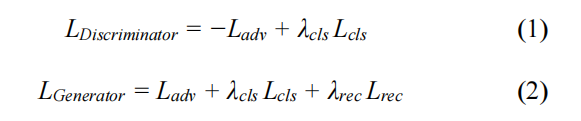

loss:对抗损失、domain分类损失、重建损失。

为了适应我们自定义的数据集,我们对模型做了一些修改(详细见论文)。

评估

250k个迭代,使用一个Nvidia 1080 TI GPU , batch size=16, 训练花了一天多四个小时来完成训练。

最后

以上就是神勇蛋挞最近收集整理的关于论文阅读 StarGAN Based Facial Expression Transfer for Anime Characters方法的全部内容,更多相关论文阅读内容请搜索靠谱客的其他文章。

发表评论 取消回复