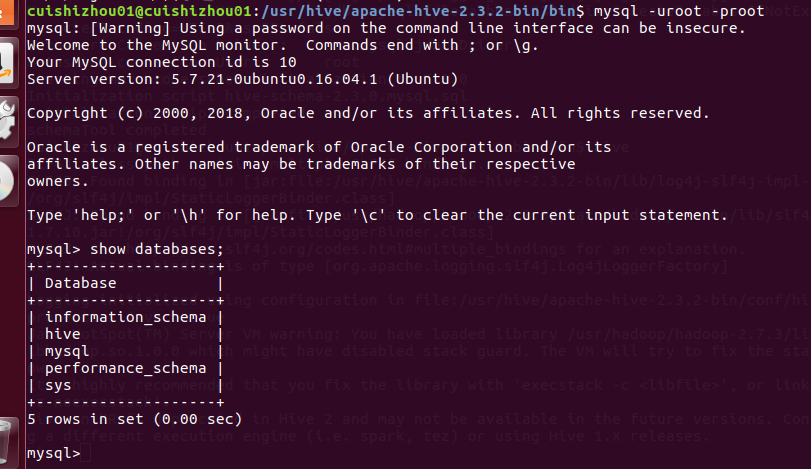

第一步:mysql已经安装好了

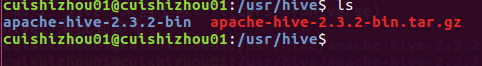

第二步下载hive包并tar开

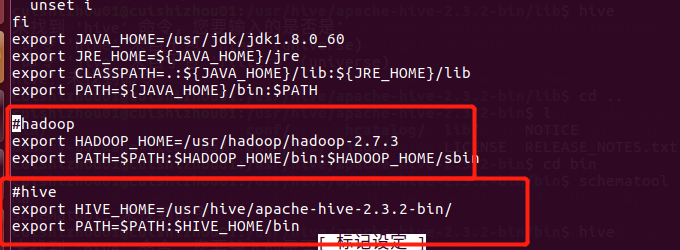

第三步:修改环境变量:

第四步:

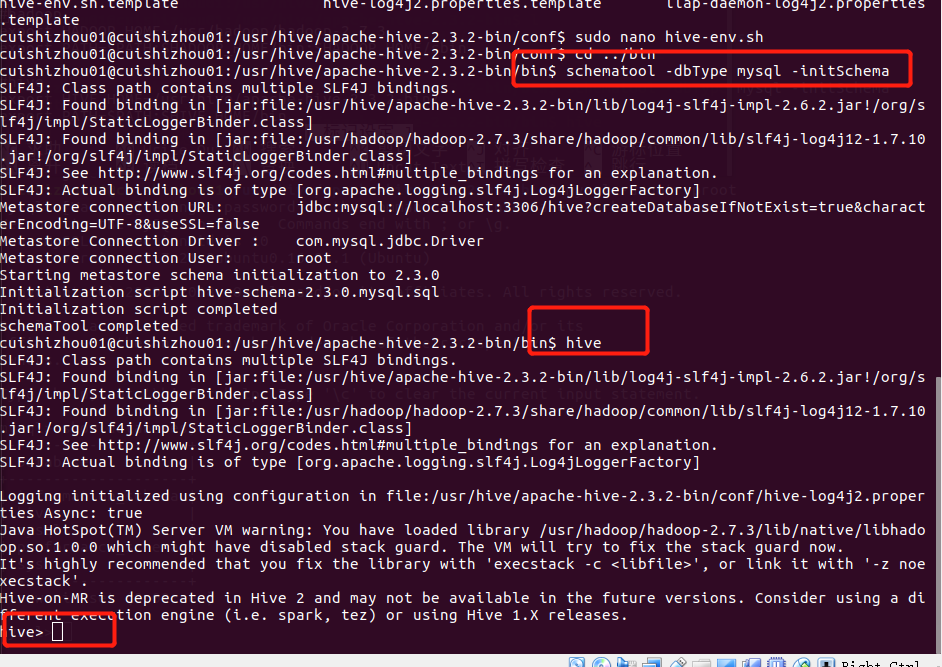

修改Hive的配置文件

到hive 配置文件目录中

cd /home/hadoop/hive-2.1.1/conf/把初始化的文件 复制一份出来 并且改名

cp hive-env.sh.template hive-env.sh

cp hive-default.xml.template hive-site.xml

cp hive-log4j2.properties.template hive-log4j2.properties

cp hive-exec-log4j2.properties.template hive-exec-log4j2.properties修改hive-env.sh

export JAVA_HOME=/usr/lib/jdk1.7.0_79 ##Java路径

export HADOOP_HOME=/home/hadoop/hadoop ##Hadoop安装路径

export HIVE_HOME=/home/hadoop/hive-2.1.1 ##Hive安装路径

export HIVE_CONF_DIR=/home/hadoop/hive-2.1.1/conf ##Hive配置文件路径在hdfs 中创建下面的目录 ,并且授权

hdfs dfs -mkdir -p /user/hive/warehouse

hdfs dfs -mkdir -p /user/hive/tmp

hdfs dfs -mkdir -p /user/hive/log

hdfs dfs -chmod -R 777 /user/hive/warehouse

hdfs dfs -chmod -R 777 /user/hive/tmp

hdfs dfs -chmod -R 777 /user/hive/log修改hive-site.xml

将 hive-site.xml 文件中以下几个配置项的值设置成上一步中创建的几个路径。

<property>

<name>hive.exec.scratchdir</name>

<value>/user/hive/tmp</value>

</property>

<property>

<name>hive.metastore.warehouse.dir</name>

<value>/user/hive/warehouse</value>

</property>

<property>

<name>hive.querylog.location</name>

<value>/user/hive/log</value>

</property>需要在 hive-site.xml 文件中配置 MySQL 数据库连接信息。

<property>

<name>javax.jdo.option.ConnectionURL</name>

<value>jdbc:mysql://localhost:3306/hive?createDatabaseIfNotExist=true&characterEncoding=UTF-8&useSSL=false</value>

</property>

<property>

<name>javax.jdo.option.ConnectionDriverName</name>

<value>com.mysql.jdbc.Driver</value>

</property>

<property>

<name>javax.jdo.option.ConnectionUserName</name>

<value>root</value>

</property>

<property>

<name>javax.jdo.option.ConnectionPassword</name>

<value>root</value>

</property>创建tmp文件

mkdir /home/hadoop/hive-2.1.1/tmp //有的情况需要sudo chmod 777 tmp在配置文件 hive-site.xml 里面

把{system:java.io.tmpdir} 改成 /home/hadoop/hive-2.1.1/tmp/

把 {system:user.name} 改成 {user.name}

5、配置jdbc驱动包

mysql的jdbc 驱动包下载地址:

下载完成后把mysql-connector-java-5.1.30-bin.jar 然后放入 $HIVE_HOME/lib 目录下

6、初始化hive

从 Hive 2.1 版本开始, 我们需要先运行 schematool 命令来执行初始化操作。(bin目录下)

schematool -dbType mysql -initSchema- 1

看到schemaTool completed 则初始化完成

检测hive 是否成功 直接在命令行输入hive即可

hive- 1

最后

以上就是明亮过客最近收集整理的关于hadoop之hive安装的全部内容,更多相关hadoop之hive安装内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复