近日,欧洲计算机视觉国际会议 ECCV 2022(European Conference on Computer Vision)发布了论文录用结果。本届 ECCV 2022论文有效投稿数5803篇,其中1650篇论文中选,录取率仅为28%。

ECCV是国际顶尖的计算机视觉会议之一,每两年举行一次。今年将在10月23日-27日于以色列特拉维夫(Tel-Aviv)举行,并采取线下和线上混合形式召开。

今年,旷视共有20篇论文入选,其中3篇 oral,内容涵盖目标检测、3D重建、图像复原等多个研究方向。以下是论文亮点解读,enjoy~

????

01

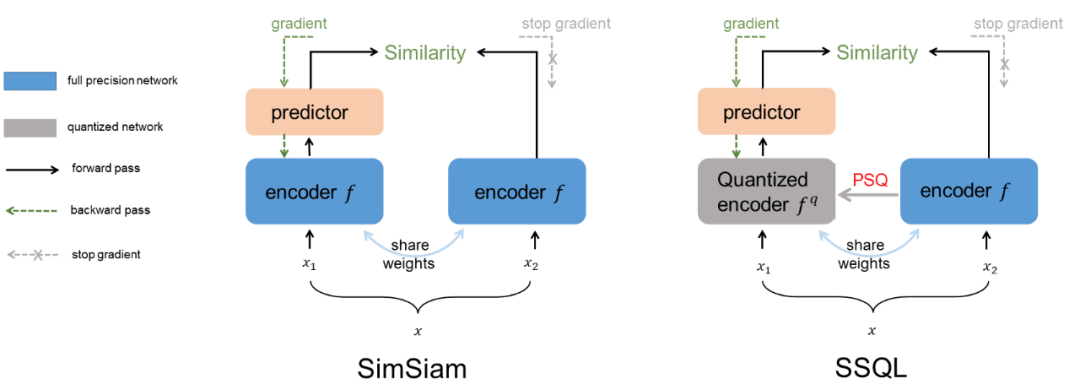

Oral:Synergistic Self-Supervised and Quantization Learning

自监督学习与量化协同互助

自监督学习由于可以避免对大量数据标注的需求,已成为当前学界和工业界的关注重点。 但将当前的自监督模型经由低比特量化实现部署时,发现模型精度出现严重下降, 限制它们在资源受限场景下的应用。为改善该现象, 论文中提出一种自监督学习和量化协同互助的方法(SSQL)来赋予自监督预训练模型量化友好的性质。SSQL 不仅在量化到不同比特时能显著改善模型精度,同时在多数实验中浮点模型原始精度也得到了进一步提升。SSQL只需要训练一次且不需要引入额外的模型参数就可以实现模型具备量化到不同位宽的能力。

????关键词:self-supervised learning, quantization, pretrained, once-for-all

02

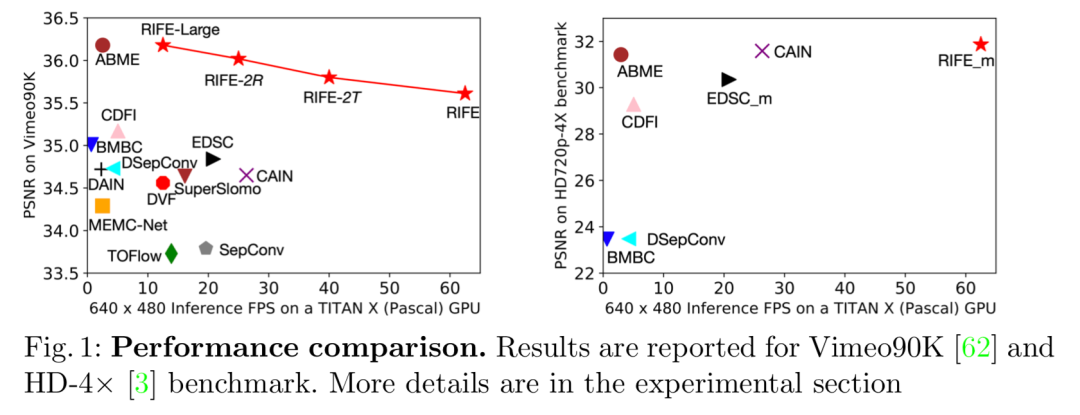

Real-Time Intermediate Flow Estimation for Video Frame Interpolatio

视频插帧中的实时中间流估计

视频插帧算法被广泛用于视频处理、多媒体播放器和显示设备上。本文提出了一种基于实时中间流估计的视频插帧算法 RIFE,包括一个端到端的高效的中间流估计网络 IFNet ,以及基于特权蒸馏的光流监督框架。RIFE 支持在两帧之间的任意时刻点插帧,在多个数据集上达到了最先进的性能且不依赖于任何的预训练模型。相比目前流行的 SuperSlomo 和 DAIN 技术,RIFE 实现了 4 至 27 倍的加速且取得更好的视觉效果。通过调制 IFNet 的时间编码输入,RIFE 还能支持包括动态场景图像拼接等应用。RIFE 相关代码已开源( https://github.com/megvii-research/ECCV2022-RIFE ),并被 Flowframes,SVFI,SVP 等视频处理软件应用。

RIFE 在处理速度上具有显著优势,如下图,横轴是每秒能处理的视频帧数,纵轴是质量指标。

????关键词:光流估计,视频增强

03

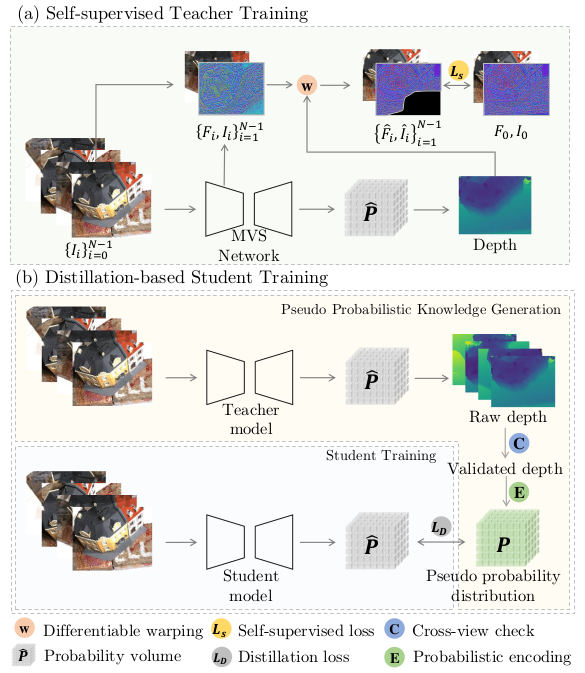

KD-MVS: Knowledge Distillation Based Self-supervised Learning for Multi-view Stereo

KD-MVS: 基于知识蒸馏的自监督多视图立体网络训练方法

自监督多视图立体重建方法在重建质量方面取得了显著进展,但面临着收集大规模真实深度标签的挑战。在本文中,我们提出了一种新的基于知识蒸馏的 MVS 自监督训练方法,称为 KD-MVS ,主要包括自监督教师训练和基于蒸馏的学生训练。具体来说,教师模型使用光度和特征度量的一致性以自监督的方式进行训练。然后通过概率知识转移将教师模型中的知识蒸馏到学生模型中。在验证知识的监督下,学生模型能够大大优于教师。在多个数据集上进行的大量实验表明,我们的方法甚至可以优于监督方法。

????关键词:MVS,自监督学习,知识蒸馏MVS,

自监督学习,知识蒸馏

04

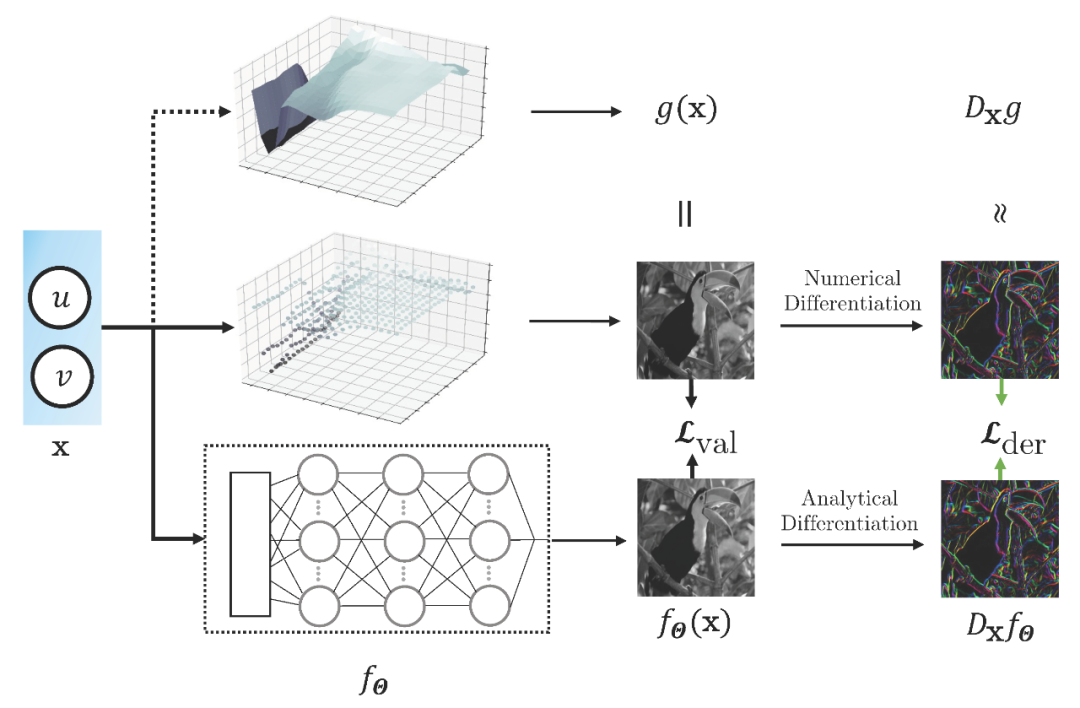

Sobolev Training for Implicit Neural Representations with Approximated Image Derivatives

基于近似图像梯度的隐式神经表达的索伯列夫训练

近几年来,用神经网络进行参数化的隐式神经表达 (INRs) 成为一种有效的信号表示方式,相对于传统离散化的信号表示方式,隐式神经表达具有连续、可微分的性质。然而,目前隐式神经表达的训练范式均是基于“输入坐标-信号值”,并没有利用信号导数值,导致隐式神经表达的泛化能力较差。本文提出了一种基于“输入信号-信号值-信号导数值”的训练范式,能够将信号的值和导数值均编码进网络权重中。本文在图像回归和逆向渲染两个任务上应用了该训练范式,结果表明该训练范式能够有效提高隐式神经表达的数据有效性和泛化能力。

????关键词:隐式神经表达,梯度监督,周期激活函数

05

W2N: Switching From Weak Supervision to Noisy Supervision for Object Detection

W2N: 一种将弱监督信号转化为噪声监督信号的目标检测方法

弱监督物体检测任务(WSOD)旨在仅利用图像级别的类别标签来训练一个检测器。几年来,一些弱监督检测方法试图从原始的 WSOD 模型中挑选高质量的伪标注来提升模型性能。然而,这些方法仅仅根据图片级的线索,简单的将带有伪标注的训练集数据集划分为有标签集和无标签集,而忽略了每一个检测框的分类信息和定位信息,因此信息没有得到充分利用。在本工作中,我们提出将弱监督信号转化为带噪监督信号的目标检测算法(W2N),该算法包含两个迭代训练的子模块。我们的算法充分考虑了每一个检测框具有的信息,并提出了一个正则化损失来缓解WSOD会集中注意到"discriminative part"的问题。实验结果显示,我们的方法在 PASCAL VOC, COCO 等数据集上都达到了 SOTA 。

????关键词:目标检测,弱监督目标检测,带噪学习

06

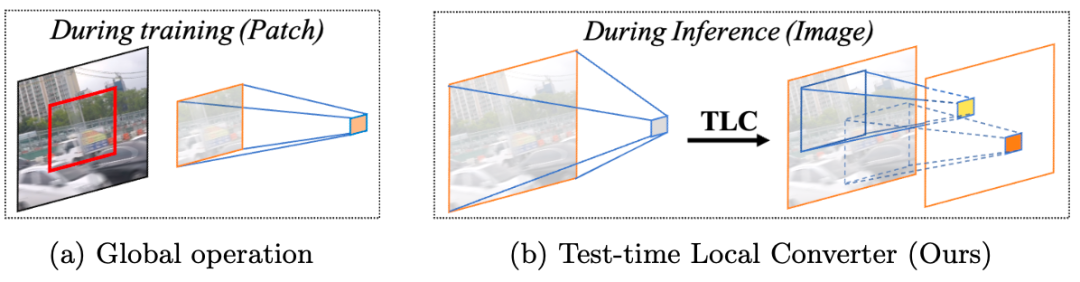

Improving Image Restoration by Revisiting Global Information Aggregation

通过重新审视全局信息聚合来改善图像修复效果

本文揭示了图像复原任务中全局操作的训练-测试不一致现象:训练时基于裁切图像的全局信息分布和推理时基于全图的全局信息的分布并不一致。为了缓解不一致性对性能的负面影响,本文提出了测试时局部转换器:在模型推理时将操作的信息聚合范围从全局(整个空间维度)转换为局部窗口。该方法无需任何微调,可以直接应用于已有模型并提升其在多种图像恢复任务上的性能。例如,该方法将 Restormer 在 GoPro 图像去模糊数据集的 PSNR 从 32.92dB 提高到 33.57dB 。代码已开源:https://github.com/megvii-research/TLC。

????关键词:图像复原、全局信息聚合、

训练与测试不一致性

07

Simple Baselines for Image Restoration

图像复原的简单基线

本文揭示了使用简单的模型结构也能达到图像复原多个任务的世界领先性能:很多复杂的设计可能不是必须的。与此同时,本文揭示了甚至连传统的激活函数(ReLU, GELU, Sigmoid 等等)都是非必须的——可以直接由点乘操作代替。在计算复杂度只有之前最佳方法 8.4% (去模糊任务)和 47%(去噪任务)的情况下,在 PSNR 指标上分别超越之前最佳方法 0.38 dB / 0.28 dB。代码已开源在https://github.com/megvii-research/NAFNet。

????关键词:图像复原,图像降噪,图像去模糊,底层视觉

08

Revisiting the Critical Factors of Augmentation-Invariant Representation Learning

重新探索基于增广不变特征学习框架中的关键因素

本文探索了自监督领域基于增广不变特征学习框架中的关键因素。我们建立了 MoCo 和 BYOL 公平对比的 benchmark ,详细研究了预训练模型设计的关键因素对模型在上游和下游任务上的性能影响,主要有以下几个结论:更复杂的模型设计可以提高上游任务的性能,但 linear evaluation 对下游性能没有指示性;在上下游使用不匹配的训练器会影响下游任务的性能。由此,我们提出了简单有效的 NormRescale 来解决这个问题;BYOL 的非对称设计移植到 MoCo 上能够提高上游结果,但会影响下游长尾分类任务的性能。我们希望这项研究能为自监督模型设计带来启发。

????关键词:自监督,对比学习,图像表征学习

09

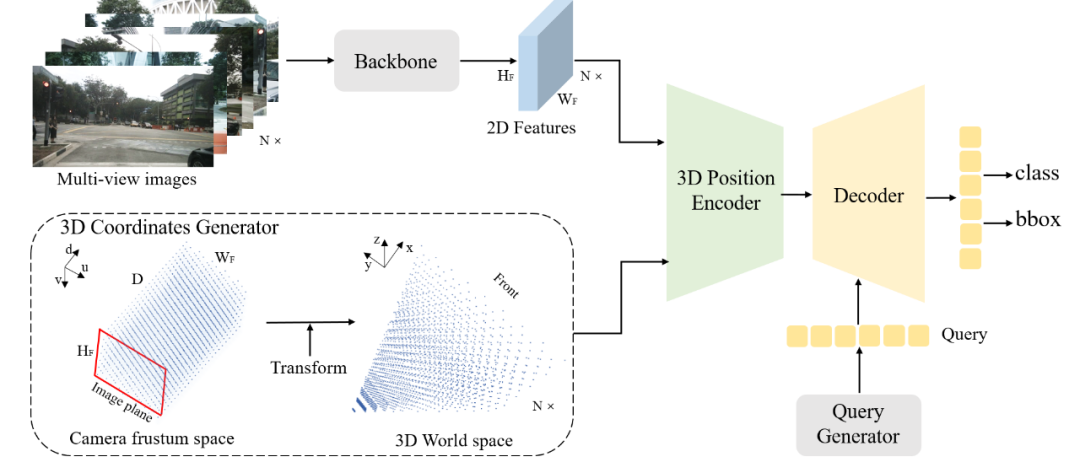

PETR: Position Embedding Transformation for Multi-View 3D Object Detection

基于3D位置编码的多视角3D目标检测

在自动驾驶中,如何基于环视相机进行纯视觉 3D 目标检测是一项大的挑战。目前的方法可以分为把多视角 2D 图像特征投影到 3D 空间和从 3D 空间向 2D 特征上采集特征两种思路,这两类方法均不可避免的会涉及到特征的空间转换,不利于实际应用部署。在这篇文章中,我们提出了 3D 位置编码的概念,将相机成像时的视锥空间转换成 3D 位置编码,与 2D 特征直接相加得到 3D 位置相关的特征。得益于上述转换,只需一个 Transformer 解码器便可简单高效地完成 3D 检测任务,端到端地得到 3D 空间下的检测结果。PETR 在 Nuscenes 数据集上取得了 44.1% mAP 和 50.4% NDS 的优异表现,成为领域内第一个在 NDS 指标上达到 50%+ 的纯视觉方法,相关代码已开源在 https://github.com/megvii-research/PETR。

????关键词:3D位置编码,Transformer,

多视角,3D目标检测

10

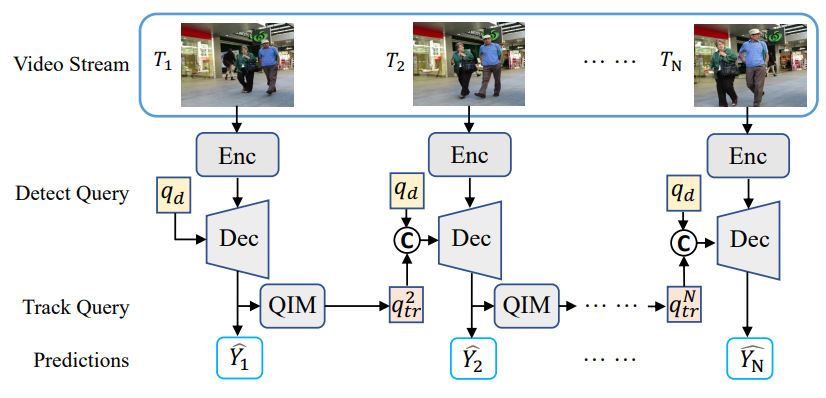

MOTR: End-to-End Multiple-Object Tracking with TRansformer

基于Transformer的端到端多目标追踪框架

在多目标追踪中,对目标进行时序建模是一个关键性挑战。已有方法往往利用物体运动、外观的先验对目标进行追踪,而利用这些先验所进行的后处理,阻碍了对视频序列中时序的端到端探索。在本文中,我们提出了多目标追踪框架 MOTR ,其扩展于 2D 检测框架 DETR ,并引入追踪向量的概念,实现对所追踪目标的建模。追踪向量随着时间的进行,会被逐帧更新并用于迭代式的预测。我们提出了追踪敏感的标签分配策略对追踪目标、新生目标的训练,同时提出了时序聚合网络、群体平均损失函数,强化对时序的建模。在 DanceTrack 数据集上,MOTR 在 HOTA 指标上显著优于此前的 SOTA 方法 ByteTrack ,优势达到 6.5% 。而在 MOT17 数据集上,MOTR 在连接性能方面超过了同期的 TransTrack、TrackFormer 等基于 Transformer 的方法。MOTR 可以作为一个面向时序建模、基于 Transformer 类研究的强大基线。代码已开源在https://github.com/megvii-research/MOTR。

????关键词:多目标追踪、端到端、Transformer

- 上篇完 -

技术信仰,价值务实

下篇中我们将继续分享入选论文摘要集锦

敬请期待哟!

最后

以上就是独特母鸡最近收集整理的关于ECCV 2022 旷视入选论文亮点解读(上)的全部内容,更多相关ECCV内容请搜索靠谱客的其他文章。

发表评论 取消回复