音视频基本概念

一、音频

声音是通过空气传播的一种连续的波,即声波,是连续的模拟信号,称为模拟声音信号。音频信号是人可以听到的频率范围的信号,一般为20Hz-20KHz。计算机要对其进行处理,必须将它转换为数字声音信号(用二进制表示的数字)。

1. 声音信号的数字化步骤:采样、量化和编码:

采样:把时间连续的模拟信号在时间轴上离散化,在某些特定的时刻获取声音信号幅值,其时间间隔称为采样周期,倒数为采用频率;

量化:把采样后连续取值的每个样本转换为离散值表示,即对样本进行A/D转换(模数转换);量化后的样本用二进制数来表示,二进制位数即为量化精度(如用1个字节表示,样本的取值范围是0-255,则精度是1/256);

编码:以上处理后得到的数字形式的信息,为了便于存储、处理和传输,进行压缩处理。

2. 数字声音的主要参数:

采样频率:表示每秒内采样的次数,常用为44.1KHz、22.05KHz、11.05KHz;

量化位数:度量声音波形幅度的精度,一般为8位、12位或16位;

声道数目:N声道一次产生N组声音波形数据(基于不同的位置)。

如果一段10s的音频,其采用频率是44.KHz,量化精度是16位,采用双声道,则其数据量为44.1Kx16bx2x10s。

二、图像

1. 颜色的相关概念:

颜色是创建图像的基础,通过光被人们感知,不同物体受光线照射后,一部分光线被吸收,其余的被反射,被人的眼睛接受并被大脑感知,称为我们所见的色彩。表示一颜色光的度量采用三个物理量:色调(颜色,如红、黄等)、饱和度(深浅程度,如粉红、深蓝等)和亮度(明暗程度)。

从理论上讲,任何一种颜色都可以用三种基本颜色按照不同的比例混合得到,也就是三原色原理(红、绿和蓝)。

彩色模型是用来精确标定和生成各种颜色的一套规则和定义;RGB颜色模型、CMY颜色模型和YUV彩色模型。

RGB彩色模型:是工业界的一种颜色标准,是通过对红R、绿G、蓝B三个颜色通道的变化及他们相互之间的叠加来得到各式各样的颜色的,如彩色荧光屏通过发射三种不同强度的电子束,使屏幕内侧覆盖的红、绿、蓝光粉受激发光而产生各种不同的颜色。

YUV彩色模型:是被欧洲电视系统所采用的一种颜色编码方法,在现代彩色电视系统中,通常采用三管彩色摄像机或彩色CCD摄像机进行取像,然后取得的彩色图像信号经分色、分别放大矫正后得到RGB,在经过矩阵变换得到亮度信号Y和两个色差信号B-Y(即U)、R-Y(即V),最后发送端将亮度和色差三个信号分别进行编码,用同一个信道发送出去。这种色彩的表示方法就是YUV色彩空间表示,其重要性是它的亮度信号Y和色度信号UV是分离的。

2. 图形和图像:

图形:用矢量表示的图形,一般是工程作图等;

图像:用像素点描述的图,一般是摄像机和扫描仪等输入设备捕捉的实际场景。其属性一般包含分辨率、像素深度、图像表示法和种类等。

像素深度:是指存储每个像素所用的二进制位数。如一幅图像的图像深度是a位,则该图像的最多颜色数或灰度级为2的a次幂种。

分辨率:分为显示分辨率和图像分辨率;显示分辨率是指显示屏上能够显示出的像素数目(如手机屏幕是1080p,意思是手机屏幕上的像素点数目是1920X1080),图像分辨率是指组成一幅图像的像素密度,即每英寸多少个像素点(DPI,200dpi的设备扫描2x2.5英寸的彩色图片,得到图片的像素个数是400x500)。

3. 图像的获取:

将现实世界的景物通过物理设备输入到计算机的过程可以成为图像的获取。如用数码相机或数码摄像机进行拍照和录像。

一幅彩色图像可以看做二维连续函数f(x,y),将其变换为离散的矩阵表示,同样包含采样、量化和编码的数字化过程。

采样:分别在x和y轴上根据图像分辨率进行周期性采样,获得色彩值(亮度和色彩信息,会量化为像素点),假如DPI是200,获取2X2.5英寸的彩色图像,则采用后的像素矩阵大小是400X450,矩阵中的每个值代表一个像素点。

量化:对扫描得到的离散的像素点对应的连续色彩值进行A/D转换,每个采样点用N位的二进制表示;图像的数据量=总像素数x图像深度,入一幅400x450的256色图像大小是400x450x8b。

编码:把离散的像素矩阵按一定方式编成二进制码组,最后把得到的图像数据按某个图像格式记录在图像文件中;编码技术主要包括有损压缩和无损压缩,目前使用最广泛的压缩编码标准是JPEG标准;常用的图像文件格式有.jpeg、.png、.bmp、.gif等。

三、视频

1.数字视频信息

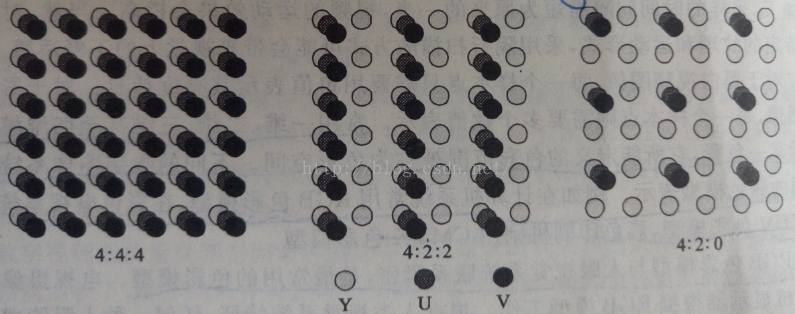

是指活动、连续的图像序列,一幅图像称为一帧,帧是构成视频信息的基本单元。数字视频使用的彩色模型是YCbCr,此模型接近YUV模型,Cb代表蓝色差,Cr代表红色差信号,由于人眼对色度信号的敏感程度远不如对亮度信号敏感,所以色度信号的采样频率可以比亮度信号的取样频率低一些,以减少数字视频的数据量,这种方式称为色度子采样。目前常用的色度子样模式是

4:4:4,指每条扫描线上每4个连续的采样点取4个亮点样本Y、4个色度样本Cr和4个色度样本Cb,这就相当于每个像素都用3个分量样本表示;

4:2:2,指每条扫描线上每4个连续的采样点取4个亮点样本Y、2个色度样本Cr和2个色度样本Cb;

4:1:1,指每条扫描线上每4个连续的采样点取4个亮点样本Y、1个色度样本Cr和1个色度样本Cb;

4:2:0,指在水平和垂直方向上每2个连续的取样点上取2个亮度样本Y、1个色度样本Cr和1个色度样本Cb,即对2X2点阵的4个采样点采样4个亮度样本和各1个色度样本;H.261、H.263和MPEG-1视频标准均使用这种取样格式。

2. 视频压缩编码

数字视频信息的数据量很大,如每帧1280x720像素点,图像深度为16位,每秒30帧,则每秒的数量量高达1280x720x16x30/(8x1024x1024)=52.7MB。为了解决此问题,必须对数字视频信息进行压缩编码:帧内压缩和帧间压缩。

帧内压缩:也称为空间压缩,近考虑本帧的数据,即把单独的图像帧当做一个静态图像进行压缩,如M-JPEG编码;

帧间压缩:视频具有时间上的连续特征,可以利用帧内信息冗余,即视频数据的连续前后两帧具有很大的相关性,或者说前后两帧信息变化很小的特点实现高效的数据压缩,通常采用基于运动补偿的帧间预测编码技术。

帧的种类分为I帧、P帧和B帧,I帧是关键帧只采用帧内压缩技术,在视频快进时只能寻找I帧;P帧是基于上一个I帧或者P帧的差异采用帧间压缩获得的帧;B帧是双向两个帧采用帧间压缩获得的帧。编码时选定一个I帧,基于此I帧生成一个P帧,然后在此IP帧中间插入若干个B帧,其存储顺序为IPBBB,在播放时正常的顺序是IBBBP。

3.视频文件格式:

.avi,.mp4,.rm/.rmvb,.mov等。

一个Frame可能包含多个Sample:一般每个视频帧中只包含一个视频采样,而音频帧中包含多个音频采样。帧率常用在视频方面,采样率常用在音频方面。

1个AAC帧包含1024个采样,如果其采样率是48KHz,则每个音频帧的播放时间=1024*(1/48000)= 0.0213s,即21.3毫秒,帧率是48000/1024。

四、字幕

根据字幕的存放方式可以把内嵌字幕(硬字幕)和外挂字幕(软字幕)。

1. 内嵌字幕(硬字幕)

把字幕文件和视频流压制在同一组数据里,像水印一样,无法分离。特点是兼容性好,对一些播放器无需字幕插件需求;缺点是,修正难度大,一旦出错必须整个视频文件重新制作,因为无法分离,限制了用户对字体风格个人喜好的修改。

2.外挂字幕(软字幕)

把字幕文件单独保存为srt、ASS,SSA或SUB格式,只需与视频文件名相同,播放时自动调用,也可用MKV进行封装;缺点是,需要字幕插件支持,一些播放器在某些配置下无法渲染;优点是,修正便捷,可以随意修改字体风格等。

最后

以上就是舒适电话最近收集整理的关于音视频基本概念的全部内容,更多相关音视频基本概念内容请搜索靠谱客的其他文章。

发表评论 取消回复