Dual Attention Network for Scene Segmentation

摘要

在本文中,我们通过基于自注意力机制捕获丰富的上下文相关性来解决场景分割任务。与以前的通过多尺度特征融合捕获上下文的工作不同,我们提出了双重注意力网络(DANet),以自适应地将局部特征与其全局依赖性相结合。特别, 我们在扩张的FCN之上附加了两种类型的注意力模块,分别对空间和通道维度的语义相互依赖性进行建模。位置注意模块通过所有位置上的特征的加权和选择性地聚合每个位置上的特征。相似的特征将彼此相关,而与它们之间的距离无关。同时,通道注意力模块通过以下方式有选择地强调相互依存的通道图:整合所有通道图之间的关联特征。我们将两个注意力模块的输出求和,以进一步改善特征表示,这有助于更精确的分割结果。我们在三个具有挑战性的场景分割数据集(即Cityscapes,PASCAL Context和COCO Stuff数据集)上实现了最新的分割性能。在Cityscapes测试集上平均IoU达到81.5%。代码地址https://github.com/junfu1115/DANet/

1.简介

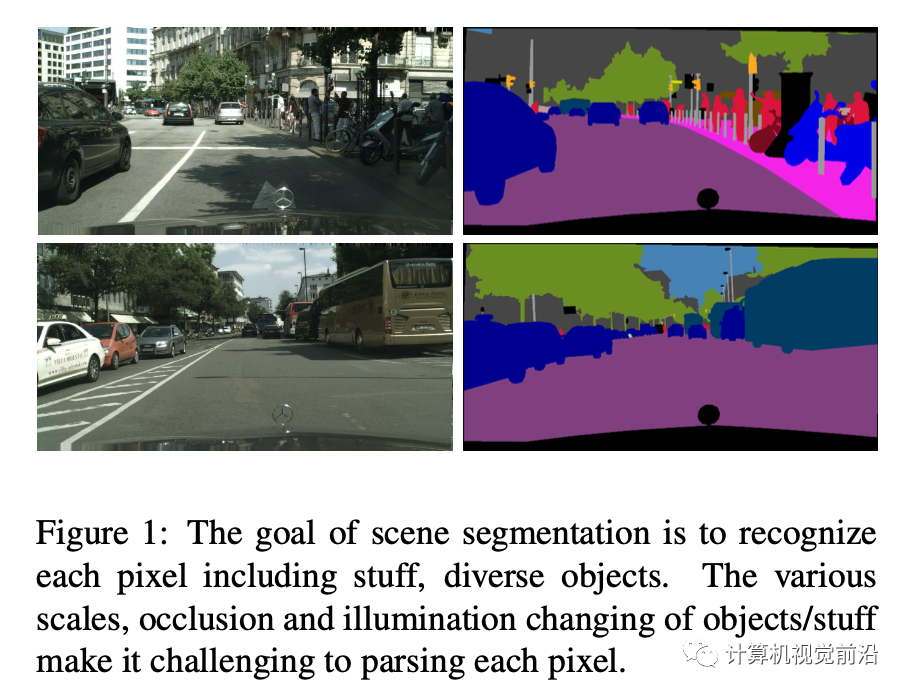

场景分割是一个基本且具有挑战性的问题,其目标是将场景图像分割并解析为与语义类别(例如,东西(例如,天空,道路,草地)和离散对象(例如,人,汽车, 自行车)。其应用如自动驾驶,机器感知和图像编辑。为了有效地完成场景分割的任务,我们需要区分一些令人困惑的类别,并考虑具有不同外观的对象。例如,“田野”和“草丛”的区域通常是无法区分的,“汽车”的物体通常可能会受到比例尺,遮挡和照明的影响。因此,有必要增强用于像素级识别的特征表示的判别能力。

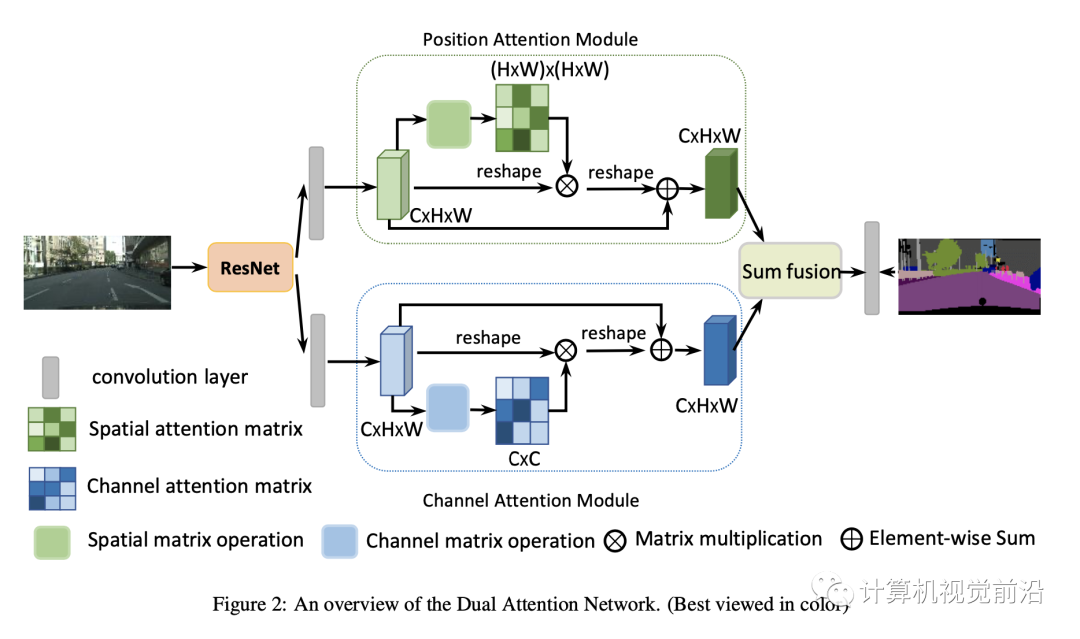

近来,FCNs被用于解决上面问题。一种方法上使用多尺度上下文融合。例如,[3,4,30]通过聚合特征图得到多尺度融合。[15,28]通过扩大卷积核丰富全局信息。另外,编码-解码结构用于融合中,高层级语义特征。尽管上下文融合有助于捕捉不同尺度特征,但无法利用全局视图中的对象或事物之间的关系,这对于场景分割也是必不可少的。另一种方法是使用递归神经网络来利用远程依赖关系,从而提高场景分割的准确性。基于2D LSTM[1]用于捕捉复杂空间依赖。[18]建立循环神经网络捕捉局部特征。但是,这些方法隐含了与递归神经网络的全局关系,后者的有效性在很大程度上取决于长期记忆的学习成果。为了解决上面问题,我们提出DANet自动场景分割,如图2所示。它在空间和通道维度分别使用自注意力。特别的,我们在FCN的两个平行分支使用注意力模块。一个是位置注意力,一个是通道注意力。对于位置注意力模块,我们使用自注意力机制捕捉空间依赖;对于某个位置上的特征,可通过使用加权求和在所有位置上聚合特征来进行更新,其中权重由对应两个位置之间的特征相似性决定。即,具有相似特征的任何两个位置都可以相互促进,而无论它们在空间维度上的距离如何。对于通道注意模块,我们使用类似的自注意机制来捕获任意两个通道图之间的通道依存关系,并使用所有通道图的加权总和更新每个通道图。最后,将这两个注意模块的输出融合在一起,以进一步增强特征表示。

我们的方法比之前方法更加高效和灵活。以如图1街道场景为例,首先,由于光线和视野,第一行中的某些“人”和“交通灯”是不明显或不完整的物体。如果希望进行简单的上下文嵌入,则来自主要显着对象(例如汽车,建筑物)的上下文将损害那些不起眼的对象标签。相比之下,我们的注意力模型选择性地聚集了不起眼的对象的相似特征,以突出它们的特征表示并避免了显着对象的影响。其次,“汽车”和“人”的比例是多种多样的,而要识别此类不同的物体,则需要不同比例的上下文信息。也就是说,应平等对待不同比例的要素以表示相同的语义。我们的带有注意力机制的模型的目的只是从全局的角度适应性地整合任何规模的相似特征,这可以在某种程度上解决上述问题。第三,我们明确考虑了空间和通道关系,以便可以从远程依赖性中受益于场景理解。

我们的贡献总结如下:

- 我们提出DANet增加场景分割的特征区分性;

- 提出了一个位置注意模块来学习特征的空间相互依赖性,并设计了一个通道注意模块来建模通道之间的依赖性。通过对局部特征进行丰富的上下文相关性建模,可显着改善分割结果。

- 在Cityscapes数据集,PASCAl Context数据集和COCO Stuff数据集上实现最佳性能。

3.DANet 双注意力网络

本部分先介绍我们的网络结构整体情况,然后介绍两个注意力模块,它们在空间和通道维度捕获长依赖上下文信息。最后介绍如何将它们聚合进一步改进。

3.1 概述

给定场景分割的图片,东西或物体在比例,照明和视图上各不相同。由于卷积运算将导致局部接收场,因此与具有相同标签的像素对应的特征可能会有一些差异。这些差异导致类内不一致并影响识别准确性。为了解决这个问题,我们通过建立具有注意机制的要素之间的关联来探索全局上下文信息。我们的方法可以自适应地聚合远程上下文信息,从而改善场景分割的特征表示。如图2所示,我们设计了两种类型的注意力模块,以便在由扩张的残差网络生成的局部特征上绘制全局上下文,从而获得用于像素级预测的更好的特征表示。我们采用以分层策略[3]为骨干的预训练残差网络。注意,我们删除了下采样操作,并在最后两个ResNet块中使用了扩展卷积,从而将最终特征图的大小放大到了输入图像的1/8。它保留了更多详细信息,而无需添加额外的参数。然后,来自扩张残差网络的特征将被馈送到两个并行注意模块中。采取图中上部的空间注意模块。以图2为例,我们首先应用卷积层以获得降维特征。然后,我们将这些特征输入到位置注意模块中,并通过以下三个步骤生成空间远程上下文信息的新特征。第一步是生成一个空间注意矩阵,该矩阵对特征的任意两个像素之间的空间关系进行建模。接下来,我们在注意力矩阵和原始特征之间执行矩阵乘法。第三,我们对上面相乘的结果矩阵和原始特征执行逐元素求和运算,以获得反映远程上下文的最终表示。同时,通道注意模块捕获通道维度中的远程上下文信息。捕获渠道关系的过程与位置关注模块相似,但第一步是在渠道维度中计算渠道关注矩阵。最后,我们汇总两个注意力模块的输出,以获得更好的特征表示,以进行像素级预测。

3.2 空间位置注意力模块

具有判别表示的特征对场景理解非常重要,可以通过捕获远程上下文信息获得。但是局部特征如FCN可能导致误分类。为了建模丰富上下文关系,我们引入位置注意力模块。它将更宽范围的上下文信息编码为局部特征,因此,增加其表示能力。接下来,我们详细说明自适应地聚合空间上下文的过程。

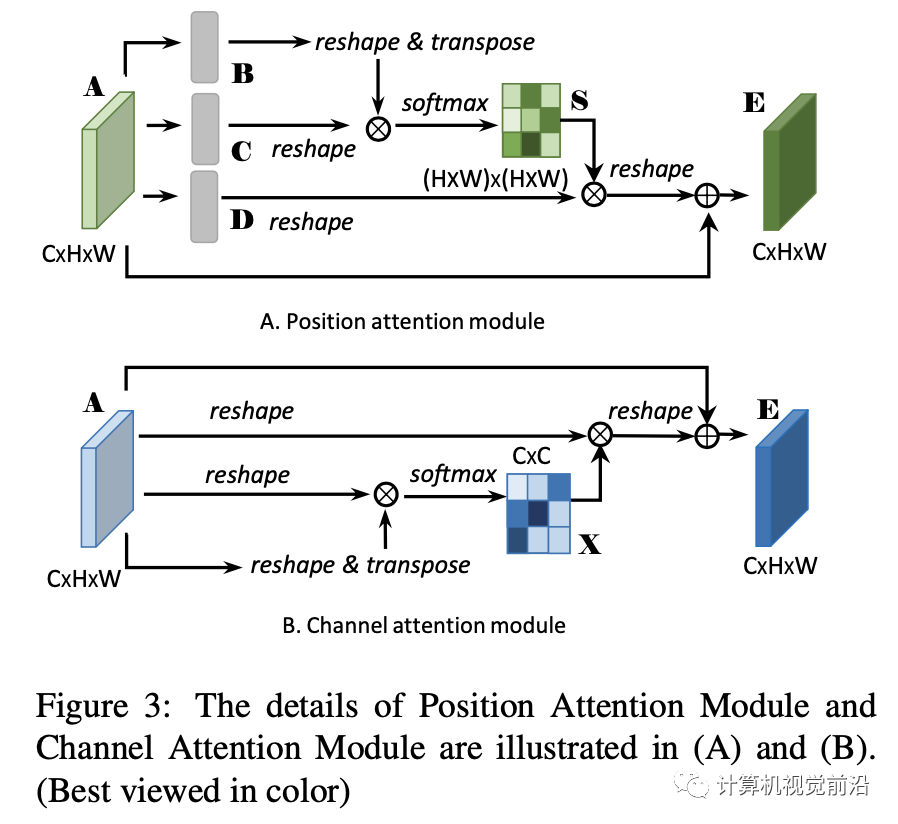

如图3A所示,给定一个局部特征,首先使用卷积层生成两个特征图B和C。其中.之后将其维度调整为,其中.之后,我们在C和B的转置之间执行矩阵乘法,然后使用softmax层计算空间注意力图.

其中代表第i个位置在第j位置的影响。两个特征越相似,它们的贡献越大。同时,我们将A送入卷积网络生成新特征图然后维度调整为,然后在D和S的转置直接使用矩阵乘法,最后把结果reshape为。最后,我们使用一个尺度因子相乘然后和A进行逐像素相加得到最终输出:

这里初始化为0逐步学习赋予更大权重。可以看到最后的E是原始特征和所有位置特征加权后的结果。因此它有一个全局视角并且选择根据空间注意力图聚合上下文信息。相似语义特征得到更多关注,因此提高类内影响和语义一致性。

3.3 通道注意力模块

每个深层特征的通道图都可以作为特定于类的响应,并且不同的语义响应相互关联。通过利用通道图之间的相互依赖性,我们可以强调相互依存的特征图并改进特定语义的特征表示。因此,我们构建了一个频道关注模块来显式地建模频道之间的相互依赖关系。如图3B所示是通道注意力模块。和空间位置注意力不同,我们直接根据原始特征A计算通道注意力.具体而言,我们将A变换为Xin R^{C* C}$:

其中代表第i个通道在第j个通道的影响。另外,我们使用在X和A中矩阵乘法,然后把结果转换为.然后,使用因子和结果相乘,再与原始特征A逐元素相加 得到最终输出:

公式4表明最终特征是原始特征和通道所有特征加权和。注意我们在计算通道关系前不使用卷积,因为它可以获取不同通道图之间的关系。另外,和[28]不同的是,它们使用全局池化或解码层建模通道关系,我们研究空间信息建模通道关系。

3.4注意力模块嵌入在网络

为了充分利用远程上下文信息,我们汇总了这两个注意模块的功能。具体来说,我们通过卷积层转换两个注意力模块的输出,并执行逐个元素的总和以完成特征融合。最后是卷积层,以生成最终的预测图。我们不采用级联操作,因为它需要更多的GPU内存。注意,我们的注意模块很简单,可以直接插入现有的FCN管道中。它们不会增加太多参数,但可以有效地增强特征表示

4.实验

为了验证本文方法,我们在城市景观数据集[5],PASCAL VOC2012 [7],PASCAL上下文数据集[14]和COCO Stuff数据集[2]。实验结果表明,DANet在三个数据集上均达到了最先进的性能。在接下来的小节中,我们首先介绍数据集和实现细节,然后对Cityscapes数据集执行一系列的消融实验。最后,我们报告关于PASCAL VOC 2012,PASCAL Context和COCO Stuff的结果。

4.1 数据集和实现细节

Cityscapes 这个数据集包含50个城市的5000图像。每一幅图大小2048* 1024,像素级标签19个类别。2979训练,500验证,1525测试集。PASCAL VOC2012 10582图像用于训练,1449验证,1456测试,包含20前景类和一个背景类。PASCAL Context 4998图像训练,5105测试,数据集提供详细的语义标签。我们在最常见的59个类别和一个背景类上验证。COCO Stuff 9000图像训练,1000图像测试。我们公布在171类别上结果,包含80个目标和91个stuff.

4.1.1 实现细节

基于Pytorch实现,初始学习率0.01,动量0.9,权重衰减0.0001.使用Synchronized BN训练。Batchsize为8或16.

4.2 在Cityscapes数据集上结果

4.2.1 注意力模块的消融实验

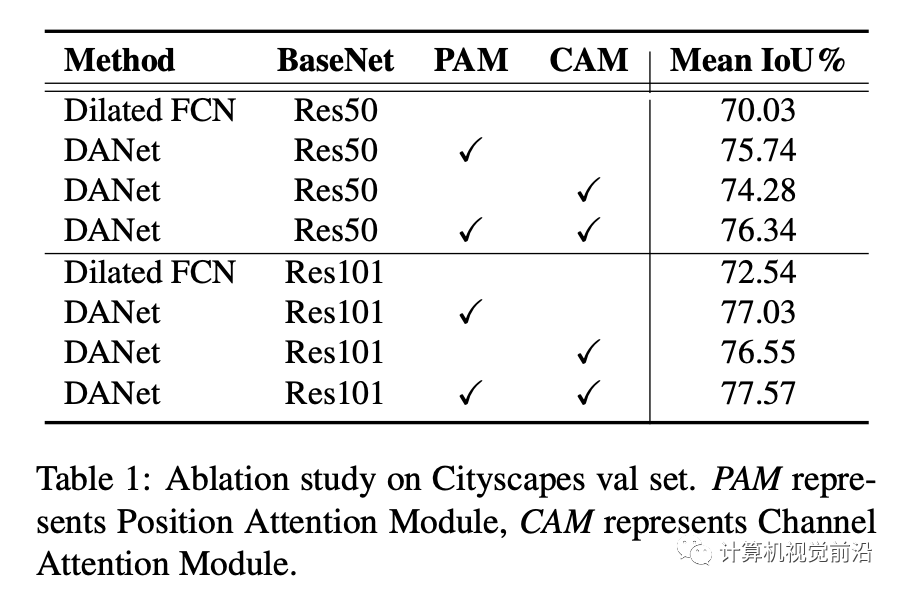

我们使用双注意力模块捕获特征进行场景理解。表1是不同的实验设置。如表1所示,注意力模块显著提高性能。以FCN为基准,使用位置注意力提高5.71%,使用通道注意力提高4.25%。同时使用两种注意力性能达到76.34%。进一步更换基础网络为ResNet-101,相对于基准模型在注意力下性能提高5.03%。

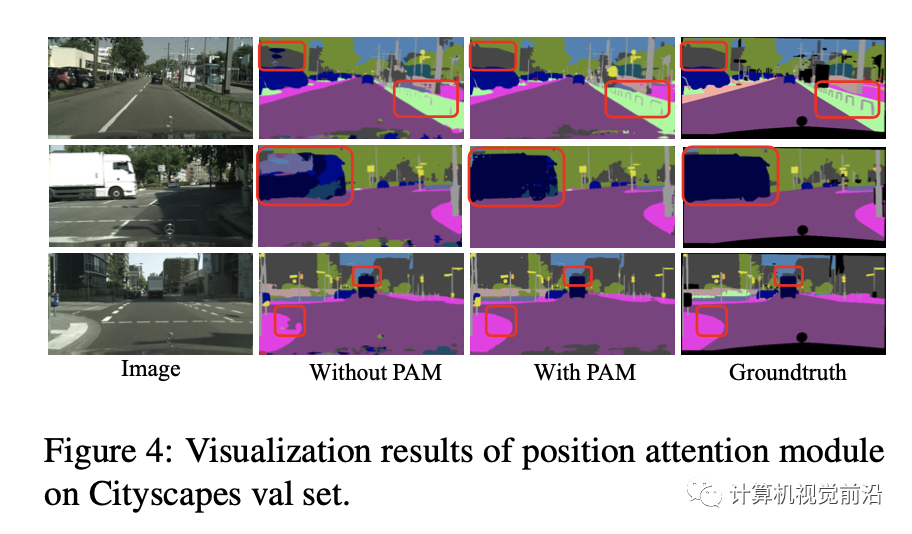

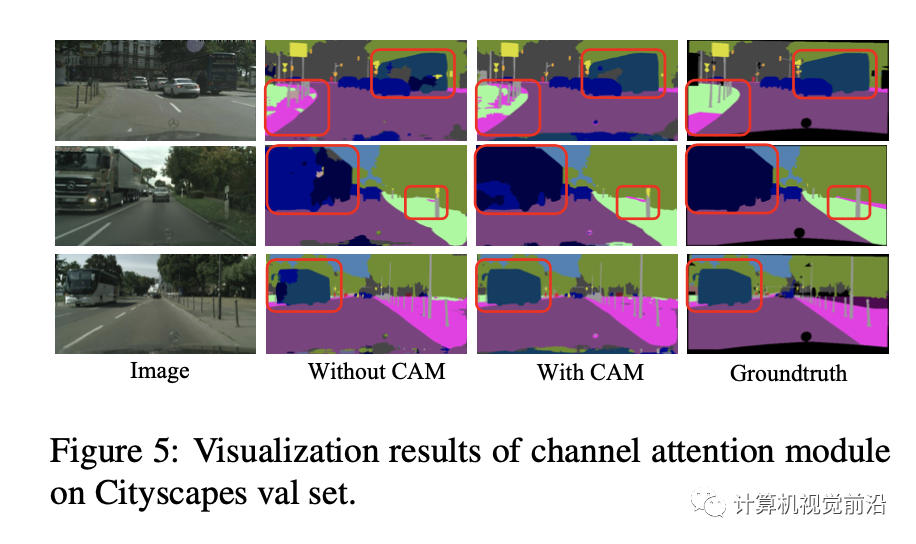

位置注意力模块的作用如图4.一些目标的边界和细节更加清晰。同时,图5表明通道注意力的作用,一些错误分类的类别被纠正。

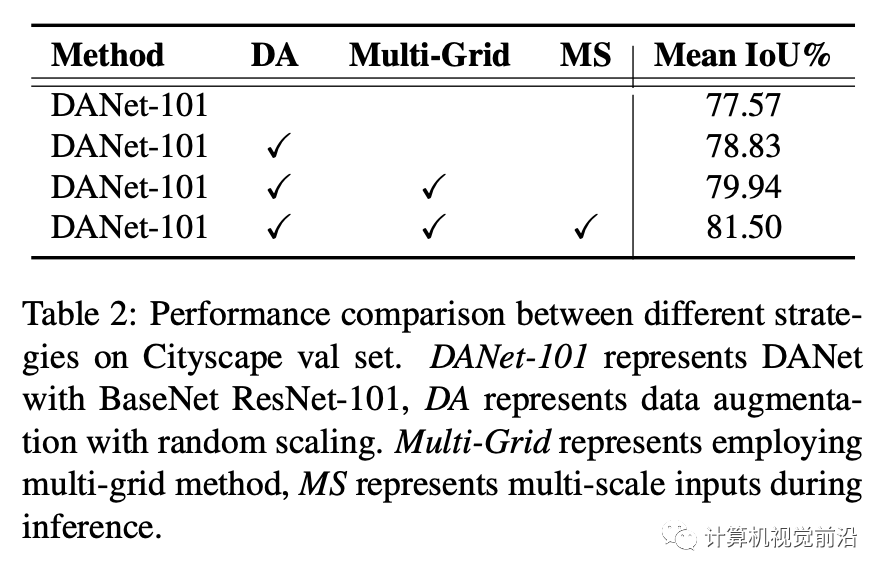

4.2.2 提升策略的消融研究

根据(4),我们使用相同的策略进一步提升性能。(1)DA,随机缩放数据扩增;(2)Multi-Grid:我们在最后一个ResNet块中应用了不同大小(4,8,16)的网格层次结构。(3)MS:我们从8个图像比例{0.5 0.75 1 1.25 1.5 1.75 2 2.2}上平均分割概率图进行推理。实验结果显示在表2中。随机缩放的数据增强将性能提高了近1.26%,这表明网络受益于丰富训练数据的规模多样性。我们采用Multi-Grid以获得更好的预训练网络特征表示,从而进一步提高了1.11%。最后,分割图融合进一步将性能提高到81.50%,比著名方法Deeplabv3 [4](在Cityscape val上为79.30%)要高出2.20%。

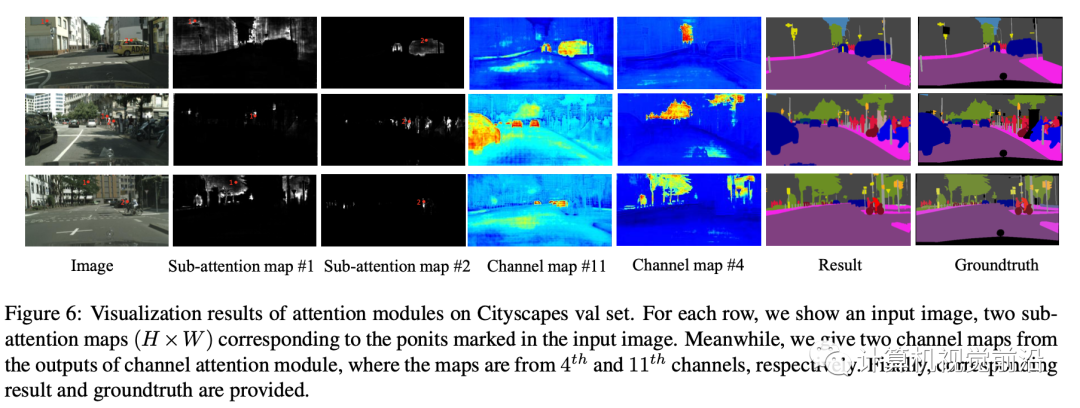

4.2.3 注意力模块可视化

对于位置注意力,自注意力图大小是,这意味着图像中的每一个点有对应的特征图.在图6中,对于每个输入图像,我们选择两个点(标记为#1和#2),并分别在第2列和第3列中显示它们对应的子注意图。我们观察到,位置注意模块可以捕获清晰的语义相似性和长期关系。例如,在第一行中,红点#1标记在建筑物上,并且其注意图(在第2列中)突出显示了建筑物所在的大部分区域。此外,在子注意地图中,即使边界中的一些远离点#1,其边界也非常清晰。至于第二点,它的注意力图集中在大多数标有“汽车”的位置上。在第二行中,即使相应像素数较少,全球区域中的“交通标志”和“人”也是如此。第三行是“植被”类和“人”类的。特别是,第2点不会对附近的“骑手”类做出反应,但会对遥远的“人”做出响应。对于通道注意力,很难直接对关注图进行全面的可视化。相反,我们显示一些有人参与的通道,以查看它们是否突出显示了清晰的语义区域。在图6中,我们在第4和第5列中显示了第11和第4个出席频道。我们发现,在频道关注模块增强之后,特定语义的响应是明显的。例如,在所有三个示例中,第11个通道图都对“ car”类做出响应,而第4个通道图则针对“ vegetation”类,这有利于对两个场景类别进行分割。简而言之,这些可视化进一步说明了捕获远程依存关系以改善场景分割中的特征表示的必要性。

4.2.4与最新技术进行比较

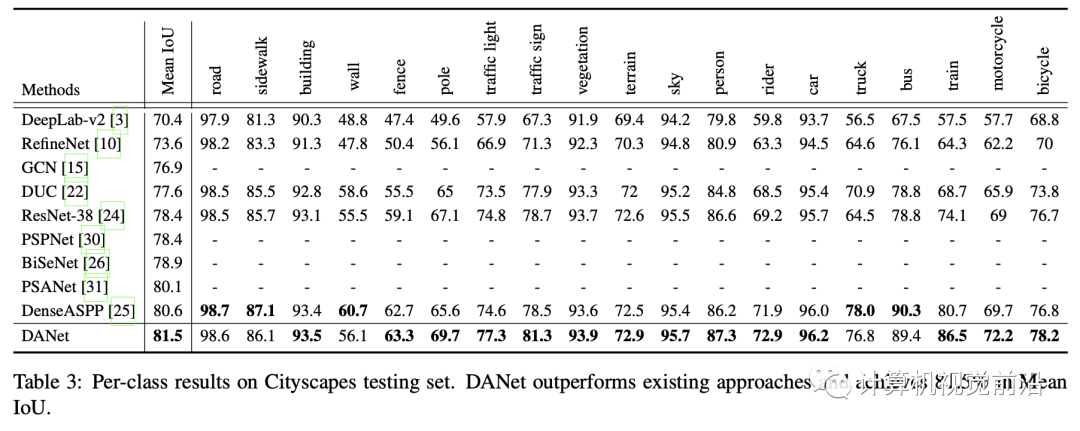

我们进一步将我们的方法与Cityscapes测试集中的现有方法进行比较。具体来说,我们仅使用精细的注释数据来训练DANet-101,并将测试结果提交给官方评估服务器。结果显示在表3中。DANet的主要优势是优于现有方法。特别是,在使用相同的主干网ResNet-101的情况下,我们的模型大大优于PSANet [31]。此外,它还超过了DenseASPP [25],后者使用了比我们更强大的预训练模型。

4.3 PASCAL VOC2012结果

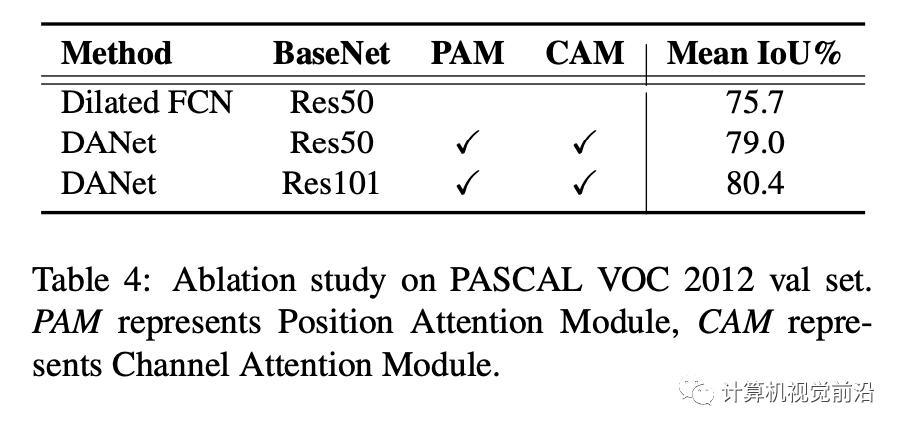

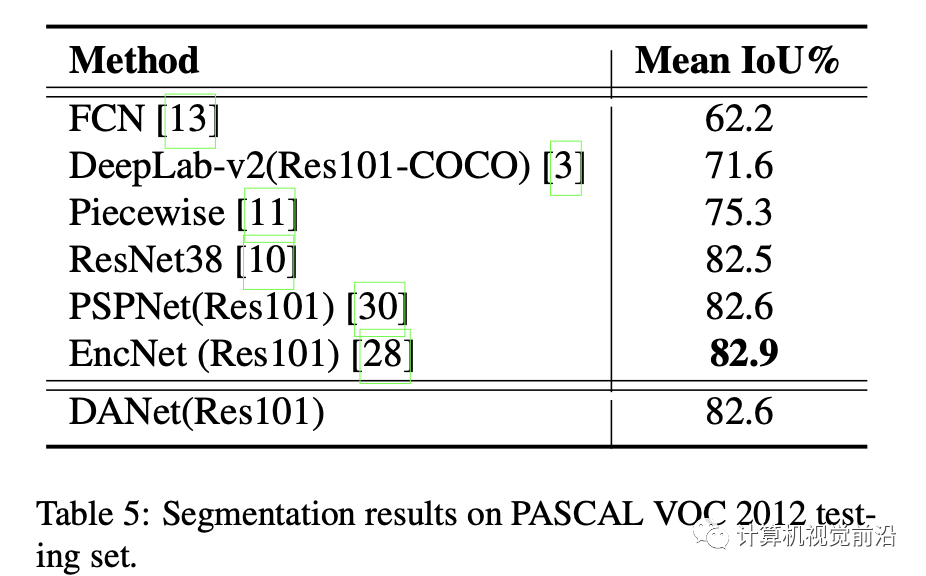

表4是VOC2012验证集上的结果。注意力模块显著提高性能,DANet-50提升3.3%。当使用ResNet-101,模型达到80.4%平均IoU。表5是在VOC202测试集上的结果。

4.4 PASCAL Context数据集上结果

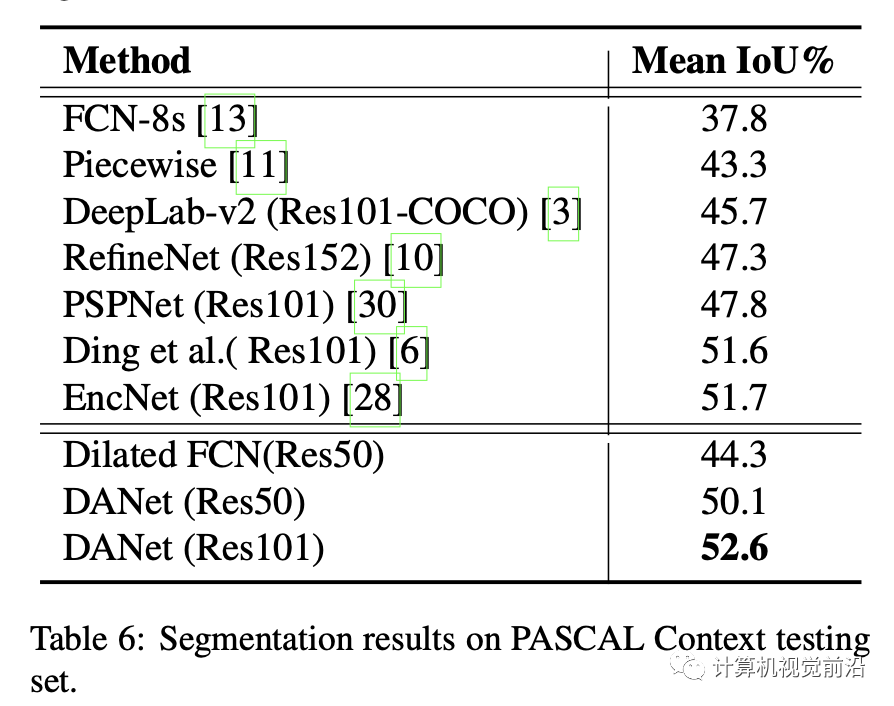

表6是PASCAL Context数据集上结果。基准模型Dilated FCN-50平均IoU为44.3%。DANet-50达到50.1%。进一步,使用ResNet101,我们的梦想达到52.6%,大大超越之前工作。

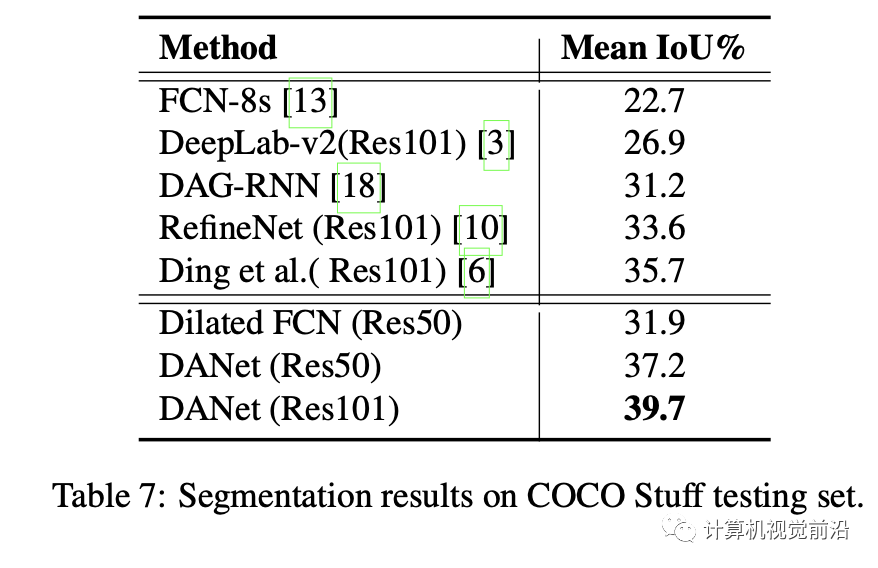

4.5 COCO stuff 数据集上结果

表7显示COCO stuff上结果。达到39.7%平均IoU。

5.结论

在本文中,我们提出了一种用于场景分割的双重注意力网络(DANet),该网络利用自我注意力机制自适应地整合了局部语义特征。具体来说,我们引入了一个位置注意模块和一个通道注意模块,以分别捕获空间和通道维度中的全局依赖性。消融实验表明,双注意力模块有效地捕获了远程上下文信息,并给出了更精确的分割结果。我们的注意力网络在四个场景分割数据集(即Cityscapes,Pascal VOC 2012,Pascal Context和COCO Stuff)上始终保持出色的性能。此外,重要的是减少计算复杂度并增强模型的鲁棒性,这将在以后的工作中进行研究。

微信公众号

如果你绝对本文对你有帮助,欢迎关注计算机视觉前沿获取更多精彩内容!小编等你一起每天进步一点点!

最后

以上就是冷酷翅膀最近收集整理的关于通道注意力机制_DANet空间和通道双重注意力来袭,助力全景分割!附代码!的全部内容,更多相关通道注意力机制_DANet空间和通道双重注意力来袭内容请搜索靠谱客的其他文章。

发表评论 取消回复