- 本文主要梳理V2V关节点估计算法的原理、网络结构、以及工程应用。

- 虽然V2V是2017年的算法,但是其3D点云处理流程和效果还是很经典的,值得作为入门3D深度学习领域的一个窗口。

1 算法部分

V2V-PoseNet基本介绍

- 发明时间:2017年

- 功能:3D关节点估计(如应用于手掌关节点估计)

- 输入数据:一张包含目标的depth图。(如用Kinect、realsense等传感器采集的的depth图)

- 输出结果:目标物体关节点的X,Y,Z坐标值。

- 两句话概括创新点:

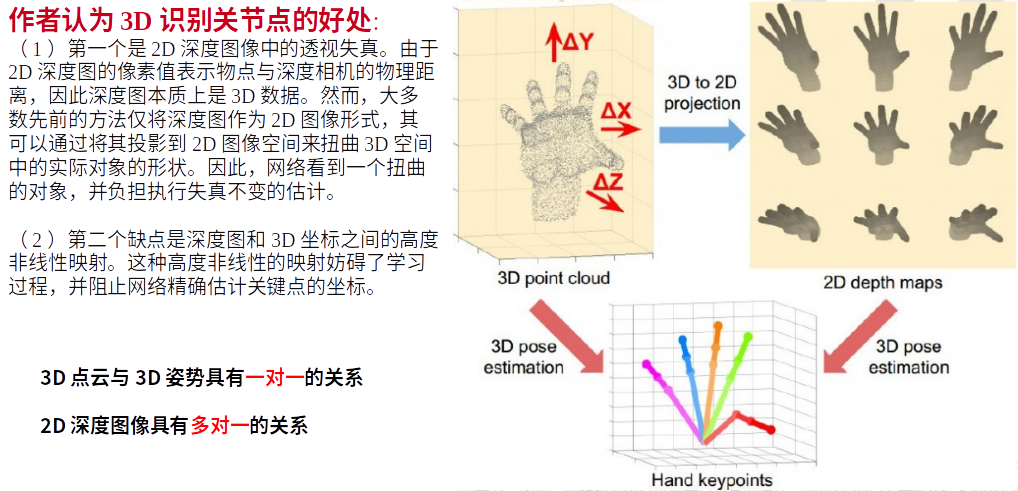

- 第一句话:传统方法是基于2D深度图直接回归关节点坐标,而我们是把2D深度图投影到3D空间,然后用3D卷积去操作,这能解决2D深度图的透视畸变问题。(透视畸变问题见下面)

- 第二句话:我们不是直接回归关节点坐标,而是估计每个点云所属某关节点的概率值。(用热图表示)

- 所获荣誉:

- CVPR2018

- 大大领先优势,获得当年基于帧的3D手部姿态估计挑战赛第一名。

- 在当前(2021年8月)手势姿态估计领域,效果排名第3。

算法结构介绍

论文中结构图如下:

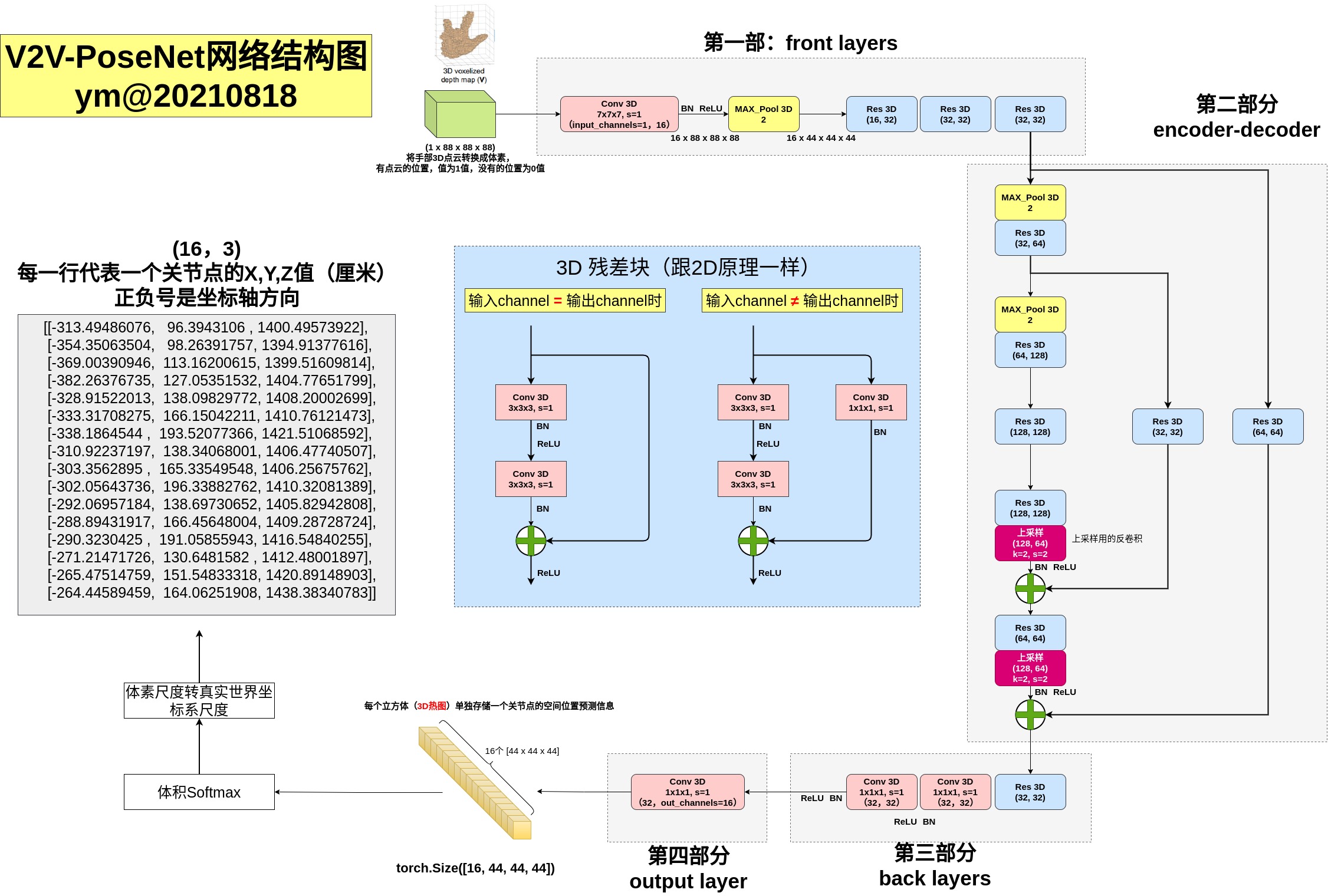

自己绘制的更详细版结构图如下:

V2V网络输入的预处理过程见后面内容,这里说明下网络输出及其后处理过程。

- 网络输出的[16, 44, 44, 44]是什么意思?

- 答:16代表关节点个数,每个关节点的XYZ坐标信息单独用一个44x44x44立方体来预测表示。此时,网络输出的立方体(44x44x44的矩阵)里面每个元素值有正有负,值越大的元素位置,即代表关节点在此处的概率越大。把这立方体里面所有元素值经过一个softmax后,每个元素值就能转换成一个0~1之间的概率值了。

- 在输出的44x44x44立方体中,怎么找到关节点的具体XYZ位置?

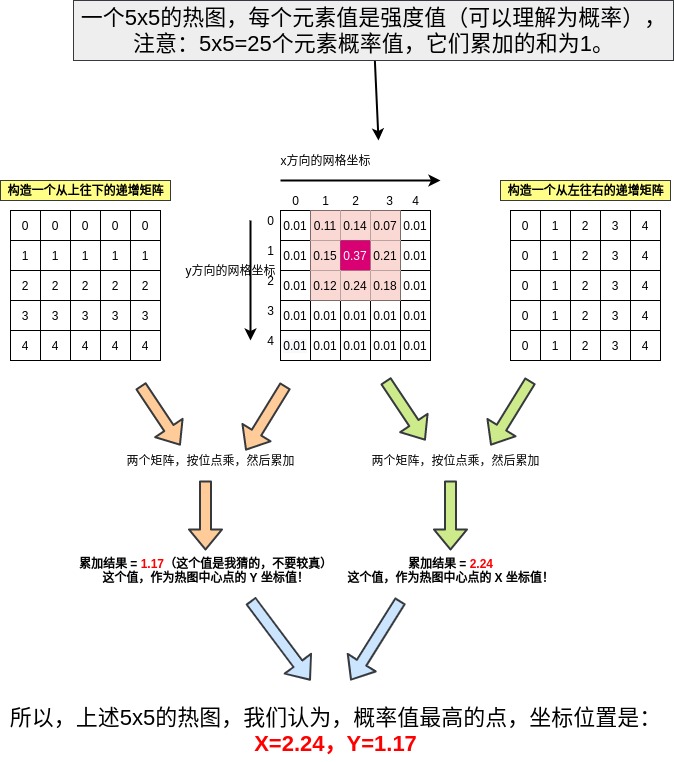

- 44x44x44立方体矩阵经过softmax后,44x44x44=85184个元素值能够转换成关节点落在此处的概率值,最简单的获取关节点XYZ位置的方法就是取这立方体中,概率最大的那个值,看这个最大的值在44x44x44立方体的什么位置,那个位置就判定为网络预测的关节点位置。但是,这种方法有很多弊端,第一个大弊端是,这种方式得到的关节点XYZ只能是整数值([0, 44]之间的整数),这就导致预测的精度损失。第二个大弊端是,概率最高的那个位置点,可能是个离群点,即有可能并不是概率密度最高区域的中心点。既然这样,那怎么根据这85184个概率值,在44x44x44的立方体中,找到关节点最佳位置呢?方法就计算所有位置概率的平均!我还不知道怎么用简短的语言描述,让我用一幅图来解释:(我用2D图中找热图中心点位置为例子,3D立体找热图中心点同理)

- 上图,关键是理解构造的那两个X、Y方向的递增矩阵就好了,它们和概率图按位点乘然后25个元素累加,其结果的物理意义,就是所有25个点位置的平均值!看热图的X方向,热图中概率最高点0.37,它左边是0.15,右边是0.21,所以,按道理中心点会在0.37网格的右边,而0.37所在的X值为2,所以,中心点的X方向值,应该大于2!实际上按上图这样计算,结果也一定会大于2!

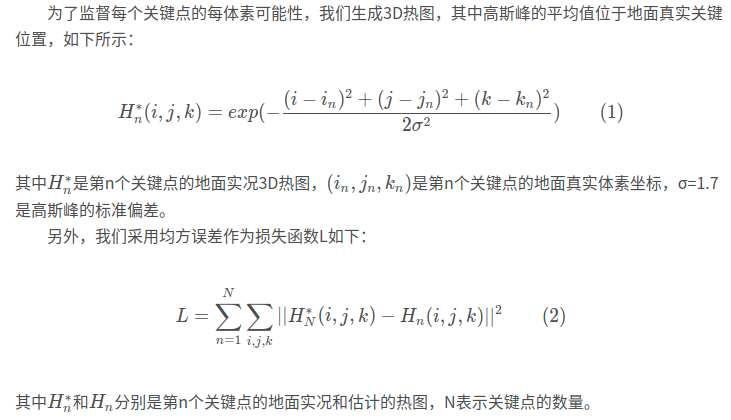

损失函数

就是把预测的3D热图(每个关节点有一个3D热图)和标签生成的热图计算均方误差:

作者认为3D识别关节点的好处

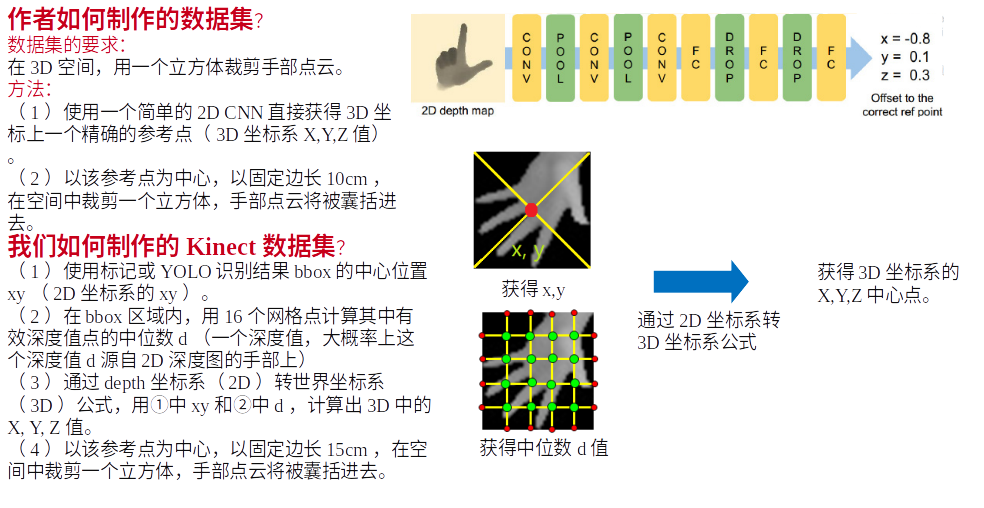

作者如何制作数据集的

作者如何制作数据集的

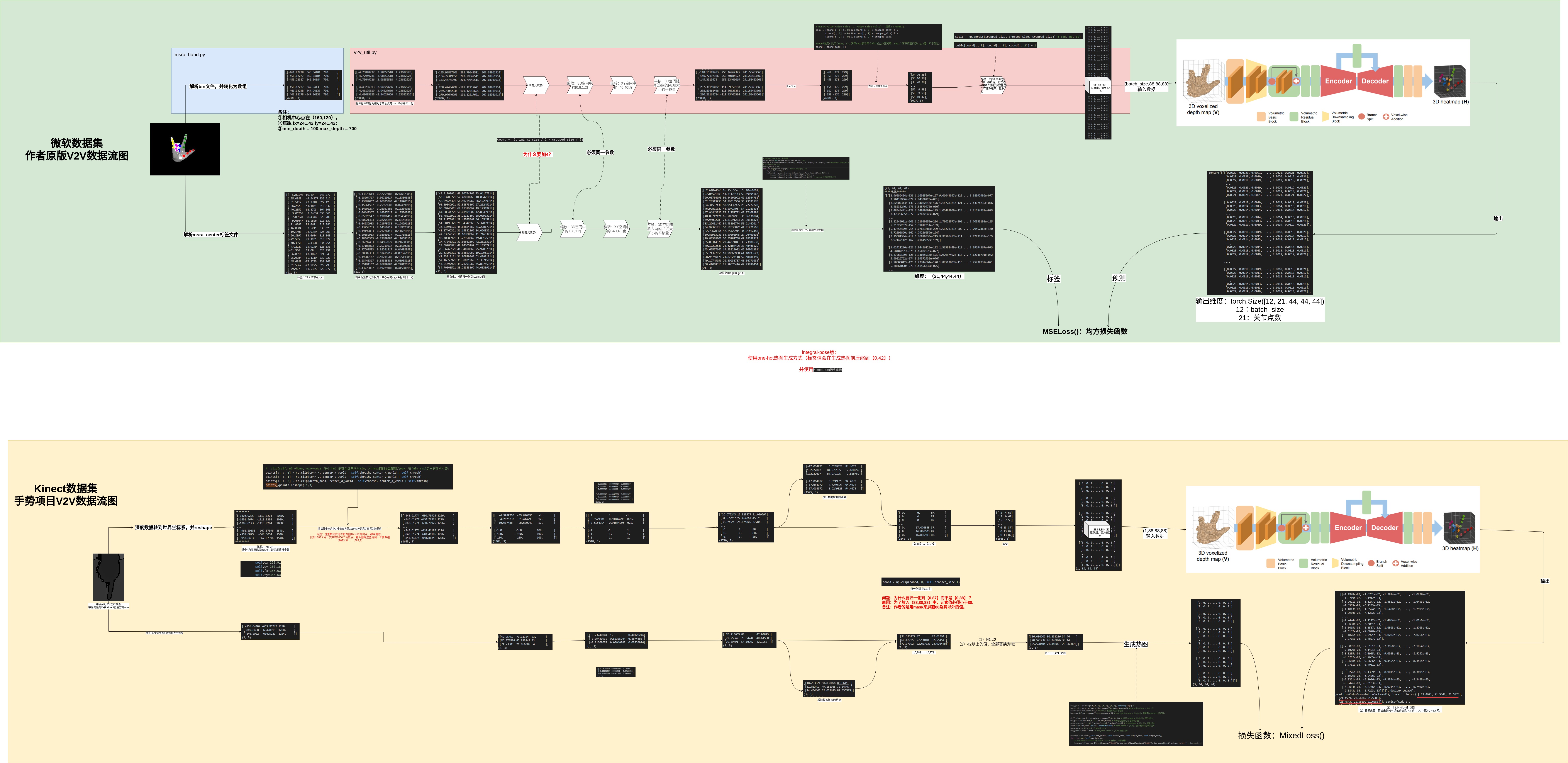

算法数据流图详情

2 工程部分

需求

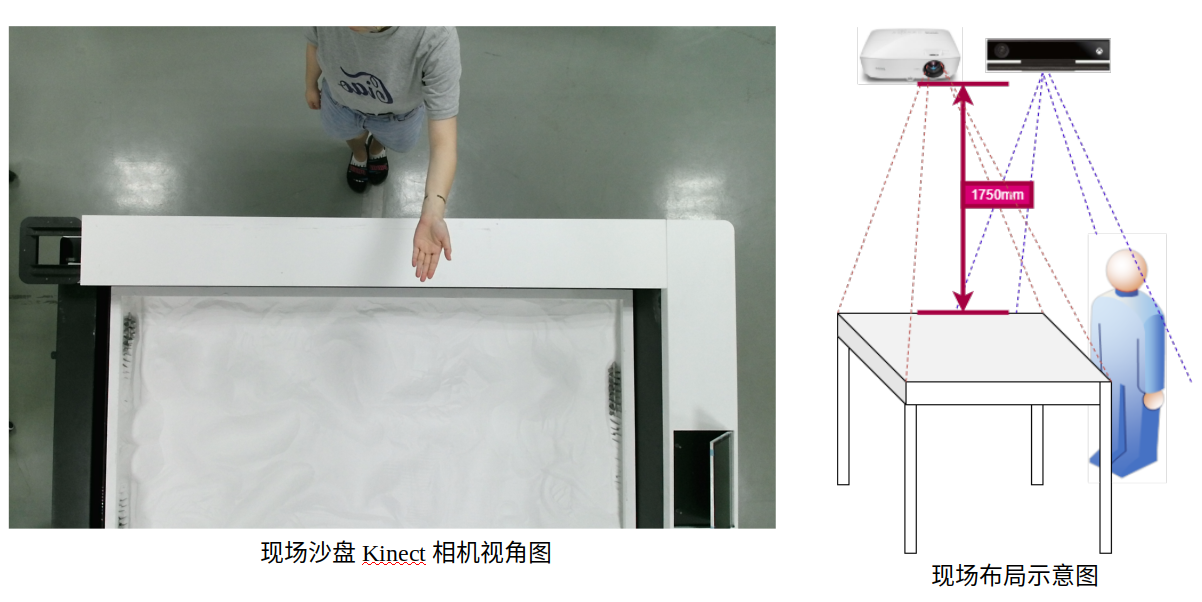

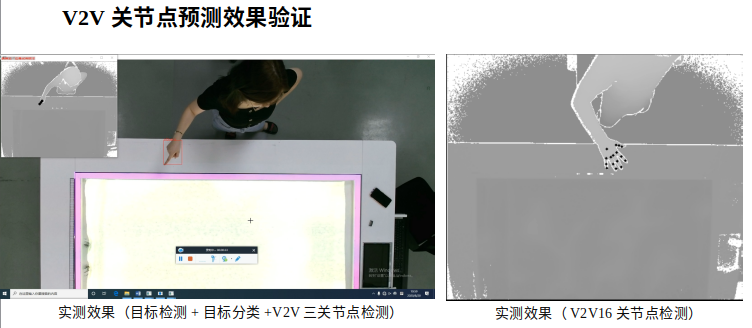

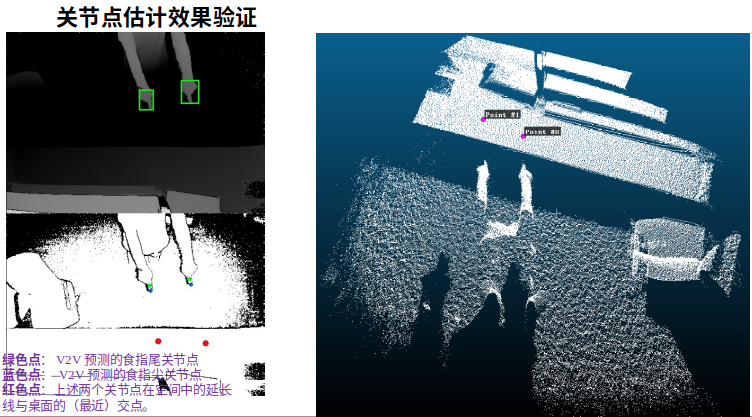

通过手势来虚拟触控激光投影,其中就需要使用V2V算法,识别手掌的16个关节点,并计算手指3关节点的空间延长线和桌面的交汇点坐标。

16个手指关节点位置:

Kinect2相机:

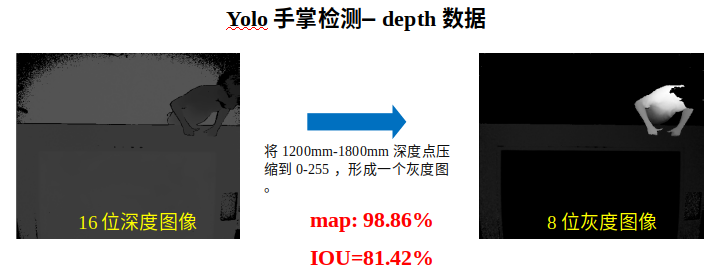

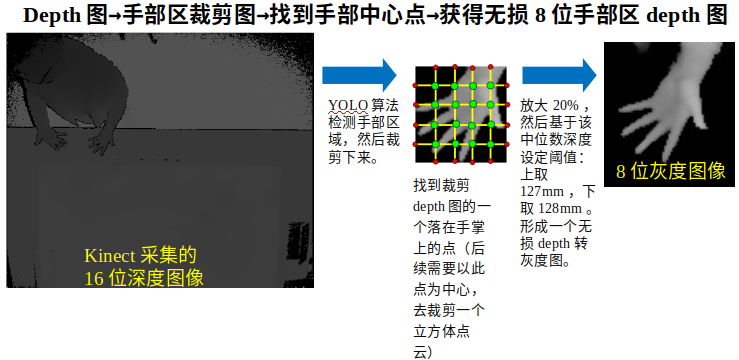

16位深度图转8位灰度图

Kinect2相机采集的depth图是16位存储的,原因是depth图中包含距离信息,值在0~2000mm之间。但是实际上我们只需要手部区域的depth图用于后续的V2V做关节点估计。最简单方法是,用YOLO目标检测器训练一个depth图的手掌目标检测模型,让YOLO算法裁剪人的手掌区域。

YOLO检测的是depth区间在1200mm至1800mm高度区间的图像,得到手部区目标框位置后,我们需要基于原始16位的depth图,去找到手部区的“中心点”,这个中心点物理意义大概是手掌在空间中的几何中心,后续我们需要基于这个中心点,去在depth转3D点云图上,以这个中心点为立体中心,去裁剪一个手部区空间,并最终送到V2V网络去预测手掌关节点位置。计算出这个中心点位置的方法有很多,这里我们简单的用16个“网格点”去获取中心点的Z值,XY值就取YOLO裁剪的手部depth图的XY值。

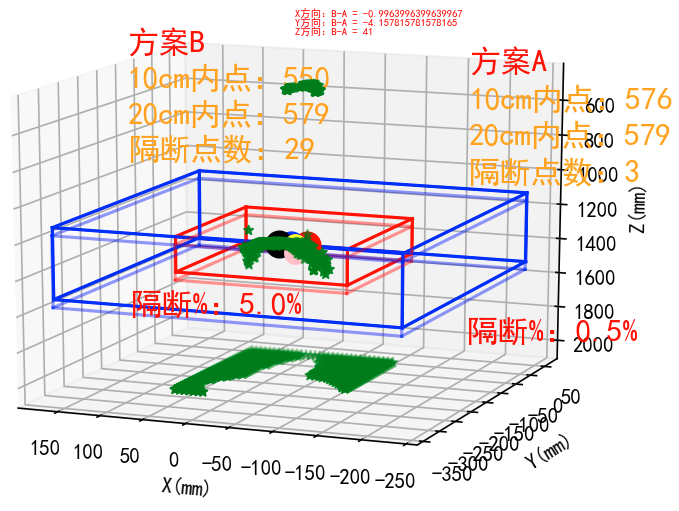

中心点选取方案的测试方法如下:(评估到底有多少手部点被排除在立方体之外)

中心点选取方案的测试方法如下:(评估到底有多少手部点被排除在立方体之外)

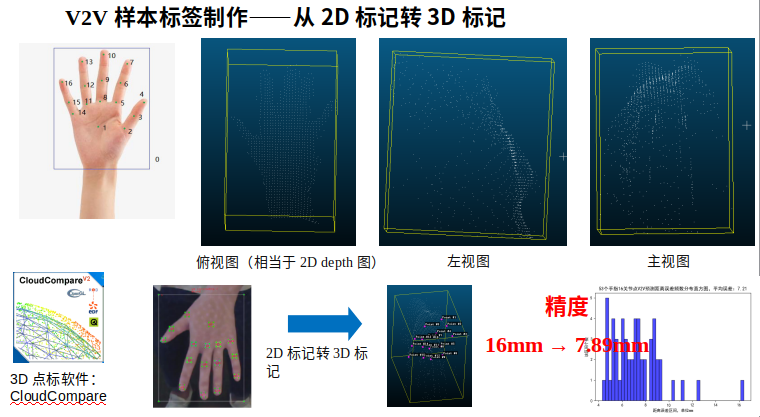

V2V样本的标注

最开始,我们在2D RGB图上标注16个关节点,然后通过RGB图坐标转depth图坐标转3D点云坐标,来获取手掌在3D空间的XYZ标签信息。但是,这种方法导致非常大的标注误差,原因在于,depth图精度并不是特别高,而且有很多噪音。RGB图上标注的点,人眼看上去标的很准,但很可能通过公式,映射到3D空间时,这个点会落在噪音点上。

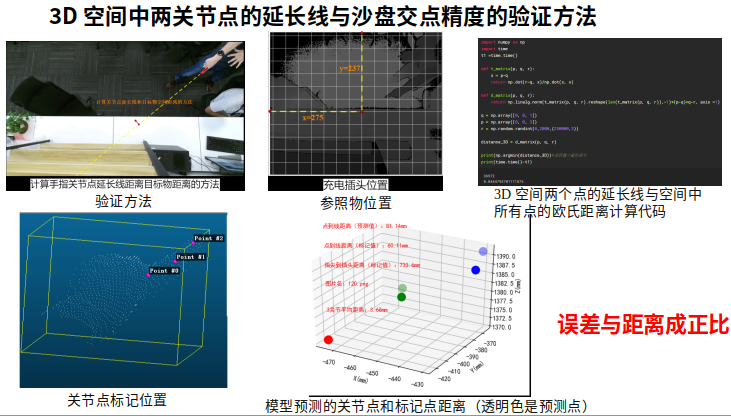

计算手指关节点的空间延长线和桌面点云的交点

V2V得到手掌16个关节点后,我们使用食指尖和食指末2个关节点的XYZ值,可以计算出其连接线射线与桌面点云的交点位置。

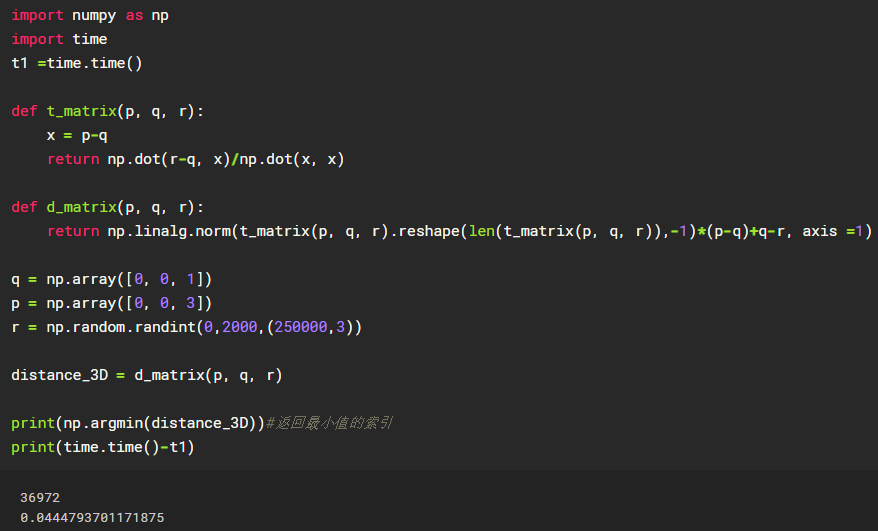

具体计算代码如下:

3 效果

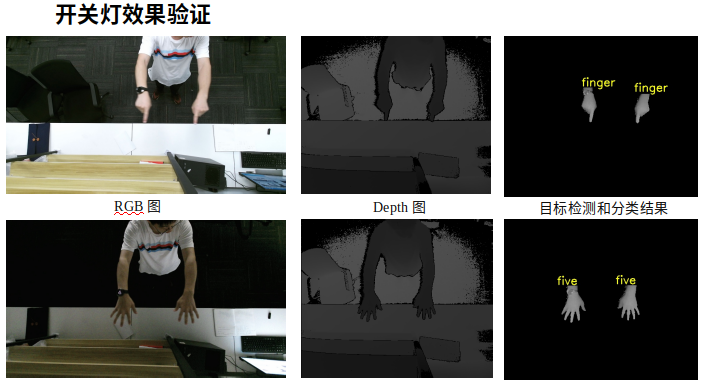

YOLO目标检测器检测手掌区域效果

V2V算法对手掌16关节点预测的效果

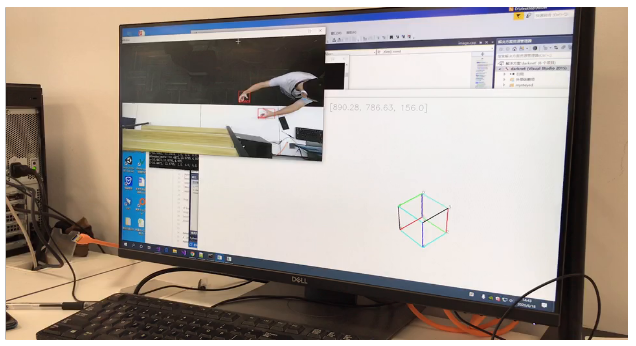

3D仿真

在开发过程中,我们设计了一个3D仿真程序,用于测试各模型及其语义逻辑在虚拟空间的操控效果。初版仿真程序是用一个简单的立方体来表示,后期仿真使用pyqtgraph库设计了一个更全功能的虚拟仿真,包括实时可视化如下内容:环境空间中的所有点云、RGB图、虚拟立方体(用于测试手掌非接触控制它的效果)、手指方向延长线与环境中点云的交汇点等等。

初版仿真程序如下:

最终版仿真程序如下:

后续更新截图。

最后

以上就是帅气自行车最近收集整理的关于V2V-PoseNet算法和应用详解(3D关节点估计领域)1 算法部分作者如何制作数据集的 2 工程部分 3 效果的全部内容,更多相关V2V-PoseNet算法和应用详解(3D关节点估计领域)1内容请搜索靠谱客的其他文章。

发表评论 取消回复