在实际生产中会有一种场景(最典型的就是黑名单的场景),就是需要DStream与RDD之间进行互相操作的,那么此时就需要我们借助transform算子来进行实现了

官网介绍:http://spark.apache.org/docs/latest/streaming-programming-guide.html#transform-operation

具体代码可见如下:

/**

* transform算子

*

* 流处理的时候,有一个数据来源于文本或者其他的 ==> RDD

* 另外一个数据来源于Kafka、或者其它数据源 ==> DStream

*/

object StreamingTransformApp {

def main(args: Array[String]): Unit = {

val ssc = ContextUtils.getStreamingContext(this.getClass.getSimpleName, 5)

val lines = ssc.socketTextStream("localhost", 9999)

// 构建黑名单

val blacks = new ListBuffer[(String, Boolean)]()

blacks.append(("huhu", true))

val blacksRDD = ssc.sparkContext.parallelize(blacks)

// 从流中获取访问日志,并对黑名单中的数据进行过滤

lines.map(x => {(x.split(",")(0), x)})

.transform(rdd => {

rdd.leftOuterJoin(blacksRDD)

.filter(_._2._2.getOrElse(false) != true)

.map(x => x._2._1)

}).print()

ssc.start()

ssc.awaitTermination()

}

}

输入数据源:

crazybird:conf $ nc -lk 9999

huhu,1

abc,2

cde,2

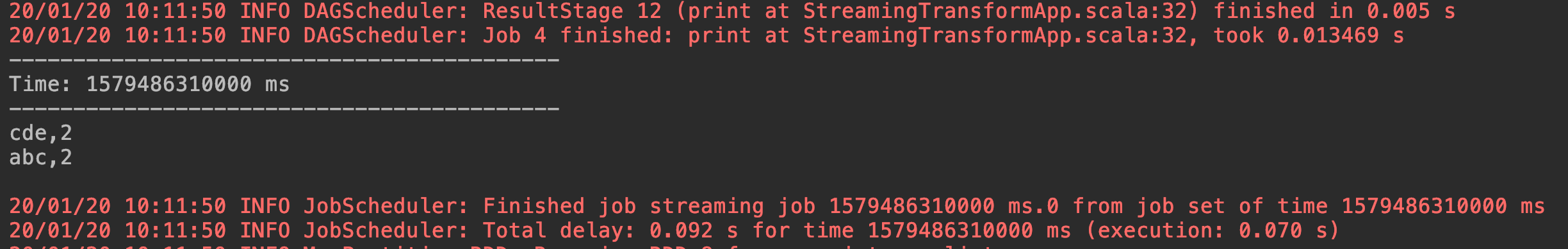

实现效果如下,成功过滤黑名单中的数据:

最后

以上就是儒雅犀牛最近收集整理的关于Spark Streaming中transform算子使用详解的全部内容,更多相关Spark内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复