看了一段时间的深度网络模型,也在tf和theano上都跑了一些模型,但是感觉没有潜下去,对很多东西的理解都只停留在“这个是干什么的”层次上面。昨天在和小老师一起看一篇文章的时候,就被问到RNN里面的后向传播算法具体是怎么推。当时心里觉得BP算法其实很熟悉啊,然后在推导的过程中就一脸懵逼了。于是又去网上翻了翻相关内容,自己走了一遍,准备做个笔记,算是个交代。

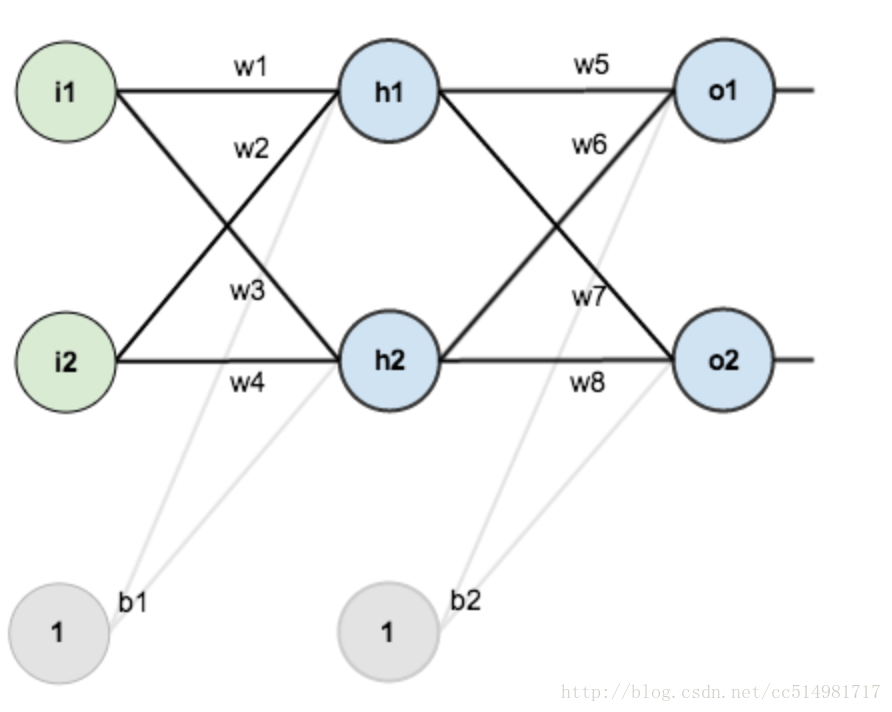

准备一个神经网络模型,比如:

其中, [i1,i2] 代表输入层的两个结点, [h1,h2] 代表隐藏层的两个结点, [o1,o2] 为输出。 [b1,b2] 为偏置项。连接每个结点之间的边已经在图中标出。

来了解一下前向算法:

前向算法的作用是计算输入层结点对隐藏层结点的影响,也就是说,把网络正向的走一遍:输入层—->隐藏层—->输出层

计算每个结点对其下一层结点的影响。

例如,我们要算结点

h1

的值,那么就是:

而在计算结点 o1 时,结点 h1 的输出不能简单的使用 neth1 的结果,必须要计算激活函数,激活函数,不是说要去激活什么,而是要指“激活的神经元的特征”通过函数保留并映射出来。以sigmoid函数为例, h1 的输出:

于是

最后 o1 的输出结果,也就是整个网络的一个输出值是:

后向算法:

在实际情况中,因为是随机给定的权值,很大的可能(几乎是100%)得到的输出与实际结果之间的偏差非常的大,这个时候我们就需要比较我们的输出和实际结果之间的差异,将这个残差返回给整个网络,调整网络中的权重关系。这也是为什么我们在神经网络中需要后向传播的原因。其主要计算步骤如下:

1. 计算总误差

在要更新每个边的权重之前,必须要知道这条边对最后输出结果的影响,可以用整体误差对 w5 求偏导求出:

需要讲出来的一个地方是,在计算 w1 的权重时, Etotal 中的两部分都需要对它进行求导,因为这条边在前向传播中对两个残差都有影响

3. 更新权重 这一步里面就没什么东西了,直接根据学习率来更新权重:

至此,一次正向+反向传播过程就到此为止,接下来只需要进行迭代,不断调整边的权重,修正网络的输出和实际结果之间的偏差(也就是training整个网络)。

原文出处:点击打开链接

最后

以上就是傲娇向日葵最近收集整理的关于神经网络中的前向和后向算法的全部内容,更多相关神经网络中内容请搜索靠谱客的其他文章。

发表评论 取消回复