2021李宏毅机器学习笔记--11 explainable ML

- 摘要

- 一、局部可解释性

-

- 1.1 基本思想

- 1.2 移除组成要素

- 1.3 改变组成要素

- 1.4 局限性

- 1.5 实例(pokemon vs digimon)

- 二、全局可解释性

-

- 2.1 反向寻找理想输入

- 2.2 输入正则化

- 三、用模型解释模型

-

- 3.1 使用线性模型

- 3.2 使用决策树

- 总结

摘要

可解释性分为两种,一种是局部可解释性,一般指的是机器说明如何判断这个样例(例如分类问题中,机器如何将一张猫的图片分成猫);另一种是全局可解释性,一般指的是机器如何对总体进行特征判断(例如分类问题中,机器认为猫长什么样子)

那么为什么我们需要这种可解释性呢?神经网络一般都是黑盒算法这确实,但并不是黑盒本身让我们难受,因为我们人的大脑也是个黑盒;而是如果我们没有一定的解释的话,我们可能会不爽。就例如一个神经网络来计算成绩,如果你分低但是还不知道为什么,那绝对会不爽。而这时如果机器能够解释每道题扣了多少分或者错在哪里这种等等,就不会不服气。也就是说我们期待的不仅是机器知道,还要机器知道为什么知道。

一、局部可解释性

1.1 基本思想

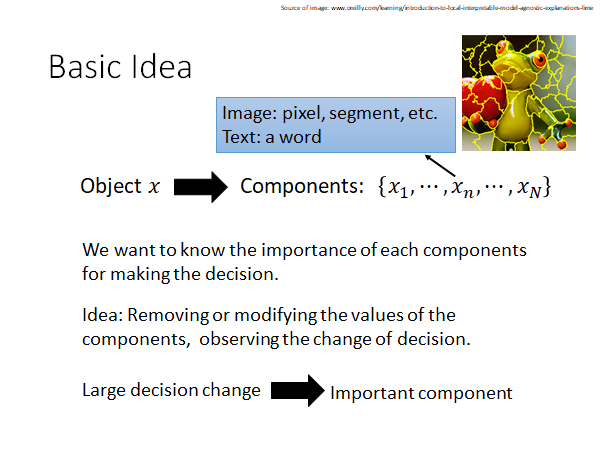

既然我们想要知道机器如何判断,这个问题其实等价于,机器把哪些所谓的特征看的很重要,是这些特征的出现很大程度的影响了机器的判断。

那我们要做的就是,把我们的这些所谓的组成部分来进行修改或者移除等等,来查看影响的效果即可,

下面就使用移除和修改两种不同的操作来进行实验。

1.2 移除组成要素

在图像中的组成要素其实我们大致就可以看作是“一块区域”,这也是CNN的基本假设。那我们就可以移除一部分,然后来记录移除这个部分的影响。如下图,就是将一部分区域涂灰,然后再进行预测,预测的效果在图的下方,与上图涂灰区域的中心对应,预测效果越差就越是冷色调。那我们就可以说明,冷色调的部分很大程度上影响了机器最后判断,也就是所谓的机器学到的内容。

最后

以上就是仁爱百合最近收集整理的关于2021李宏毅机器学习笔记--11 explainable ML摘要一、局部可解释性二、全局可解释性三、用模型解释模型总结的全部内容,更多相关2021李宏毅机器学习笔记--11内容请搜索靠谱客的其他文章。

发表评论 取消回复