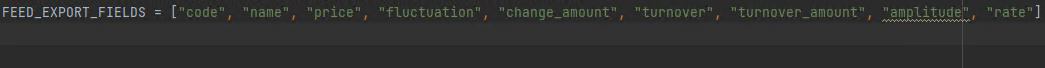

1.问题一 问题:使用scrapy crawl spider -o spider.csv命令保存为csv文件时输出的结果没有按照items的顺序来,网上搜了很多解决方法,都是要新建一个类,感觉很麻烦,琢磨了一会儿发现直接修改setting.py也可以实现 解决方案: 修改setting.py 添加一行内容如下

FEED_EXPORT_FIELDS = ["code", "name", "price", "fluctuation", "change_amount", "turnover", "turnover_amount", "amplitude", "rate"]列表内表示的是自己在items定义的字段,即要输出结果的字段顺序

FEED_EXPORT_FIELDS = [“字段名1”,"字段名2"]

2.问题二

在爬取中财网的过程中出现了 Filtered offsite request to 'quote.cfi.cn'问题

问题:

2022-01-07 10:17:52 [scrapy.spidermiddlewares.offsite] DEBUG: Filtered offsite req uest to 'quote.cfi.cn': <GET 平安银行(000001)_股票行情,行情首页_中财网>

解决:

在yield scrapy.Request() 里添加 dont_filter=True即可

allowed_domain写法错误也会导致这个问题

正确写法为:

allowed_domains = ['data.cfi.cn']

不需要添加:http://等前缀

3.问题三

问题:

scrapy crawl gpSpider -o data.json保存为json格式的时候中文乱码,输入输出编码不一致编码不一致导致的

解决:

两种方法

第一种方法:添加配置

在settings.py文件添加FEED_EXPORT_ENCODING='utf-8'或FEED_EXPORT_ENCODING='gbk'

第二种方法:在输出命令后面加上-s FEED_EXPORT_ENCODING=utf-8

scrapy crawl gpSpider -o data1.json -s FEED_EXPORT_ENCODING=utf-8

最后

以上就是专注云朵最近收集整理的关于Scrapy问题总结的全部内容,更多相关Scrapy问题总结内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

![[scrapy.downloadermiddlewares.retry] ERROR: Gave up retrying <GET>(failed 3 times): 500 Internal Ser正确代码](https://www.shuijiaxian.com/files_image/reation/bcimg9.png)

发表评论 取消回复