Scrapy框架基础

路径管理

路径

-

绝对路径

总是从根目录开始

H:PyCharmProjectstutorials_2jd_crawlermain.py -

相对路径

jd_crawlermain.py-

.和...代表当前目录,..代表父目录

-

-

工作目录

当前执行命令所在的目录

# 将工作目录添加进当前的路径列表 sys.path.append(os.getcwd())

路径列表

-

查看当前路径列表

只有在路径列表当中的包和模块才可以导入和调用

import sys print(sys.path) -

路径搜索顺序

- 当前脚本路径, 也就是执行文件的目录

PYTHONPATH路径- 虚拟环境路径

site-packages- 安装的第三方库所在路径

-

可以向路径列表添加路径

sys.path.append(r"H:PyCharmProjectstutorials_2")

常见报错

-

ModuleNotFoundError: No module named 'xxxx'-

为什么在pycharm中不报错, 在命令行当中报错

Pycharm会自动将当前项目的根目录添加到路径列表当中

-

-

ModuleNotFoundError: No module named 'parser.search'; 'parser' is not a pac kage-

自定义包和内置包名有冲突

修改包名即可

-

导入的不是一个包

-

-

ModuleNotFoundError: No module named '__main__.jd_parser'; '__main__' is no t a package-

入口程序不可以使用相对路径

-

__main__主程序模块名会被修改为

__main__

-

-

ValueError: attempted relative import beyond top-level package当前访问路径已经超过了python已知的最大路径

from tutorial_2.jd_crawler.jd_parser.search import parse_jd_item top-level package 指的是上述from导入命令中的首路径tutorial_2, 而不是根据目录结构- 把工作目录加入到路径列表当中

- 进入到项目根目录下执行命令

- 上述两个操作相当于将项目根目录加入到路径列表当中

注意事项

- 确定入口程序, 没有一个锚定的路径就没有办法做相对路径的管理

- 将项目根目录加入到入口程序当中

- 进入到项目根目录下执行命令

- 项目目录结构不要嵌套的太深

- 脚本文件或者临时运行单个模块中的方法, 可以将根目录临时添加到路径列表当中

Scrapy爬虫框架介绍

-

文档

- 英文文档

- 中文文档

-

什么是scrapy

基于

twisted搭建的异步爬虫框架.scrapy爬虫框架根据组件化设计理念和丰富的中间件, 使其成为了一个兼具高性能和高扩展的框架

-

scrapy提供的主要功能

- 具有优先级功能的调度器

- 去重功能

- 失败后的重试机制

- 并发限制

- ip使用次数限制

- …

-

scrapy的使用场景

- 不适合scrapy项目的场景

- 业务非常简单, 对性能要求也没有那么高, 那么我们写多进程, 多线程, 异步脚本即可.

- 业务非常复杂, 请求之间有顺序和失效时间的限制.

- 如果你不遵守框架的主要设计理念, 那就不要使用框架

- 适合使用scrapy项目

- 数据量大, 对性能有一定要求, 又需要用到去重功能和优先级功能的调度器

- 不适合scrapy项目的场景

-

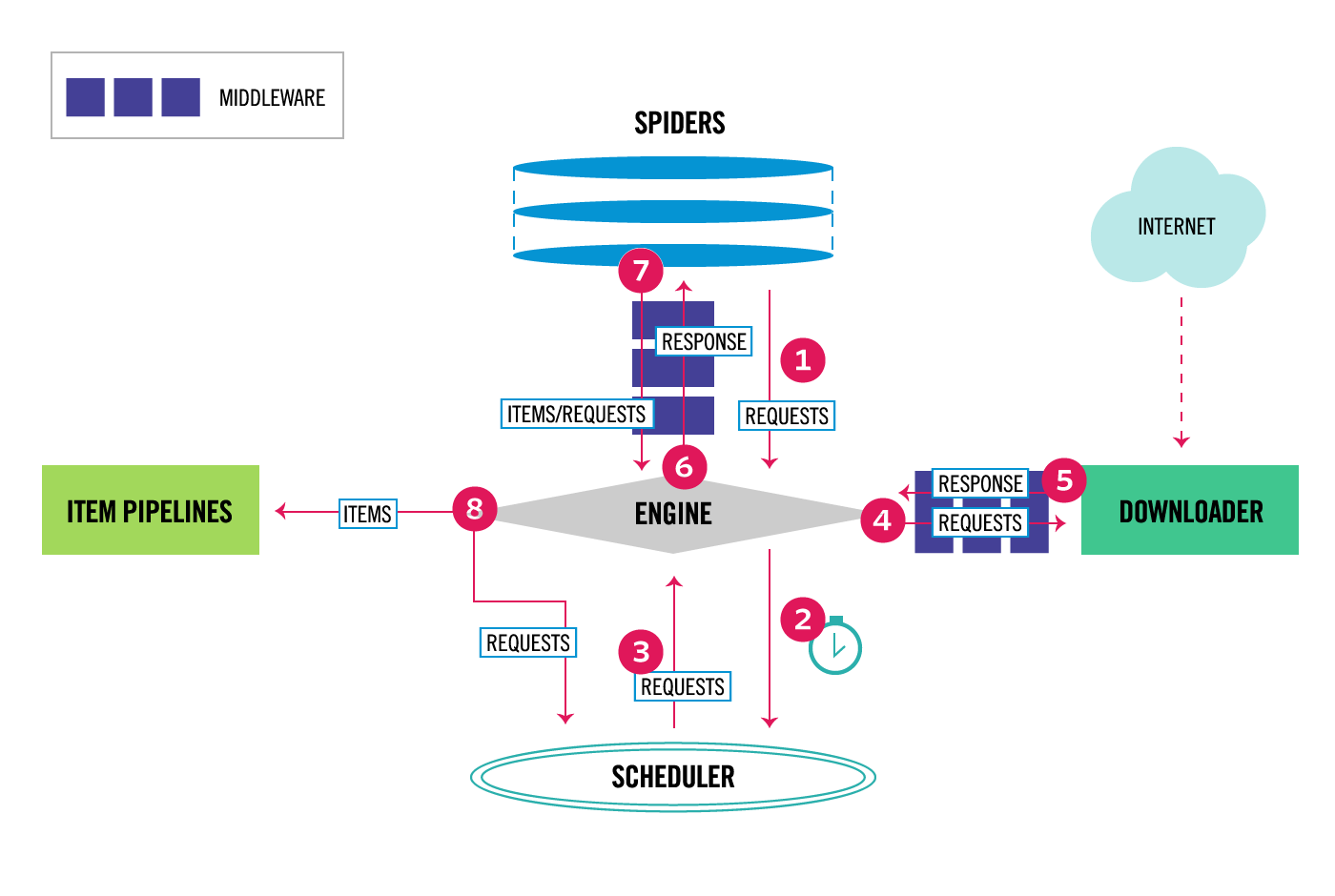

scrapy组件

ENGINE从SPIDERS中获取初始请求任务RequestsENGINE得到Requests之后发送给SCHEDULER,SCHEDULER对请求进行调度后产出任务.Scheduler返回下一个请求任务给ENGINEENGINE将请求任务交给DOWNLOADER去完成下载任务, 途径下载器中间件.- 一旦下载器完成请求任务, 将产生一个

Response对象给ENGINE, 途径下载器中间件 ENGINE收到Response对象后, 将该对象发送给SPIDERS去解析和处理, 途径爬虫中间件SPIDER解析返回结果- 将解析结果

ITEMS发送给ENGINE - 生成一个新的

REQUESTS任务发送给ENGINE

- 将解析结果

- 如果

ENGINE拿到的是ITEMS, 那么就会发送给ITEM PIPELINES做数据处理, 如果是REQUESTS则发送给SCHEDULER - 周而复始, 直到没有任务产出

Scrapy教程

-

安装

pip install scrapy -

创建项目

scrapy startproject jd_crawler_scrapy -

目录结构

-

spiders(目录)

存放

SPIDERS项目文件, 一个scrapy项目下可以有多个爬虫实例 -

items

解析后的结构化结果.

-

middlewares

下载器中间件和爬虫中间件的地方

-

piplines

处理items的组件, 一般都在pipelines中完成items插入数据表的操作

-

settings

统一化的全局爬虫配置文件

-

scrapy.cfg

项目配置文件

-

-

scrapy爬虫demo

import scrapy class JdSearch(scrapy.Spider): name = "jd_search" def start_requests(self): for keyword in ["鼠标", "键盘", "显卡", "耳机"]: for page_num in range(1, 11): url = f"https://search.jd.com/Search?keyword={keyword}&page={page_num}" # 选用FormRequest是因为它既可以发送GET请求, 又可以发送POST请求 yield scrapy.FormRequest( url=url, method='GET', # formdata=data, # 如果是post请求, 携带数据使用formdata参数 callback=self.parse_search # 指定回调函数处理response对象 ) def parse_search(self, response): print(response) -

启动爬虫

scrapy crawl spider_name

Scrapy的启动和debug

-

命令行

scrapy crawl jd_search -

启动脚本

# 新建run.py from scrapy import cmdline command = "scrapy crawl jd_search".split() cmdline.execute(command)

Scrapy Item

只是对解析的结构化结果进行一个约束, 在到达pipeline前就可以检查出数据错误.

Scrapy的设置

-

ROBOTTEXT_OBEY

获取对方网站是否允许爬虫获取数据的信息.

-

设置中间件

数字越小, 离

ENGINE越近DOWNLOADER_MIDDLEWARES = { # 'jd_crawler_scrapy.middlewares.JdCrawlerScrapyDownloaderMiddleware': 543, 'jd_crawler_scrapy.middlewares.UAMiddleware': 100, } -

设置PIPELINE

ITEM_PIPELINES = { 'jd_crawler_scrapy.pipelines.JdCrawlerScrapyPipeline': 300, } -

LOG

-

LOG_ENABLE

默认为

True, 是否使用log -

LOG_FILE

设置保存的log文件目录

-

LOG_LEVEL(按严重程序排序)

- CRITICAL

- ERROR

- WARNING

- INFO

- DEBUG

-

Scrapy的中间件

-

请求头中间件

class UAMiddleware: def process_request(self, request, spider): request.headers["user-agent"] = "Mozilla/5.0 (Windows NT 10.0; WOW64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/87.0.4280.141 Safari/537.36"

最后

以上就是自觉发带最近收集整理的关于Scrapy框架基础Scrapy框架基础的全部内容,更多相关Scrapy框架基础Scrapy框架基础内容请搜索靠谱客的其他文章。

发表评论 取消回复