TensorRT自带的trtexec在bin目录下,是一个可执行文件。

目前官方的转换工具 ONNX-TensorRT https://github.com/onnx/onnx-tensorrt

trtexec的用法说明参考 https://blog.csdn.net/qq_29007291/article/details/116135737

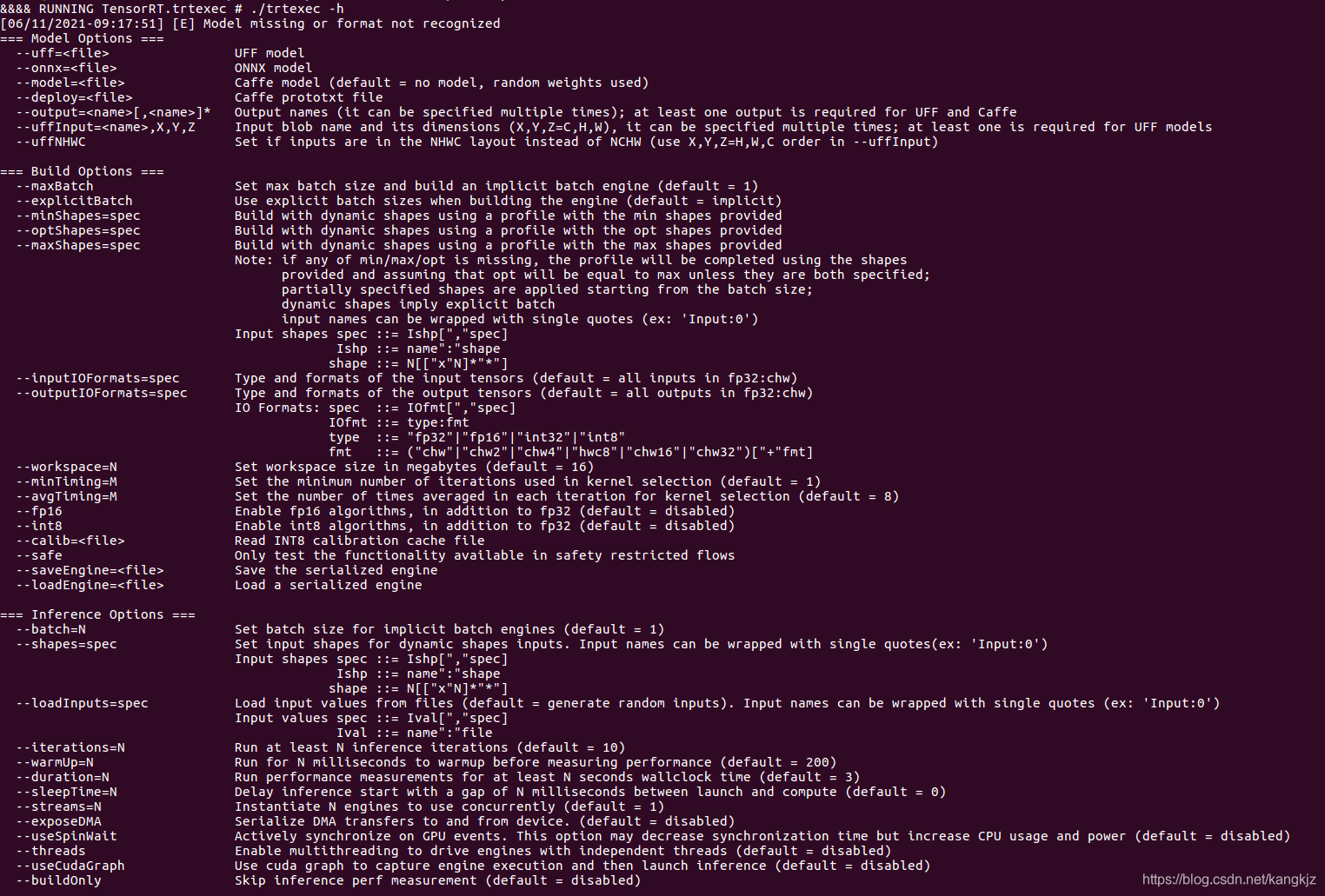

trtexec有两个主要用途:

- 测试网络性能 - 如果您将模型保存为 UFF 文件、ONNX 文件,或者如果您有 Caffe prototxt 格式的网络描述,您可以使用 trtexec 工具来测试推理的性能。 注意如果只使用 Caffe prototxt 文件并且未提供模型,则会生成随机权重。trtexec 工具有许多选项用于指定输入和输出、性能计时的迭代、允许的精度等。

- 序列化引擎生成 - 可以将UFF、ONNX、Caffe格式的模型构建成engine。

运行./trtexec -h

其中给出了 model options、build options、 inference options和system options等。

上次我们使用TensorRT的pyhton API进行序列化模型和前向推理

最后

以上就是高大唇彩最近收集整理的关于TensorRT用自带trtexec实现onnx转engine的用法说明的全部内容,更多相关TensorRT用自带trtexec实现onnx转engine内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复