[1] Unsupervised Attention-guided Image-to-Image Translation

Youssef A. Mejjati, Christian Richardt, James Tompkin, Darren Cosker, Kwang In Kim

University of Bath, Brown University

https://papers.nips.cc/paper/7627-unsupervised-attention-guided-image-to-image-translation.pdf

目前,无监督的图像到图像的转换方法一般集中在单个物体上,背景是不发生变化的,也不考虑场景中多个物体之间的交互。这篇文章基于人类感知的注意力,提出了一种无监督的注意力机制,其中生成器和判别器对抗式训练。这种方法更加可以注意到图像中相关的区域,进而可以生成更加真实的映射。

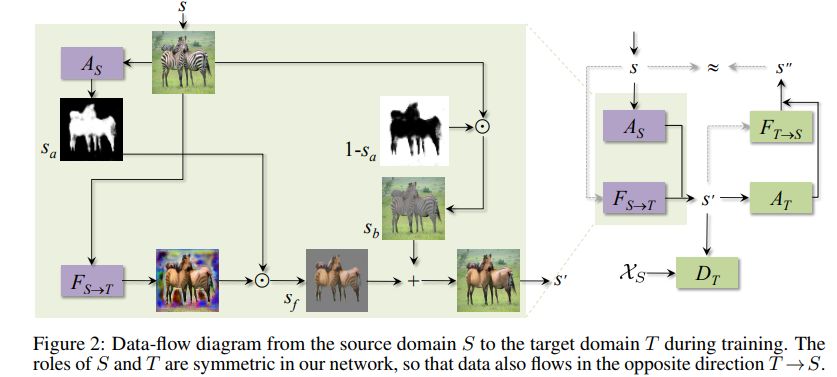

源域到目标域的数据流示例如下

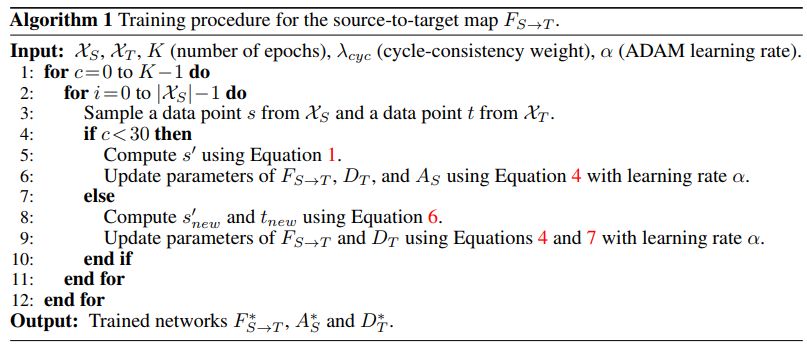

训练过程伪代码如下

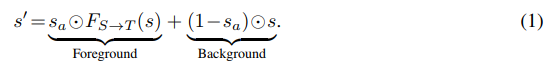

其中1式为

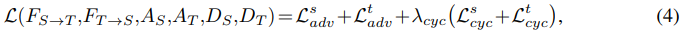

4式为

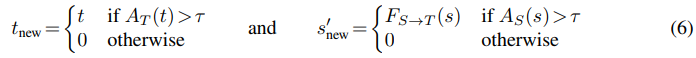

6式为

7式为

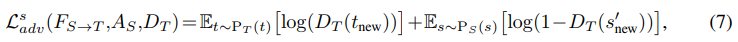

几种算法的效果对比如下

DiscoGAN对应的论文为

Learning to discover cross-domain relations with generative adversarial networks. JMLR 2017.

RA对应的论文为

Residual attention network for image classification. CVPR 2017

代码地址

https://github.com/fwang91/residual-attention-network

DualGAN对应的论文为

DualGAN: Unsupervised dual learning for image-to-image translation. ICCV 2017

UNIT对应的论文为

Unsupervised image-to-image translation networks. NIPS 2017

CycleGAN对应的论文为

Unpaired image-to-image translation using cycle-consistent adversarial networks. ICCV 2017

代码地址

https://junyanz.github.io/CycleGAN/

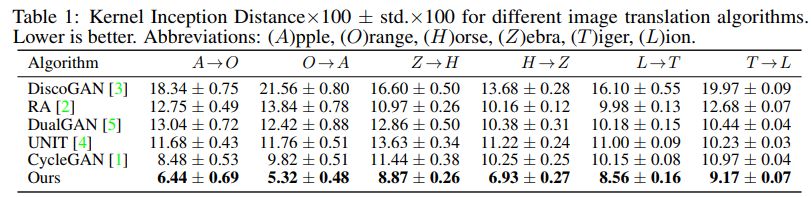

不同情况下算法效果对比如下

代码地址

https://github.com/AlamiMejjati/Unsupervised-Attention-guided-Image-to-Image-Translation

我是分割线

我是分割线

[2] Lipschitz regularity of deep neural networks: analysis and efficient estimation

Kevin Scaman, Aladin Virmaux

Huawei Noah’s Ark Lab

https://papers.nips.cc/paper/7640-lipschitz-regularity-of-deep-neural-networks-analysis-and-efficient-estimation.pdf

深度学习对小的扰动比较敏感,对这种结构的正则性进行估计对于安全和鲁棒的实际应用十分重要。

这篇文章研究了估计正则性的关键特性,即深度学习结构的利普希茨常数。即使对于两层的神经网络,该量的精确计算就是np难的,而且当前最好的方法也有可能明显高估该值。作者们利用autolip对之前的估计方法进行扩展和改善。autolip是对任意自动可微函数的利普希茨常数的上界进行估计的第一个通用算法。基于自动微分的幂算法计算效率较高,即使在大的卷积操作也是如此。

对于序列神经网络,作者们提出一种改进算法,seqlip,该算法可以将线性计算图的优势集成进来,然后每对连续的层的计算可以分割开来。另外,针对特别大的网络,作者们在seqlip的基础上还提出了启发式方法。

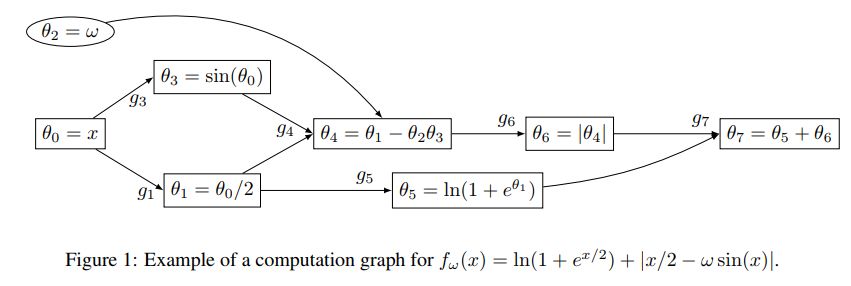

计算图示例如下

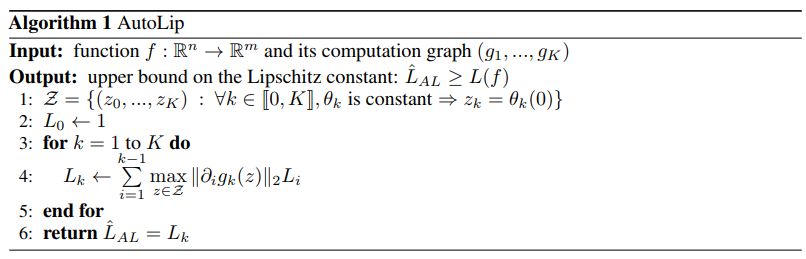

autolip算法伪代码如下

AutoGrad一致幂方法伪代码如下

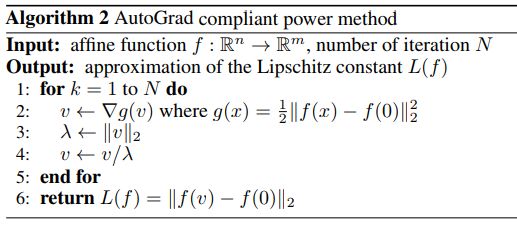

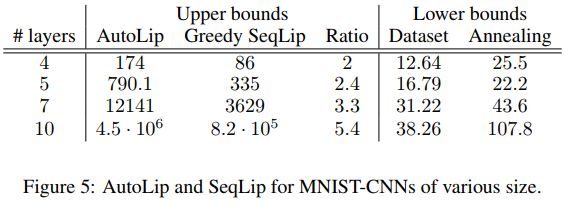

不同情况下autolip和seqlip的效果对比如下

代码地址

https://github.com/avirmaux/lipEstimation

我是分割线

我是分割线

[3] Deep Generative Markov State Models

Hao Wu, Andreas Mardt, Luca Pasquali, and Frank Noe

Freie Universität Berlin, Tongji University

https://papers.nips.cc/paper/7653-deep-generative-markov-state-models.pdf

这是同济第一篇nips?

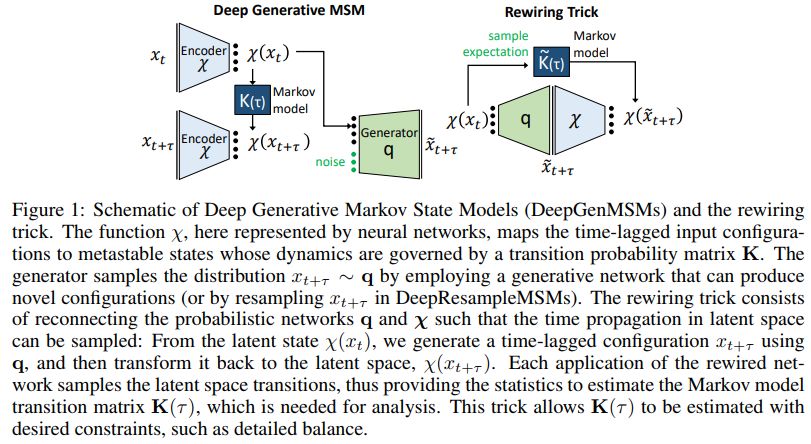

这篇文章提出一种深层生成式马尔科夫状态模型学习框架,DeepGenMSM,该框架可以对亚稳动态系统进行推理,也可以对轨道进行预测。

该模型对时间序列数据进行无监督训练后,可以得到:

概率编码,该编码将高维配置空间映射到标示亚稳长存状态的所属的低维向量;

马尔科夫链,该链条管理着亚稳状态之间的转换,有利于长存动态的分析

生成式部分,这部分可以对下一步配置的条件分布进行采样。

该模型可以递归的调用,进而生成轨迹来预测系统来自既定开始状态的进化,还可以提出新的配置。该模型可以提供长时间动力学的精确估计,并且对分子动力学基准系统可以生成有效的分布。

模型结构示例如下

代码地址

https://github.com/markovmodel/deep_gen_msm

我是分割线

我是分割线

您可能感兴趣

最后

以上就是忐忑酸奶最近收集整理的关于NIPS2018深度学习(11)|亮点: 注意力模型; GAN; 马尔科夫状态模型(论文及代码)的全部内容,更多相关NIPS2018深度学习(11)|亮点:内容请搜索靠谱客的其他文章。

发表评论 取消回复