0. 个人浅谈

Attention是在2014年提出的(paper为:Recurrent Models of Visual Attention,下载地址为https://papers.nips.cc/paper/5542-recurrent-models-of-visual-attention.pdf),而本文的发表时间是在2016年,它是ACL会议(NLP国际顶级会议之一)的录用论文(具有一定的研究意义),显而易见的是它是把attention应用到到NLP的关系抽取中的一个成功实践。所以对于AI学习者而言,学习最新的技术,然后将其应用到自己所在的工作领域,这是一件非常有趣的事情。

1. 摘要

关系抽取是自然语言处理领域中一个非常重要的语义处理任务(除了语义处理,还有其他任务吗?)。然而,已有的系统使用词法资源(如WordNet)或者依赖于解析器和命名实体识别获得的高级特征。另外一个挑战是,重要的信息可能出现在句子中的任意位置。为了解决这些问题,我们提出了基于注意力机制的LSTM网络,从而可以获取句子中最重要的语义信息。我们采用的实验数据是SemEval-2010关系分类任务数据,实验结果表明我们的方法优于现有的方法。

2. 引言

关系分类是寻找名词对之间的语义关系任务,它对于很多NLP应用都很有用,例如信息提取、知识问答。例如,下面的句子包括了Flowers和chapel的实体对。

⟨e1⟩ Flowers ⟨/e1⟩ are carried into the ⟨e2⟩ chapel ⟨/e2⟩.

其中⟨e1⟩, ⟨/e1⟩, ⟨e2⟩, ⟨/e2⟩ 是位置的标识符,它标识了实体的开始和结束。传统的关系分类是从词法资源中构造手工造特征,然后进行模式匹配,它的效果还可以。该方法的问题在于,很多的NLP系统提取了一些高级特征,例如词性标注、最短依赖路径、命名实体识别,但这会导致计算成本和误差的增大。另外一个缺点在于,手造特征不仅耗时,而且通用性较差。最近,部分研究者采用了深度学习方法,从而降低了手造特征的数量。然而这些方法还是使用了词法资源,例如WordNet或者其他高级特征。本文提出了一种新型的网络结构,从而可用于关系分类。该方法不需要任何词法资源。

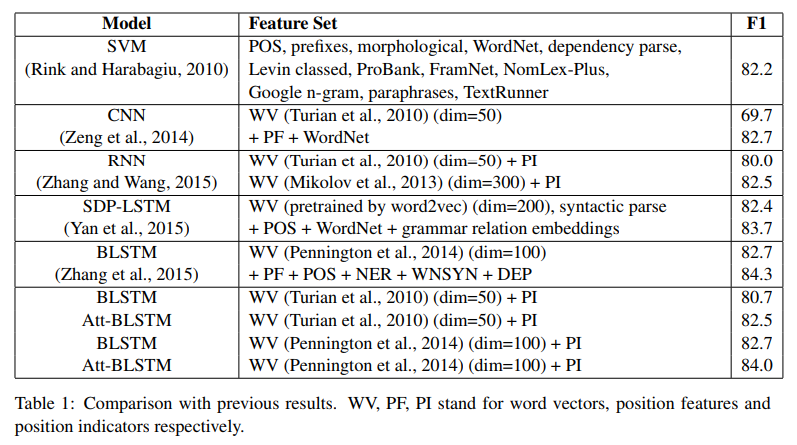

本文的贡献在于自动提取重要的单词,而没有应用额外的知识和NLP系统。在SemEval-2010第八个任务的数据集上进行实验,F1 score为84%,超过了现有的方法。

3. 相关工作

这些年来,产生了各种用作关系分类的方法。大多数的是采用模式匹配的方法,并且利用了额外的NLP系统去提取词法特征。其中一个方法是由Rink and Harabagiu在2010年提出的,该方法是从其他语料库提取多个特征,然后使用SVM进行分类。

近些年来,深度神经网络自动学习特征,并且在各种文献中使用。最有代表性的是由Zeng在2014年提出的,他使用CNN进行关系分类。 然而CNN不太适合用来学习长距离的语义信息,因此我们的方法是基于RNN。

其中和RNN相关的一个工作是由 Zhang和Wang在2015年提出的,使用双向RNN从原始文本数据中提取特征。尽管双向RNN可以提取双向的上下文信息,但它容易产生梯度消失的问题。为了克服这个问题,在1997年,Hochreiter和Schmidhuber提出了长短期记忆网络。

在2015年Yan也提出了SDP-LSTM模型。该模型利用了两个实体的最短依赖路径,沿着该路径使用LSTM单元提取异构信息。然而我们的方法针对的是原始文本数据。

而我们的工作是基于Zhang提出的双向LSTM模型。该模型利用了NLP的工具和词法资源去获取单词、位置、词性标注、命名实体识别、依赖解析和上位词特征,然后输入到LSTM单元,最终实现了很好的效果。然而他提出的特征过于复杂,而我们的方法把四个位置标志( ⟨e1⟩,⟨/e1⟩,⟨e2⟩,⟨/e2⟩ )作为单独的词,并且把所有的词表示成词向量,虽然简单但效果也很好。

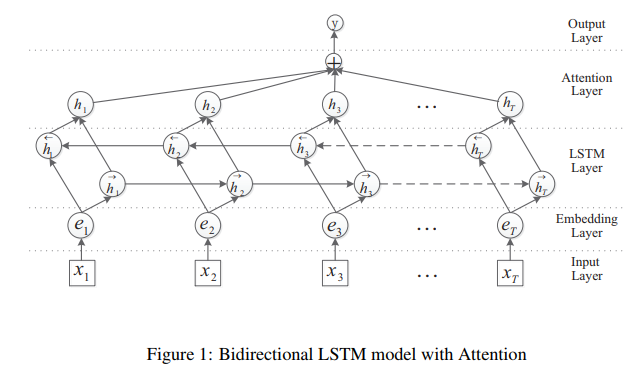

4. 模型

在本节中,我们提出了基于注意力机制的双向LSTM模型。该模型包括5个组成部分:

- 输入层:将句子输入模型。

- 嵌入层:把每个词映射到低维的向量。

- LSTM层:使用双向LSTM逐步获取高级特征。

- 注意力层,产生一个权重向量,然后通过把权重向量和每个时间步长的词特征相乘,合并为句子级别的特征向量。

- 输出层,句子级别的特征向量最终用来特征分类。

4.1 Word Embeddings

给定一个由若干个词组成的序列,将每个词转换成一个实数向量。通过查表得到句子的嵌入矩阵

W

w

r

d

W^{wrd}

Wwrd。该矩阵W是学习的参数,每个词词嵌入的维度是一个超参数,需要用户提前指定。我们把每个单词

x

i

x_i

xi 转换为词嵌入

e

i

e_i

ei,是通过矩阵向量运算得到的。

e

i

=

W

w

r

d

v

i

e_i = W^{wrd}v_i

ei=Wwrdvi

其中

v

i

v_i

vi是一个独热向量,只在

e

i

e_i

ei的位置为1,其它位置均为0。所以句子可以表示为向量

e

m

b

s

=

{

e

1

,

e

2

,

…

,

e

T

}

emb_s={e_1,e_2,dots,e_T}

embs={e1,e2,…,eT}。

4.2 双向LSTM网络

LSTM单元是由Hochreiter和Schmidhuber在1997年提出的,它是为了解决梯度消失的问题(并不能解决梯度爆炸的问题)。它的主要想法是采用适应门机制,它决定LSTM单元保持之前状态和从当前输入数据从提取特征的程度。有很多LSTM的变种也被提出了,如GRU,它是把输入门和遗忘门合并为了一个门。

具体步骤就不做阐述了,可参考链接https://blog.csdn.net/herosunly/article/details/89554214 。值得注意的是,最终是把双向LSTM的输出加到了一起。

4.3 Attention

基于注意力机制的神经网络在很多任务中都取得了极大的成功,如知识问答,机器翻译等。在这个小节中,我们提出了关系分类任务中的注意力机制。假设H是由LSTM产生的多个向量组成的,即

H

=

[

h

1

,

h

2

,

…

,

h

T

]

H = [h_1,h_2,dots,h_T]

H=[h1,h2,…,hT],其中T是句子的长度(Pytorch文档中RNN的输出维度为output of shape (seq_len, batch, num_directions * hidden_size,其中seq_len指代的就是句子的长度)。句子的表示是由这些输出向量的加权和。

M

=

t

a

n

(

H

)

M = tan(H)

M=tan(H)

α

=

s

o

f

t

m

a

x

(

W

T

M

)

alpha =softmax(W^TM)

α=softmax(WTM)

r

=

H

α

T

r=Halpha^T

r=HαT

我们获取句子级别的特征用来进行分类:

h

∗

=

t

a

n

h

(

r

)

h^∗ = tanh(r)

h∗=tanh(r)

4.4 分类

采用softmax计算每个类别的概率,并以概率最大的作为预测的关系。在本文中,我们采用L2正则化和dropout去缓解过拟合。

5. 实验

5.1 实验数据说明

实验数据为SemEval-2010第八个任务的数据集。该数据集包括了9种关系。包括了10,717个数据,其中8000个句子用于训练,而2717个数据用于测试。评价指标为F1,并且考虑关系的方向性。

采用了50维的词向量和100维的词向量分别进行测试。其中50维向量是为了和Zhang、Wang (2015)的工作进行比较,它是由Turian在2010年提出的,然后将它作为嵌入层的初始化。

由于没有官方提供的验证集,我们随机选取800个句子进行验证。超参数是在验证集中进行搜索得到的。我们的模型所使用的是AdaDelta优化方法,并且学习率为1.0,batch size为10。L2正则化的强度为10^-5。其它的参数是随机初始化产生的。

5.2 实验结果

6. 结论

在本篇论文中,我们提出了一个新的神经网络模型,用来进行分类。该模型不依赖NLP工具或者其它的词法资源,使用的是原始的文本数据和位置标识作为输入。

最后

以上就是唠叨龙猫最近收集整理的关于Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification 论文研读0. 个人浅谈1. 摘要2. 引言3. 相关工作4. 模型5. 实验6. 结论的全部内容,更多相关Attention-Based内容请搜索靠谱客的其他文章。

![[ACL2016]Attention-Based Bidirectional Long Short-Term Memory Networks for Relation Classification](https://www.shuijiaxian.com/files_image/reation/bcimg14.png)

发表评论 取消回复