当机器中存在多个设备可以支持tensorflow时,tensorflow会根据版本不同自动检测使用默认设备进行运算操作,也可以通过手动指派tensorflow中数据运行的支持设备。

tensorflow中设备格式:cpu ---'/cpu:0' '/cpu:1'

gpu---'/gpu:0' '/gpu:1' '/gpu:2'

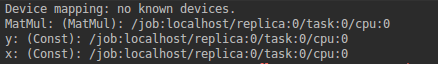

查看变量或运算在那个设备上的设置:log_device_placement

sess = tf.Session(config=tf.ConfigProto(log_device_placement=True))不同版本的tensorflow默认的设备可能不一样,这里默认使用的是cpu设备

一.手动指定设备

通过with tf.device可以指定运行设备

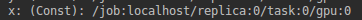

with tf.device('/gpu:0'):

x = tf.constant([1.0, 2.0], shape=[1, 2], name='x')

二.设备不存在时设置

当指派的设备不存在时通过设置allow_soft_placement来避免报InvalidArgumentError 错

sess = tf.Session(config=tf.ConfigProto(

allow_soft_placement=True, log_device_placement=True))三.多GPU集群训练

通过tf.device(d)来指定运行设备。

ops = []

for d in ['/gpu:2', '/gpu:3']:

with tf.device(d):

a = tf.constant([1.0, 2.0], shape=[1, 2])

b = tf.constant([1.0, 2.0], shape=[ 2,1])

ops.append(tf.matmul(a, b))

with tf.device('/cpu:0'):

sum = tf.add_n(ops)

sess = tf.Session(config=tf.ConfigProto(log_device_placement=True))

print sess.run(sum)多GPU集群训练需要将模型参数更新和梯度均值计算放在cpu完成,不同GPU上计算不同数据,整体数据都计算完后到cpu中累计求均值。

(注:完全异步计算会产生次优训练效果,而完全同步又会出现训练速度太慢的现象,所以采用多GPU集成训练是当前比较合适的方法)

最后

以上就是无奈手链最近收集整理的关于Tensorflow GPU使用综述的全部内容,更多相关Tensorflow内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

![[实时渲染] 3.1 GPU管线综述](https://www.shuijiaxian.com/files_image/reation/bcimg13.png)

发表评论 取消回复