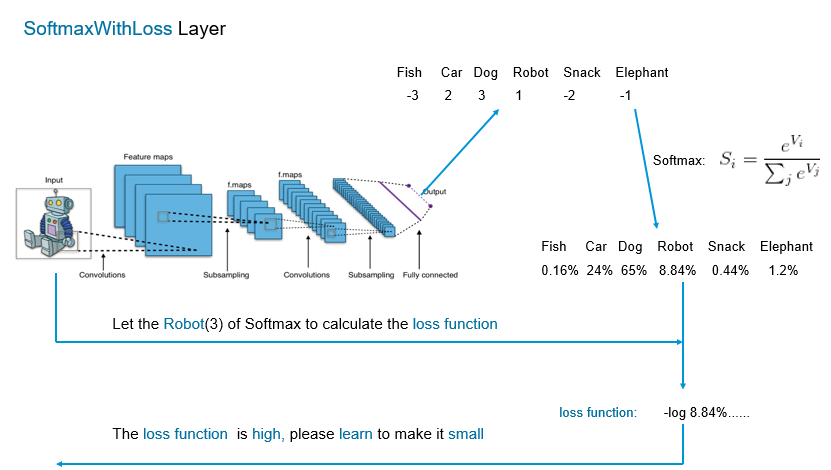

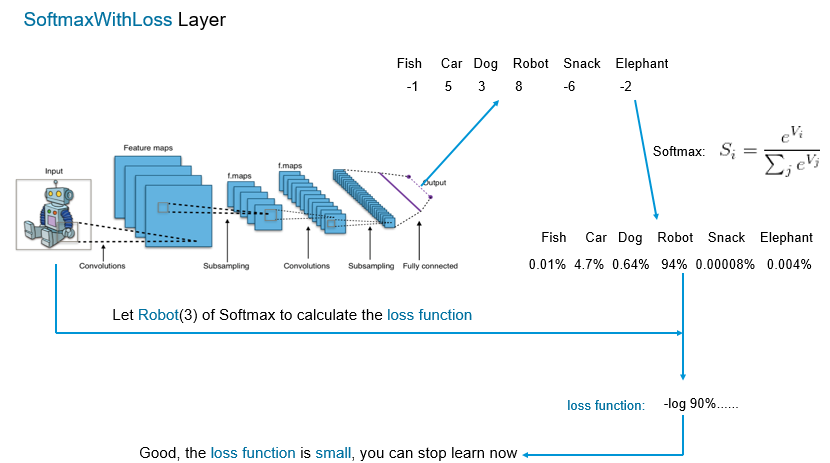

为了更好的理解SoftMaxWithLossLayer, 绘制了如上的示意图,SoftMaxWithLossLayer主要使用了两个概率统计原理:逻辑回归和最大似然估计。

逻辑回归对应于SoftMax,其将神经网络的输出特征(即output输出的一串数字,有多少个种类就有多少个数字)转化成概率。这样做的好处有:

1、保证数字越大概率越大;

2、得到的所有类的所占概率之和为1.

3、将负数转化成小于1的正数,对最后的loss function有放大的作用(loss function前面有负号),实现反例的功能。

将正数转化成大于1的数,对最后的loss function有缩小的作用,实现正例的功能。

最大似然估计用于计算损失函数,根据最大似然估计原理,选择的模型应使得观察到的事件的概率最大。其中选择的模型即cnn训练出的模型,观察的事件即该图片对应的label(label由人为的指定)。

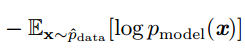

根据最大似然估计计算出的损失函数的数学公式为:

另外,损失函数并不是单张图片求得的损失函数,一般使用mini batch进行训练, 因此是n张图片的损失函数。SoftMaxWithLossLayer进行分类的好处给定一张图片,能输出该张图中物体属于每个种类的概率,

因此最后输出层有多少个特征,网络就能识别多少种类。但是若需要识别的种类很多时,输出特征就很大。

转载于:https://www.cnblogs.com/Tron/p/7308326.html

最后

以上就是谦让黄豆最近收集整理的关于理解softMaxWithLoss层的全部内容,更多相关理解softMaxWithLoss层内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复