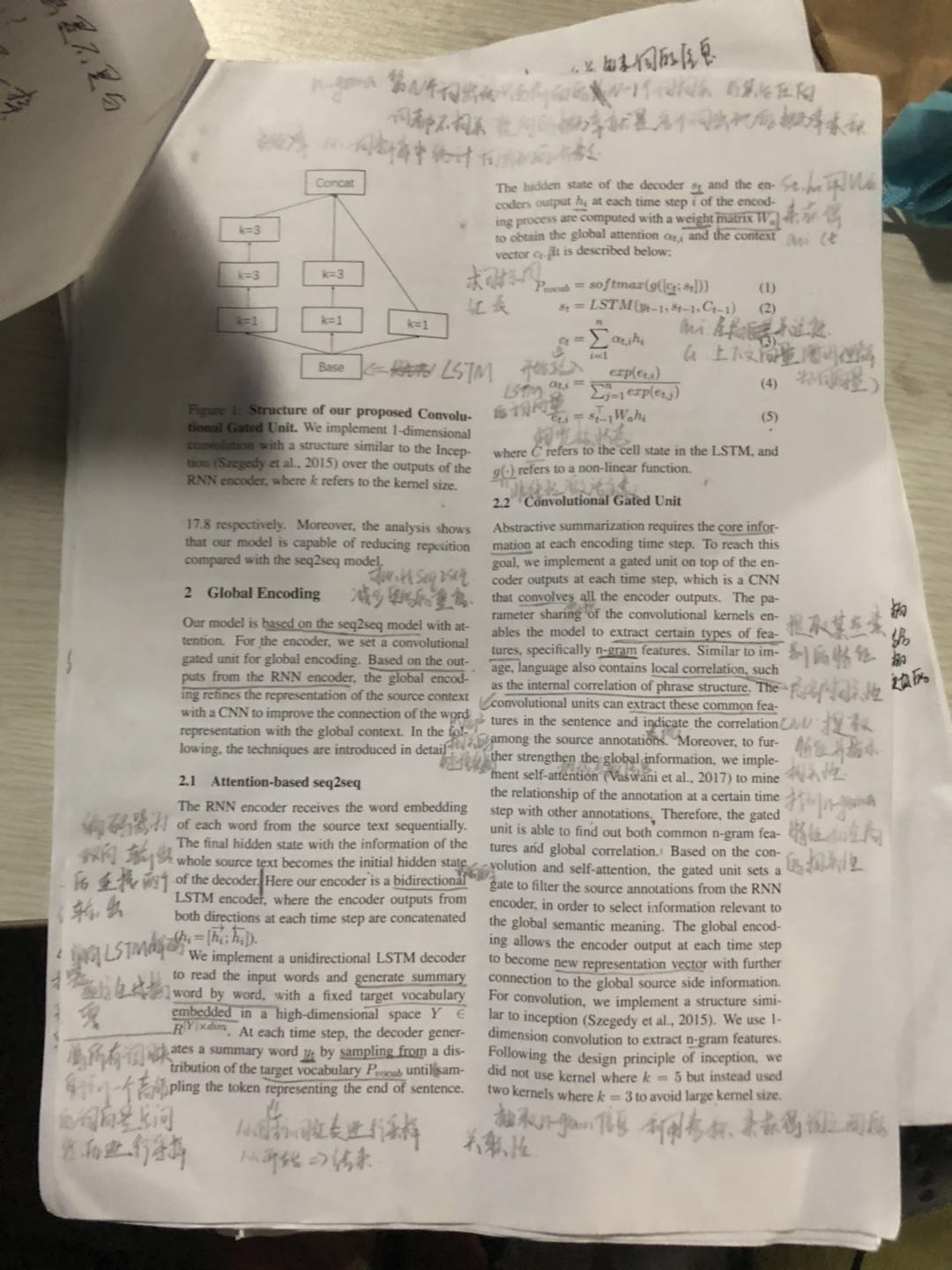

1.Attention-based seq2seq

e(t,i):求上一时刻的输出和这一时刻编码器的输出的相似度

a(t,i):求这个词在整个文本中占多大的比重,每个时刻都存在着一个值,这个只是求一个softmax

c(t):文本向量,求和,n代表序列长度,每个词都有一个softmax值,用每一个概率值去乘以隐变量,这个隐变量就是最初的文本向量,这个概率值就是每个词在整个文本中占多大的比重,结果就是一个最终的文本向量

s(t):解码器

P(vocal):求出的是一个概率值,表示多大概率取到哪一个词(然后根据这个概率值去字典中进行采样)

转载于:https://www.cnblogs.com/callyblog/p/9452366.html

最后

以上就是大方楼房最近收集整理的关于Global Embedding 理解的全部内容,更多相关Global内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复