1 前言

tensorflow中定义了3个交叉熵损失函数:

-

softmax_cross_entropy_with_logits(logits, labels)

-

softmax_cross_entropy_with_logits_v2(logits, labels)

-

sparse_softmax_cross_entropy_with_logits(logits, labels)

其中logits都是未经激活函数(sigmoid、tanh、relu)和softmax放缩后的神经网络输出值,labels为样本标签(真实值);

1和2应用差不多,函数1不太严格,在新版本中将被淘汰,不建议使用;

1和2中,logits和labels维数相同,并且labels采用one-hots编码,比如mnist数据集中,有3个样本标签[1 5 8],采用one-hot编码为:[[0 1 0 0 0 0 0 0 0 0], [0 0 0 0 0 1 0 0 0 0], [0 0 0 0 0 0 0 0 1 0]],如果labels不是采用one-hot编码,需要采用tf.one_hot(y, 10) 函数转换为one-hot编码格式;

3中,logits和labels维数不相同,labels没有采用one-hot编码,若已编码,需采用tf.argmax(y,1) 还原为原格式;

这3个函数都封装了如下两个函数:

- y_=softmax(z) (z为神经网络输出值)

- cross_entropy=-ylog(y_) (y为标签)

2 实验

import tensorflow as tf

#真实值(标签值)

y=tf.constant([[1.,0.,0.],[0.,1.,0.],[0.,0.,1.],[1.,0.,0.]])

#未经激活函数和softmax放缩后的神经网络输出值

z=tf.constant([[1.,5.,9.],[8.,7.,3.],[6.,7.,5.],[2.,8.,4.]])

#使用softmax(z)函数和-y*log(y_)函数计算交叉熵

y_=tf.nn.softmax(z)

cross_entropy1 =-y*tf.log(y_)

#计算cross_entropy1的行和

cross_entropy12=tf.reduce_sum(cross_entropy1,1)

#使用softmax_cross_entropy_with_logits函数计算交叉熵

cross_entropy2=tf.nn.softmax_cross_entropy_with_logits(logits=z, labels=y)

#使用softmax_cross_entropy_with_logits_v2函数计算交叉熵

cross_entropy3=tf.nn.softmax_cross_entropy_with_logits_v2(logits=z, labels=y)

#使用sparse_softmax_cross_entropy_with_logits函数计算交叉熵

cross_entropy4=tf.nn.sparse_softmax_cross_entropy_with_logits(logits=z, labels=tf.argmax(y,1))

with tf.Session() as sess:

c1=sess.run(cross_entropy1)

c12=sess.run(cross_entropy12)

c2=sess.run(cross_entropy2)

c3=sess.run(cross_entropy3)

c4=sess.run(cross_entropy4)

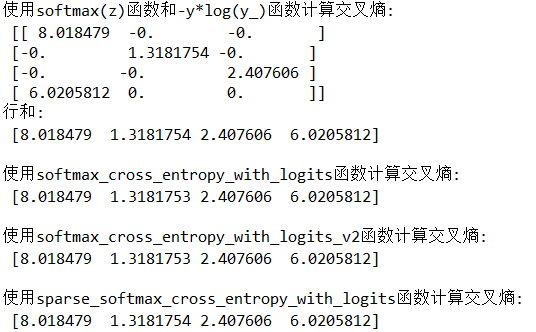

print("使用softmax(z)函数和-y*log(y_)函数计算交叉熵:n",c1)

print("行和:n",c12)

print("n使用softmax_cross_entropy_with_logits函数计算交叉熵:n",c2)

print("n使用softmax_cross_entropy_with_logits_v2函数计算交叉熵:n",c3)

print("n使用sparse_softmax_cross_entropy_with_logits函数计算交叉熵:n",c4)

3 注意事项

在进行分类时,网络输出值z并不是最终的类别,需要进行如下操作:

#softmax压缩变换

y_=tf.softmax(z)

#精确度

correct_prediction=tf.equal(tf.argmax(y_,1),tf.argmax(y,1))

accuracy=tf.reduce_mean(tf.cast(correct_prediction,tf.float32))由于softmax()只是将数据整体压缩,并不改变数据的相对大小,因此,一些教材或网课在计算预测分类和精确度时,为简化计算,省去了softmax函数,如下:

#精确度

correct_prediction=tf.equal(tf.argmax(z,1),tf.argmax(y,1))

accuracy=tf.reduce_mean(tf.cast(correct_prediction,tf.float32))最后

以上就是笑点低老虎最近收集整理的关于tensorflow中交叉熵损失函数详解1 前言2 实验3 注意事项的全部内容,更多相关tensorflow中交叉熵损失函数详解1内容请搜索靠谱客的其他文章。

发表评论 取消回复