文章目录

- 0. 前言

- 1. 要解决什么问题

- 2. 用了什么方法

- 3. 效果如何

- 4. 还存在什么问题&有什么可以借鉴

0. 前言

- 相关资料:

- arxiv

- github

- 论文解读

- 论文基本信息

- 领域:时空行为检测

- 作者单位:慕尼黑工业大学

- 发表时间:2019.11

1. 要解决什么问题

- 主流的时空行为检测方法使用的是类似 Faster R-CNN 的结构,这种方法的主要流程是:

- 第一步,生成一系列proposals。

- 第二步,对生成的proposals执行分类操作,并进行 localization refinements。

- 上述结构存在以下问题:

- 生成 action tubes(每一帧都有bbox) 非常耗时,且分类结果非常依赖proposals的质量。

- proposals只关心单个人的特征,而没有考虑多个人之间的相互关系,以及单个人周边信息。

- 使用 two-stage 的方法,分别训练 rpn 与后续的分类网络,并不能确保得到全局最优,可能只能得到局部最优。且训练消耗资源非常多。

2. 用了什么方法

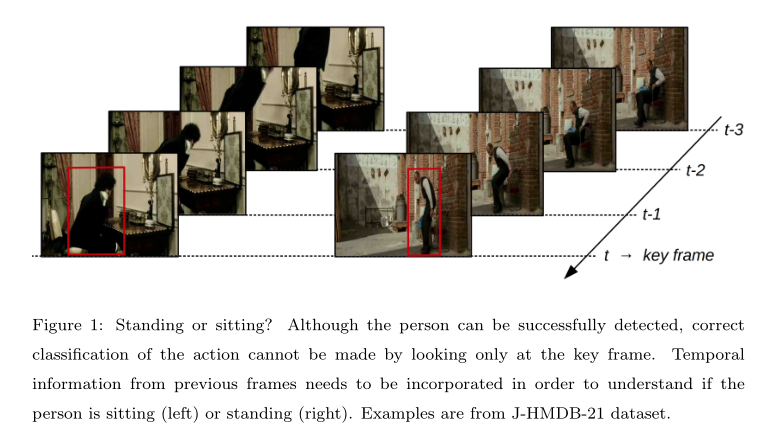

- YOWO的初始灵感来源于人的视觉感知系统

- 人进行行为识别时,只会看到当前帧的信息。

- 为了区分具体行为,会总我们的记忆中获取历史帧的信息。

- 之后,融合当前帧与历史帧信息后,得出最终结论。

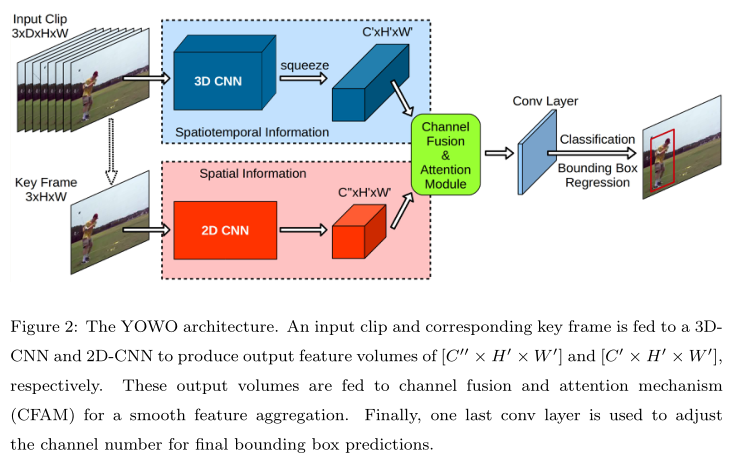

- YOWO 总体结构

- YOWO是single-stage的方法,类似于Yolo在目标检测中的概念。

- 特征提取分为两个分支:

- 3D CNN分支:处理一个clip的数据,使用3D CNN网络提取特征。

- 注意,输出是

C, H, W,temporal 纬度会在特征提取网络中变为1。

- 注意,输出是

- 2D CNN分支:处理一个关键帧的数据,使用2D CNN提取特征。

- 3D CNN分支:处理一个clip的数据,使用3D CNN网络提取特征。

- Channel fusion and attetion mechanism

- 作用:融合上面两个分支的信息。

- 融合好的特征上进行分类与bbox回归操作。

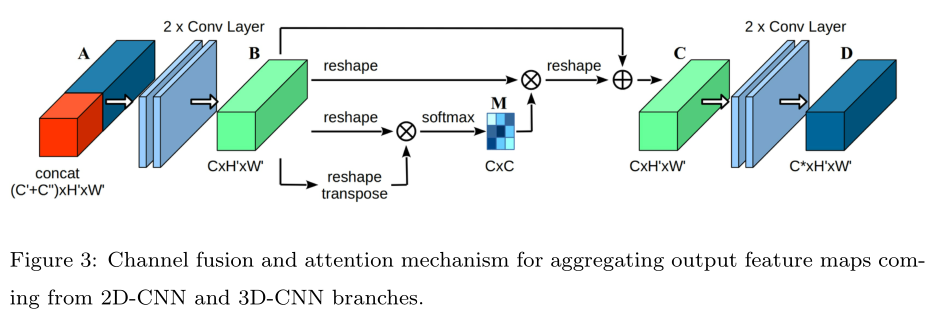

- Channel fusion and attention mechanism 详解

- 结构如下图。

- 输入特征是之前2DCNN/3DCNN concat后的结果。

- 中间有一个注意力机制。

- Linking Strategy

- 注意,需要这一步操作是获取 action tube 时的功能。

- 所谓action tube,指的是每一帧都有bbox,前后帧bbox需要关联。

- AVA数据集并不支持action tube。

- Long-term feature bank

- 保留一些历史数据,从而提高模型精度。

- 因为YOWO期望提高模型运行效率,所以clip中帧数量较少,期望增减LFB来提高精度。

- LFB的输入是3D CNN的输出。

- 我没看懂这句话,需要到代码中研究下:At inference time, 3D features centering the key-frame are averaged and the resulting feature map is used as input to the CFAM block

- 一些实现细节:

- 3DCNN在Kinetics上预训练

- 2DCNN在Pascal VOC上预训练

3. 效果如何

- 性能指标包括两个

- frame-mAP:使用Pascal VOC 2012的指标,猜测就是目标检测的mAP。

- video-mAP:计算 action tube 中每一帧的IOU,当平均IOU大于阈值且行为标签正确时认为是TP。

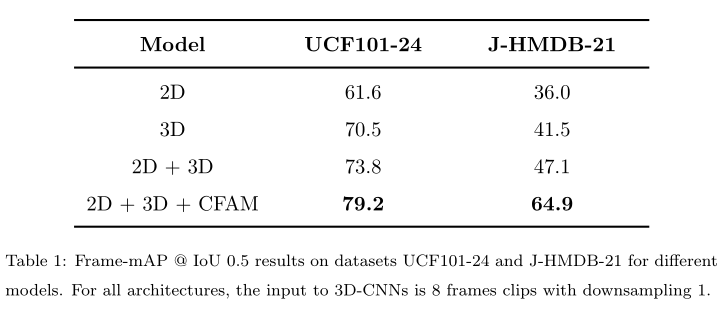

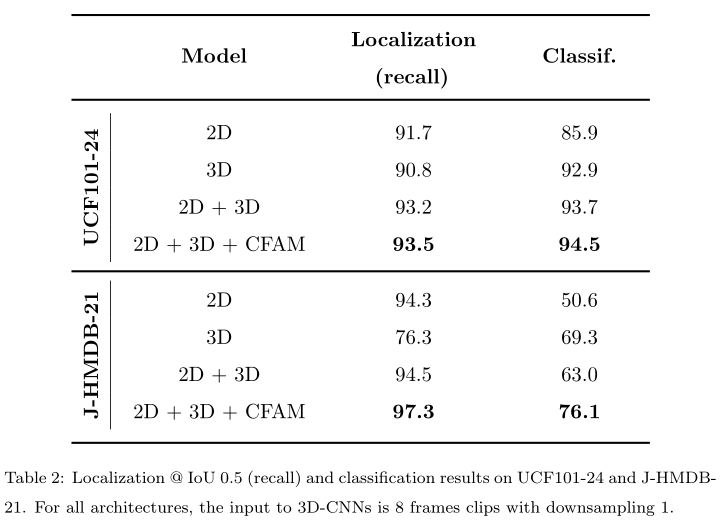

- 在Frame-mAP中,2D+3D+CFAM的效果比单独2D与3D效果好

- 在video-mAP中,2D/3D/CFAM的效果

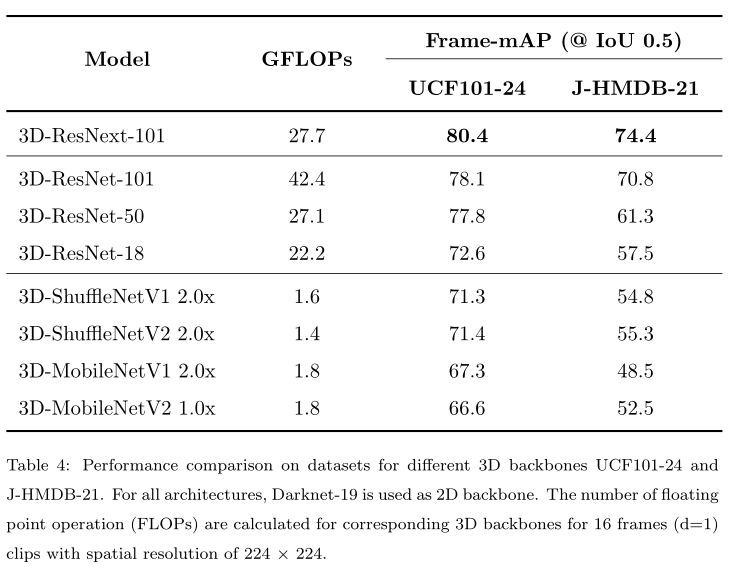

- 对比不同backbone的结果

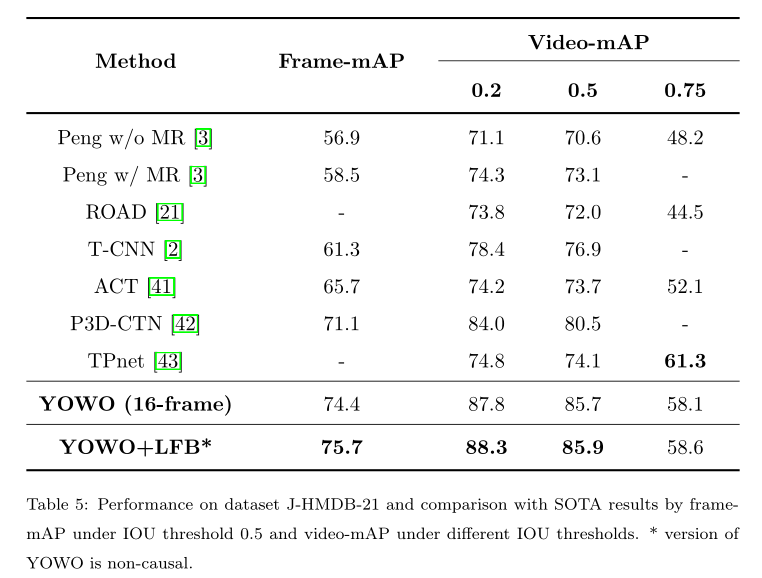

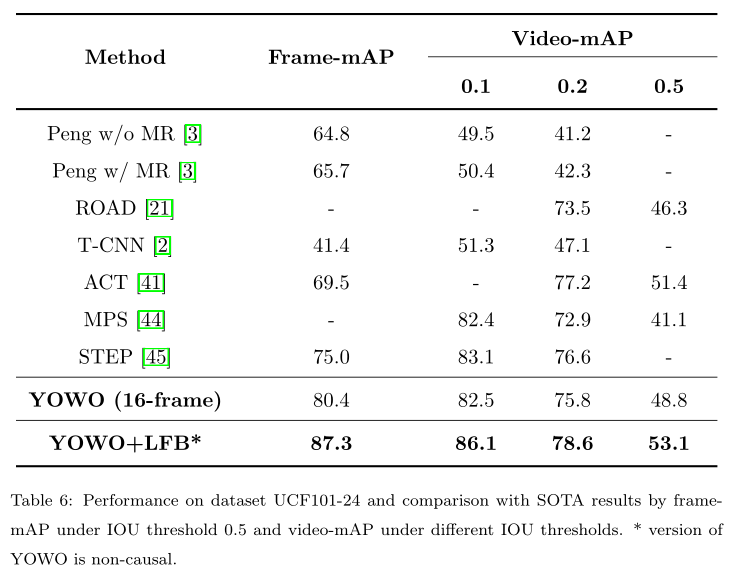

- 与SOTA比较

4. 还存在什么问题&有什么可以借鉴

-

LFB的实现细节需要看源码。

-

关于性能指标,特别是video-mAP,其实还没有完全明白,最好也看下代码。

-

没搞清楚,linking strategy 在online中的作用是啥?

- 感觉在online展示结果的时候,并不需要linking。

- 只有在计算video-mAP的时候才需要linking。

最后

以上就是优雅往事最近收集整理的关于论文浏览(35) You Only Watch Once的全部内容,更多相关论文浏览(35)内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复