一、Hadoop安装前配置

1.创建hadoop用户,设置密码并配置管理员权限

使用命令

sudo useradd -m hadoop -s /bin/bash

创建hadoop用户,并使用/bin/bash作为shell,接着使用命令sudo passwd hadoop来为hadoop用户设置密码,再使用命令

sudo adduser hadoop sudo

为hadoop用户增加管理员权限,接下来在登录界面选择hadoop用户登录,如下图:

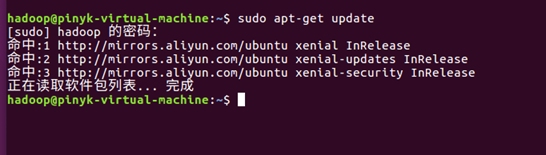

2.更新apt

sudo apt-get update //更新apt防止有某些软件安装不了

如果执行命令时出现error:Hash效验和不符,这是软件源的问题,更改了软件源问题便解决了

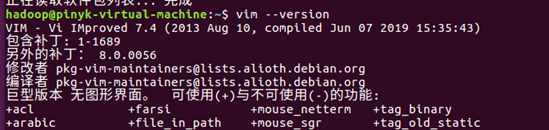

3.安装Vim

sudo apt-get install vim

安装成功可查看版本信息如图:

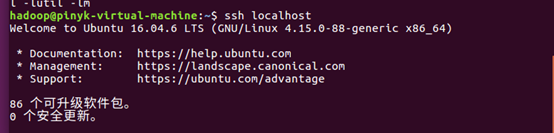

4.安装ssh

sudo apt-get install openssh-server //安装

ssh localhost //安装后登陆

5.关于Java环境的安装配置

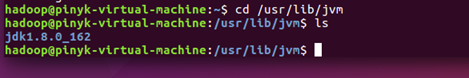

先在官网下载JDK1.8安装包,然后创建/usr/lib/jvm目录用来存放JDK文件,再将压缩包用tar命令解压在创建好的该目录下

sudo tar -zxvf ./jdk-8u162-linux-x64.tar.gz -C /usr/lib/jvm

然后使用命令

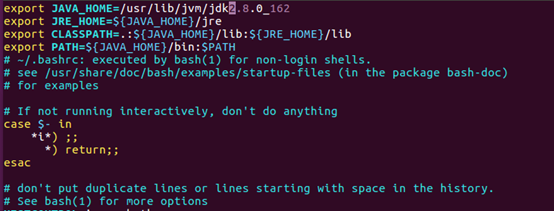

vim ~/.bashrc //设置环境变量

在文件头添加如下几行内容:

export JAVA_HOME=/usr/lib/jvm/jdk1.8.0_162

export JRE_HOME=${JAVA_HOME}/jre

export CLASSPATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib

export PATH=${JAVA_HOME}/bin:$PATH

保存.bashrc文件并退出vim编辑器,使用如下命令让刚刚改好的.bashrc文件生效

source ~/.bashrc

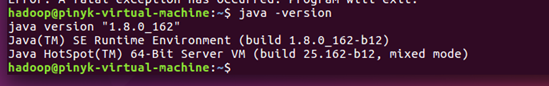

之后检查java是否安装成功

java -version

二、Hadoop安装过程及伪分布式配置

1.在Hadoop官网下载Hadoop压缩包并使用如下命令解压到 /usr/local/下

sudo tar -zxf ~/下载/hadoop-3.1.3.tar.gz -C /usr/local

2.修改文件权限

sudo chown -R hadoop ./hadoop

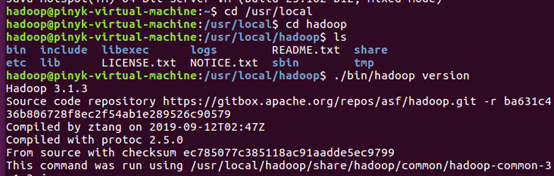

3.使用如下命令检查Hadoop是否能用

cd /usr/local/hadoop

./bin/hadoop version

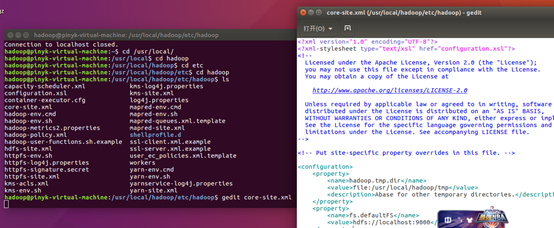

4.进入到/usr/local/hadoop/etc/hadoop路径下,该路径一般用于存放hadoop的配置文件,然后使用gedit来修改core-site.xml文件

gedit ./core-site.xml

在其中的configuration标签内添加以下内容:

<configuration>

<property>

<name>hadoop.tmp.dir</name>

<value>file:/usr/local/hadoop/tmp</value>

<description>Abase for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

</configuration>

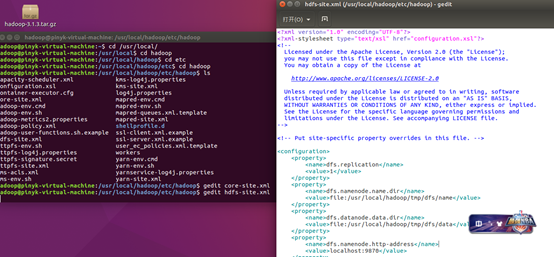

5.用同样的方式修改该目录下hdfs-site.xml文件

gedit ./hdfs-site.xml

在其中的configuration标签内添加以下内容:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/name</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>file:/usr/local/hadoop/tmp/dfs/data</value>

</property>

</configuration>

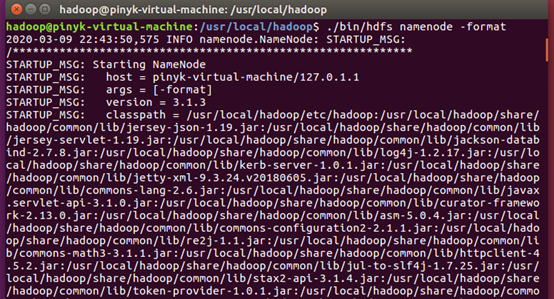

6.回到/usr/local/hadoop路径下使用如下命令对NameNode进行格式化

cd /usr/local/hadoop

./bin/hdfs namenode -format

执行后出现如下图则成功:

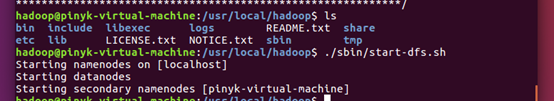

使用以下命令开启NameNode和DataNode的守护进程

cd /usr/local/hadoop

./sbin/start-dfs.sh

执行后如图:

三、Hadoop安装后测试

1.使用jps命令测试是否启动成功

cd /usr/local/hadoop

jps

若成功启动则会列出如下进程: “NameNode”、”DataNode” 和 “SecondaryNameNode”(如果 SecondaryNameNode 没有启动,请运行 sbin/stop-dfs.sh 关闭进程,然后再次尝试启动尝试)。如果没有 NameNode 或 DataNode ,那就是配置不成功,请仔细检查之前步骤,或通过查看启动日志排查原因。

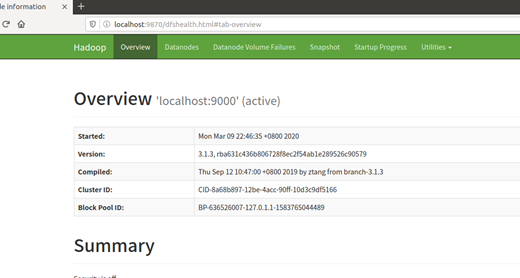

2.在浏览器里面访问localhost:9870检测Web界面是否启动成功,注意3.0版本以上使用端口9870, 2.0的版本用端口50070

本篇教程就介绍到这里,如发现错误或者产生疑问请及时提出

最后

以上就是细腻便当最近收集整理的关于Ubuntu上Hadoop的安装与配置的全部内容,更多相关Ubuntu上Hadoop内容请搜索靠谱客的其他文章。

发表评论 取消回复