基于多任务学习的肿瘤医学影像语义分割与分类研究

文章目录

- 基于多任务学习的肿瘤医学影像语义分割与分类研究

- 1 背景介绍

- 2 主要内容

- 3 材料和方法

- 3.1卷积神经网络

- 多层感知模型(全连接)

- 3.1.1 隐含层

- 卷积过程示意图

- 卷积层示意图

- 最大值池化示意图

- 3.1.2激活函数

- Sigmoid函数

- tanh函数

- ReLU函数

- ELU函数

- PReLU函数

- 3.2 基于U-net的肿瘤图像分割算法

- 经典的U-net网络结构

- 反卷积示意图

- 4 模型介绍

- 4.1 双生网络

- 训练时良恶性分类-鉴别双生网络的输入输出示意图

- 4.2 交替训练网络

- 良恶性分类模型与U-net模型进行参数共享

- 多任务模型I

- 4.3 联合训练网络

- 多任务模型II示意图

- 4.4 损失函数

- 5 总结

1 背景介绍

乳腺癌是女性疾病中常见的癌症,由于乳腺癌发病原因未知,这给诊断和治疗带来了极大的困难。在传统的超声检查中,医生根据超声图像,结合自己的专业知识及临床经验进行诊断,主观性较强,且会受到其他身体组织和阴影等其它干扰,因此会存在漏诊或者误诊,故临床诊断需要引入计算机辅助设计,可以减少人为干预,提高诊断性能。如今大部分计算机辅助设计系统都利用深度学习进行医学图像处理,大部分深度学习算法都需要大量的数据集来支撑模型的训练,以便得到较好的效果,由于乳腺超声图像的特殊性,可**获取的样本很难满足深度学习算法的硬性需求,**故使用一般的深度学习方法进行乳腺超声图像处理时无法取得良好的效果。

2 主要内容

(1)设计了一种交替训练的多任务模型,通过交替训练的方式,在样本较小的情况下,可以挖掘出更多的信息,提高良恶性分类和语义分割的效果。

(2)设计了一种良恶性分类和语义分割的多任务网络,通过直接共享网络层的方式,使两个任务同时学习相关信息,使分类和语义分割的效果更好。同时针对改网络模型设计了联合良恶性分类和语义分割两个损失的损失函数,通过调节两种任务的损失比重,可以防止某个任务比重过大,影响另一个任务的学习。

3 材料和方法

3.1卷积神经网络

卷积神经网络是具有深度结构的前馈神经网络(FNN),本质上是一种输入到输出的映射网络,它可以从大量的数据中学习输入与输出之间的映射关系,只要用已知的模式对卷积神经网络加以训练,就具有输入输出之间的映射能力。主要包含输入层、隐含层及输出层。

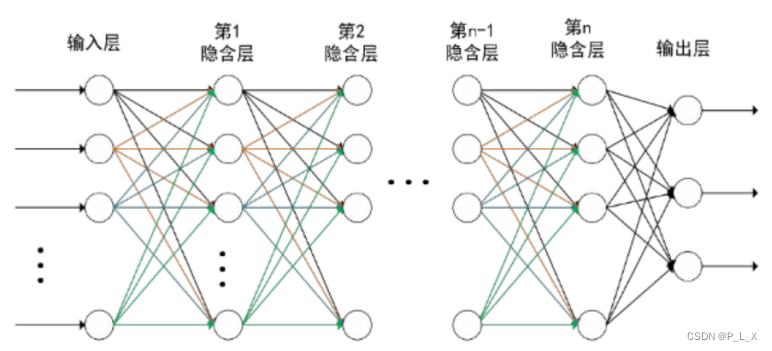

多层感知模型(全连接)

3.1.1 隐含层

卷积层最主要的特点是局部连接和参数共享,局部连接是指卷积核仅与前一节部分节点相连。这种方式减少了参数传递数量,加快了学习速率,同时也在一定程度上减少了过拟合的可能,神经元之间参数共享减少了参数求解。

卷积过程示意图

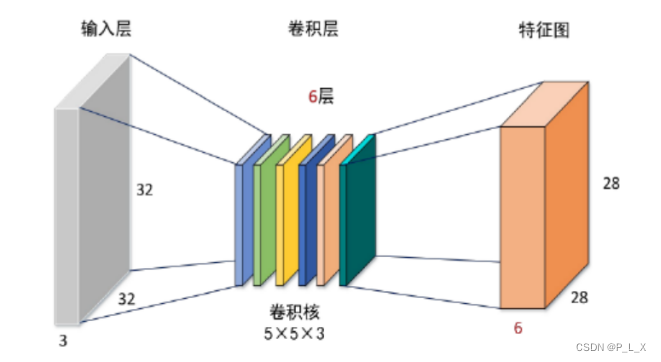

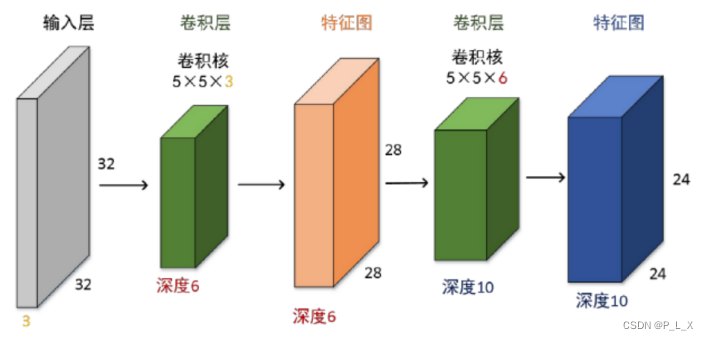

对32×32×3的彩色图像,采用6个(卷积层深度为6)5×5×3的卷积核,步长为1,不进行填充,则得到28×28×6的特征图,接着采用10个5×5×6的卷积核进行运算,得24×24×10的特征图。

卷积层就是对原式特征逐步进行浓缩,最终得到可靠的特征,利用最后一层特征就可以做分割及分类。在卷积神经网络中,一般会在卷积层后加入激活函数,以此来表达非线性因素。

卷积层示意图

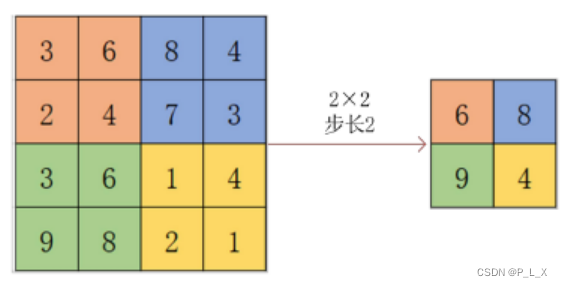

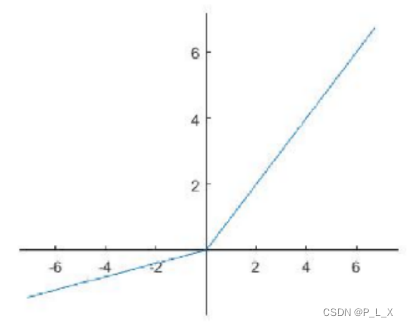

如下图,对于每个2×2的窗口选出最大值进行输出。对比卷积层得到的特征图,池化层对其进行降维,只是去掉图像中无关紧要的信息,留下最能表达图像的特征,可以一定程度上防止过拟合,也可以保持特征的空间不变性,例如旋转、平移、以及尺度等,由此也更方便优化,这样即使输入图像的形状大小发生了变化,池化层也能将这种变化的影响降低。

最大值池化示意图

3.1.2激活函数

激活函数f在于判定每个神经元的输出有没有达到阈值。

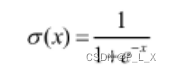

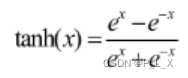

(1)Sigmoid函数

需要进行指数运算,速度慢,进而会影响整个网络的运算速度。

Sigmoid函数

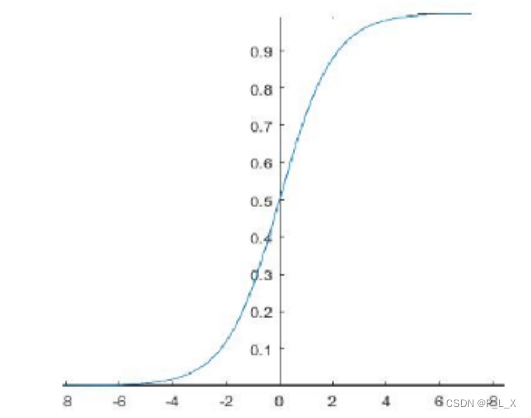

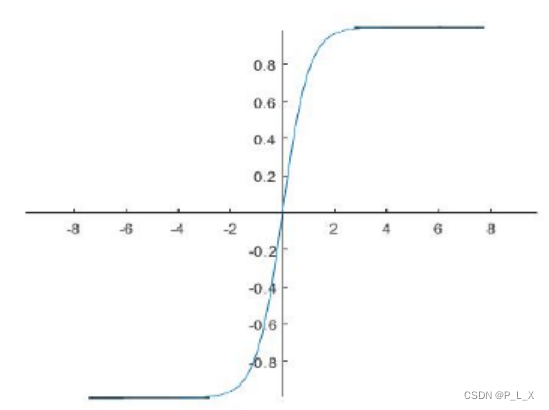

(2)tanh函数

双曲正切函数,大致形状同Sigmoid函数。比Sigmoid函数略好,但在数据较大或较小时,依然存在梯度饱和的问题,计算中也有指数运算影响速度。

tanh函数

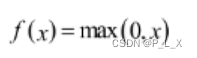

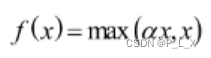

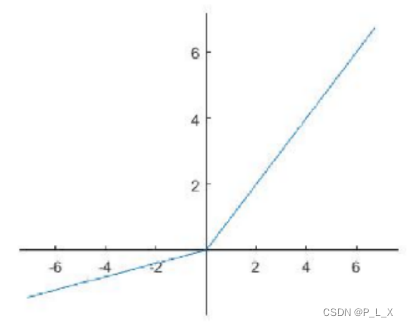

(3)ReLU函数

函数收敛速度快。有两大优点:①在输入为正数的时候,不存在梯度饱和问题,解决了Sigmoid和tanh存在的问题,②相比于上两个激活函数,没有指数运算,计算复杂度低。不足:在前向传播过程中,当输入为负数时,有的区域是敏感的,有的不敏感,但是在训练的反向传播中,当输入为负数时,此时梯度被置零,此神经元有可能再也不会被激活,在后续的训练中将失去作用,故该函数中神经元利用率较低。

ReLU函数

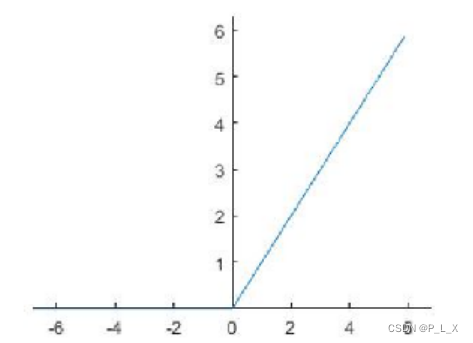

(4)ELU函数

该函数为ReLU函数的改进,参数α一般取0-1。当输入为负数时,有一定的值输出,故该输出具有一定的抗干扰能力,但是依然存在梯度饱和和指数运算的问题。

ELU函数

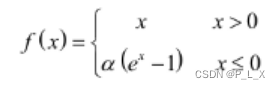

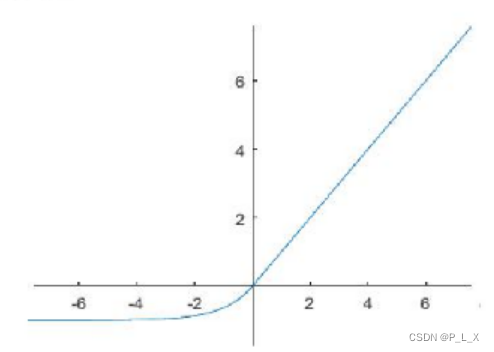

(5)PReLU函数

ReLU函数的另一种改进,在负数区域内,PReLU是斜率为α的一条斜线,可以进行线性运算,避免梯度被置零,无指数运算负担。

PReLU函数

3.2 基于U-net的肿瘤图像分割算法

U-net是全卷积神经网络的一种变形,网络结构对称分布,左侧为收缩路径,采用卷积和最大池化捕捉语义,右侧为扩展路径,采用上采样进行精准定位,其中输入层接收乳腺肿瘤超声图像,网络的收缩路径由5个块组成,其中每个块都由3个相同尺寸的卷积层,以及1个池化层组成,并且使用ReLU作为激活函数,网络的扩展路径也由5个块组成,其中每个块都由1个反卷积层,以及2个卷积层组成,使用ReLU作为其激活函数,每个块都以U-net收缩路径中块的输出以及上一层的输出作为输入。U-net的最后一层为一个卷积层,卷积核的个数为语义分割的类别数,卷积核的大小为3×3,使用Sigmoid函数作为激活函数。

经典的U-net网络结构

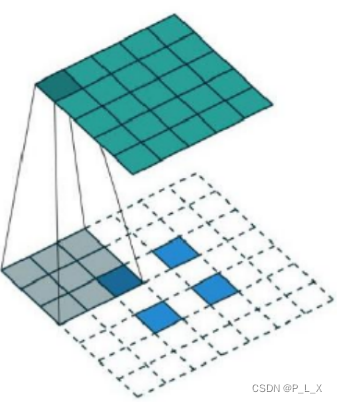

反卷积也称为转置卷积或逆卷积,与池化层和卷积层类似,卷积层和池化层可以看作是下采样,反卷积对图像的操作是上采样,在对图像进行操作的过程中,卷积层和池化层会使特征图的尺寸变小,而在语义分割方面,希望网络是每个像素点都对应着输出的一个点,表示该像素的分类情况。于是,就需要以一种手段来对特征图的尺寸进行恢复,并且要保证恢复后的特征要尽可能地保留原来的信息,在这里也就是上采样,反卷积就是上采样的一种方式。与卷积层的将多个特征点映射到一个点相对,反卷积可以看作是较少的点映射到多个点。

反卷积示意图

4 模型介绍

本文主要研究乳腺肿瘤超声图像语义分割和良恶性分类,主要有三个网络模型。

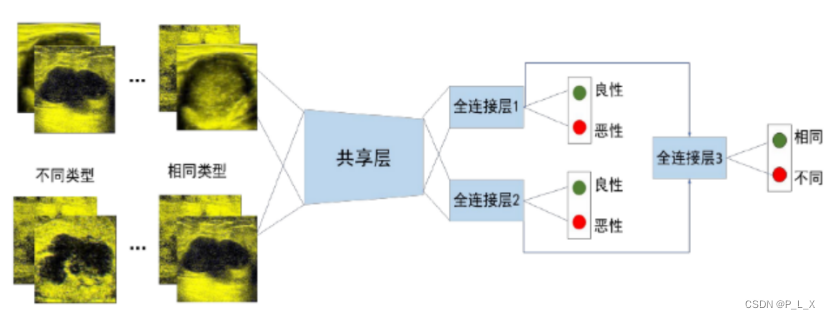

4.1 双生网络

在该模型中,有两个输入,分别为两张乳腺肿瘤超声图像,有三个输出,即两

个输入对应的两张图像的良恶性类别,而第三个输出为鉴别任务的结果,即判断两张图像是否为同一类型的肿瘤。该双生模型将前级卷积层抽取的两张图像的特征拿出来,计算两个特征之间的欧氏距离,并将结果作为鉴别任务的输出。

训练时良恶性分类-鉴别双生网络的输入输出示意图

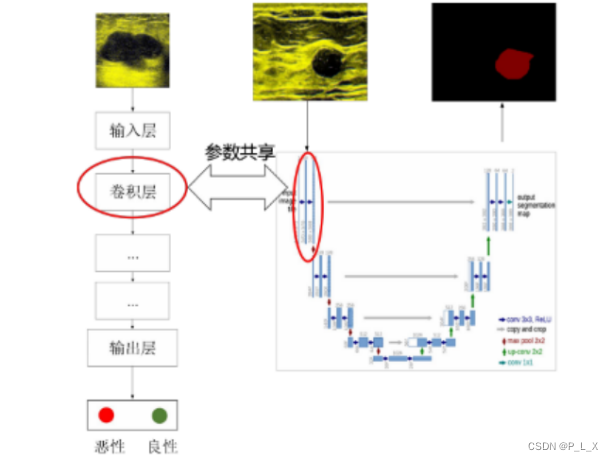

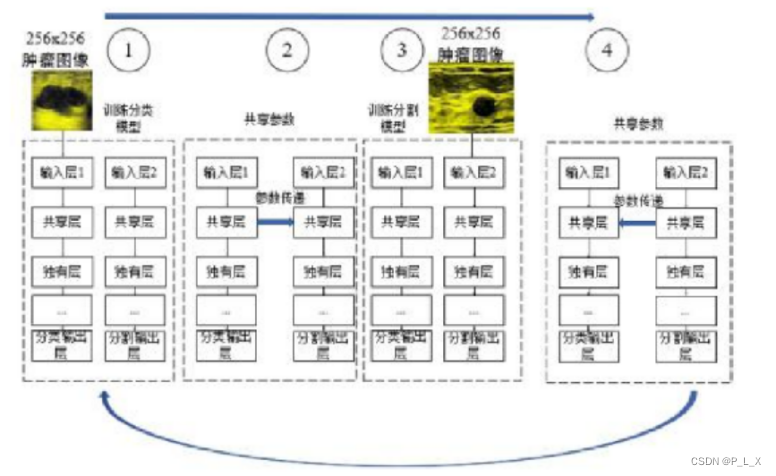

4.2 交替训练网络

他们是两个分离的网络,但是在训练的时候,我们将其中的共享层进行传递。其中左侧的图像为用于良恶性判别的分类训练样本,右侧的图像为用于肿瘤超声图像语义分割的训练样本。

良恶性分类模型与U-net模型进行参数共享

输入层1接收用于良恶性分类的图像,输入层2接收用于语义分割的图像。其中共享层为共享参数的层,可以为一层,也可以为多层,它们之间网络结构相同,并进行参数共享。共享层之后的层则分别为分类网络和语义分割网络独有的层。输出层1为分类网络的输出层,输出层2为语义分割网络的输出层。

多任务模型I

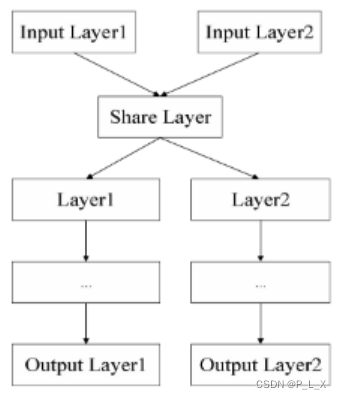

4.3 联合训练网络

多任务模型II中共享层与模型I中的共享层结构相同,在本实验模型中采用长宽都为3,核数为64的卷积层作为共享层。其中cls_input为良恶性分类图像的输入,seg_input为语义分割图像的输入,share_conv1_1为共享卷积层,两个输入图像经过卷积层的运算后,分别进入自己的网络继续进行计算。

多任务模型II示意图

4.4 损失函数

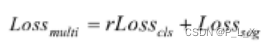

在训练时,首先通过单独的两个损失函数分别计算分类和分割两个输出的损失,再计算这两个损失的加权和作为网络的损失。

式中,r为良恶性判别和语义分割的损失权重之比。在训练时,有可能出现某一任务的偏重明显大于其他任务的情况,这样可能使有些任务的训练效果较差,所以在这里加入损失权重,来对每个任务的比重进行调节,以防止某个任务的训练效果较差。

5 总结

(1)目前,双生网络的分类效果提高不明显,可以通过改造网络结构或者构造其他任务来辅助提高良恶性分类的效果。

(2)针对本文提出的共享网络结构的多任务模型,即上文所示的多任务模型II,还可以进一步研究,主要可以通过调整共享网络层,改进或者改变损失函数的手段,进一步地提升训练效果。

最后

以上就是动听夕阳最近收集整理的关于深度学习论文精读01——基于多任务学习的肿瘤医学影像语义分割与分类研究基于多任务学习的肿瘤医学影像语义分割与分类研究的全部内容,更多相关深度学习论文精读01——基于多任务学习内容请搜索靠谱客的其他文章。

发表评论 取消回复