目录

一、镜像介绍

二、部署的步骤和方法:

一、镜像介绍

如果想要直接部署可以使用命令下载镜像,可以下载项目部署spark Hadoop 集群

https://gitee.com/wuchenlhy/spark-haoop-docker.git

web访问地址

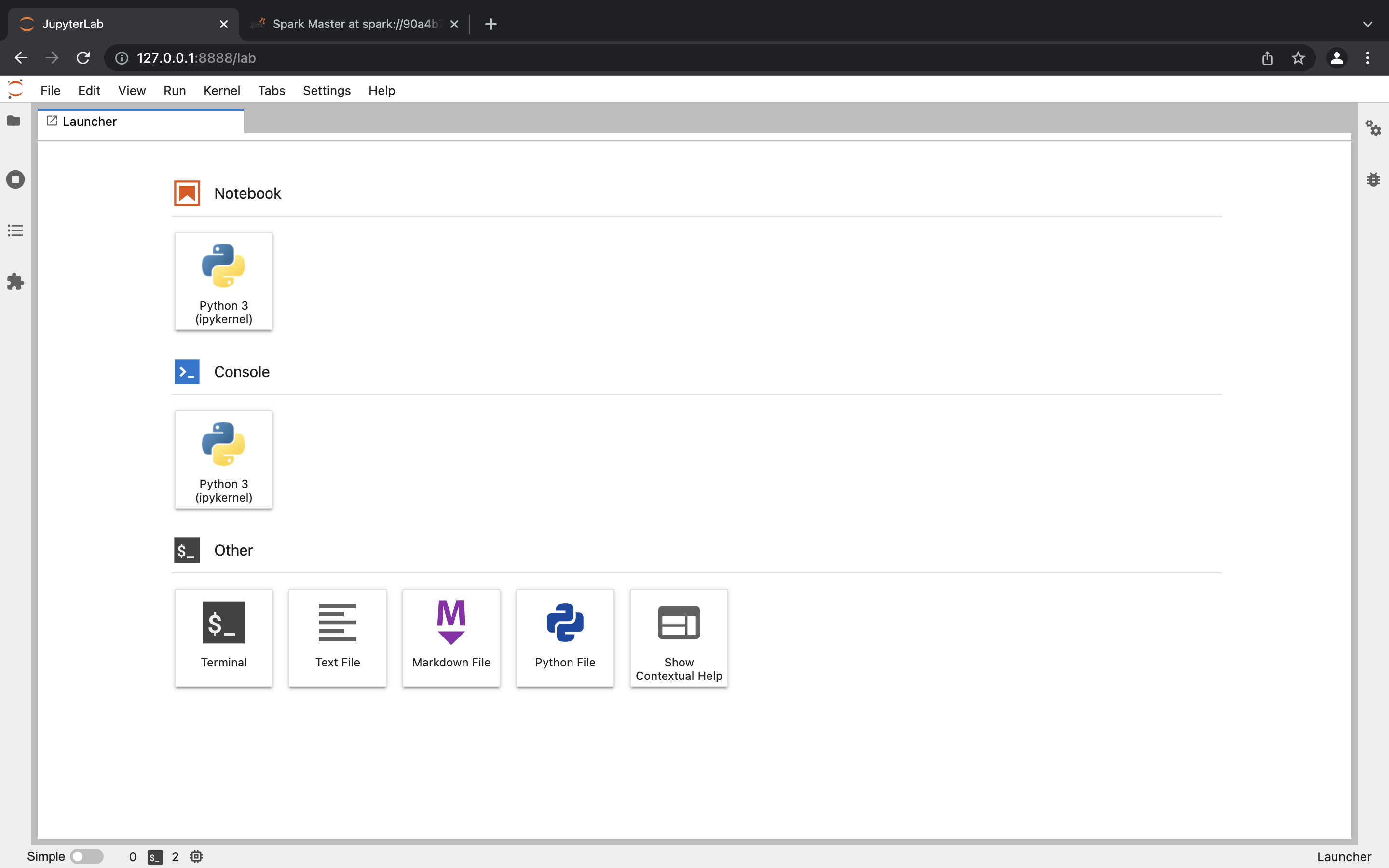

可以通过 http://ip:8888 访问 jupyterLab

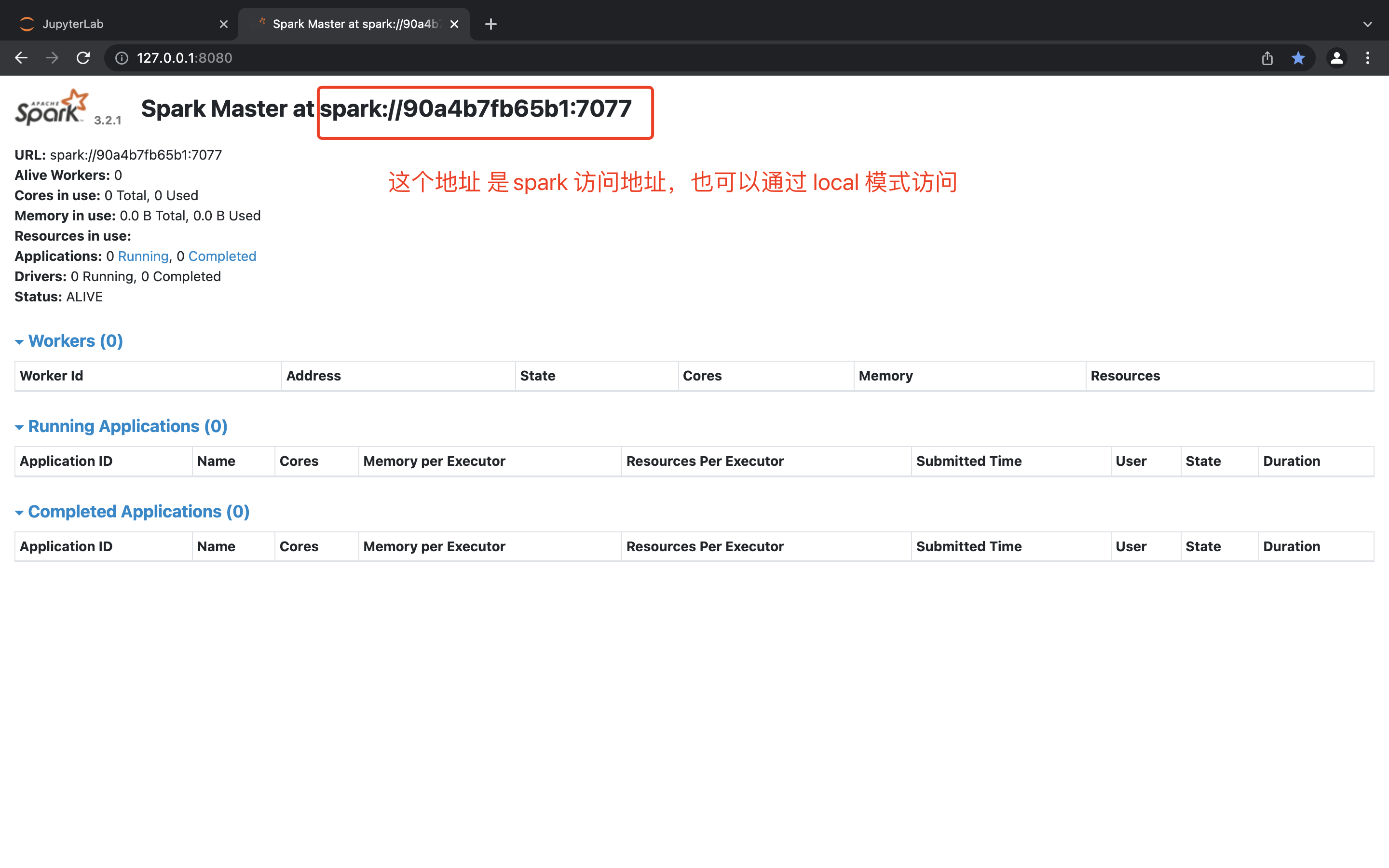

可以通过 http://ip:8080 访问 spark

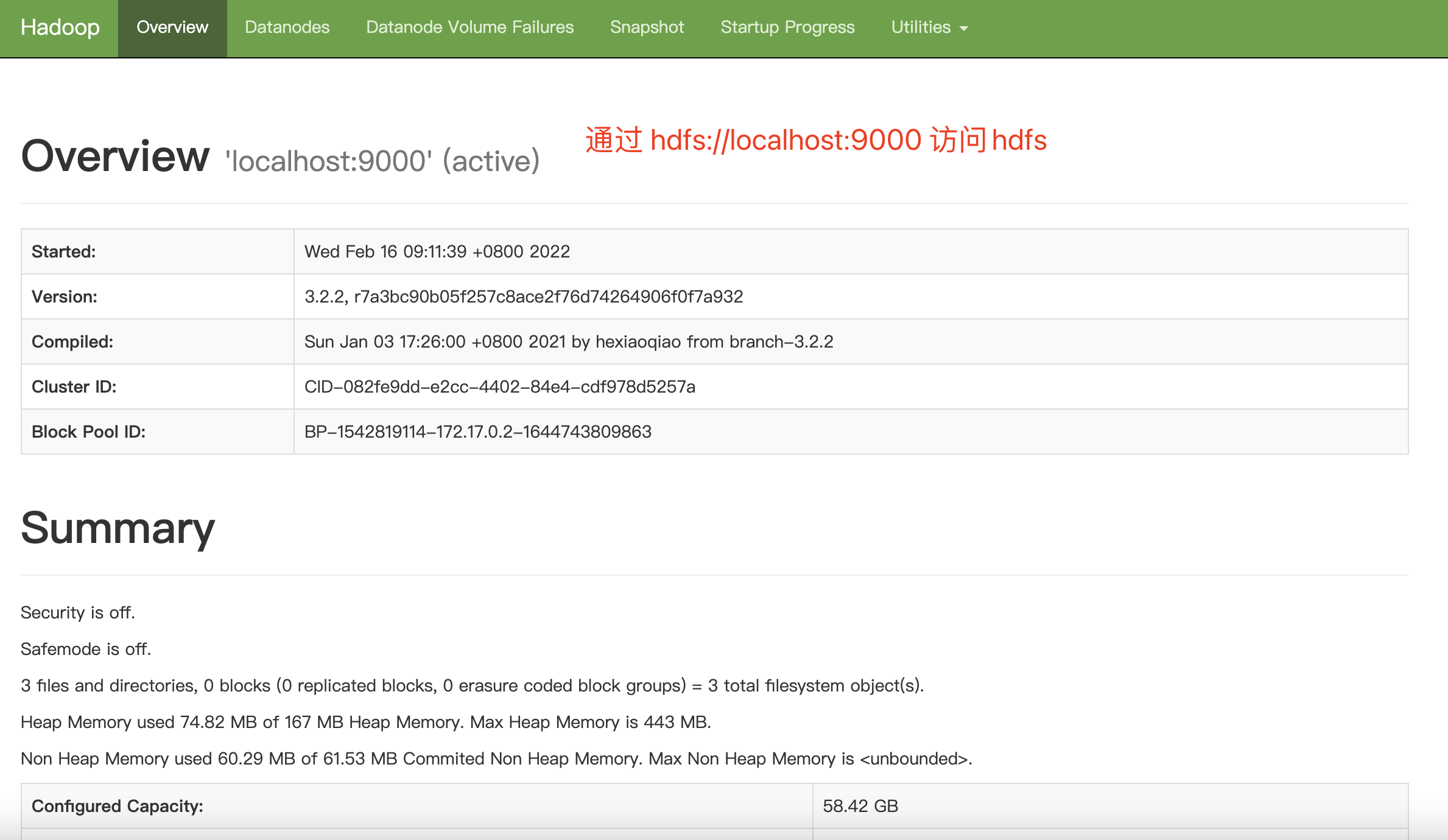

可以通过 http://ip:9870 浏览 NameNode 的web页面

可以通过 http://ip:8088 浏览 yarn 的web页面

二、部署的步骤和方法:

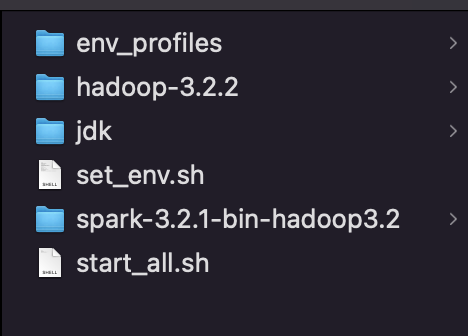

链接:https://pan.baidu.com/s/1yhYROd2u_44uiNJOymA8Mg 密码:xluz先下载准备好的所有安装文件和脚本(已经配置过spark和Hadoop),也可以去官网下载对应的版本自己修改配置,使用下面提供的脚本部署

jdk1.8

spark-3.2.1-bin-hadoop3.2

hadoop-3.2.2稍后挂在到docker容器中

env_profiles/etc_profile_java

export JAVA_HOME=/opt/jdk export JRE_HOME=/opt/jdk/jre

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tools.jar:$JRE_HOME/lib

export PATH=$JAVA_HOME/bin:$JRE_HOME/bin:$PATH

env_profiles/etc_profile_java

deb http://mirrors.aliyun.com/ubuntu/ bionic main multiverse restricted universe

deb http://mirrors.aliyun.com/ubuntu/ bionic-backports main multiverse restricted universe

deb http://mirrors.aliyun.com/ubuntu/ bionic-proposed main multiverse restricted universe

deb http://mirrors.aliyun.com/ubuntu/ bionic-security main multiverse restricted universe

deb http://mirrors.aliyun.com/ubuntu/ bionic-updates main multiverse restricted universe

deb-src http://mirrors.aliyun.com/ubuntu/ bionic main multiverse restricted universe

deb-src http://mirrors.aliyun.com/ubuntu/ bionic-backports main multiverse restricted universe

deb-src http://mirrors.aliyun.com/ubuntu/ bionic-proposed main multiverse restricted universe

deb-src http://mirrors.aliyun.com/ubuntu/ bionic-security main multiverse restricted universe

deb-src http://mirrors.aliyun.com/ubuntu/ bionic-updates main multiverse restricted universe

set_env.sh

#!/usr/bin/bash

echo "step1 copy file jdk to /opt"

cp -r ./jdk /opt

echo "step2 copy file spark to /opt"

cp -r ./spark-3.2.1-bin-hadoop3.2 /opt

echo "step3 copy file hadoop to /opt"

cp -r ./hadoop-3.2.2 /opt

echo "step4 set java env"

cat env_profiles/etc_profile_java >> /etc/profile

echo "step5 update /etc/apt/sources.list to aliyun"

cat env_profiles/sources.list.aliyun > /etc/apt/sources.list

source /etc/profile

apt-get update

echo "step6 set ssh localhost"

apt-get install openssh-server -y

apt-get install ssh -y

ssh-keygen -t rsa -P '' -f ~/.ssh/id_rsa

cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized_keys

chmod 0600 ~/.ssh/authorized_keys

echo "install jupyterlab pyspark"

apt-get install python3-pip -y

pip3 install jupyterlab -i http://mirrors.aliyun.com/pypi/simple --trusted-host mirrors.aliyun.com

pip3 install pyspark==3.2.1 -i http://mirrors.aliyun.com/pypi/simple --trusted-host mirrors.aliyun.com

start_all.sh

#!/bin/bash

source /etc/profile

service ssh start

/opt/hadoop-3.2.2/sbin/start-dfs.sh

/opt/spark-3.2.1-bin-hadoop3.2/sbin/start-master.sh

jupyter-lab --allow-root --ip=0.0.0.0

下面是安装步骤

1、 新建容器

挂在路径 -v 后面换成自己的

docker run -itd

--name spark

-p 8888:8888

-p 8088:8088

-p 8080:8080

-p 9870:9870

-v /Users/lvhaiyang/workspace/docker/data:/data/

ubuntu:18.04

进入容器 docker exec -it -u root spark bash

2、解压安装文件

进入安装文件目录 执行 bash set_env.sh

等待环境安装完成

3、环境安装完毕后格式化 Hadoop 文件系统

/opt/hadoop-3.2.2/bin/hdfs namenode -format

4、运行启动脚本 start_all.sh

5、验证安装

查看docker 日志 找到 jupyter的token

可以通过 http://ip:8888 访问 jupyterLab

可以通过 http://ip:8080 访问 spark

可以通过 http://ip:9870 浏览 NameNode 的web页面最后

以上就是飞快期待最近收集整理的关于docker搭建jupyter+spark+hadoop环境详细版的全部内容,更多相关docker搭建jupyter+spark+hadoop环境详细版内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复