本节课内容批量归一化和残差网络、凸优化、梯度下降

一、批量归一化和残差网络

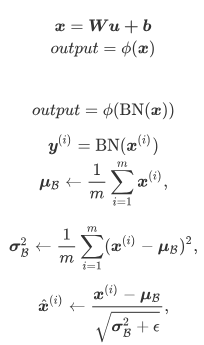

1.批量归一化

对输入的标准化(浅层模型):处理后的任意一个特征在数据集中所有样本上的均值为0、标准差为1。标准化处理输入数据使各个特征的分布相近。

批量归一化(深度模型):利用小批量上的均值和标准差,不断调整神经网络中间输出,从而使整个神经网络在各层的中间输出的数值更稳定。

对全连接层做批量归一化

位置:全连接层中的仿射变换和激活函数之间。

对卷积层做批量归一化

位置:卷积计算之后、应用激活函数之前。

如果卷积计算输出多个通道,我们需要对这些通道的输出分别做批量归一化,且每个通道都拥有独立的拉伸和偏移参数。 计算:对单通道,batchsize=m,卷积计算输出=pxq 对该通道中m×p×q个元素同时做批量归一化,使用相同的均值和方差。

预测时的批量归一化

训练:以batch为单位,对每个batch计算均值和方差。

预测:用移动平均估算整个训练数据集的样本均值和方差。

代码实现

nn.BatchNorm2d(6),

nn.BatchNorm1d(84),

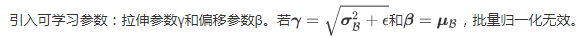

2.残差网络

在残差块中,输入通过跨层的数据线路更快 地向前传播。

代码实现

class Residual(nn.Module): # 本类已保存在d2lzh_pytorch包中方便以后使用

#可以设定输出通道数、是否使用额外的1x1卷积层来修改通道数以及卷积层的步幅。

def __init__(self, in_channels, out_channels, use_1x1conv=False, stride=1):

super(Residual, self).__init__()

self.conv1 = nn.Conv2d(in_channels, out_channels, kernel_size=3, padding=1, stride=stride)

self.conv2 = nn.Conv2d(out_channels, out_channels, kernel_size=3, padding=1)

if use_1x1conv:

self.conv3 = nn.Conv2d(in_channels, out_channels, kernel_size=1, stride=stride)

else:

self.conv3 = None

self.bn1 = nn.BatchNorm2d(out_channels)

self.bn2 = nn.BatchNorm2d(out_channels)

def forward(self, X):

Y = F.relu(self.bn1(self.conv1(X)))

Y = self.bn2(self.conv2(Y))

if self.conv3:

X = self.conv3(X)

return F.relu(Y + X)

def resnet_block(in_channels, out_channels, num_residuals, first_block=False):

if first_block:

assert in_channels == out_channels # 第一个模块的通道数同输入通道数一致

blk = []

for i in range(num_residuals):

if i == 0 and not first_block:

blk.append(Residual(in_channels, out_channels, use_1x1conv=True, stride=2))

else:

blk.append(Residual(out_channels, out_channels))

return nn.Sequential(*blk)

net = nn.Sequential(

nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3),

nn.BatchNorm2d(64),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1))

net.add_module("resnet_block1", resnet_block(64, 64, 2, first_block=True))

net.add_module("resnet_block2", resnet_block(64, 128, 2))

net.add_module("resnet_block3", resnet_block(128, 256, 2))

net.add_module("resnet_block4", resnet_block(256, 512, 2))

net.add_module("global_avg_pool", d2l.GlobalAvgPool2d()) # GlobalAvgPool2d的输出: (Batch, 512, 1, 1)

net.add_module("fc", nn.Sequential(d2l.FlattenLayer(), nn.Linear(512, 10)))

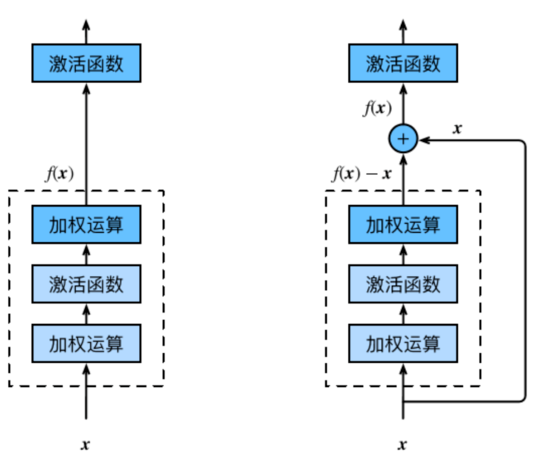

3.DenseNet

DenseNet主要构建模块:

稠密块(dense block): 定义了输入和输出是如何连结的。

过渡层(transition layer):用来控制通道数,使之不过大。

def conv_block(in_channels, out_channels):

blk = nn.Sequential(nn.BatchNorm2d(in_channels),

nn.ReLU(),

nn.Conv2d(in_channels, out_channels, kernel_size=3, padding=1))

return blk

class DenseBlock(nn.Module):

def __init__(self, num_convs, in_channels, out_channels):

super(DenseBlock, self).__init__()

net = []

for i in range(num_convs):

in_c = in_channels + i * out_channels

net.append(conv_block(in_c, out_channels))

self.net = nn.ModuleList(net)

self.out_channels = in_channels + num_convs * out_channels # 计算输出通道数

def forward(self, X):

for blk in self.net:

Y = blk(X)

X = torch.cat((X, Y), dim=1) # 在通道维上将输入和输出连结

return X

def transition_block(in_channels, out_channels):

blk = nn.Sequential(

nn.BatchNorm2d(in_channels),

nn.ReLU(),

nn.Conv2d(in_channels, out_channels, kernel_size=1),

nn.AvgPool2d(kernel_size=2, stride=2))

return blk

net = nn.Sequential(

nn.Conv2d(1, 64, kernel_size=7, stride=2, padding=3),

nn.BatchNorm2d(64),

nn.ReLU(),

nn.MaxPool2d(kernel_size=3, stride=2, padding=1))

num_channels, growth_rate = 64, 32 # num_channels为当前的通道数

num_convs_in_dense_blocks = [4, 4, 4, 4]

for i, num_convs in enumerate(num_convs_in_dense_blocks):

DB = DenseBlock(num_convs, num_channels, growth_rate)

net.add_module("DenseBlosk_%d" % i, DB)

# 上一个稠密块的输出通道数

num_channels = DB.out_channels

# 在稠密块之间加入通道数减半的过渡层

if i != len(num_convs_in_dense_blocks) - 1:

net.add_module("transition_block_%d" % i, transition_block(num_channels, num_channels // 2))

num_channels = num_channels // 2

net.add_module("BN", nn.BatchNorm2d(num_channels))

net.add_module("relu", nn.ReLU())

net.add_module("global_avg_pool", d2l.GlobalAvgPool2d()) # GlobalAvgPool2d的输出: (Batch, num_channels, 1, 1)

net.add_module("fc", nn.Sequential(d2l.FlattenLayer(), nn.Linear(num_channels, 10)))

X = torch.rand((1, 1, 96, 96))

for name, layer in net.named_children():

X = layer(X)

print(name, ' output shape:t', X.shape)

二、凸优化

尽管优化方法可以最小化深度学习中的损失函数值,但本质上优化方法达到的目标与深度学习的目标并不相同。

优化方法目标:训练集损失函数值

深度学习目标:测试集损失函数值(泛化性)

优化在深度学习中的挑战

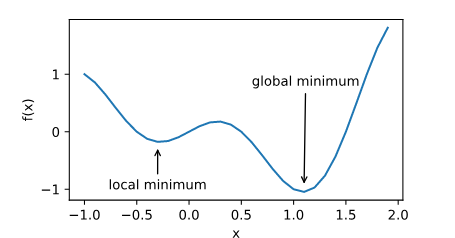

局部最小值:

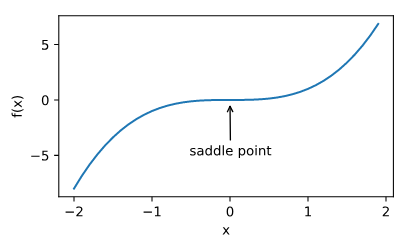

鞍点

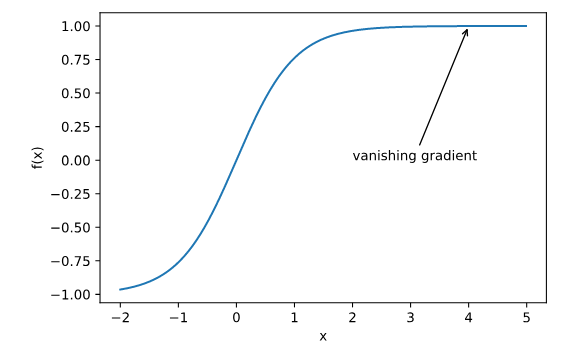

梯度消失

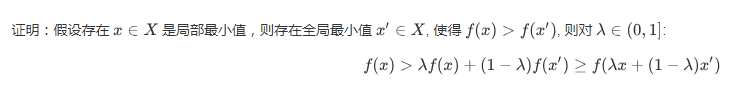

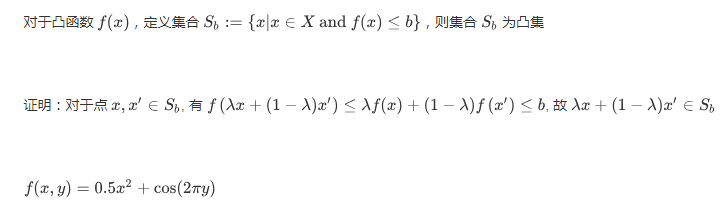

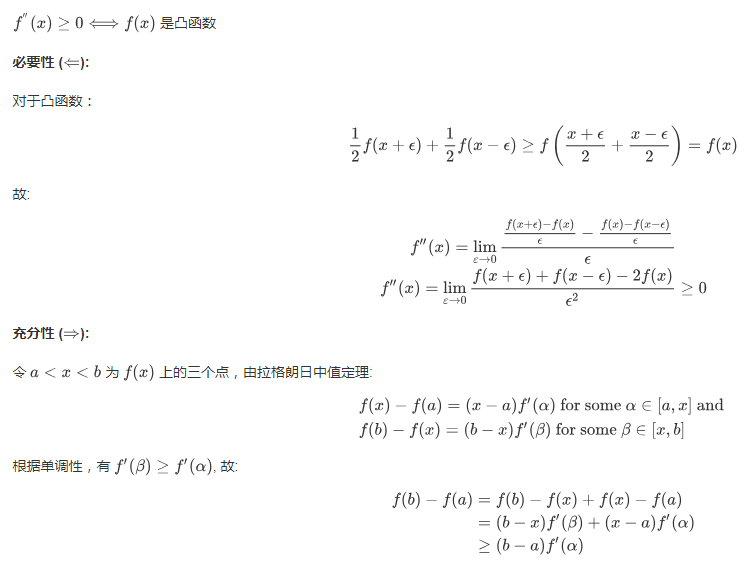

凸函数的性质

1.无局部极小值

2.与凸集的关系

3.二阶条件

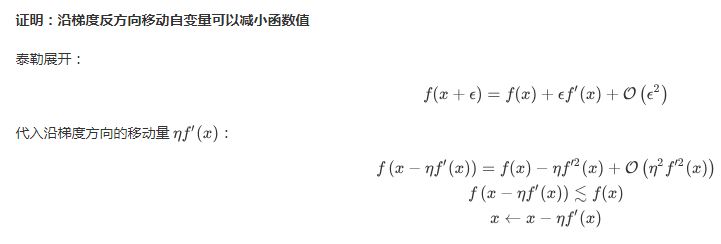

三、梯度下降

1.一维梯度下降

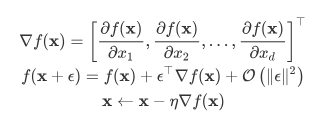

2.多维梯度下降

3.自适应方法

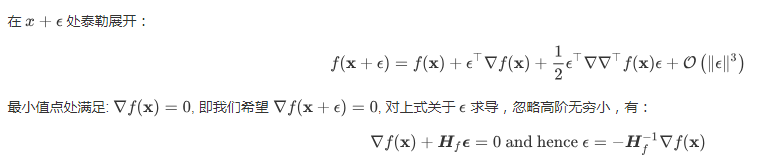

牛顿法

收敛性分析

Heissan阵辅助梯度下降

梯度下降与线性搜索(共轭梯度法)

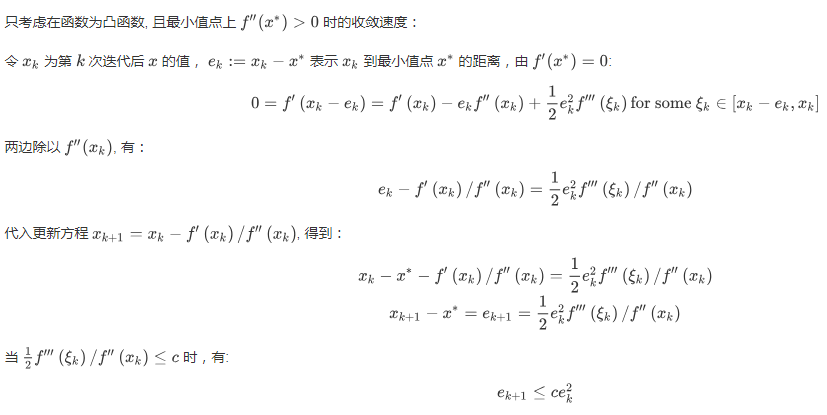

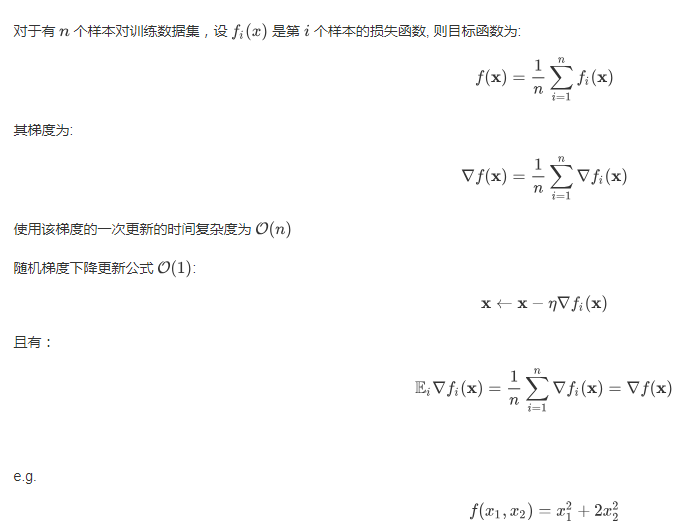

4,随机梯度下降

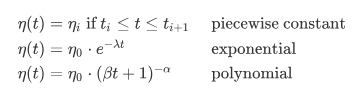

动态学习率

小批量梯度下降代码实现

# 本函数与原书不同的是这里第一个参数优化器函数而不是优化器的名字

# 例如: optimizer_fn=torch.optim.SGD, optimizer_hyperparams={"lr": 0.05}

def train_pytorch_ch7(optimizer_fn, optimizer_hyperparams, features, labels,

batch_size=10, num_epochs=2):

# 初始化模型

net = nn.Sequential(

nn.Linear(features.shape[-1], 1)

)

loss = nn.MSELoss()

optimizer = optimizer_fn(net.parameters(), **optimizer_hyperparams)

def eval_loss():

return loss(net(features).view(-1), labels).item() / 2

ls = [eval_loss()]

data_iter = torch.utils.data.DataLoader(

torch.utils.data.TensorDataset(features, labels), batch_size, shuffle=True)

for _ in range(num_epochs):

start = time.time()

for batch_i, (X, y) in enumerate(data_iter):

# 除以2是为了和train_ch7保持一致, 因为squared_loss中除了2

l = loss(net(X).view(-1), y) / 2

optimizer.zero_grad()

l.backward()

optimizer.step()

if (batch_i + 1) * batch_size % 100 == 0:

ls.append(eval_loss())

# 打印结果和作图

print('loss: %f, %f sec per epoch' % (ls[-1], time.time() - start))

d2l.set_figsize()

d2l.plt.plot(np.linspace(0, num_epochs, len(ls)), ls)

d2l.plt.xlabel('epoch')

d2l.plt.ylabel('loss')

注:

本博客所有内容均参考伯禹学习平台动手学深度学习课程

最后

以上就是现代鸭子最近收集整理的关于动手学深度学习Pytorch Task06一、批量归一化和残差网络二、凸优化三、梯度下降的全部内容,更多相关动手学深度学习Pytorch内容请搜索靠谱客的其他文章。

发表评论 取消回复