问题描述:

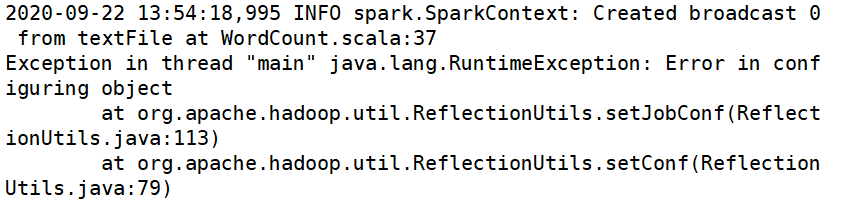

spark.SparkContext: Created broadcast 0 from textFile at WordCount.scala:37

Exception in thread "main" java.lang.RuntimeException: Error in configuring object

.........

//往下N多行

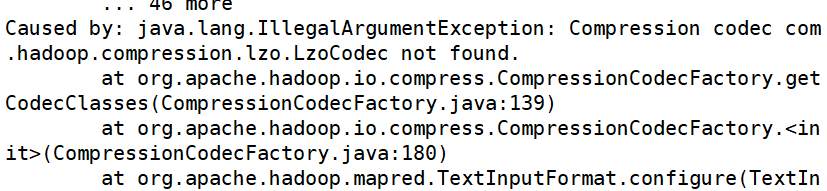

Caused by: java.lang.ClassNotFoundException: Class com.hadoop.compression.lzo.LzoCodec not found

at org.apache.hadoop.conf.Configuration.getClassByName(Configuration.java:2499)

问题原因:

Spark on Yarn会默认使用Hadoop集群配置文件设置编码方式,但是Spark在自己的spark-yarn/jars 包里面没有找到支持lzo压缩的jar包,所以报错。

问题解决方案:

解决方案一:拷贝lzo的包到/opt/module/spark-yarn/jars目录

cp /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-lzo-0.4.20.jar /opt/module/spark-yarn/jars

解决方案二:在执行命令的时候指定lzo的包位置

bin/spark-submit

–class com.lu.spark.WordCount

–master yarn

–driver-class-path /opt/module/hadoop-3.1.3/share/hadoop/common/hadoop-lzo-0.4.20.jar

WordCount.jar

/input

/output

最后

以上就是称心咖啡豆最近收集整理的关于hadoop.compression.lzo.LzoCodec not found问题发现及解决的全部内容,更多相关hadoop.compression.lzo.LzoCodec内容请搜索靠谱客的其他文章。

本图文内容来源于网友提供,作为学习参考使用,或来自网络收集整理,版权属于原作者所有。

发表评论 取消回复